靠谱客(kaopuke.com)6月22日消息:阿里巴巴悄悄发布了 Qwen2系列模型,这是 Qwen1.5升级后的重大更新。

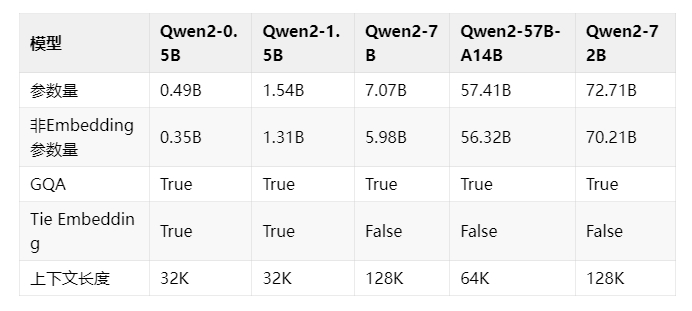

Qwen2系列包含了5个不同规模的预训练和指令微调模型,分别是 Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B 和 Qwen2-72B。这些模型在处理长文本时支持不同的上下文长度,最大可达128K tokens。

Qwen2系列在多语言方面做了优化,增加了27种语言的高质量数据,并针对常见的语言转换问题进行了优化。模型在多项评测中表现优异,包括自然语言理解、知识、代码、数学和多语言理解等能力,显著超越之前的 Qwen1.5和其他开源模型。

在代码和数学能力方面,Qwen2系列持续提升,特别是在多种编程语言上的表现和数学解题能力方面有显著提升。模型还能处理长文本任务,其中 Qwen2-72B-Instruct 能完美处理128k 上下文长度内的信息抽取任务。

在安全性方面,Qwen2-72B-Instruct 模型与 GPT-4表现相当,显著优于 Mistral-8x22B 模型。所有模型均已开源在 Hugging Face 和 ModelScope 上,可在各种应用场景中使用。未来,Qwen 团队还将继续训练更大的模型,探索模型及数据的 Scaling Law,并将 Qwen2扩展成多模态模型。

项目地址:https://github.com/QwenLM/Qwen2

(举报)

发表评论取消回复