关注并星标

从此不迷路

计算机视觉研究院

公众号ID|ComputerVisionGzq

学习群|扫码在主页获取加入方式

论文地址:https://arxiv.org/abs/2203.03952

代码地址:https://github.com/hkzhang91/ParC-Net

计算机视觉研究院专栏

作者:Edison_G

继承ConvNet和Transformer优点的位置敏感的循环卷积。

01

概述

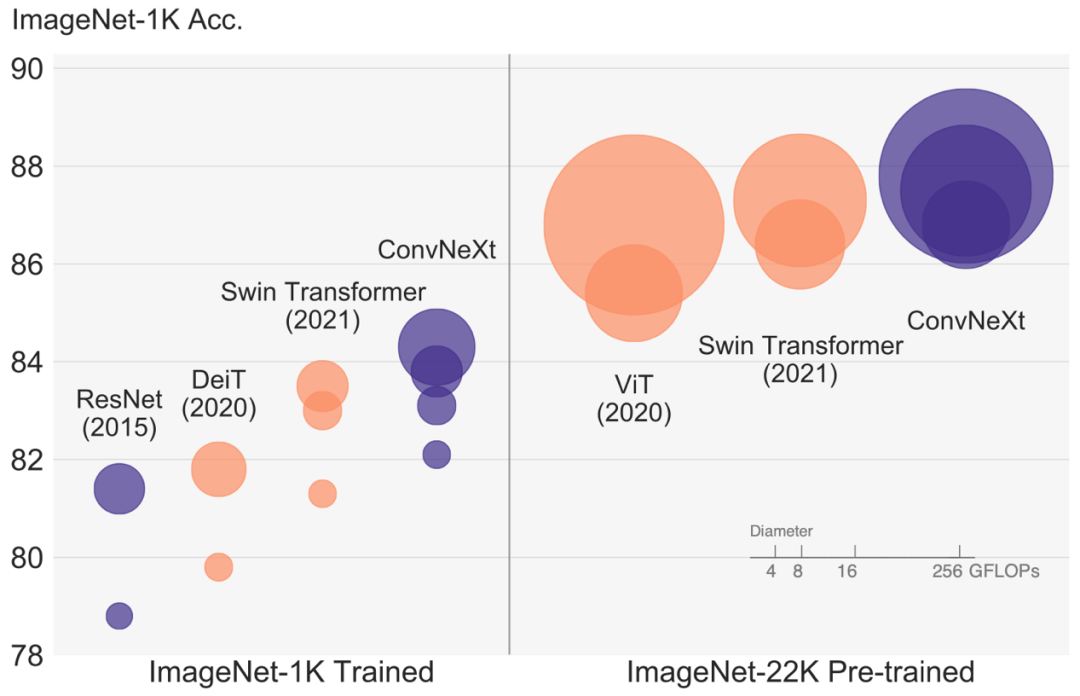

最近,vision transformers开始显示出令人印象深刻的结果,显着优于基于大型卷积的模型。然而,在移动或资源受限设备的小型模型领域,ConvNet在性能和模型复杂度方面仍然具有自己的优势。研究者提出了ParC-Net,这是一种纯基于ConvNet的骨干模型,通过将vision transformers的优点融合到ConvNet 中,进一步增强了这些优势。

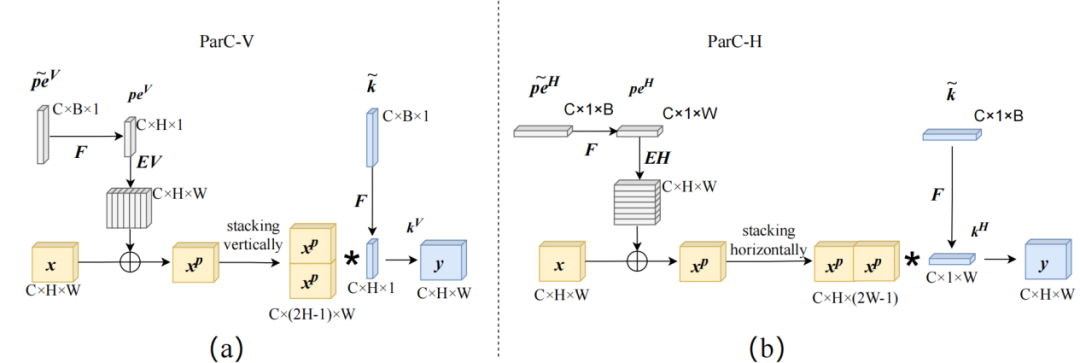

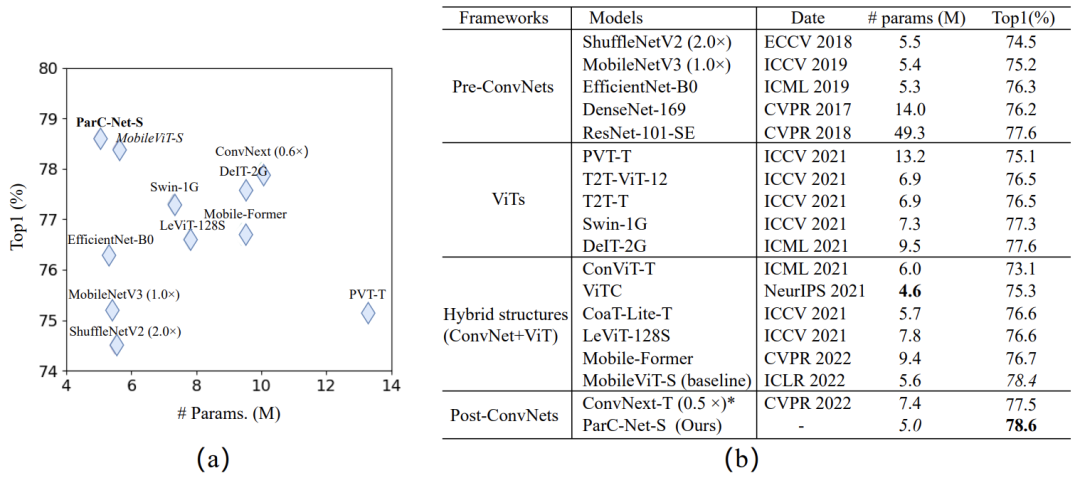

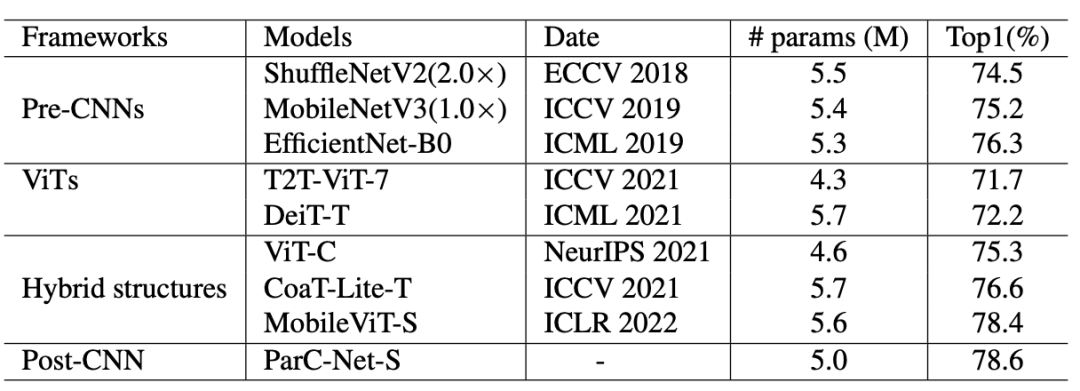

ConvNet与ViT模型图像分类实验结果对比

具体来说,研究者提出了位置感知循环卷积(ParC),这是一种轻量级的卷积运算,它拥有全局感受野,同时产生与局部卷积一样的位置敏感特征。将ParCs和squeeze-exictation ops结合起来形成一个类似于元模型的模型块,它还具有类似于transformers的注意力机制。上述块可以即插即用的方式使用,以替换ConvNets或transformers中的相关块。

实验结果表明,在常见的视觉任务和数据集中,所提出的ParC-Net比流行的轻量级ConvNets和基于vision transformers的模型具有更好的性能,同时具有更少的参数和更快的推理速度。对于ImageNet-1k上的分类,ParC-Net在大约500万个参数的情况下实现了78.6%的top-1准确率,节省了11%的参数和13%的计算成本,但准确率提高了0.2%,推理速度提高了23%(基于ARM的Rockchip RK3288)与MobileViT相比,仅使用0.5倍的参数,但与DeIT相比获得了2.7%的准确度。在MS-COCO目标检测和PASCAL VOC分割任务上,ParC-Net也表现出更好的性能。

02

背景

然而,我们认为ViTs和ConvNets都是不可或缺的,原因如下:

1)从应用的角度来看,ViTs和ConvNets都有其优点和缺点。ViT模型通常具有更好的性能,但通常计算成本高且难以训练。与ViTs相比,ConvNets可能表现出较差的性能,但它们仍然具有一些独特的优势。例如,ConvNets具有更好的硬件支持并且易于训练。此外,正如[Jianyuan Guo, Kai Han, Han Wu, Chang Xu, Yehui Tang, Chunjing Xu, and Yunhe Wang. Cmt: Convolutional neural networks meet vision transformers.]和研究者的实验中总结的那样,ConvNets在移动或边缘设备的小型模型领域仍然占主导地位。

2)从信息处理的角度来看,ViTs和ConvNets都具有独特的特征。ViT擅长提取全局信息,并使用注意力机制从输入数据驱动的不同位置提取信息。ConvNets专注于对局部关系进行建模,并且通过归纳偏置具有很强的先验性。上述分析自然提出了一个问题:我们能否向ViT学习以改进用于移动或边缘计算应用的ConvNet?

ViT论文:https://arxiv.org/abs/2010.11929

ConvNeXt论文:https://arxiv.org/abs/2201.03545

03

新框架

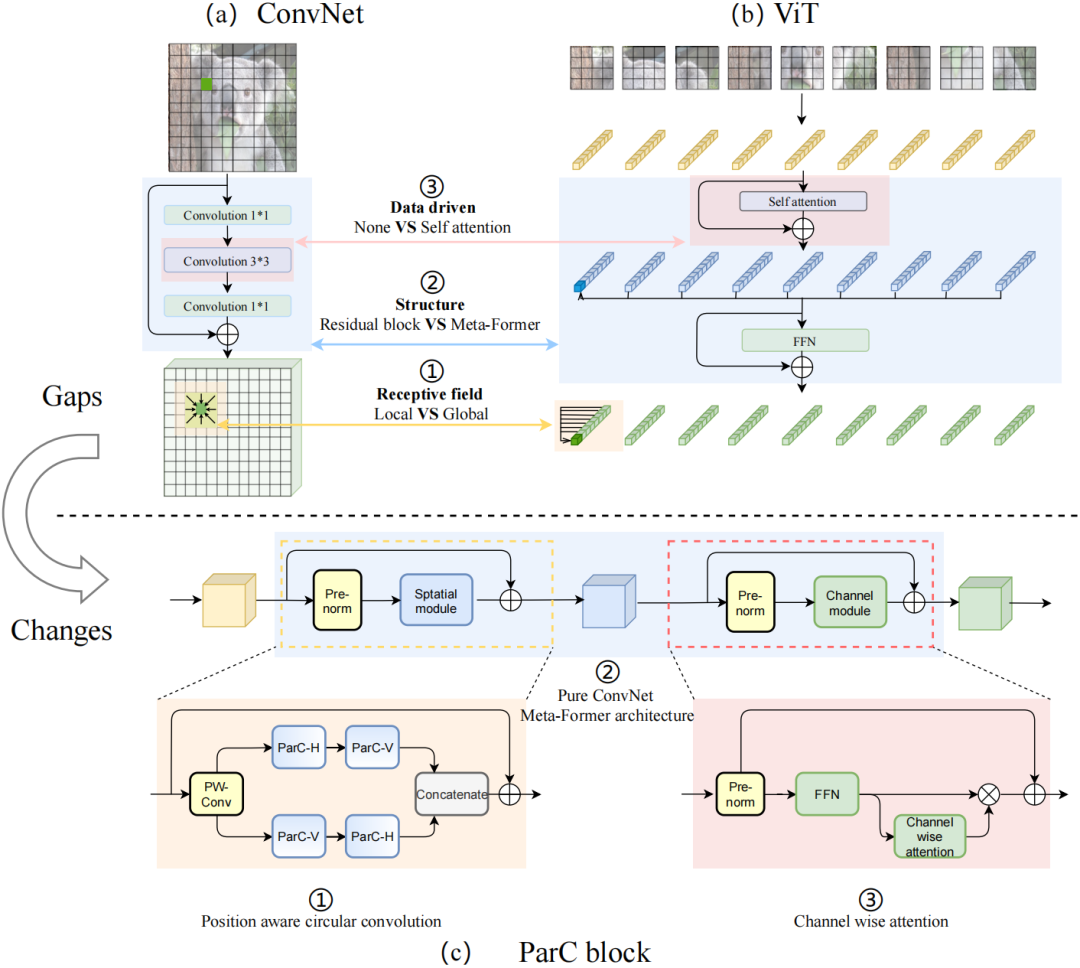

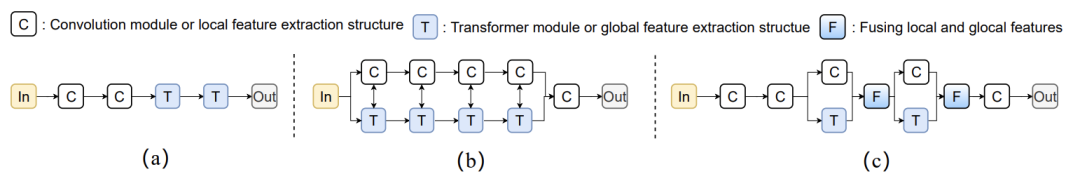

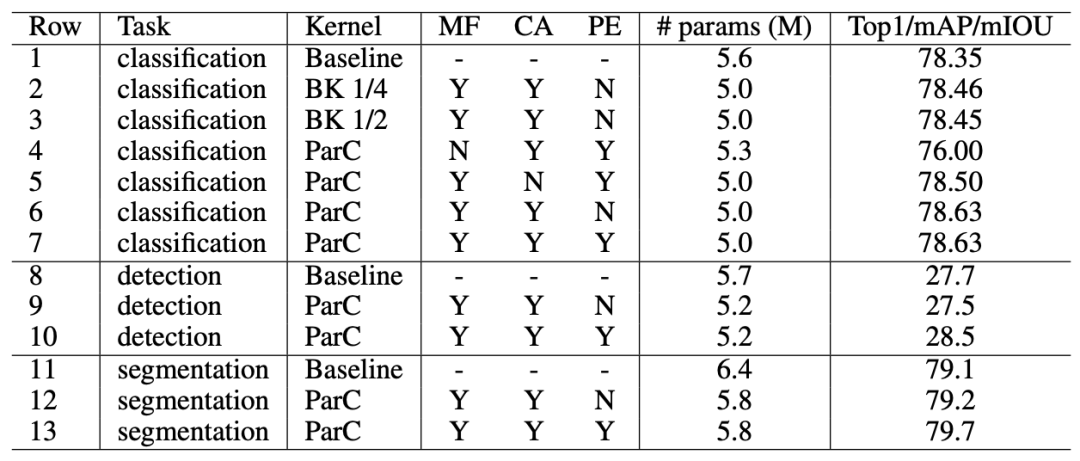

研究者们取ViT的三个亮点,将纯卷积结构变强。研究者认为,ViT和ConvNet有三个主要区别:ViT更擅长提取全局特征,采用meta-former结构,而且信息集成由数据驱动。ParC的设计思路便是从这三点着手来优化ConvNet。

普通ConvNet和ViT之间的三个主要区别。a)ConvNet常用的Residual block;b)ViT中常用的Meta-Former 结构;c)研究者提出的ParC block。

具体而言,研究人员设计了一种位置信息敏感的循环卷积(Position aware circular convolution, ParC)。这是一种简单有效的轻量卷积运算算子,既拥有像ViT类结构的全局感受野,同时产生了像局部卷积那样的位置敏感特征,能克服依赖自注意力结构提取全局特征的问题。

Position aware circular convolution

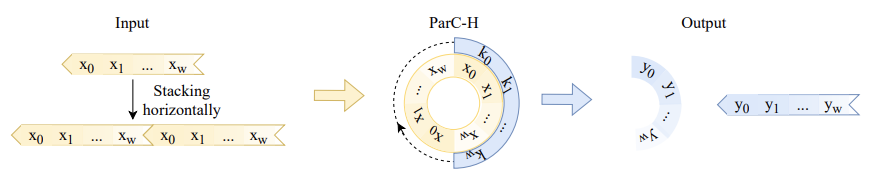

水平方向的全局循环卷积

可以看到ParC-H沿着通过连接输入的开始和结束生成的圆执行卷积。因此,研究者将提出的卷积命名为循环卷积。提议的ParC引入了三个修改:

结合circular padding和大感受野低秩分解卷积核提取全局特征;

引入位置嵌入,保证输出特征对于空间位置信息的敏感性;

动态插值实时生成尺寸适配的卷积核和位置编码,应对输入分辨率变化情况,这增强了对不同尺寸输入的适应能力。

研究者还将ParC和squeeze exictation结合起来,构建了一个纯卷积结构的meta former结构。该结构舍弃了自注意力硬件支持不友好的操作,但保留了传统Transformer块提取全局特征的特点。研究者还在channel mixer部分引入硬件支持较友好的通道注意力机制,使其纯卷积meta former结构也具备自注意力的特点。

基于ParC结构最终得到的ParC块,可作为一个即插即用的基础单元,替换现有ViT或ConvNet模型中的相关块,从而提升精度,并降低计算成本,有效克服硬件支持的问题。

三种主要的混合结构。(a) serial structure; (b) parallel structure; (c) bifurcate structure。

04

实验分析

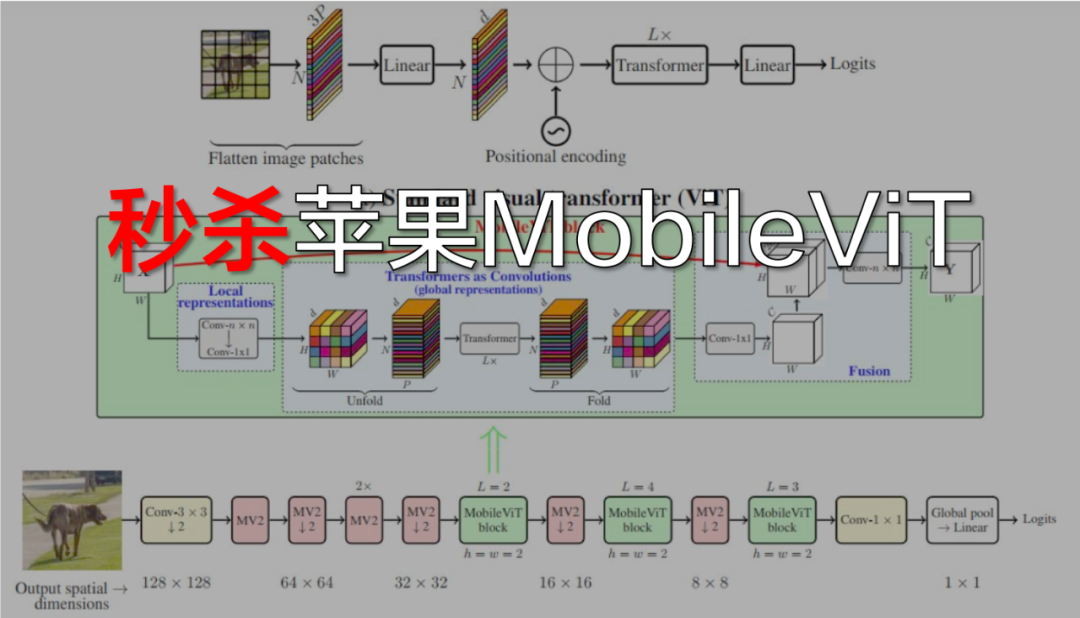

在图像分类实验中,对于ImageNet-1k的分类,ParC-Net使用的参数规模最小(约500万个参数),却实现了最高准确率78.6%。

MobileViT是Apple2022年在国际深度学习顶会ICLR22上提出的轻量级通用ViT模型。同样部署在基于Arm的瑞芯微RK3288芯片上,相较基线模型MobileViT,ParC-Net节省了11%的参数和13%的计算成本,同时准确率提高了0.2%,推理速度提高了23%。

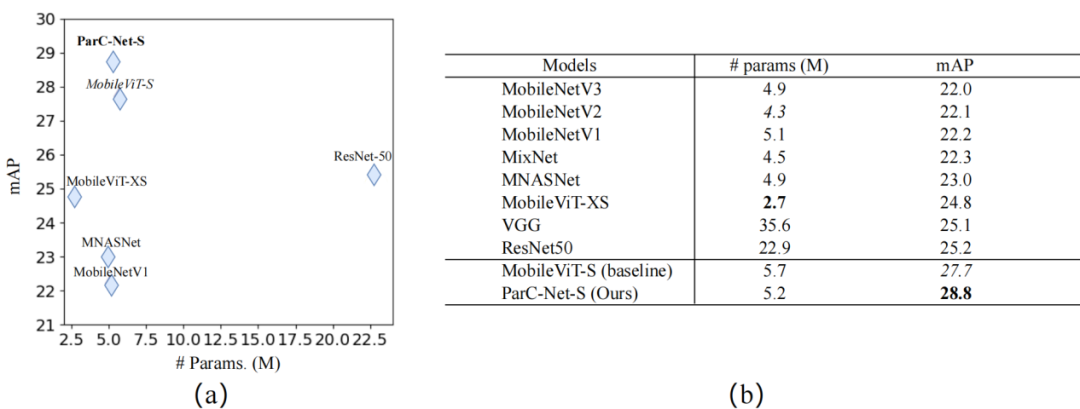

MS-COCO物体检测实验结果

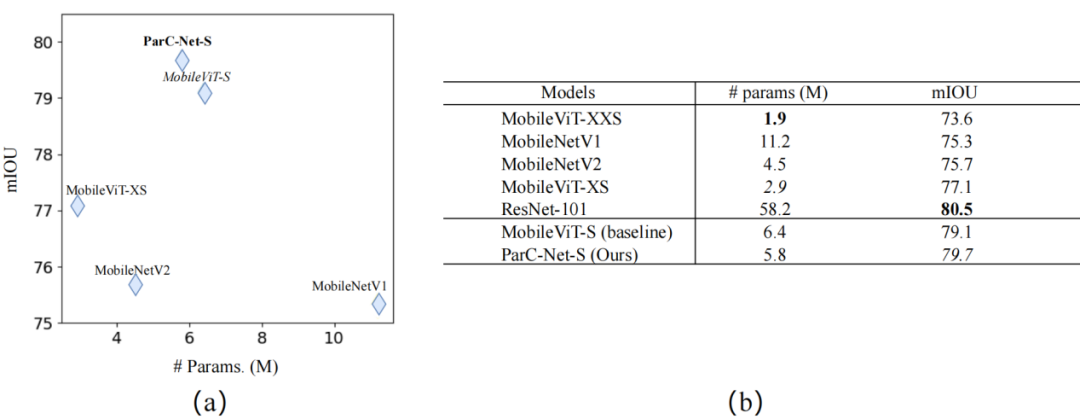

PASCAL VOC分割任务实验结果

研究者将ParC-Net和基线模型MobileVit均部署到自研低功耗芯片DP上进行推理速度测试。从实验结果可以看到,ParC-Net的推理速度能够达到MobileViT速度的3~4倍。

© THE END

转载请联系本公众号获得授权

计算机视觉研究院学习群等你加入!

我们开创“计算机视觉协会”知识星球两年有余,也得到很多同学的认可,最近我们又开启了知识星球的运营。我们定时会推送实践型内容与大家分享,在星球里的同学可以随时提问,随时提需求,我们都会及时给予回复及给出对应的答复。

ABOUT

计算机视觉研究院

计算机视觉研究院主要涉及深度学习领域,主要致力于人脸检测、人脸识别,多目标检测、目标跟踪、图像分割等研究方向。研究院接下来会不断分享最新的论文算法新框架,我们这次改革不同点就是,我们要着重”研究“。之后我们会针对相应领域分享实践过程,让大家真正体会摆脱理论的真实场景,培养爱动手编程爱动脑思考的习惯!

VX:2311123606

往期推荐

????

Yolov7:最新最快的实时检测框架,最详细分析解释(附源代码)

最新的目标检测的深度架构 | 参数少一半、速度快3倍+(文末福利)

SSD7 | 对嵌入式友好的目标检测网络,产品落地

精度提升方法:自适应Tokens的高效视觉Transformer框架(已开源)

ONNX 浅析:如何加速深度学习算法工程化?

劲爆!YOLOv6又快又准的目标检测框架开源啦(附源代码下载)

FastestDet:比yolov5更快!更强!全新设计的超实时Anchor-free目标检测算法(附源代码下载)

目前精度最高效率最快存储最小的目标检测模型(附源码下载)

CVPR小目标检测:上下文和注意力机制提升小目标检测(附论文下载)

Double-Head:检测头上再创新,提升精度(附原论文下载)

海康研究院出品:具有场景自适应概念学习的无监督目标检测(附论文下载)

新技术:高效的自监督视觉预训练,局部遮挡再也不用担心!

VS Code支持配置远程同步了

改进的阴影抑制用于光照鲁棒的人脸识别

基于文本驱动用于创建和编辑图像(附源代码)

基于分层自监督学习将视觉Transformer扩展到千兆像素图像

霸榜第一框架:工业检测,基于差异和共性的半监督方法用于图像表面缺陷检测

最后

以上就是细腻水杯最近收集整理的关于ECCV 2022丨轻量级模型架构火了,力压苹果MobileViT(附代码和论文下载)的全部内容,更多相关ECCV内容请搜索靠谱客的其他文章。

发表评论 取消回复