batch_size:多少个数据为一个批次进行梯度更新。

batch:以batch_size为单位,将数据集划分为多少个batch。batch=total size/batch_size

epoch:将整个数据集训练多少次。一般选择>1,因只输入网络一次不能很好的学习到特征。

shuffle:每个epoch是否乱序;

max_seq_len:tokenizer参数,若数据大于max_seq_len,直接截断;少于max_seq_len时,在输入网络时,会padding 0,进行数据的对齐

tqdm库:在电脑终端上显示进度,使代码进度可视化,用于for循环中。

辅助标记符[CLS]和[SEP]来表示句子的开始和分隔。

pytorch:数据读取Dataloader

(6条消息) pytorch - 数据读取机制中的Dataloader与Dataset_诗与远方-CSDN博客

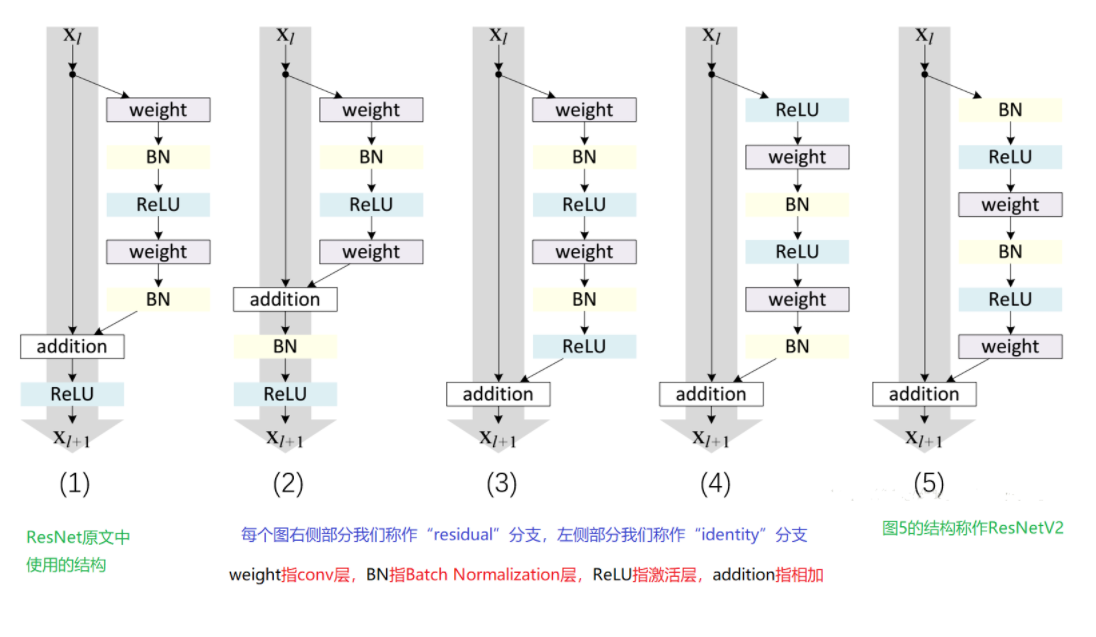

ResNet中Pre-activation和Post-activation的区别

其中pre和post是对于卷积操作来说的, 对于1,2,3是先进行卷积,故为post-activation

4,5为pre-activation模式;

shortcut可以理解为跨层连接,为了减轻随着网络深度的增加,模型性能降低的问题。

下采样(downsampling)可以用于减少模型参数,如DPCNN中,选取步长为2,大小为3的下采样,可以是特征图数据量减少一半。

最后

以上就是无聊板凳最近收集整理的关于ML参数及ResNet中Pre-activation和post-activation的区别的全部内容,更多相关ML参数及ResNet中Pre-activation和post-activation内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复