我是靠谱客的博主 健壮导师,这篇文章主要介绍第一讲.Liner_Regression and Gradient_Descent(Rui Xia) 单变量线性回归及梯度下降,现在分享给大家,希望可以做个参考。

本栏目(Machine learning)包括单参数的线性回归、多参数的线性回归、Octave Tutorial、Logistic Regression、Regularization、神经网络、机器学习系统设计、SVM(Support Vector Machines 支持向量机)、聚类、降维、异常检测、大规模机器学习等章节。所有内容均来自Standford公开课machine learning中Andrew老师的讲解。(https://class.coursera.org/ml/class/index)

---------------------------------------------------------------------------------------------------------------------------------------------------------

前 言:

机器学习很重要的步骤和思想就是三步走:

1.Hypothesis--假设函数

寻找假设函数,如果一开始假设函数就找找错的话,后面的都是错误的,problem:假设函数找到了,关键是如何求出参数parameters

2.Learning--

学习(最重要的是:求 parameters参数的方法 还有 损失函数或者价值函数:cost function的计算)

学习的过程就是根据样本值找出最合适的参数,当然有时候只是局部最优解,监督学习:训练的时候是有样本的输出期望值得,而非监督学习则没有

problem:把样本的值(均是已知)全部带入后,cost function的表达是就是parameters 的函数了,用什么方法求出参数呢,已知的有:梯度下降,随机梯度下降,矩阵等等

3.Prediction--预测

利用梯度下降求出来parameters之后,我们就要用来预测可能值,也会把预测值再次用来调整 theta

本文会讲到:

(1)单变量线性回归

(2)cost function:评价线性回归是否拟合训练集的方法

(3)梯度下降:解决线性回归的方法之一

(4)python代码及结果演示

参考文献:http://www.stat.yale.edu/Courses/1997-98/101/linreg.htm

1.Linear_Regression

方法:线性回归属于监督学习(有预期期望值的是监督学习),因此方法和监督学习应该是一样的,先给定一个训练集,根据这个训练集学习出一个线性函数,然后测试这个函数训练的好不好(即此函数是否足够拟合训练集数据),挑选出最好的函数(cost function最小)即可;

注意:

(1)因为是线性回归,所以学习到的函数为线性函数,即直线函数;

(2)因为是单变量,因此只有一个x;

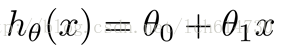

我们能够给出单变量线性回归的模型(即我们假设这个函数就是最终结果):

-------h(x)为hypothesis;

-------h(x)为hypothesis;

从上面“方法”中,我们肯定有一个疑问,怎么样能够看出线性函数拟合的好不好呢?

我们需要使用到Cost Function(代价函数)或者是J(theta0,theta1),代价函数越小及图上所有的点到我们假设的直线模型h(x)距离平方和最小就好(最小二乘法),说明线性回归地越好(和训练集拟合地越好),当然最小就是0,即完全拟合;

| 举个实际的例子: 我们想要根据房子的大小,预测房子的价格,给定如下数据集:

南京年份和平均房价(这个是本人上网查的不准确,将就着看吧!) # X是年份 均要加上2000年 |

最后

以上就是健壮导师最近收集整理的关于第一讲.Liner_Regression and Gradient_Descent(Rui Xia) 单变量线性回归及梯度下降的全部内容,更多相关第一讲.Liner_Regression内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

![[Python]数据挖掘(1)、梯度下降求解逻辑回归——考核成绩分类ps:本博客内容根据唐宇迪的的机器学习经典算法 学习视频复制总结而来http://www.abcplus.com.cn/course/83/tasks逻辑回归](https://www.shuijiaxian.com/files_image/reation/bcimg14.png)

发表评论 取消回复