靠谱客(kaopuke.com) 6月5日消息:阿里巴巴与中国科学技术大学联手推出了一款名为ViViD的新框架,旨在革新虚拟试衣体验。ViViD基于先进的扩散模型技术,能够实现视频中人物衣物的实时替换,从而生成自然且逼真的视频效果。

ViViD的推出解决了以往视频试衣中难以保持时间一致性和图像质量的难题。它由三大核心组件构成:服装编码器、姿势编码器以及时间模块。这些组件协同工作,不仅可以精确提取衣物细节的语义特征,还能对人物姿势进行编码,并确保整个视频在时间线上的连贯性。

为了进一步提升试衣效果,研究团队还引入了一种创新的注意力特征融合机制。这种机制优化了衣物语义信息的整合过程,使得最终呈现的试衣效果更加贴合用户的多样化需求。无论是上半身、下半身还是连衣裙等不同类型的服装,ViViD都能够轻松应对,展现出其强大的适应性。

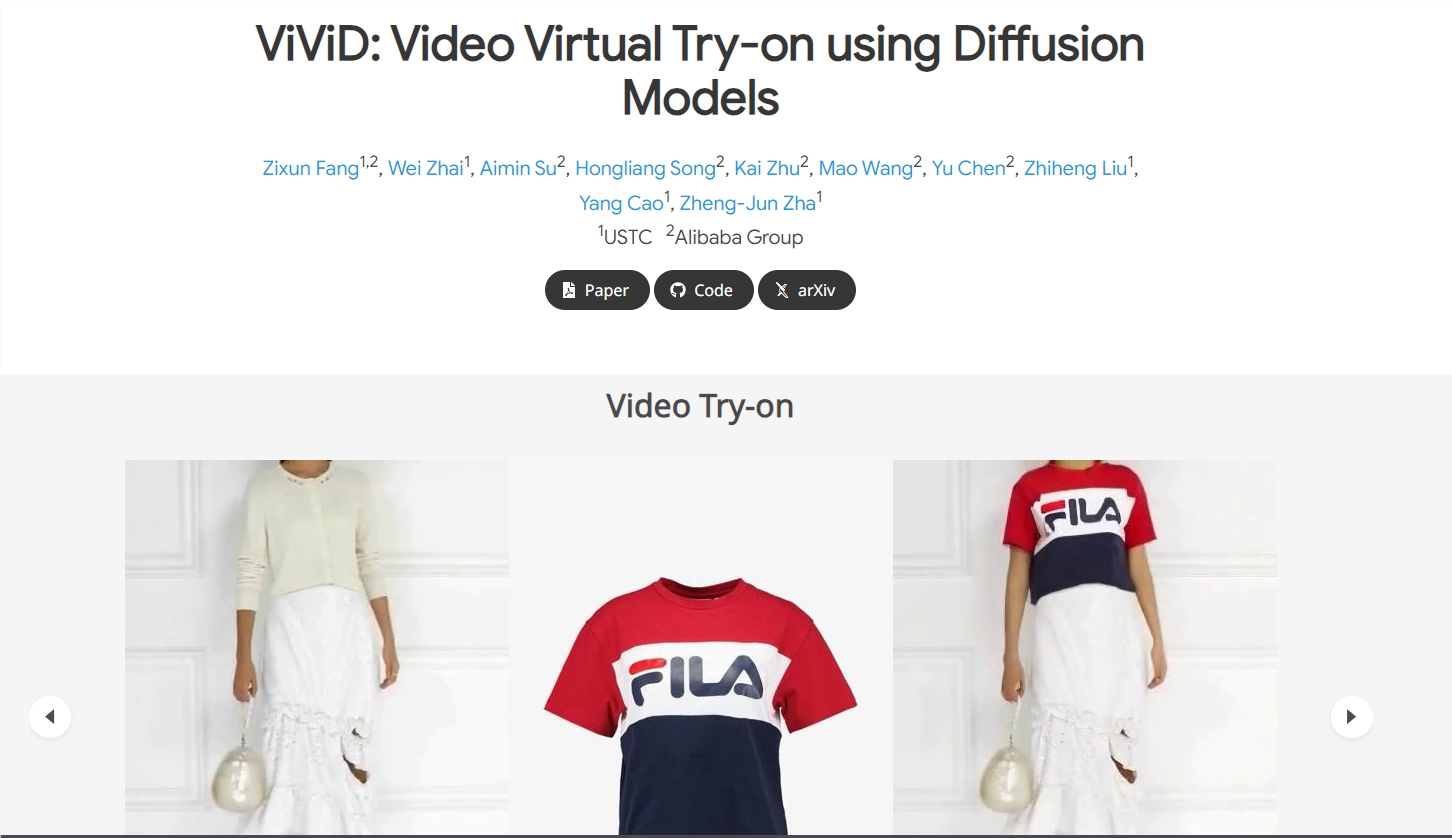

视频来自官方项目页

在实验测试中,ViViD展现出了令人瞩目的性能。与其他现有方法相比,它在视觉质量、时间一致性以及细节保持方面都取得了显著优势。实际演示中,用户可以选择单独更换上衣或裤子,或者同时替换两者,这种灵活的选择极大地丰富了用户体验。

为了全面评估ViViD的性能,阿里和中科大的研究团队投入了大量资源构建了一个专门的数据集,命名为ViViD数据集。这个数据集包含了高达9700个服装视频对,分辨率高达832×624,是目前公开数据中规模最大、多样性最高且分辨率最清晰的视频虚拟试衣数据集。

ViViD的问世不仅是人工智能领域的一项技术突破,更是虚拟试衣技术迈向实用化的重要一步。随着这一新框架的推广和应用,未来消费者在线上购物时将能享受到更加便捷、直观的试衣新体验,为零售商和电商企业带来新的增长机遇。

项目页:https://becauseimbatman0.github.io/ViViD

论文地址:https://arxiv.org/pdf/2405.11794

(举报)

发表评论取消回复