声明:本文来自于微信公众号 量子位,作者:明敏 鱼羊,授权靠谱客转载发布。

安卓新王骁龙8至尊版一出,2024年最后一季度的手机市场再度火热起来。

新硬件,新功能,让人眼花缭乱的表象之下,核心关键词必然是:AI,AI,还是AI。

无论是荣耀的一句话命令,让手机助手按照你的习惯帮你点奶茶:

还是超级小爱的帮你记、帮你找:

如果说此前市场对于AI手机还有“蹭大模型热度”的犹豫和质疑,那么如今各大厂商都在用实际进展证明:

端侧AI,已经成为手机新的竞争焦点。

而如此时间节点的如此变化,反映的一个事实是,应用侧的坚定AI化,背后更关键的信心来源之一,依然是底层硬件的变化。

不只是堆料堆算力,让大模型能被装进手机,更是为了让AI能在端侧真正被用起来、用得好,围绕AI进行的全方位性能升级,甚至颠覆重构。

在量子位举办的MEET2025智能未来大会上,2024人工智能年度杰出产品榜出炉,高通的骁龙8至尊版移动平台入选,关键原因之一便是其正引领终端侧AI的发展,并对行业广泛赋能。

各种细节,今天,我们就掰开骁龙8至尊版,一项一项具体来看。

AI手机需要什么样的芯片?

作为新一代手机最强芯,骁龙8至尊版的核心目标很明确:全面重构性能、全面重构AI。

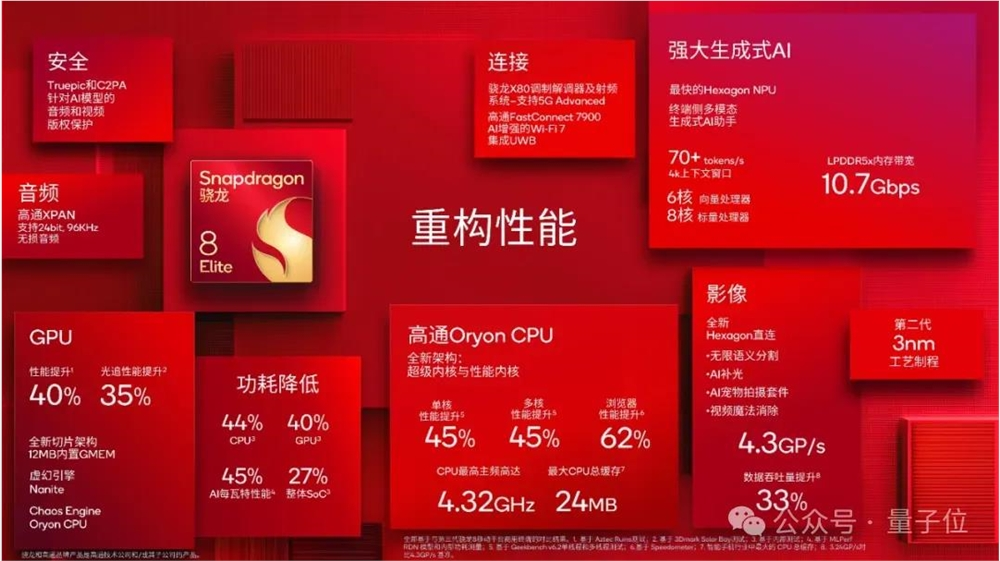

先来看整体的数据:

CPU单核和多核性能相比前代均提升45%,浏览器性能提升62%,同时,CPU功耗降低44%。

GPU性能提升40%,光线追踪性能提升35%,同时,GPU功耗降低40%。

NPU增加额外内核,拥有6核向量处理器和8核标量处理器,AI性能提升45%,每瓦特性能提升45%,支持70+tokens/s的输入,以及4k上下文窗口。

骁龙8至尊版还支持高达10.7Gbps速率的LPDDR5X内存,以增强终端侧AI的使用体验。

不难看出,在猛攻性能的基础之上,高通在这一代骁龙旗舰芯片上,又着重强调了性能与功耗的平衡。

本质的原因,还是要适配AI手机时代的全新变化。

在今年的骁龙峰会上,高通官方也从用户体验的视角,对这些变化做了更全面的展示:

首先,是真正“知你所言,懂你所想”的个性化多模态AI助手。

就像手机厂商们正在竞相宣传的那样,大模型加持下的AI助手,不仅仅是“听得懂人话”版的增强型语音助手,更关键的是,它能充分挖掘用户在手机端留存的个性化数据,通过分析用户的操作、语音等信息,在准确感知、理解用户意图的基础之上,变革人机交互体验——从单一场景到多场景、多任务,甚至是从人找服务到AI助手主动为人做策划。

比如,让AI助手看一眼你的旅行账单,Ta就能自动根据你的行为偏好,帮你分析怎么更好地省钱。

其次,手机传统的宣传重点——影像体验也将进一步被AI重构。

具体体现为,很多原本需要后期才能实现的图像和视频效果,现在实时就能在手机端实现。

比如利用无限语义分割技术(支持250+层语义识别和分割),精细控制照片的每一处细节。即使光线不佳,NPU也能识别不同图层,进而预测皮肤和天空的色调,呈现更完美的拍摄效果。

又比如视频通话或直播时的实时AI补光,可以添加虚拟的可移动光源来给人脸“打光”,提升人像在镜头中的观感。

另外,去年火爆的手机端照片“路人消除”大法,现在进一步延展到了视频当中。

划重点:这样的操作可以完全脱离云端,在终端设备上本地完成。

当然还有游戏体验。

网易已经第一时间官宣了和高通在《永劫无间》手游上合作的最新进展:除了更强性能下更高的游戏帧率和稳定性外,基于高通Hexagon NPU,《永劫无间》手游首次将18亿参数大模型引入智能手机,打造全新升级的端到端AI队友功能。

该功能不仅能让AI队友听懂玩家的语音对战指令,还支持人类和AI玩家之间的自然语音对话,首词时延可控制在300ms以内。

可以说,AI化的框架已经全面搭建起来,更多AI手机细节功能的实现,就要看各路手机厂商的本事了。

简单总结一下,在骁龙8至尊版支持下,AI手机在以下几个维度有了明显提升:

AI运行速度

多模态交互

AI Agent(智能体)“自动驾驶”

在其背后,无论是能在手机上调度各种功能的AI助手,还是更AI的影像、游戏体验,都意味着更多Agent进入手机,意味着更复杂的系统调度和数据分析。

那么,问题就来了:手机毕竟是重量仅为200克左右的终端设备,性能之外,电池续航、发热问题同样是直接影响用户体验的因素。

来到AI手机时代,性能与功耗之间的矛盾更加凸显,具体又待如何解决?

CPU+GPU+NPU,释放AI能力

这次,除了对于AI而言最为关键的NPU,在CPU和GPU上,高通同样做了不少文章。

在CPU上,高通历史性将自研Oryon CPU带到移动端。

它负责处理对时延敏感的AI任务,比如实时翻译、AI助手命令响应等。并负责将AI任务分配到其他核心上。

它在架构上全面升级,采用“2+6”模式,2枚超级内核+6枚性能内核,取消效率内核。

超级内核最高主频达到4.32GHz,明显超越同行。

6个性能内核都经过调优,负责运行最密集型的应用程序,用乱序性能内核取代了传统的效率内核,实现了效率和能耗的既要又要。

内存架构上,Oryon CPU每个CPU丛集配备最大的缓存,即每个丛集都拥有12MB的二级缓存,总计24MB紧密耦合的专用缓存,这也是移动领域最大的缓存。

同时也增加了每个超级内核和性能内核中的L1缓存。

如前所说,Hexagon NPU方面,高通也带来一系列升级。

在NPU驱动下,可以完成70+Tokens/秒、4K上下文的生成能力。Token是信息构建模块,可以是文本、语音,甚至是照片和视频。骁龙8至尊版以支持更长上下文窗口和更多token输入量。更长的上下文窗口将为用户的AI助手提供更丰富的情境信息,以便进行复杂推理。

并为应对多模态AI任务增加了额外内核。

值得一提的是,骁龙8至尊版首次实现了让AI助手完全运行在终端时理解摄像头中拍摄的内容,用户可以通过摄像头和AI助手实时互动。

利用手机的丰富传感器,AI助手可以结合用户的位置、偏好和个人习惯创建个性化神经网络,以便AI助手针对用户需求生成个性化回复。

高通传感器中枢是实现个性化AI助手的门户,骁龙8至尊版对其进行了一系列改进,它现在的AI性能提升了60%。

为了更好支持大语言模型、超长文本应用等,张量加速器方面也做了增强。

此外,内存并发性,AI和计算机视觉工作负载现在可以同时访问一个内存空间并协同工作,创造流畅有趣的体验。

GPU方面,骁龙8至尊版首次推出了Adreno GPU切片架构,将内部渲染单元分为三个独立切片,其中每个切片都可以运行在对应主频。

这样一来就能实现动态调整不同工作负载,得益于这一架构,GPU性能提升40%,功耗降低40%。

GPU支持12MB内存,可以减少数据传输交互时对系统内存的访问调用。

基于如上底层计算的全面升级,完全在终端运行的个性化、多模态AI助手等全新体验得以走进现实。

但是底层计算只是实现这一切的基石。软件层面,先进算法和海量工具,是生成式AI应用得以繁荣的另一大关键。

与智谱、腾讯混元达成大模型合作

AI重构手机,不仅是交互模式、计算范式上发生巨变,更关键在于上层应用生态也将被快速重塑。

各种APP、功能都在引入AI,手机厂商、AI厂商、互联网大厂都在积极尝试。不过怎样才能更充分调用底层计算、发挥大模型能力,构建真正满足大家需要的AI应用?现在确实还处在探索早期。

所以可以看到,在完成对端侧AI计算的定义后,高通开始更进一步促成上层应用生态的构建。

今年,伴随着骁龙8至尊版正式发布,高通还官宣了两则重磅消息——和智谱以及腾讯混元的合作。

两家的合作,也印证了AI手机的两大发展方向:端侧与多模态。

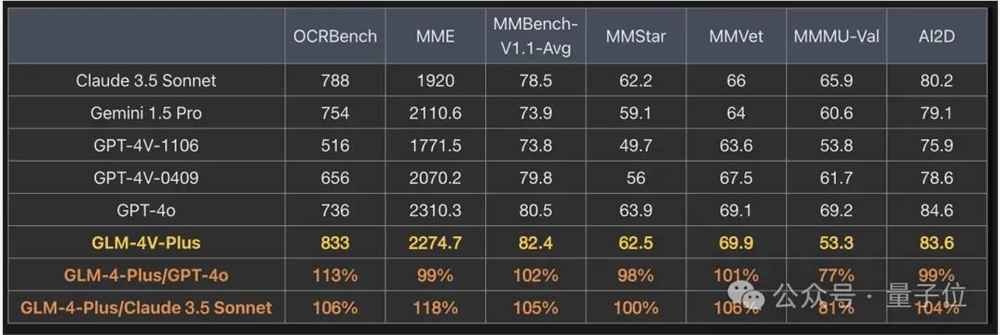

在和智谱的合作中,高通明确提到将GLM-4V端侧视觉大模型将面向骁龙8至尊版进行深度适配和推理优化,支持丰富的多模态交互方式。

今年早些时候,智谱推出了国内首个类GPT-4o视频通话功能,底层模型基于GLM-4V-plus,在图像和视频理解方面都取得了不错成绩。

骁龙峰会上,高通也表示现在AI助手可以完全在终端侧通过摄像头看到用户所看到的内容,用户可以通过相机实时模式和AI助手互动,也就是把AI视频通话彻底放在端侧。

据介绍,用户可以直接把摄像头对准账单收据,然后AI通过推理来计算个人应付的账单。

和腾讯混元的合作中则提到,双方将基于骁龙8至尊版共同推动混元大模型7B和3B版本的终端部署。

这两项合作的官宣意味着智谱和腾讯混元大模型,未来将有可能深度参与骁龙平台上先进AI应用范例的开发与打造。

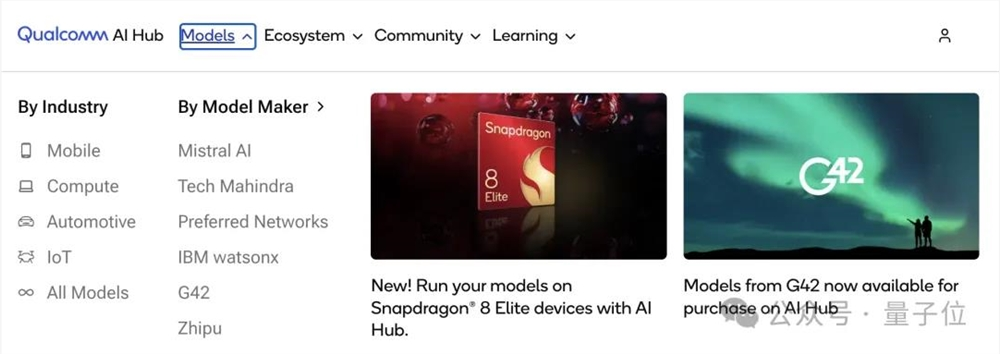

实际上,在大模型趋势开始后,高通就马上推出了AI Hub,为开发者和企业构建了一个开放的AI开发平台。

在AI Hub上,开发者可以找到各种主流大模型,利用高通提供的工具集进行开发。

它能让开发者充分利用高通芯片的计算能力,将AI推理放置在设备端,实现低延迟、高效率的本地化AI处理,进一步丰富端侧AI应用。

平台提供的工具集能够帮助开发者优化AI模型,使其在高通芯片上运行更加高效,同时简化了部署过程。

同时,AI Hub与高通的其他开发工具紧密结合,如Qualcomm Neural Processing SDK(神经处理SDK),为开发者提供全面的开发环境。

更早之前高通推出的AI软件栈(AI Stack),还全面支持主流AI框架(如TensorFlow、pytorch、ONNX和Keras)和runtime(如 TensorFlow Lite、TensorFlow Lite Micro、ExecuTorch和ONNX runtime),能帮助开发者进一步加快开发流程。

软硬结合,才能更彻底释放AI手机的潜力。

比如前面提到的实时AI补光技术,就是算法和底层硬件高效连接的成果。

在影像领域,高通将先进的AI算法直接引入图像和视频处理管线的核心(Insight AI),其中的无限语义分割功能,支持对图片进行超过250层语义识别与分割。在完成分割后,实时皮肤和天空算法可以利用NPU来识别光线条件并进行修图,保障在强光条件下也能拍出自然的皮肤和天空色调。

从CPU变革到AI手机变革

所以,高通如何理解AI手机?

APP/应用成为人类使用互联网的入口,构成了当下人机交互最重要的范式。

AI的出现让这些熟悉的事物开始瓦解,当机器开始理解人类语言,交互可以变得更为主动,智能化体验也将被重新定义。

在骁龙峰会上,高通总裁兼CEO安蒙一语道破:

我们将看到, 应用程序的不断进化所催生的全新体验……而且这不局限在某一个杀手级应用,而是每一个应用的体验都将改变。

如今,骁龙8至尊版为实现这一愿景提供了一个强大平台。

在这里,移动计算被重构,移动计算的发展方向也更加明了——

当AI成为移动设备的全局性能力,更强大的CPU将成为必需,小核已经成为过去时。NPU作为天生为AI而来的硬件核心,负责为多模态、超长文本等能力提供支持。GPU则继续在擅长的游戏、图像领域发挥能力。

当然,为了满足AI模型运行的需求,大内存也成为必然。

由此,语音助手、实时翻译等功能才能提供更快速响应、更智能回复,得以脱胎换骨成为真正意义上的AI应用。

2024年,AI手机的趋势已经势不可挡。这是从算法到应用再到底层计算的全方位变革。

而想要真正意义上带来AI手机风暴,这个逻辑或许要转换一下,先从底层计算看起。

已经为行业定义了NPU的高通,如今正从CPU开始,为行业重新定义AI时代的移动计算。

(举报)

发表评论取消回复