Meta-Llama-3.1-70B 是什么?

Meta-Llama-3.1-70B是Meta公司推出的大型语言模型,拥有 70 亿个参数,支持 8 种语言的文本生成。该模型采用优化的Transformer架构,并通过监督式微调和人类反馈强化学习进一步优化,以符合人类对帮助性和安全性的偏好。模型在多语言对话使用案例中表现优异,超越了许多现有的开源和封闭聊天模型。

Meta-Llama-3.1-70B 有哪些功能?

- 支持 8 种语言的文本生成,包括英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。

- 采用Grouped-Query Attention (GQA)技术,提高推理扩展性。

- 经过监督式微调(SFT)和人类反馈强化学习(RLHF),以提高模型的有用性和安全性。

- 优化的Transformer架构,为多语言对话使用案例提供了高性能。

点击前往「Meta-Llama-3.1-70B」官网体验入口

谁适合使用 Meta-Llama-3.1-70B?

Meta-Llama-3.1-70B的目标受众为需要在多种语言环境下进行文本生成的开发者和研究人员。无论是构建聊天机器人、语言翻译服务还是多语言内容创作,Meta-Llama-3.1-70B都能提供强大的语言理解和生成能力,帮助他们实现更加丰富和准确的自然语言处理应用。

Meta-Llama-3.1-70B 是如何工作的?

Meta-Llama-3.1-70B使用优化的Transformer架构,通过Grouped-Query Attention (GQA)技术提高推理扩展性。经过监督式微调(SFT)和人类反馈强化学习(RLHF),以提高模型的有用性和安全性。用户可以通过调用模型的generate()函数,输入文本提示并获取生成的文本。根据反馈调整模型参数,优化文本生成结果。

Meta-Llama-3.1-70B 的主要特点

| 主要特点 | 需求人群 | 使用场景 | 产品特色 |

|---|---|---|---|

| 支持 8 种语言的文本生成 | 需要在多种语言环境下进行文本生成的开发者和研究人员 | 构建聊天机器人、语言翻译服务还是多语言内容创作 | 优化的Transformer架构 |

| 采用Grouped-Query Attention (GQA)技术 | 经过监督式微调(SFT)和人类反馈强化学习(RLHF) | ||

| 提高模型的有用性和安全性 |

Meta-Llama-3.1-70B 使用教程

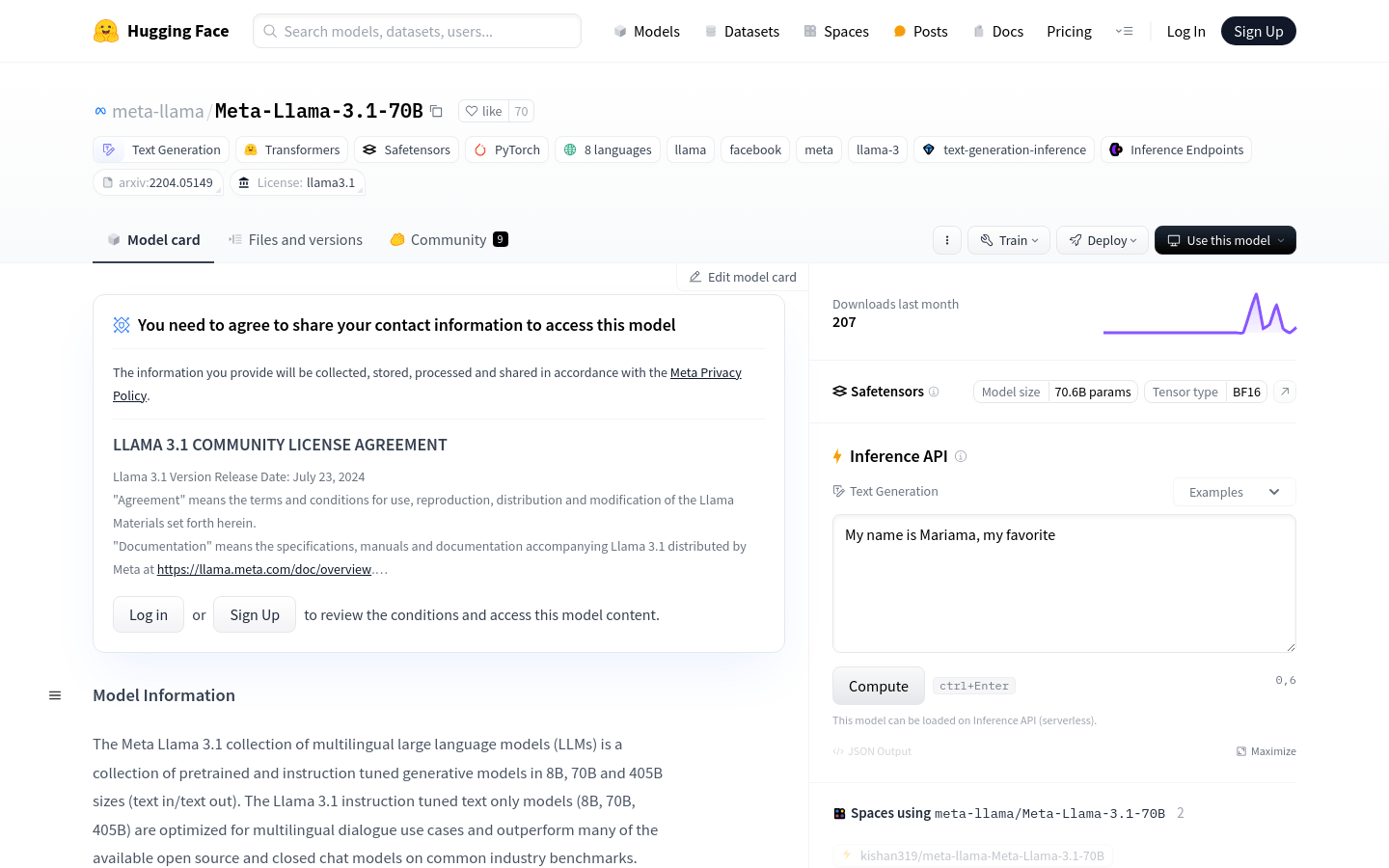

- 访问Hugging Face模型库并搜索’Meta-Llama-3.1-70B’模型。

- 根据需要的应用程序场景,选择使用transformers库或原始llama代码库。

- 使用pip命令更新transformers库到最新版本。

- 导入transformers库并加载模型,设置适当的参数,如使用’torch.bfloat16’数据类型和自动设备映射。

- 通过调用模型的generate()函数,输入文本提示并获取生成的文本。

- 根据反馈调整模型参数,优化文本生成结果。

- 将模型集成到最终的应用程序中,实现多语言文本生成功能。

Meta-Llama-3.1-70B 是免费的吗?

Meta-Llama-3.1-70B遵循Llama 3. 1 社区许可协议,允许商业和研究用途。具体定价信息请访问官网。

关于 Meta-Llama-3.1-70B 的常见问题

- Meta-Llama-3.1-70B支持哪些语言?

- Meta-Llama-3.1-70B支持 8 种语言的文本生成,包括英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。

- 如何使用 Meta-Llama-3.1-70B?

- 用户可以通过调用模型的generate()函数,输入文本提示并获取生成的文本。具体使用方法请参考使用教程。

- Meta-Llama-3.1-70B是否免费?

- Meta-Llama-3.1-70B遵循Llama 3. 1 社区许可协议,允许商业和研究用途。具体定价信息请访问官网。

前往 AIbase 查找更多「 Meta-Llama-3.1-70B 」同类产品

AIbase智能匹配最适合您的AI产品和网站。AIbase拥有一个全面的国内外AI产品数据库,收录了超过 7000 个出色的人工智能网站和产品,覆盖了 40 多个不同的领域,如Ai绘画生成、Ai文案写作、Ai视频编辑、Ai智能营销等。您可以通过我们的AI产品库轻松发现最适合您需求的人工智能工具,解锁AI的力量。

(举报)

发表评论取消回复