论文来自AAAI2020 oral

论文地址:https://arxiv.org/abs/2005.04580

摘要

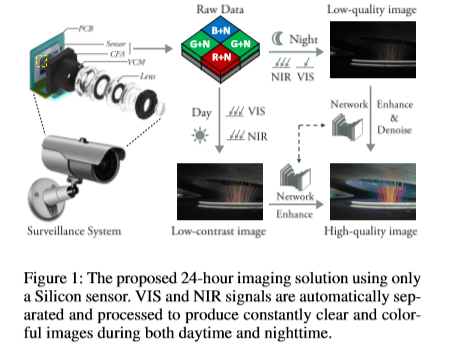

目前,24小时室外成像的行业惯例是使用硅相机,并辅以近红外(NIR)照明。这导致彩色图像白天对比度差,夜间没有色度。对于这种困境,所有现有的解决方案都试图分别捕获RGB和NIR图像。然而,它们需要额外的硬件支持,并且存在使用寿命短、价格昂贵、特定使用场景等诸多缺点。本文提出了一种新颖的、集成的增强解决方案,无论是在白天充足的阳光下还是在极低的光照下,都能产生清晰的彩色图像。我们的核心思想是从混合信号中分离出可见光和近红外信息,并以近红外信号为辅助对可见光信号进行自适应增强。为此,我们建立了一个光学系统来收集新的VIS-NIR-MIX数据集,并提出了一种基于CNN的图像处理算法。大量的实验展示了突出的结果,证明了我们的解决方案的有效性。

引言

许多实用的成像系统,如监视系统,需要连续稳定的运行。我们希望在24小时内拍摄到高质量的图像。因此,环境光照变化成为一个不可忽略的因素。普通相机通常在充足的日光下工作良好,但在夜间光线不足时性能不佳。简单地使用闪光灯或增加曝光时间是不切实际的,因为它们会改变成像色调、曝光覆盖范围并导致图像模糊。

为了克服这一局限性,现有的大多数解决方案都使用额外的近红外(NIR)照明来照亮物体并捕获它。然而,对于这些系统来说,NIR是一把双刃剑。一方面,它利用了硅传感器在700nm-950nm之间的灵敏度,允许在黑暗中获取视觉信息。另一方面,它会影响可见光谱(VIS)信息的获取,导致彩色图像质量下降。

对于这种困境,先进的解决方案倾向于分别捕获近红外和可见光信号。三种典型的硬件辅助解决方案包括使用可调红外截止滤光片、使用特定的彩色滤光片阵列(cfa)和使用两种不同的成像传感器。在第一种情况下,在足够的照明下自动或周期性地安装IR-Cut滤波器,否则将被移除。然而,这需要额外的照明强度传感器,也缩短了使用寿命。在第二种情况下,特定的cfa直接捕获近红外和可见光信息,但图像分辨率和质量受到很大限制。对于最后一种选择,使用两个摄像头会增加成本,同时也会面临细致化校准的困难。整体来说,所有试图同时捕获近红外和可见光信号的现有解决方案仍然存在局限性。

与现存解决方案不同,本文建议直接从单个传感器捕获的混合信号中分离可见光和近红外信号,而无需任何额外的硬件,如图1所示。所需的硬件只是一个没有红外截止滤波器的普通硅传感器。通过我们提出的算法,我们的解决方案不仅大大降低了成本,而且在白天和晚上都能产生清晰多彩的图像。

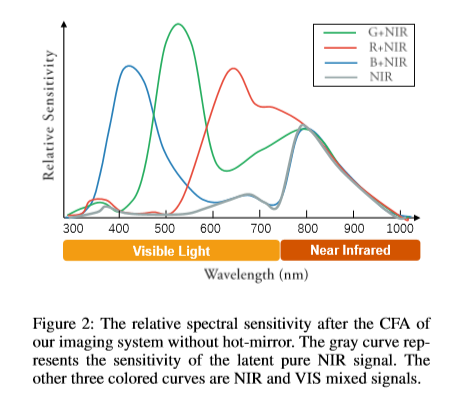

我们的关键在于正确使用硅传感器的宽范围,即300-950纳米的灵敏度,来捕捉等同于VIS和NIR成分的信息,如图2所示。因此,我们提出从混合信号中自动分离出可见光和近红外信号,并以此为指导对可见光图像进行增强和恢复。为此,我们设计了一个光学成像系统,并建立了一个新的VIS-NIR-MIX图像数据集,从而可以学习一个物理意义上的RAW-To-VIS映射网络。

定性和定量实验都表明,我们提出的解决方案能够在充足的阳光和极低光照的场景下生成彩色清晰的图像,优于现有的解决方案。总体而言,我们的主要贡献有三个方面:

我们提出了一个完整的增强解决方案,只使用一个普通的硅传感器,而不需要额外的硬件。

我们设计了一个原型成像系统,并构建了一个新的数据集,该数据集具有对齐的RAW/VIS/NIR图像,使得RAW-VIS映射更加精确。

提出并实现了一个端到端网络的图像处理模型。为高质量的图像生成提供了有希望的结果。

相关工作

不稳定光照下的成像是许多成像系统面临的主要挑战。现有的研究大多集中在特定的实例上,而不是提供一个完整的24小时彩色成像解决方案。根据使用的信息,大致可分为三类:仅使用VIS信号、仅使用NIR信号和同时使用VIS/NIR信号。在这一部分,我们将简要概述最相关的工作。

Using only VIS signals.

可见光图像的增强与恢复一直是研究的热点。现有的增强方法主要有基于直方图均衡化(HE)的方法(Nakai、Hoshi和Taguchi 2013)、基于Retinex理论的方法(Guo、Li和Ling,2017)和基于学习的方法(Chen et al。2018年;Lv等人。2018年;Lv、Li和Lu,2019年)。现有的去噪方法是大量的,通常包括基于滤波器的方法(Dabov等人。2007年),有效的基于先验的方法(Xu、Zhang和Zhang 2018a)、基于低秩的方法(Yair和Michaeli 2018)、基于稀疏编码的方法(Xu、Zhang和Zhang 2018b)和基于学习的方法(Remez等人。2017年)。虽然这些研究极大地促进了图像增强和去噪技术的发展,但离24小时成像系统的要求还有很大差距。

Using only NIR signals.

一些研究(Limmer和Lensch 2016;Suárez,Sappa和Vintimilla 2017)考虑直接学习NIR到RGB映射,以避免不稳定的环境可见光照明的影响。然而,近红外图像和可见光图像并不完全相同,这将导致不切实际的结果。更为根本的是,物体的颜色往往具有内在的模糊性,这意味着在没有附加约束的情况下,很难从近红外信号中准确地估计出颜色信息。因此,这种着色方法通常用于特定目的,而不是用于高质量的成像系统。

Using both VIS and NIR signals.

由于近红外图像具有各种优点,例如无雾,因此使用可见光和近红外信号的解决方案已成为24小时成像系统的行业标准。有三种常见类型:使用可操纵的热反射镜、使用特定的cfa和使用两个摄像头。在第一种情况下,切换热镜可以确保白天的彩色成像,而在夜间获得几乎是灰色的图像。自动切换除了存在色度损失的缺陷外,还会增加成本,缩短使用寿命。对于第二种情况,特殊的CFA包含近红外成分,这使得它可以同时捕获RGB和NIR信号。许多研究集中在RGB/NIR分离(Teranaka等人。2016)、RGB/NIR联合还原(ParkandKang2016)和微光成像(Yamashita、Sugimura和Hamamoto,2017),使用特殊的CFA。这种特殊的CFA以牺牲彩色图像分辨率为代价,对低分辨率近红外信号进行了处理,从而影响了图像质量。此外,这些特殊CFA的优点将转化为与正常拜耳过滤器在白天的缺点。至于最后一种策略,它可以被看作是第二种情况的升级版本,因为两个摄像头可以同时捕获高分辨率的近红外和可见光图像。这将为微光RGB/NIR处理的研究提供先决条件(Sugimura et al。2015)和RGB/NIR联合修复(Yan等人。2013年)。然而,两台摄像机将增加成本,并面临着细致标定的严重问题。

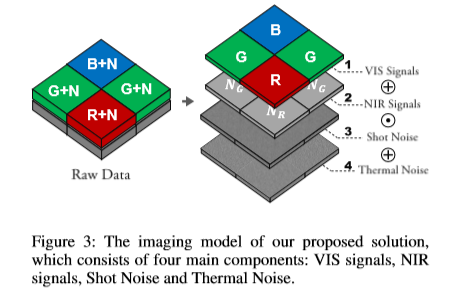

Imaging in Both Daytime and Nighttime: Analysis and an Integrated Solution

如上所述,现有的解决方案在处理24小时成像任务时并不完全令人满意。在本文中,我们提出了一种新颖而完整的24小时彩色清晰成像解决方案,它只需要一个普通的摄像头,而不需要额外的硬件辅助。在本节中,我们将详细的分析我们提出的解决方法的成像机理,如图三所示。

Our imaging model.

我们考虑移除热镜的普通相机,这样可见光和近红外光子都可以到达传感器。假设自动曝光被关闭,一个传感器元件的原始响应可以表示为:

![]()

其中g是放大因子,V是偏置电压,η是量化步长。符号I*是释放的电子,其无噪声版本可表示为:

式中,t为曝光时间,A为有效面积,U为调制函数,λ为波长,L(λ)为入射光谱辐照度,t(λ)为透射率,q(λ)为光电转换函数。我们考虑两种主要的噪声:热噪声和散粒噪声。实际释放的电子I*应表示为:

![]()

式中,Ns(x)表示根据信号x的散粒噪声,Nt表示热噪声。在我们的成像模型中,λ∈[300nm,950nm]。我们可以用近红外-可见光信号的混合和来近似近红外-可见光信号。因此,混合成像模型变成:

![]()

其中Sm是捕获到的混合信号,Sv是无潜在噪声的可见光信号,Sn是无潜在噪声的滤色器通过的近红外信号。

(这一段涉及的光学和摄影设备知识较多,没看懂,不过不太影响)

Analysis on noise signals.

散粒噪声受光照强度的动态影响,而Nt通常是稳定的、可测量的。正如之前的研究报告(Foi等人。2008;郭等。2018),通常采用高斯/泊松噪声来近似热/散粒噪声。假设VIS信号与NIR信号无关,则散粒噪声Ns(siv+sin)≈Ns(siv)+Ns(sin)。根据这个想法,我们将噪声建模为:

![]()

其中P(λ)表示具有参数λ的泊松分布,N(0,σ2)分别表示方差为σ2的零均值高斯分布、Sv和Sn是VIS信号和NIR信号。通过考虑简化反射光模型,我们得到:

![]()

式中,F是将照明转换为信号的非线性相机响应过程,kv是反射系数,Iv(t)表示时间t中的可见光照度水平。同样,NIR 的信号Sn与中的近红外照明水平具有相同的关系。

到目前为止,公式5和公式6模拟了两个主要组件,即式4中的Sv和Sn(论文中好像是写错了),它们显然分别依赖于Iv和In。至于Iv,它在白天变化明显而且能够被Sv显著影响。当Iv不足时,它将具有较低的信噪比。然而,由于存在额外的近红外照明,In是一个稳定的大值,因此Sn稳定且具有较高的信噪比。

The final solution.

基于以上分析,我们建议分离Sv+Ns(Sv)和Sn+Ns(Sn),并借助高质量的NIR信号增强VIS信号。由于Sn+Ns(Sn)的稳定性,使分离成为可能。然后我们的想法是,在白天,当Iv和In都很大时,噪声可以忽略不计,而在夜间,当Iv变小,In仍然很大时,问题就变成了用高质量的NIR信号提供的信息(例如场景结构)来恢复VIS信号。通过这种方式,集成解决方案可以在24小时内生成高质量的图像。据我们所知,这是第一个此类解决方案。

Hardware Design & Dataset Construction

我们设计了一个新的光学成像系统,并建立了一个新的数据集用于训练和基准测试。

Optical Design

有两种可行的方法来收集成对的弱光/正常光图像。一种方法是(Chen等人。2018年)在夜间拍摄,并使用较长曝光时间的图像作为参考。另一种方法(Wei等人。2018)是通过调整白天曝光时间和ISO来成像。前者更符合我们的任务。因此,我们选择第一种方式收集图像。特别的,在夜间每幅图像都要以四种配置捕获:(1)不带滤光片,(2)用可见光滤光片,(3)用长曝光和可见光滤光片,(4)用近红外滤光片。至于白天,我们只需要拍三张照片。

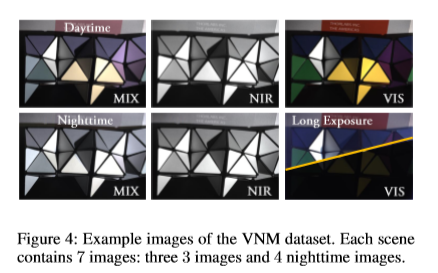

Hardware Configuration

我们设计的成像系统的示意图如图5所示。夜间/白天的曝光分别设置为0.8s/0.08s,长曝光图像的曝光设置为8s。在使用相机(BitranCS-63C, 没有红外截止滤波器)的情况下,使用的分辨率为2048*3072,像素深度为12字节。我们使用一个电动旋转器用于自动滤镜切换,以确保相机拍摄的每一组图像都对齐。它有六个孔:两个放置的VIS-pass过滤器(Thorlabs FESH0700),两个放置的近红外滤光片(Thorlabs FELH0850),还有两个是空的。我们使用氙灯(朝日Lax103)作为光源。对于夜间,我们使用额外的880nm带通滤波器(FWHM=15nm)来模拟LED照明。白天不使用过滤器。

VIS-NIR-MIX Dataset

我们提出了一个新的数据集,它包含了对齐良好的VIS图像、NIR图像及其混合图像。据我们所知,这是第一个此类真实数据集,可以认为是我们在本文中的主要贡献之一。这种VIS-NIR-MIX数据集可以指导VIS和NIR信号从它们的混合图像中分离出来,从而使我们的成像模型的训练成为可能。

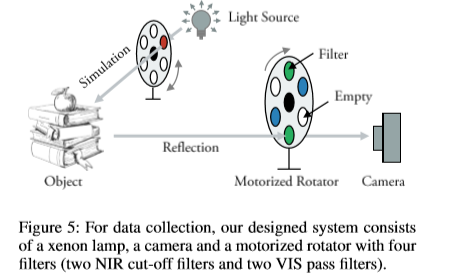

如前所述,我们为每个场景收集7张图像,其中3张用于白天,4张用于夜间。捕获的图像集的示例如图4所示。除了保证物理校准外,我们还手动检查每个样品,以实现精确校准。通过使用上面介绍的采集系统,我们总共收集了102个不同场景的714幅图像。本文使用14幅图像进行测试,其余图像用于训练,其余图像作为训练集。

Methodology

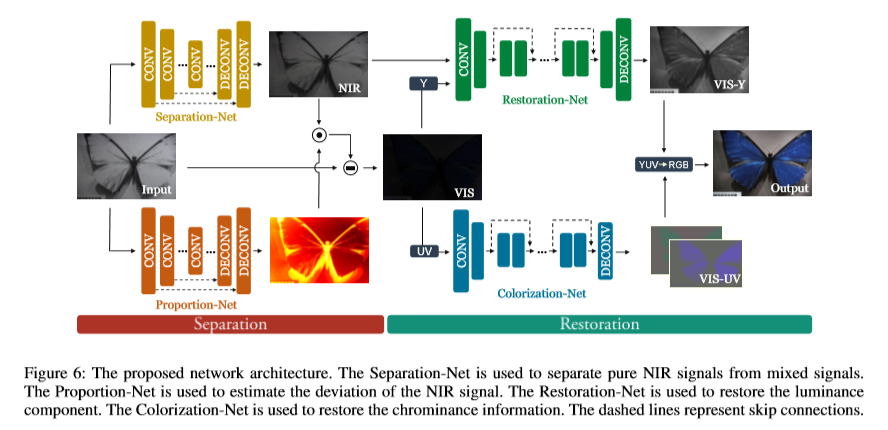

本节将介绍提出的解决方案的具体实现,并提供所有必要的细节。我们的解决方案包括两个主要步骤:分离和恢复。我们设计了一个由四个子网组成的新的网络体系结构。

Network Architecture

如图6所示,提出的网络由四个子网络组成。我们用U-net和Res-Net作为我们网络的基本元素,它们已经被证明是非常有效的。我们使用实例规范化(Ulyanov、V edaldi和Lempitsky 2016)而不是批量规范化(Ioffe和Szegedy 2015)进行规范化。对于U-Net模块,我们的卷积stride为2来下采样,使用Resize卷积层进行上采样(Odena、Dumoulin和Olah 2016)。随着特征图尺寸的减小,特征图的数量加倍,第一层的特征图数量被设置为64。对于所有层,使用Leaky ReLU(除了比例网),卷积核大小被设置为3×3,并且使用跳跃连接时沿着通道维度的连接而不是直接相加。

Separation-Net.

我们使用一个U-Net模块作为虚拟近红外通滤波器来生成纯近红外图像。输入为混合图像,输出为估计的近红外图像。

Proportion-Net.

由于VIS/NIR滤光片的间隔、透射率的限制等原因,所捕获的NIR信号和VIS信号的总和并不完全等于混合信号。考虑到偏差的主要成分在700-850nm之间,与近红外信号相似。我们使用一个U-Net模块来预测这种偏差。与其他子网不同,我们在最后一层使用Sigmoid,在其他层使用ReLU。输入应缩放到[0,1],输出值也以[0,1]为单位,表示近红外信号的偏差百分比。

Restoration-Net.

由于亮度分量与近红外图像相似,我们对色度分量进行了分离(不知道咋分的),以避免可能的干扰。我们直接使用类似ResNet的子网对亮度分量进行增强和去噪。输入是估计的近红外图像和估计的可见光图像的亮度分量。输出是由近红外图像引导的恢复亮度分量

Colorization-Net.

由于颜色的空间频率(单位长度内变化的次数)比强度(0~255?)低得多,一定程度的压缩不会导致色度信息的丢失,反而有利于去噪和增强。与其他子网不同,着色网的输出size仅为输入量的一半。对得到的颜色分量进行大小调整,并与亮度分量进行融合以获得最终结果。

Loss Function

我们提出的总损失函数公式为:L=α·Ls+β·Lr,(7)其中Ls和Lr代表分离和恢复过程的损失函数,α和β是相应的系数。以下是两个损失的详细情况。

为了保持结构的一致性,我们使用了结构感知平滑度损失和著名的图像质量评估算法SSIM和mae作为损失函数。SSIM的值范围为(−1,1],定义见(Wang等人。2004年)。Ls定义为:

![]()

式中,Lma,Lss,λ表示mae、ssim值和系数。Lnsm定义为:

![]()

式中,In为分离网的输出,Im为输入图像,∇表示梯度,λg表示平衡结构感知强度的系数。我们在恢复过程中使用了相似的损失函数,

其中v2和y代表RGB和YUV颜色空间中的输出,Ly sm和Lv2 sm是由近红外信号引导的亮度和可见光信号的平滑约束(类似于公式9),γ2、γ3和γ4是系数,Lv2 pe是感知损失,定义可在(Johnson,Alahi,和Fei Fei 2016)中找到。实验中参数的配置为:α=1,β=1,λn=λv=λv2=λy=100,γ1=0.1,γ2=5,γ3=1,γ4=100,γg=10。

实验结果

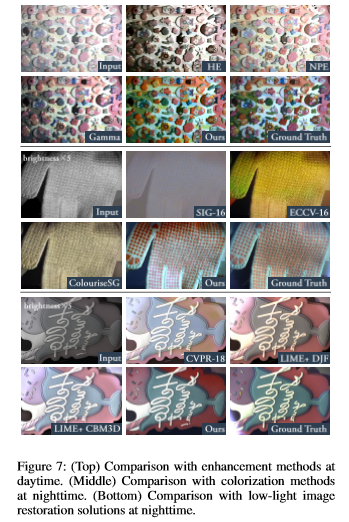

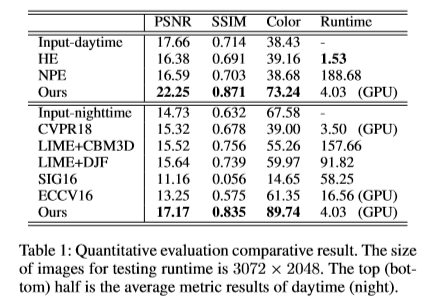

与白天增强、夜间增强和夜间着色方法的比较:

定量评估:

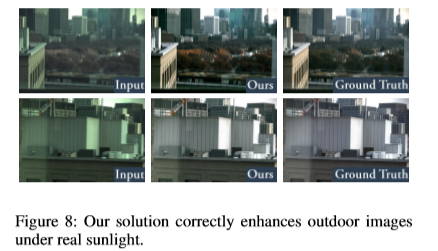

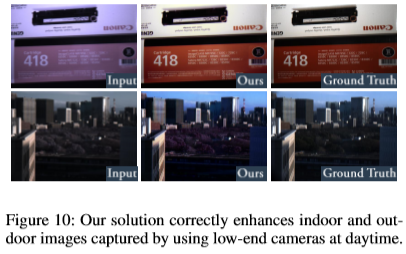

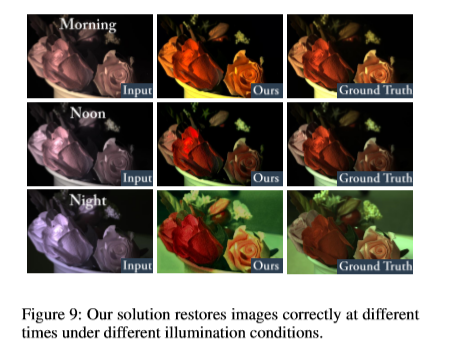

鲁棒性验证:

最后

以上就是故意红牛最近收集整理的关于24小时图像增强方法论文:An Integrated Enhancement Solution for 24-hour Colorful Imaging翻译与解读摘要引言相关工作Imaging in Both Daytime and Nighttime: Analysis and an Integrated Solution Hardware Design & Dataset Construction Methodology实验结果的全部内容,更多相关24小时图像增强方法论文:An内容请搜索靠谱客的其他文章。

发表评论 取消回复