最近在研究RNN。RNN 即循环神经网络,是以是一类以序列(sequence)数据为输入的神经网络,输出不仅取决于当前时刻的输入,还和之前时刻的输入有关。而LSTM则是RNN的一种变种,用于改善RNN在处理long term memory时的缺陷。

在查找资料的时候发现了这篇文章写得非常好,而且通俗易懂。将RNN和LSTM之间的区别阐述的非常明白。

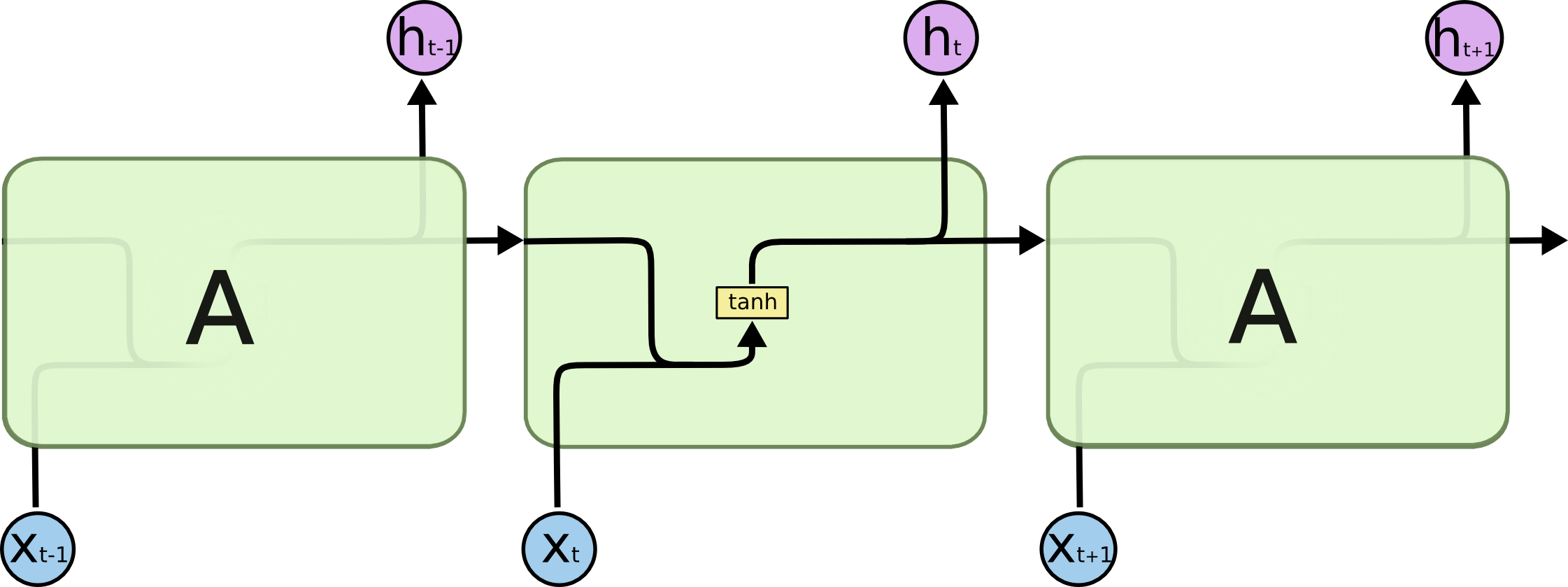

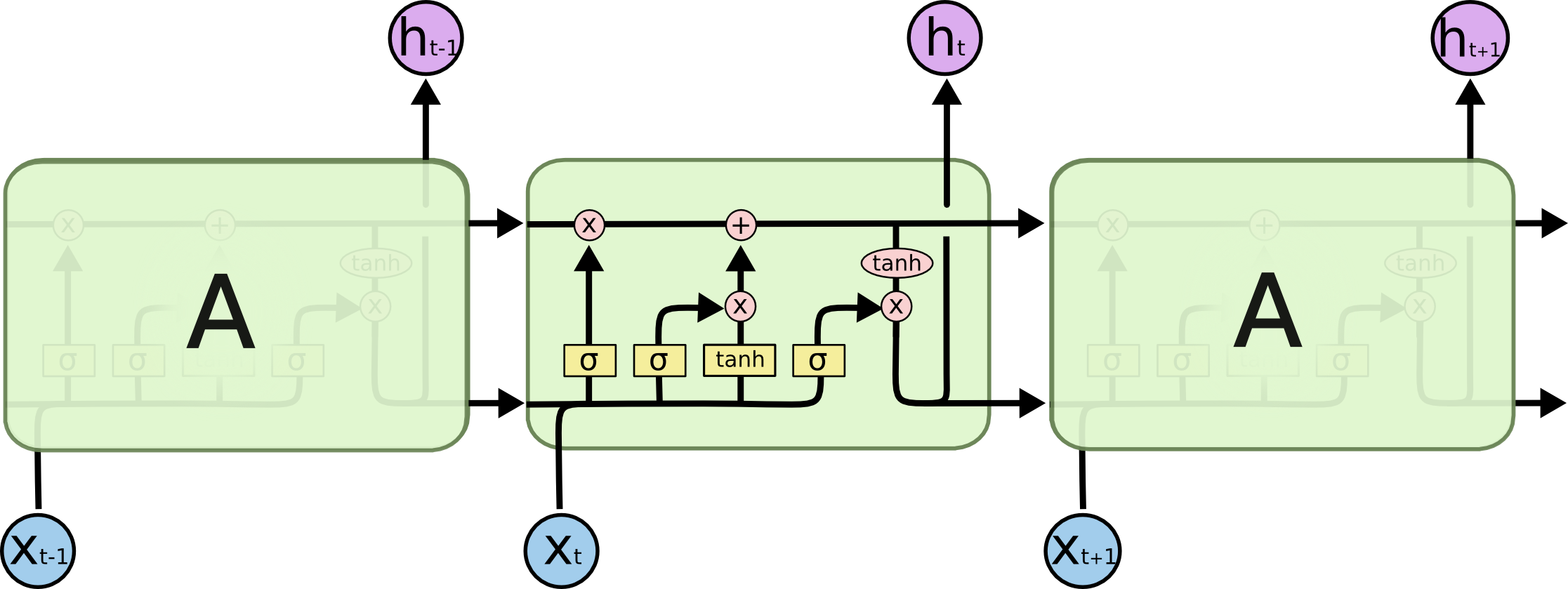

首先是两幅经典的图:来自(http://colah.github.io/posts/2015-08-Understanding-LSTMs/)

RNN:

LSTM:

1)哪些细胞状态应该被遗忘

2)哪些新的状态应该被加入

3)根据当前的状态和现在的输入,输出应该是什么

下面来分别讨论:

1)哪些细胞状态应该被遗忘(遗忘门)

这部分功能是通过sigmoid函数实现的,也就是最左边的通路。根据输入和上一时刻的输出来决定当前细胞状态是否有需要被遗忘的内容。举个例子,如果之前细胞状态中有主语,而输入中又有了主语,那么原来存在的主语就应该被遗忘。concatenate的输入和上一时刻的输出经过sigmoid函数后,越接近于0被遗忘的越多,越接近于1被遗忘的越少。

2)哪些新的状态应该被加入(输入状态门)

继续上面的例子,新进来的主语自然就是应该被加入到细胞状态的内容,同理也是靠sigmoid函数来决定应该记住哪些内容。但是值得一提的是,需要被记住的内容并不是直接

concatenate的输入和上一时刻的输出,还要经过tanh,这点应该也是和RNN保持一致。并且需要注意,此处的sigmoid和前一步的sigmoid层的w和b不同,是分别训练的层。

细胞状态在忘记了该忘记的,记住了该记住的之后,就可以作为下一时刻的细胞状态输入了。

3)根据当前的状态和现在的输入,输出应该是什么 (输出门)

这是最右侧的通路,也是通过sigmoid函数做门,对第二步求得的状态做tanh后的结果过滤,从而得到最终的预测结果。

事实上,LSTM就是在RNN的基础上,增加了对过去状态的过滤,从而可以选择哪些状态对当前更有影响,而不是简单的选择最近的状态。

最后

以上就是活泼长颈鹿最近收集整理的关于LSTM与RNN的比较 (repost from https://blog.csdn.net/lanmengyiyu/article/details/79941486)的全部内容,更多相关LSTM与RNN的比较内容请搜索靠谱客的其他文章。

发表评论 取消回复