1 A2C方法

A2C方法的状态价值输出端针对连续动作保持不变。唯一受影响的是策略的表示形式。

2 确定性策略梯度

论文:Deterministic Policy Gradient Algorithms

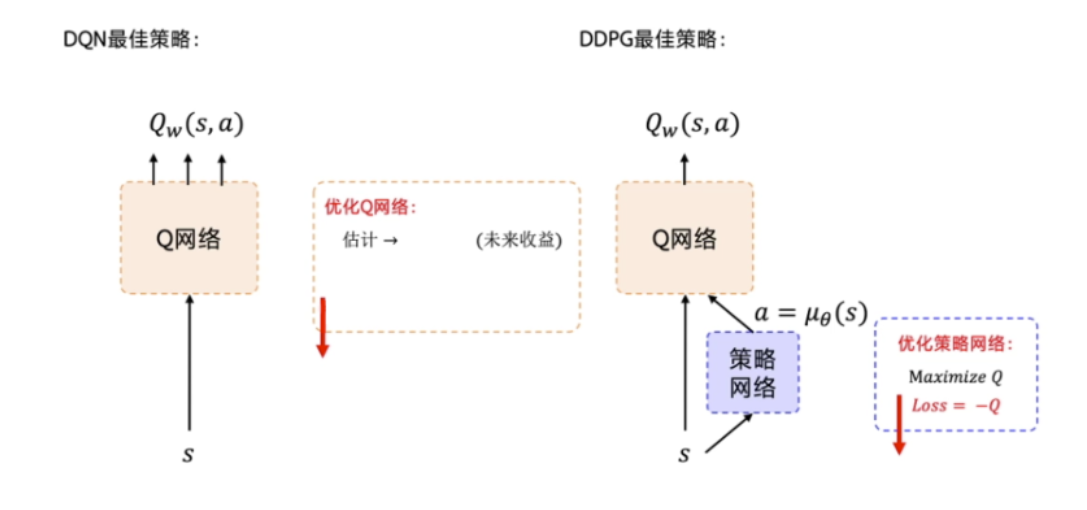

DDPG 在深度 Q 网络基础上加了一个策略网络来直接输出动作值,所以 DDPG 需要一边学习 Q 网络,一边学习策略网络。Q 网络的参数用 w 来表示。策略网络的参数用 θ 来表示。我们称这样的结构为演员-评论员的结构.

3 分布的策略梯度(D4PG)

论文:Distributed Distributional Deterministic Policy Gradient

第一个改进:用概率分布替换critic的单个Q值。将Bellman方程替换为Bellman运算符,该运算符以类似的方式转换分布表示的Q值

第二个改进:使用n阶Bellman方程,加速收敛

第三个改进:使用带优先级的回放缓冲区而不是统一采样的缓冲区

最后

以上就是落寞萝莉最近收集整理的关于连续动作空间1 A2C方法2 确定性策略梯度3 分布的策略梯度(D4PG)的全部内容,更多相关连续动作空间1内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复