目录

- 写在前面

- 前置工作

- 调用网络

- 写在后面

写在前面

本人大四狗一名,不是计算机专业,所以这方面比较菜。最近在学习强化学习的一些算法,python更新太快,很多一两年前的学习资料就不太能用了,涉及到版本匹配和语法的更改等一系列问题。2020b的matlab中加入了DDPGTD3PPO等算法的强化学习算例和强化学习库,于是想用matlab来做强化学习。

之前在忙活开题,放假回家的事儿,好久没更新。????

继上一篇博文,在上一篇文章中写道如何利用DDPG方法训练一个网络,那么,训练出来的网络就涉及到对网络的评价,这个评价可以重复调用训练好的网络,求得利用网络控制器控制的成功率。注意到网络上关于如何调用训练好的网络没有具体的方法说明,故简单写一下。

前置工作

要调用一个网络首先要有agent和env,这里的agent可以使用训练好的,或者是creat出来的都可以,env就是在simulink中搭建的模型。我们说的网络其实就是agent,通过agent根据状态量给出动作量再输入到env中,驱动我们的动力学。

前面的工作我在之前的文章中有过比较详细的介绍,包括编写的逻辑和训练的注意事项,需要者请移步:

https://blog.csdn.net/weixin_46322427/article/details/112172193

调用网络

这里调用网络在前置工作已经做完的情况下很简单,如下:

simOptions = rlSimulationOptions('MaxSteps',100);%最长时间100

experience = sim(env,agent,simOptions);%调用agent

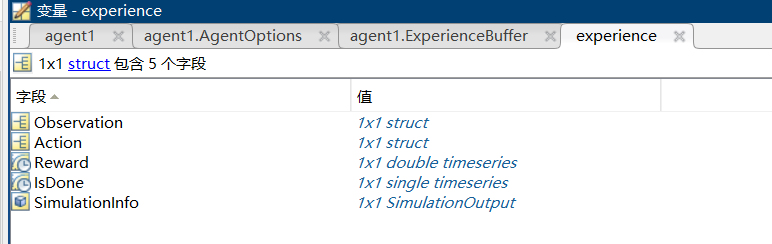

返回的experience是个结构,在工作区显示如下:

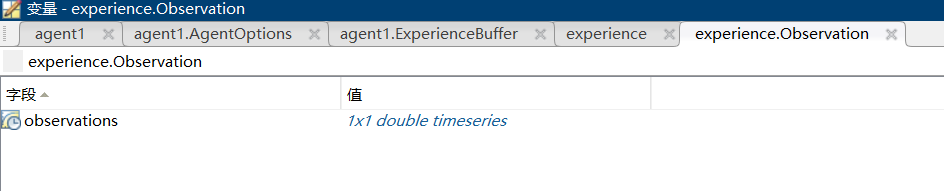

我们可以看到,里面有时间序列的obs,env,rew

ard等我们关心的一系列数据。我们在simulink中to workplace模块里经常选择的是array,那么对于时间序列的数据要如何调用呢?

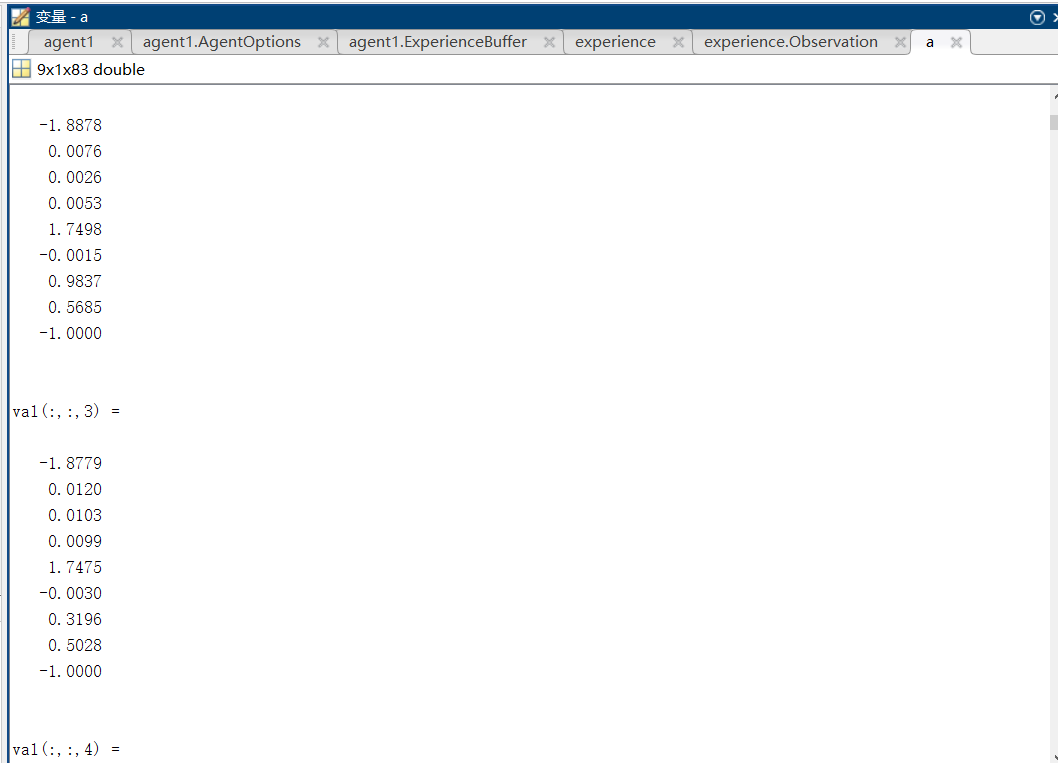

a=experience.Observation.observations.data;

我们可以看到,我们需要的数组信息就可以调出来了。

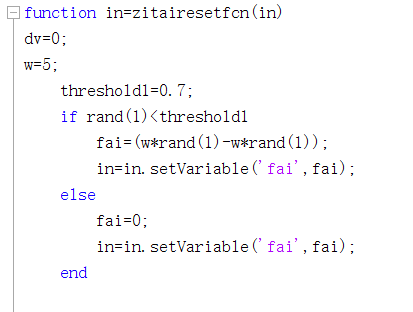

解决好调用的问题我们就可以开始进行网络的性能评估了,首先将reset函数三轴初值的角度设置为-10度至10度。

解决好调用的问题我们就可以开始进行网络的性能评估了,首先将reset函数三轴初值的角度设置为-10度至10度。

我在这里选择调用一百次网络,并记录下来,具体代码如下:

successtime=0;

successtime2=0;

for i=1:100

simOptions = rlSimulationOptions('MaxSteps',100);

experience = sim(env,agent,simOptions);

a=experience.Observation.observations.data;

len=length(a(1,1,:));

if len<100

successtime=successtime+1;

end

b=abs(a(1,1,len))+abs(a(2,1,len))+abs(a(3,1,len))+abs(a(4,1,len))+abs(a(5,1,len))+abs(a(6,1,len));

if b<=0.6

successtime2=successtime2+1;

end

end

这段代码比较好理解,很容易改动。在调用后发现我们的网络效果还可以,成功率在90%左右。

写在后面

最近由于中美关系不好,matlab不让我们学校用了,十分郁闷,只能连着vpn用学校的机房版,在后续强化学习的过程中要逐渐开始python的学习了,不能被人掐脖子。如果各位读者有相关的资源欢迎在评论区评论或者私信给博主:)

水平有限,请有幸看到的您多多指正。在工作之余,祝您早安,午安,晚安。Have a nice day。

(可能的话点个赞再走吧)

P.S.博主还会不定时更新的,喜欢的话就收藏吧。

最后

以上就是勤恳短靴最近收集整理的关于matlab强化学习算法改编/菜鸟理解3——航天器三轴姿态稳定器网络调用·性能评估前置工作调用网络写在后面的全部内容,更多相关matlab强化学习算法改编/菜鸟理解3——航天器三轴姿态稳定器网络调用·性能评估前置工作调用网络写在后面内容请搜索靠谱客的其他文章。

发表评论 取消回复