4.1-4.10日,花了约15个小时,入门了transformer和基于Transformer的BEV perception,记录一下分享给志同道合的人,以下是学习路径。

一、 Transformer原理

-

李宏毅2021深度学习课程,看了3遍self-attention和Transformer的原理,勉强看懂。因为这里是用语音识别作为例子的,和图片应用还是有点不一样。

-

DETR论文,官方代码。官方推理代码一定要看一下,很简单,而且在网页上能直接运行,非常有助于加深理解。

-

两个B站的讲解视频:

- 干货!2022讲得最清晰的【Transformer核心项目DETR目标检测训练】DETR讲的很清楚,而且也很形象,这个老师值得推荐。

- 一个外国哥们讲得DETR论文也很清晰。B站视频讲解

-

Query该怎么理解?这个回答很形象,query跟所有的key求一遍相似度,把这个相似度当做加权值乘以key,所有加权过的key相加,就是最终的结果。现在回过头看,其实自己一开始最大的问题就在于query到底是什么,理解不了。

-

博客 Transformer学习笔记 理解transformer源码

二、 Transformer BEV Perception

刘兰个川。可以先看看这个大佬写的BEV Perception博客,里面总结了4种方案,但作者认为第4种基于Transformer的方案才是未来的方向。

我也认为Transformer也是未来,因此以后将只关注此类的方法。

1 Camera onoy

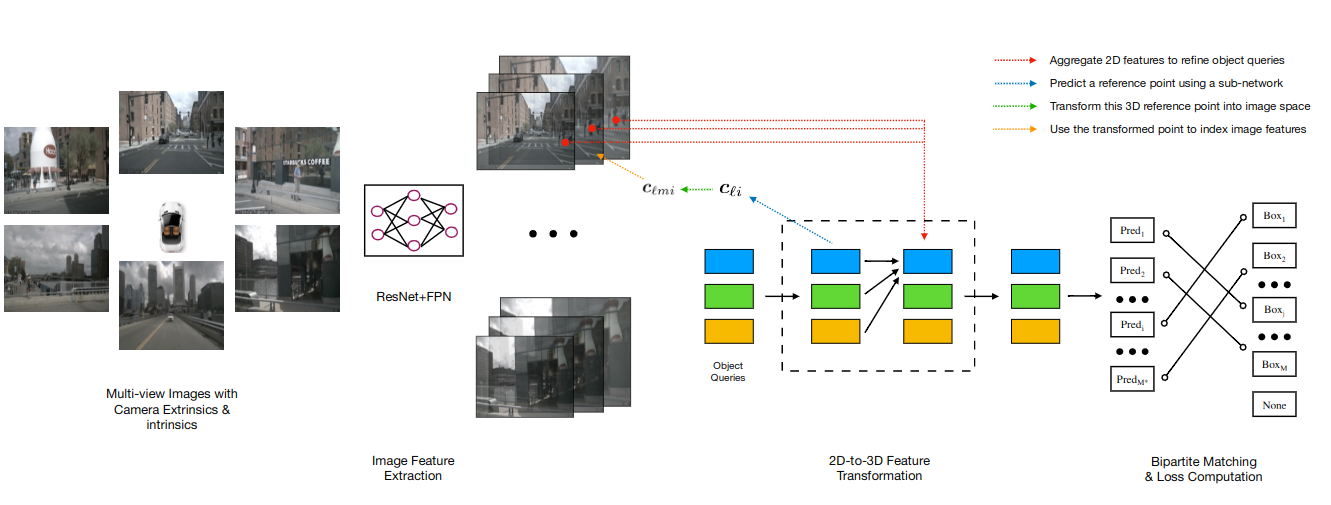

清华,DETR3D

https://arxiv.org/abs/2110.06922

主要思想:固定900个query个数,随机初始化query。每个query对应一个3D reference point,然后反投影到图片上sample对应像素的特征。

缺点:需要预训练模型,且因为是随机初始化,训练收敛较慢

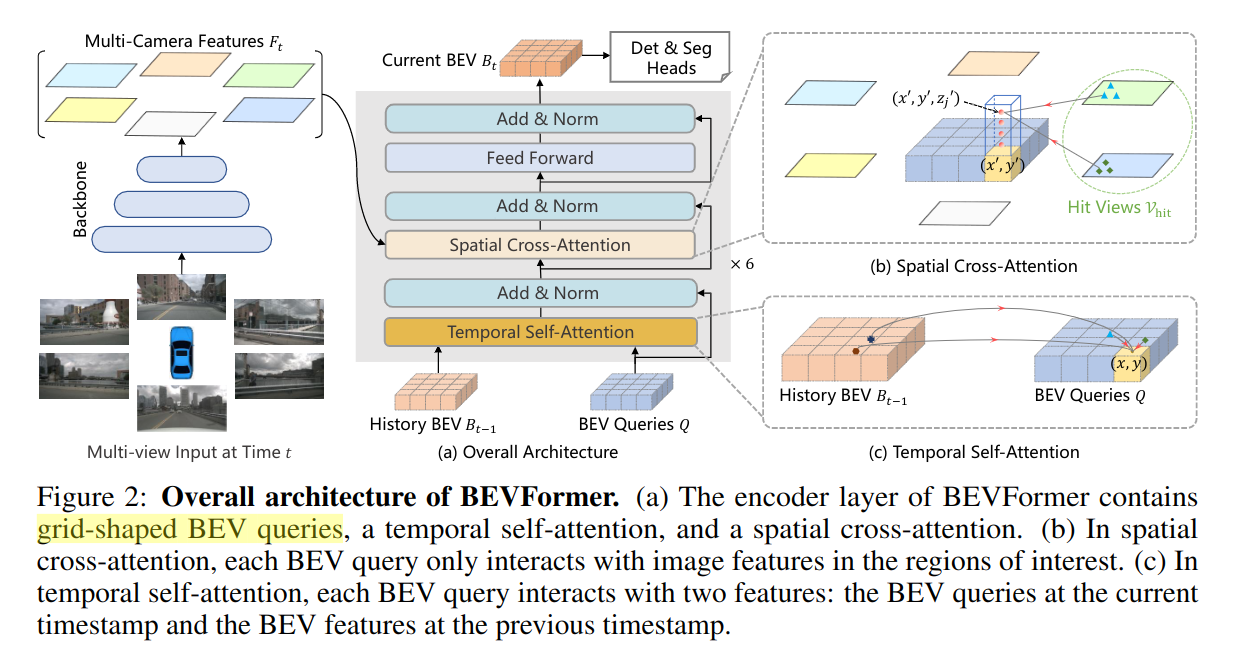

BEV Former

https://arxiv.org/abs/2203.17270

主要思想:将BEV下的每个grid作为query,在高度上采样N个点,投影到图像中sample到对应像素的特征,且利用了空间和时间的信息。并且最终得到的是BEV featrue,在此featrue上做Det和Seg。

**Spatial Cross-Attention:**将BEV下的每个grid作为query,在高度上采样N个点,投影到图像中获取特征。

Temporal Self-Attention: 通过self-attention代替运动补偿,align上一帧的feature到当前帧的Q

旷视,PETR

2 多模态

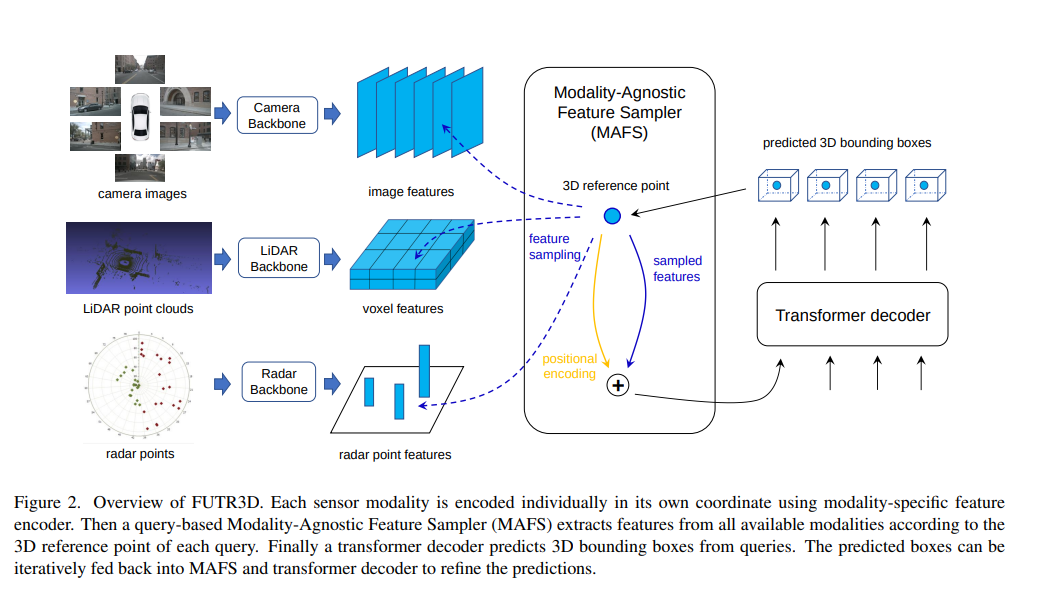

清华,FUTR3D

https://arxiv.org/pdf/2203.10642.pdf

在DETR的基础上,将3D reference point投影到Lidar voxel特征和radar point 特征上。

香港科技大学,Transfusion

https://arxiv.org/pdf/2203.11496.pdf

利用CenterPoint在heatmap上获取Top K个点作为Query(这K个点可以看做是通过lidar网络初始化了每个目标的位置,这比DETR用随机点作为Qurey收敛要快),先经过Lidar Transformer得到proposal,把这个proposal作为Query,再和image feature做cross attention。

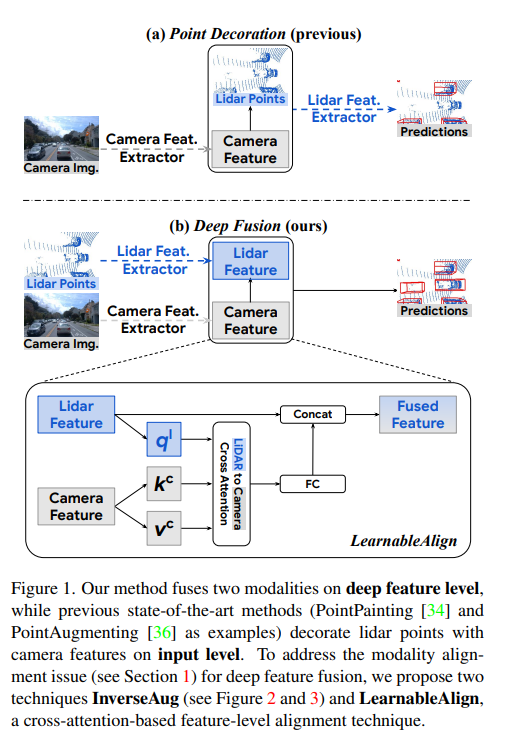

Google,DeepFusion

https://arxiv.org/abs/2203.08195

直接将Lidar feature和Camera feature做cross attention,这个思路牛逼,我不看到这篇论文是绝对想不到还能这么搞的。

最后

以上就是安详天空最近收集整理的关于Transformer BEV perception一、 Transformer原理二、 Transformer BEV Perception的全部内容,更多相关Transformer内容请搜索靠谱客的其他文章。

发表评论 取消回复