我是靠谱客的博主 愤怒蜡烛,这篇文章主要介绍CVPR2022 |BEV感知(自动驾驶感知新范式)| Cross-view Transformers for real-time Map-view Semantic Segmentation,现在分享给大家,希望可以做个参考。

Cross-view transformer BEV 内容导航

- 文章信息

- 内容摘要

- 论文方法简介

- 实验数据

- 论文总结和展望

文章信息

- 文章链接: https://arxiv.org/abs/2205.02833

- 代码:https://github.com/bradyz/cross_view_transformers

内容摘要

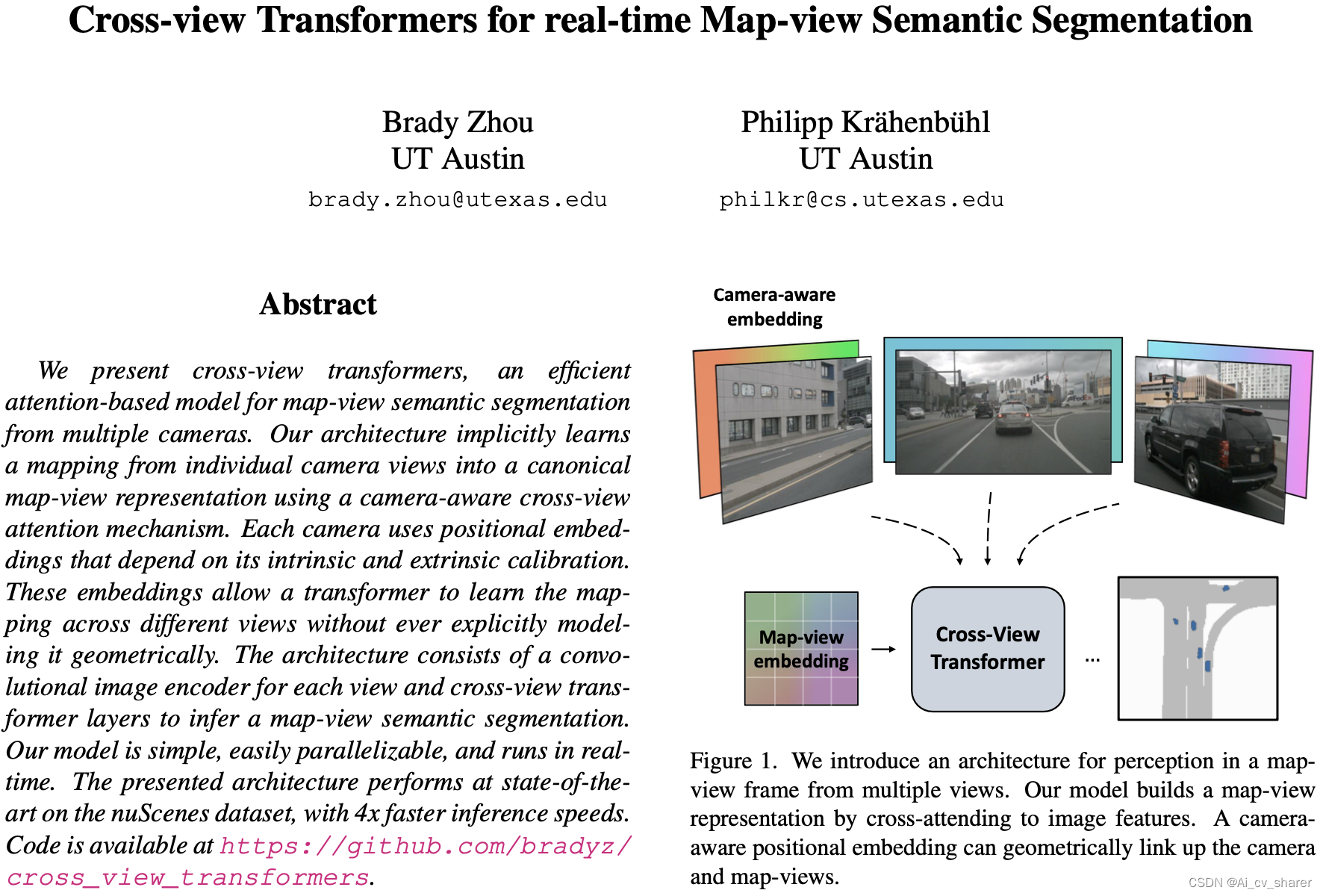

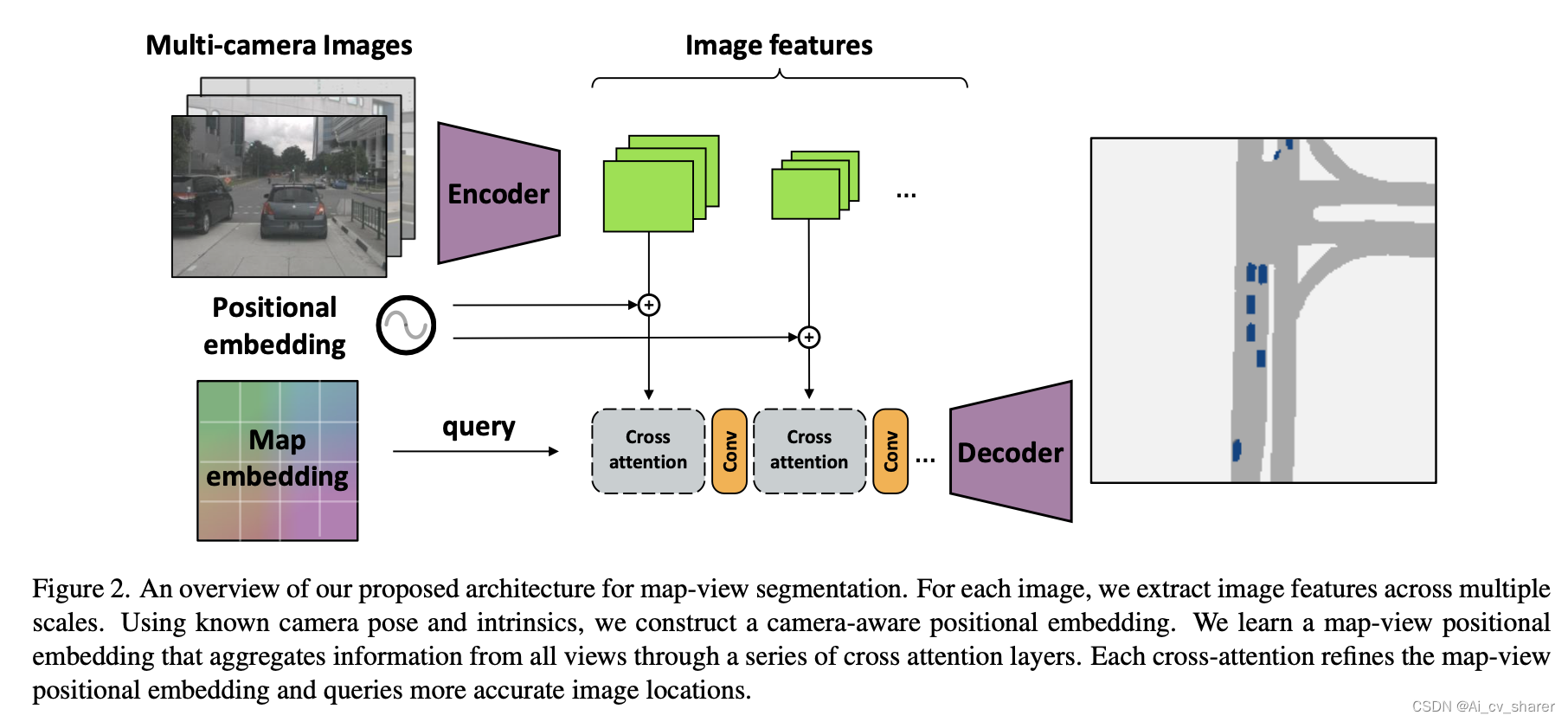

不同于之前的 VPN,lift-splat 方法,本文提出了一种新的基于transformer 架构的环视 BEV 分割方法,设计了 camera-aware 位置编码来关联 BEV 平面和环视 camera 的 feature。

论文方法简介

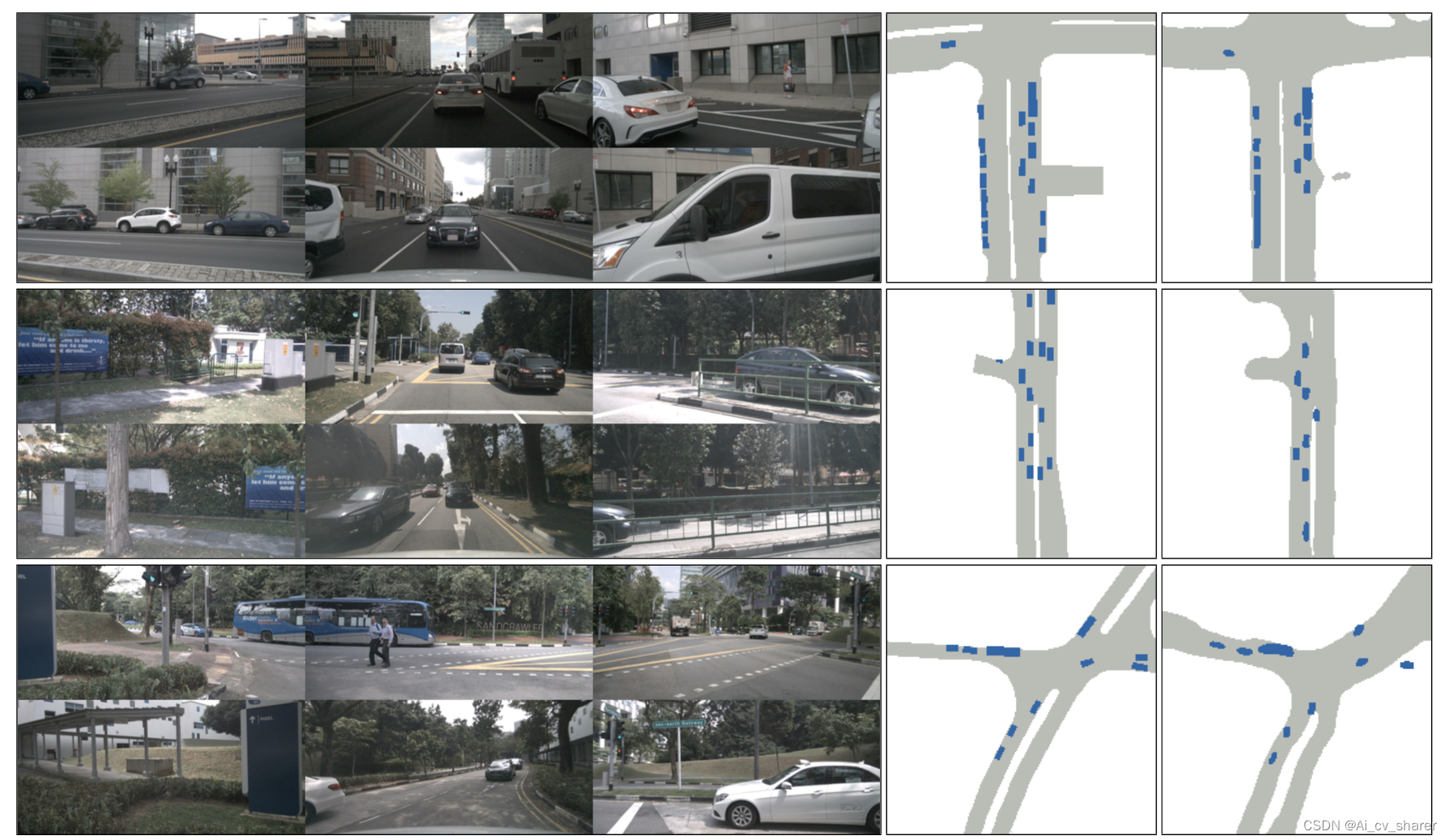

实验数据

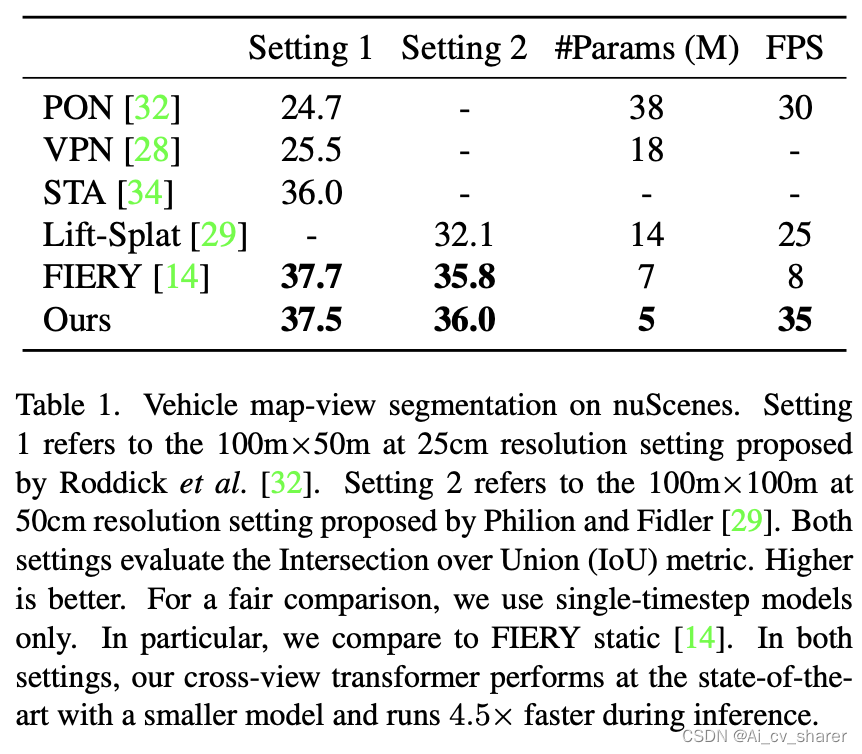

论文中的方法相对 Lift-Splat,FIERY 优势,算法架构更加简洁,模型推理速度更快。

论文总结和展望

目前 BEV 感知在自动驾驶领域吸引越来越多的注意力,不同于 lift-splat 显式预测深度融合BEV的方法,目前 transformer-based隐式融合路线涌现大量的 BEV 感知方法, BevFormer,BevSegFormer 等方法,本文提供了一种新思路,推理速度也快,是一种不错的方法。后期越来越多的工作会聚焦在如何做featrue 融合,Bev query 和环视referece feature 关联上面,以及和 Lidar Bev 融合上面。

最后

以上就是愤怒蜡烛最近收集整理的关于CVPR2022 |BEV感知(自动驾驶感知新范式)| Cross-view Transformers for real-time Map-view Semantic Segmentation的全部内容,更多相关CVPR2022内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复