(一)文章素材参考

数据参考|汽车ECU开发 微信公众号

(二)正文

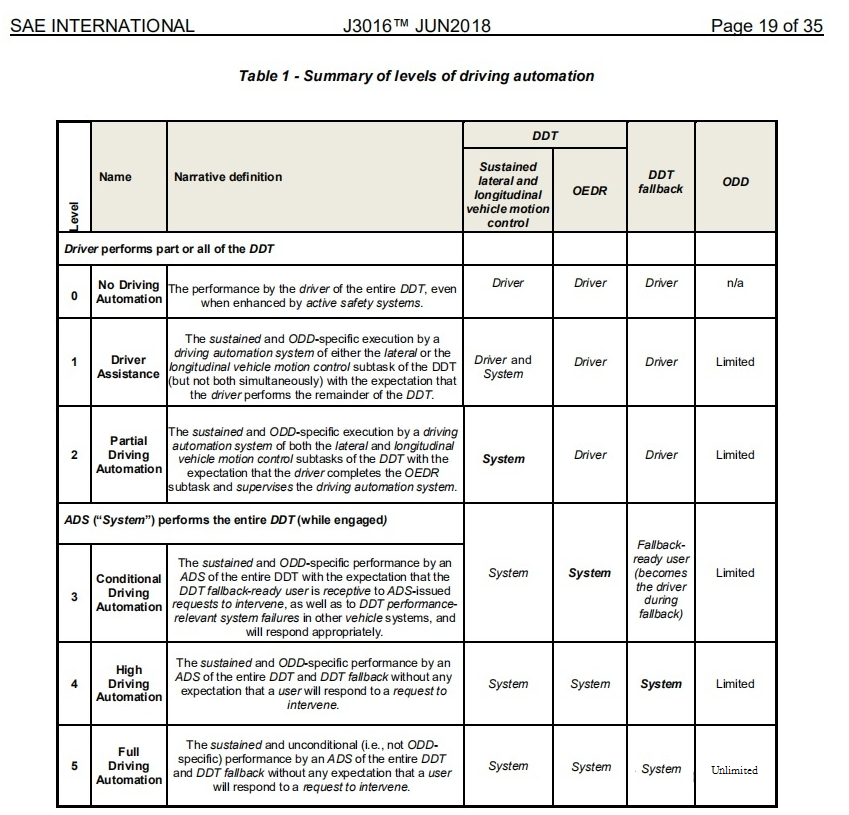

1、自动驾驶分级

目前公认的自动驾驶分级标准由SAE(SAE International,Society of Automotive Engineers国际自动机工程师学会,原译为美国汽车工程师学会)制定。

按照SAE的分级,自动驾驶技术分为L0-L5共六个等级。L0代表没有自动驾驶加入的传统人类驾驶,而L1-L5则随自动驾驶的技术配置进行了分级。

Level 0(无自动化):由人类驾驶者全权操作汽车,在行驶过程中可以得到警告和保护系统的辅助。

Level 1(驾驶支援):通过驾驶环境对方向盘和加减速中的一项操作提供驾驶支援,对其他的驾驶动作都由人类驾驶员进行操作。

Level 2(部分自动化):通过驾驶环境对方向盘和加减速中的多项操作提供驾驶支援,其他的驾驶动作都由人类驾驶员进行操作。

Level 3(有条件自动化):由无人驾驶系统完成所有的驾驶操作。根据系统请求,人类驾驶者提供适当的应答。

Level 4(高度自动化):由无人驾驶系统完成所有的驾驶操作。根据系统请求,人类驾驶者不一定需要对所有的系统请求作出应答,限定道路和环境条件等。

Level 5(完全自动化):由无人驾驶系统完成所有的驾驶操作。人类驾驶者在可能的情况下接管。在所有的道路和环境条件下驾驶。

2、自动驾驶水平现状

目前市面上的自动驾驶水平都是停留在Level 2,尚无厂家敢宣称自己真正达到了Level 3 及以上的水平。更多的是在打擦边球: L2.5,L2.9、L2.9x…

为什么现在都还达不到Level 3呢?笔者认为有3大原因:

1)责任风险

如果一个人自己把车开到了河里,那么责任在驾驶员本身;

如果是车辆自己开到河里,车乘人员把责任推到车辆的生产方,对车辆生产商来说是一个极大的问题,甚者危及企业存活。

2)技术风险

之所以存在责任风险,从侧面来看,很大程度上还是自动驾驶技术不够成熟导致。如果技术足够成熟,那么可以极大降低由车机本身造成的事故。

3)法律层面

目前还没相关的法律针对自动驾驶有比较详细的规定和约束,包括道路约束以及我们关注的出了事故后的责任鉴定标准。

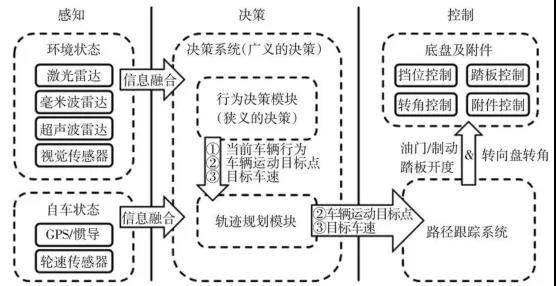

3、自动驾驶系统架构

从上图我们知道,自动驾驶系统的架构大体分为感知、决策和控制等3大模块组成。

(1)感知:感知部分是决定自动驾驶路线的关键因素,相当与人类的五官,用来获取外部的信息。

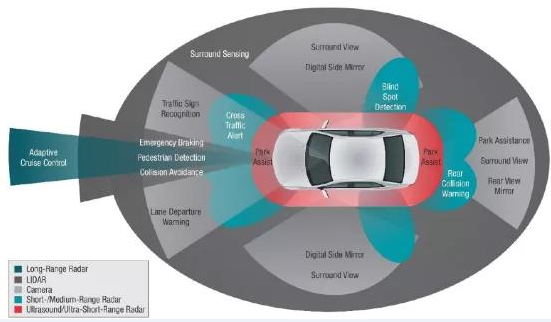

长期以来 ,自动驾驶的感知技术路线主要有2种:纯视觉、视觉+雷达。

=》视觉:最常用的是摄像头;

优点:它和人类的眼睛最接近,可以看清有颜色的标识、物体,看得懂字体,分得清红绿灯。

缺陷:在夜晚或恶劣的天气下视力就严重下降,也不擅长远距离观察。

=》雷达:毫米波雷达、激光雷达,以及传统的超声波雷达;

-

毫米波雷达:可以全天候工作,这使得它不可或缺,即便它无法识别高度,分辨率不高,也难以成像。但它凭借其穿透尘雾、雨雪的硬本领,站稳一席之地。

-

激光雷达:比较常见的是在车顶,像是顶不停旋转的帽子。原理很简单,就是通过计算激光束的反射时间和波长,可以完成绘制周边障碍物的3D图。而短板则是无法识别图像和颜色。

-

超声波雷达:仅适用于近距离的感知(米级),可以用于泊车场景中,最常见的用途就是倒车,所以又被称之为倒车雷达。

对于上述几种感知设备的优劣势比对我们在智能网联交通系统的关键技术与发展已经总结过,这里不再阐述。

(2)决策:决策部分可以类比人类的大脑,基于感知层的信息进行判断,决定对车辆进行何种操作。

(3)控制:控制部分可以类比人类的四肢,收到大脑的决策指令后,对车辆进行控制操作,比如转动方向盘或刹车等。

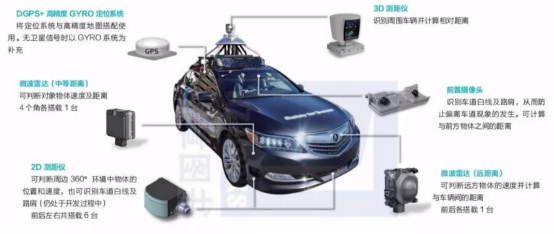

下图是一个自动驾驶的感知系统方案,集合了所有上述几种感知设备,可以说是武装到了牙齿:

4、纯视觉靠谱吗?

从第三节我们知道,视觉系统已经成为了自动驾驶的重要组成部分。

目前市面上以纯视觉作为自动驾驶技术主线的主机厂家典型代表为特斯拉。然而,纯靠视觉靠谱吗?

4.1 人眼参数

前面章节说到,纯靠视觉类似于我们人类使用眼睛去辨别事物。那么,我们先来看看人眼的“技术参数”:

(1)人眼能够分辨率的最小细节折合0.59角分;

(2)人眼拥有大概650万个视锥细胞;

(3)人眼拥有大概1.2亿个视杆细胞;

(4)人眼的视野大概为向外95° 向内60° 向上60° 向下75°;

(5)人眼只能够清晰的分辨出中央10°范围的物体;

(6)人眼的分辨率越往外越低;

(7)人眼看到低于24帧的物体时会有明显的卡顿感;

(8)人眼最高大约可以分辨到75帧的高速度物体。

简单概括为:我们的眼睛,只有盯住哪里,哪里看起来才是清楚的,我们不盯着看的地方基本都是模糊看不清楚的。人的单眼静态分辨率的确不太高,单次成像只有500万像素左右。我们觉得自己可以看清楚很大范围内的物体,其实是人眼可以快速采样多张图片并通过大脑将多次采样的数据合成出完整为清晰的图像。最终的效果可以达到10亿像素相机的效果。这是任何专业单反相机都无法达到的。

人眼相比相机的优势(作为驾驶员在感知端的优势):

(1)焦距调节速度非常快,从最远到最近距离的对焦可以瞬间完成;

(2)在一定范围内对光线的变化反应迅速,保证始终可以看清物体;

(3)方向可以随意条件(脖子转一下或者眼睛自己转一下就行)

大脑会把所有输入的图像进行快速处理,并自动找出哪些才是在驾驶活动中需要重点关注的。比如识别障碍物、其它车辆与行人的趋势等等。这些所有数据有机的结合起来,才能够最终保障驾驶安全。

下图是人脑一个正常的处理效果:

4.2 摄像头参数

目前车上用来进行自动驾驶数据采集的前向摄像头最高的像素也已经可以达到几百万的级别了。

理论上,仅靠视觉是可以覆盖大部分驾驶场景的,而且机器不会像人一样感到疲劳或分神,但是目前的纯视觉自动驾驶方案的局限性还是比较明显的。

目前局限性包括:

- 摄像头无法像如人眼一样随时变换焦距和景深来看清楚整个视野中的每个细节;

- 对雨雪风霜雾等自然环境的适应性问题,导致摄像头方案在图像数据采集端就有天然的限制;

- 视觉系统的另外一个局限性在于对距离的精准判断,即使采用双目或者三目摄像头也是面临着同样的问题。没有精确的距离感,在规划车辆的运动轨迹的时候就很难做好。

- 目前的人工智能算法还远远没有达到接近人类视觉系统的处理能力,造成了至少目前阶段纯视觉方案的可靠性与适用性还是不能完全满足各种场景的需求。

也是正因为纯视觉方案的各种局限性,目前大多数厂家采用的方案都是多种传感器结合的方式。因此我们现在在路面上看到的自动驾驶测试车辆基本都是长下面这个样子:

不过,无论是纯视觉还是多种感知设备结合的方案,目前都还没达到Level 3的水准,可靠性和安全性都还需要提升。因此,说不上哪一种方案更优于另外一种方案,一切都有待技术和时间来考究。

最后

以上就是贪玩刺猬最近收集整理的关于自动驾驶的纯视觉路线是否靠谱?的全部内容,更多相关自动驾驶内容请搜索靠谱客的其他文章。

发表评论 取消回复