边缘智能:研究进展及挑战

作者:乔德文,郭松涛,何 静,朱永东

首发:《无线电通信技术》

摘 要:近年来, 物联网的普及让数以亿计的移动设备连接到互联网上,在网络边缘产生了海量的数据,使得一种全新的计算范式———边缘计算兴起。同时,得益于深度学习算法和摩尔定律的突破,使得人工智能的发展再一次迎来了高潮。在这一趋势下,将边缘计算与人工智能相结合是必然的,由此产生的新的交叉研究———边缘智能引起了许多学者的广泛关注。

在该综述中,边缘智能被分为基于边缘计算的人工智能和基于人工智能的边缘计算( 即 AI on edge 和 AI for edge)两部分。AI on edge 侧重于研究如何在边缘计算平台上进行人工智能模型的构建,主要包括模型训练和模型推理两部分;AI for edge侧重于借助先进的人工智能技术,为边缘计算中的关键问题提供更优的解决方案,主要包括任务卸载和边缘缓存两部分。该综述从一个广阔的视角对边缘智能的研究进行了归纳总结,为涉足该领域的相关学者提供了一个详细的背景知识。

关键词:物联网;边缘计算;深度学习;人工智能;边缘智能

0.

引言

随着5G技术的发展和物联网(Internet of Things,IoT)的普及,网络边缘的数据由地理上分布广泛的移动终端和IoT设备所创建,这些在网络边缘生成的数据比大型云数据中心生成的数据还要多。另外,根据IDC的预测,到2025年[2],全球物联网产生数据的70%都要在网络边缘处理。同时,人们在日常生活中使用这些智能终端设备时对其服务质量的需求有了进一步的提高[3]。因此,在这种情形下,用传统的云集中式处理模式将无法高效率地处理这些网络边缘数据,也不能满足用户对智能终端高服务质量的需求。具体来说,传统云计算在处理这些网络边缘数据时存在三点不足:①实时性不够;②带宽不足;③能耗较大。因此,为了解决以上问题,更适用的方式是直接在边缘网络侧处理用户需求,这催生了一种全新的计算范式——边缘计算(Edge Computing,EC)[4]。

EC将云服务从网络核心推向更接近物联网设备和数据源的网络边缘,它是一种在终端设备中分析和处理数据的技术。通过这种技术,数据可以在网络边缘进行实时处理,以实现数据流加速的目的。从本质上讲,与传统基于云的计算模式相比,EC使得计算和数据源之间的物理距离更加接近,大大降低了数据传输的时延,缓解了网络带宽的压力,减少了数据通信的能耗,使得用户的服务质量大大提升[5-7] 。

近些年来,得益于摩尔定律的突破,使得人工智能(Artificial Intelligence,AI)的发展再一次迎来了高潮。日常生活中,熟知的 AlphaGo[8] 、无人驾驶汽车[9] 、智慧医疗[10] 等, 都是AI发展的延伸。可以说,我们目前生活在一个 AI蓬勃发展的时代。另外,在算法、算力、大数据等最新进展的推动下,深度学习(Deep Learning,DL)[11] 作为AI领域最耀眼的领域,在计算机视觉、语音识别、自然语言处理等多个领域取得了实质性突破。得益于这些突破,以智能个人助理、个性化购物推荐、智能家电等为代表的一系列智能应用迅速进入了人们的视野,得到了巨大的青睐。现代社会普遍认为这些智能应用极大地丰富了人们的生活方式,提高了社会生产效率。由于AI算法的实现需要大量的计算,当前AI大部分的计算任务都是依靠部署在云及其他大规模计算资源密集的平台上实现的,但考虑到大规模计算资源密集平台与智能终端的物理距离以及网络边缘海量数据的现实,就极大地限制了AI带来的便利。因此,催生了人们将EC与AI进行结合的想法,这也就产生了边缘智能(Edge Intelligence,EI)。

EI并不是将EC和AI进行简单的结合,EI涉及到的主题十分广泛,目前学术界还没有给出一个统一的定义。但是,很多涉足EI的学者都给出了自己对EI的理解,例如,Zhou 等人认为EI的范围不应该仅仅局限于边-端上运行AI算法,而也应该包括在边-云上运行AI算法[12] ;Zhang 等人将EI定义为使边缘设备能够执行AI算法的能力[13] ;李肯立等人将EI 定义为融合网络、计算、存储、应用核心能力的开放平台[14]。

处于初级阶段的EI吸引了学者的广泛关注。他们对EI的进展做了较为全面的研究总结,例如,Zhou 等人从 AI模型的训练、推理以及边-云和端- 边-云协作等方面对 EI进行了较为全面的阐述[12];Chen 等人对网络边缘DL应用的场景以及在网络边缘部署分布式DL算法的常见方法进行了研究[15];Wang 等人从AI 、EC各自的应用场景以及二者相结合的应用场景角度更加全面地介绍了EI[16];也有一些文献从AI驱动的雾计算的角度对 EI进行了研究[17-18]。例如,Peng和 Zhang全面总结了雾-无线电接入网的性能分析和无线电资源分配的最新进展。然而,EI的主题涉及范围广泛,无论是起源还是性质,这些文献都没有完全涵盖。还有许多问题没有得到解决,正因为如此,本文对EI进行分类阐述,以一种简单明了的方式将EI的重点内容呈现出来。具体来说,本文将EI分为基于EC的 AI(AI on edge)和基于AI 的EC(AI for edge)。AI on edge可以理解为在边缘环境中部署AI算法;AI for edge可以理解为利用AI算法解决EC中的优化问题,现有关于EI的研究都可以大致分为这两大类。

1.

EC和AI的关系

AI和EC的结合是必然,它们之间存在着一种互动关系。AI为EC提供解决问题的技术和方案,而EC为AI提供释放潜力的平台。

1.1 AI为EC提供技术和方法

EC是一种分布式计算范式,通过构建软件定义的网络来分散数据,提供具有鲁棒性和弹性的服务。EC在不同的层次上面临资源分配问题,如CPU周期频率、访问权限、射频、带宽等。因此,对各种功能强大的优化算法提出了很高的要求,以提高系统的效率。从本质上讲,EC将真实场景中的优化问题进行建模,然后用梯度下降方法迭代地寻找渐近最优 解。无论是统计学习方法还是DL方法都可以为边缘提供帮助。此外,包括多智能体学习、深度Q-网络(Deep Q-Network,DQN)在内的强化学习在边缘资源分配问题中发挥着越来越重要的作用。

1.2 EC为AI提供场景和平台

IOT设备的激增使万物互联成为现实。除了云数据中心外,更多的数据是由边缘网络设备创建的。更多的应用场景,如自动驾驶、智能家居、智慧城市等,都可以极大地促进AI从理论到实践的实现。此外,通信质量高、计算能力要求低的AI 应用可以从云迁移到边缘,可以说,EC为AI提供了一个功能丰富的平台,得以让AI尽情地释放其内在潜力。

2.

AI on edge

在这一部分,本文将 AI on edge的研究工作分为模型训练和模型推理两部分。其中模型训练部分重点介绍目前流行的联邦学习(Federated Learning,FL)在边缘环境中的一些研究工作;在模型推理部分,本文主要介绍模型的优化、分割以及共享三方面的工作。最后,本文对上述两部分的工作做相应的总结分析。

2.1 模型训练

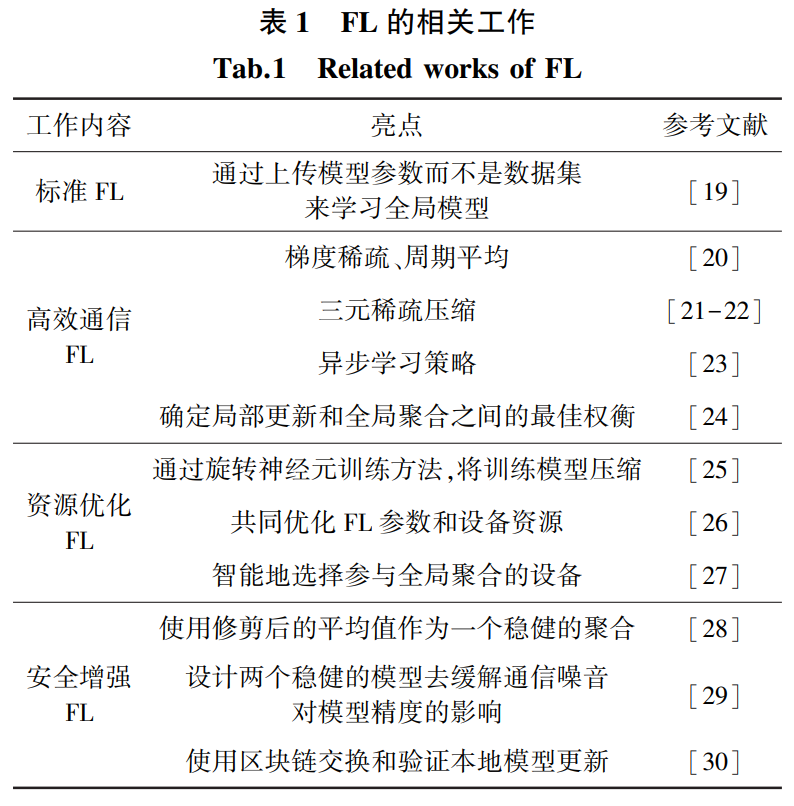

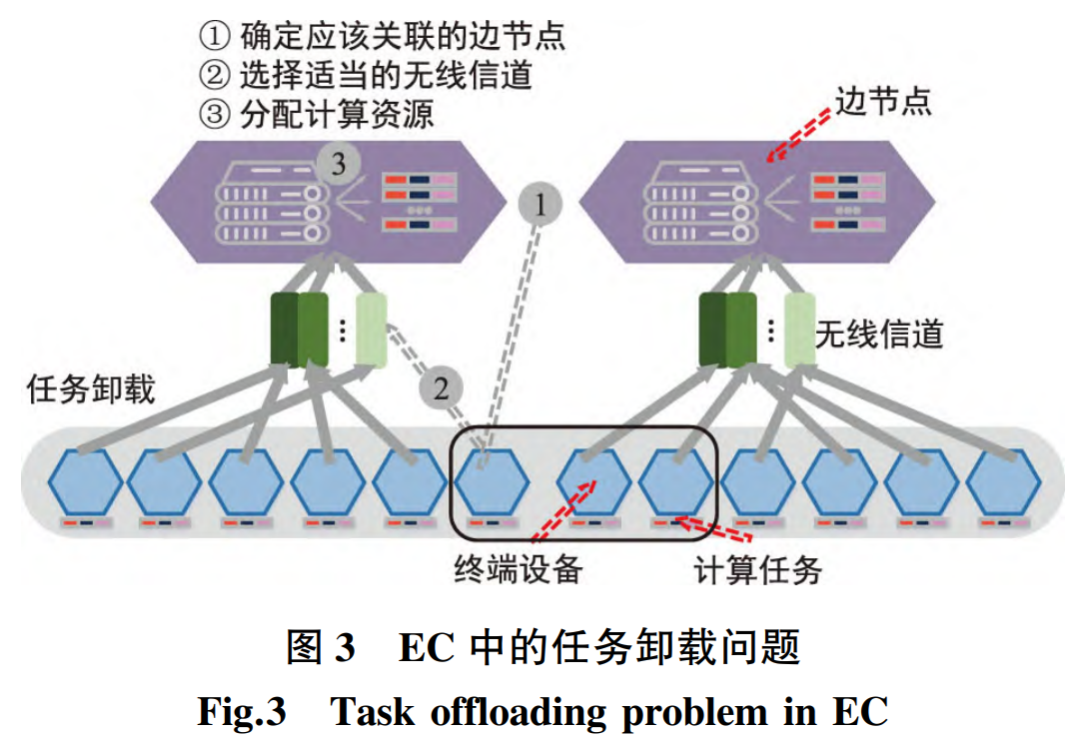

在边缘环境中,本文将在边缘侧进行的AI模型训练称之为“AI on edge ”。这种训练需要大量资源来进行数据参数的交换更新,但往往存在着数据隐私暴露的风险。幸运的是,FL作为一种新兴的分布式学习架构,能够很好地解决AI on edge存在的一些问题。对于EC中能力多样、网络条件有限的设备,FL可以在处理Non⁃IID训练数据时保护隐私,在高效通信、资源优化和安全等方面具有良好的扩展性。表1中列出了一些关于FL的工作。

丨2.1.1 标准FL

FL[19]作为端-边-云之间的一种实用的深度学习训练机制而出现。在 FL的框架下,移动设备被视为执行本地训练的客户端。同时,云中的终端设备、边缘节点和服务器在一定条件下也可以等价地视为FL 中的客户端。下面讨论基于边缘计算的联邦学习基本原理。FL不需要上传数据到中心云进行训练,边缘设备只需要使用本地数据训练本地DL模型,然后上传更新后的DL模型参数。在标准FL中有两个角色:具有本地数据的客户端和负责模型聚合的聚合服务器。整个FL的过程如下:① 请求一组客户端从服务器下载初始化全局DL模型参数;② 用本地数据在下载的全局模型参数上训练本地模型;③ 将更新后的本地模型参数上传到服务 器,接着对本地模型参数进行加权聚合得到全局模 型参数。如图 1所示,根据FL中的两个角色和EC三个层次之间的关系,有3种可行的训练FL的解决 方案:① 端-边合作:边缘节点代替云作为服务器, 端侧作为客户端;② 边-云合作:边侧作为客户端参与 FL,而云作为聚合服务器;③ 端-边-云合作:端边两侧作为客户端参与FL,而云作为聚合服务器,这种方式可以结合上述两种方式的优点。

丨2.1.2 高效通信FL

在FL训练过程中,不用将原始数据上传到服务器,可以说在很大程度上降低了通信代价。但如果本地训练的DL模型足够大,从边缘设备向中心 服务器上传模型参数也会消耗大量的通信资源。为了解决这一问题,有学者提出让FL边缘设备定期地(不是持续地)与中央服务器通信,以寻求关于全局DL模型的共识[20]。此外,FL框架下,DL模型参数的压缩和学习策略的创新也能实现FL高效通信的目的。例如,在文献[21-22]中,提出了一种稀疏三元压缩方法,实现客户端和服务器之间参数传输的上下游通信压缩,达到降低通信代价的目的;文献[23]提出了一种异步学习策略,该学习策略将不同层次的深度神经网络分为浅层和深层,深层的参数更新频率低于浅层。此外,在服务器上引入时间加权聚合策略,利用之前训练的局部模型,从而提高中心模型的准确性和收敛性。

另外,与云相比,边缘设备的计算资源非常稀缺。提高通信效率还需要考虑其他挑战:① 计算资源在边缘设备上是异构的和有限的;② 边缘设备上 的训练数据可能是Non-IID的。基于此,文献[24]推导出的Non-IID分布式学习的收敛界,可以保证在理论上优化所有参与设备在给定资源预算下的聚集频率。

丨2.1.3 资源优化FL

当FL将相同的神经网络模型部署到异构的边缘设备时,计算能力较弱的设备可能会极大地延迟全局模型的聚合。虽然将掉队者从协作中剔除可以 在一定程度上缓解延迟问题,但掉队者可能会保留从非相同数据集学习到的独特和关键信息,直接剔除会损害整体协作性能。因此,文献[25]中提出了异构感知FL框架Helios 来解决设备能力异构的问题。Helios识别单个设备的异构训练能力,因此预期的神经网络模型训练量与协作训练速度有关。针对掉队设备,提出了一种软训练方法,通过旋转神经元训练方法将原始相同训练模型动态压缩到期望体积。通过广泛的算法分析和优化方案,可以在保持局部训练和联邦协作收敛的同时,充分利用掉队者的信息。实验表明,在不同的协作设置下,Helios可以提供高达2.5倍的训练加速度并提高4.64%的收敛精度。

同时,在移动EC场景中部署FL 时,FL的执行时间主要取决于客户端数量及其计算能力。因此,为了最小化FL的训练时间,对FL 进行适当的资源分配不仅需要考虑FL参数(如计算通信的精度水平),还需要考虑客户端的资源分配(如功率和CPU周期)。但是,客户端能耗的最小化和 FL执行时间 存在冲突。例如,客户端可以通过始终保持低频率的CPU 来节省能源,但这肯定会增加训练时间。因此,为了在能量消耗和训练时间之间取得平衡,文献[26]首先为每个客户端设计了一种新的算法———FEDL,对其局部问题进行近似求解,直到达到局部精度水平。然后,利用帕累托效率模型,提出了无线网络中FEDL的非凸资源分配问题,以获取客户端能量成本和FL执行时间之间的权衡。最后,利用该问题的特殊结构,将其分解为3个子问题,并据此推导出闭解,表征了帕累托效率控制旋钮对最优解的影响。

此外,FL中涉及的设备数量通常很大,从数亿到数百万不等。当设备数量巨大时,在每轮客户端和服务器进行通信时,将这些设备的本地模型参数全部上传到服务器进行加权聚合是不现实的。为了解决设备数量带来的通信压力问题,文献[27]提出了一个经验驱动的控制框架,该框架利用强化学习智能地选择客户端设备参与每一轮的全局聚合,在减少通信轮数的情况下达到同等模型精度的实现。

丨2.1.4 安全增强FL

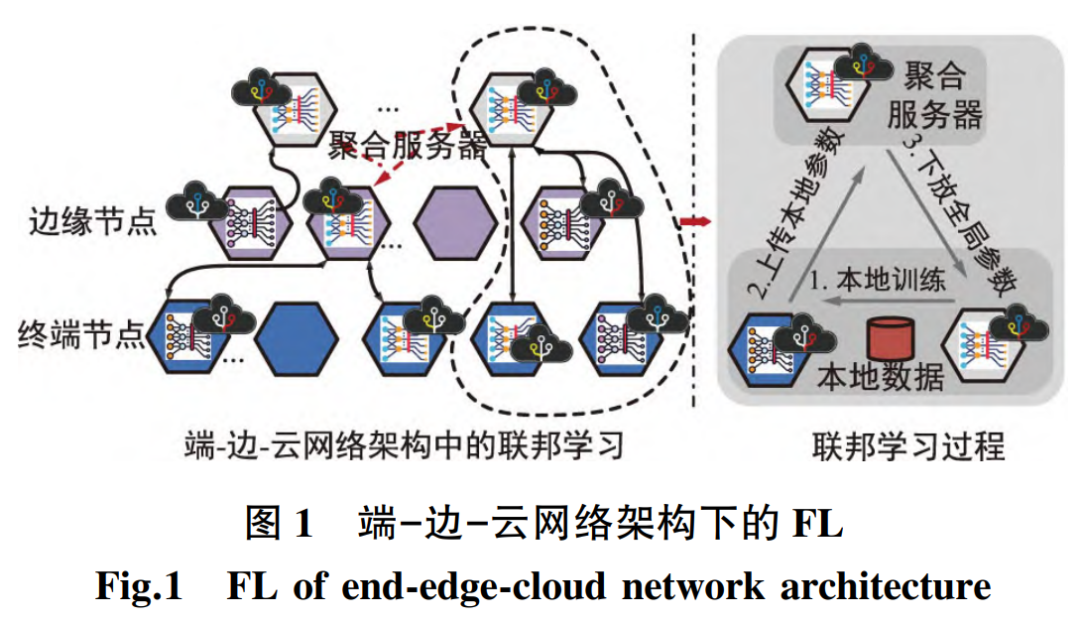

在分布式训练场景中,客户端的信息交流是涉及到分布式机器学习中的隐私核心问题。FL避免了上传训练数据可能导致的隐私泄露,但同时也引 入了模型更新的隐私问题。可以引入差分隐私(Differential Privacy ,DP) 的技术,在敏感数据中添加噪声来严格量化表达式控制信息的公开,有助于降低FL训练更新中隐私泄露的威胁,常见的几种FL 的模型如图2所示。

为了解决FL训练时的隐私问题,客户端首先利用自己的数据计算模型参数更新,然后进行差分隐私处理,最后上传处理后的模型参数并进行模型 聚合。从另一个角度来看,聚合服务器对训练设备也不应该完全信任,因为对手可能会毒害他们的训练数据或直接篡改模型更新,从而导致对全局模型的破坏。为了使FL能够容忍拥有中毒数据集的少量设备参与训练,鲁棒联邦优化[28]定义了一个修剪的平均操作。通过过滤有毒设备产生的值和正常设备中的自然离群值,实现了鲁棒聚合,保护全局模型不受中毒数据的影响。

除故意攻击外,还应关注不可预测的网络条件和计算能力给安全带来的被动不利影响。无线通信噪声不可避免地阻碍了训练设备与聚合服务器之间的信息交换,这可能对训练延迟和模型可靠性产生重大影响。在文献[29]中,提出了基于期望模型和最坏情况模型下的并行优化问题,并分别采用正则化的损失函数逼近算法和基于抽样的逐次凸逼近算法求解这两个模型。理论分析表明,该方法具有可接受的收敛速度;仿真结果表明,该方法提高了模型精度,降低了损耗函数。

反过来,FL中聚合服务器的故障也可能导致不准确的全局模型更新,从而污染所有本地模型参数的更新过程。此外,数据样本数量较多的边缘设备可能不太愿意与贡献较少的其他设备一起参与FL。因此,在文献[30]中,提出了将区块链和FL结合为Block FL,以实现:① 在每个边缘设备而不是特定服务器上进行局部全局模型更新,确保在更新全局模型时,设备故障不会影响其他局部更新;② 刺激边缘装置参与FL的适当奖励机制。

2.2 模型推理

随着对精度要求的提高,深度神经网络(DNN)的层数也越来越深,如此就需要更大规模的数据集,这样会造成昂贵的计算费用。因此,之前的 AI模型都是部署在高性能的云计算平台上,而终端设备只是将输入数据发送到云端,然后等待AI推理结果。然而,仅云推理限制了AI服务的部署。此外,对于重要的数据源,应解决数据安全和隐私保护问题。为了解决这些问题,AI服务往往诉诸EC。因此,AI模型需要进一步定制,以适应资源受限的边缘,同时仔细处理其推理精度和执行延迟之间的权衡。本小节从模型优化、模型分割以及模型共享三方面对模型推理做了详细的阐述。

丨2.2.1 模型优化AI

任务通常是计算密集型的,需要很大的内存占用。但在边缘,没有足够的资源来支持原始的大规模AI模型。优化AI 模型并量化其权重可以降低资源成本。下面讨论3种常用的模型优化方法。

(1) 参数剪枝与共享

大量的参数是制约AI模型训练效率的重要因素。因此,为了实现更高效、快速的AI模型训练,一些研究者对AI模型进行了参数剪枝和共享的优化。文献[31]中提出了缓存相邻层之间的中间数据,以减少数据移动。此外,像二值化一样的量化也是一个很好的分支。在XNOR-Net [32]中,不仅滤波器近似于二进制值,卷积层的输入也是二进制的。卷积主要是用二元运算来近似的。这些措施提供了58倍的加速,同时在某些数据集(如CIFAR-10)上实现了类似的精度。

(2) 传输/紧凑卷积滤波器

为了实现AI模型的优化,可以设计一种特殊结构的卷积滤波器来节省参数。但该方法只适用于卷积层。在文献[33]中,提出的SqueezeNet 比AlexNet 的参数减少了50倍,且在ImageNet上实现了相同的精度水平。减少参数的方法是用1×1滤波器代替3 × 3滤波器,并减少输入通道的数量。同时,在网络后期进行降采样是为了使精度最大化。

(3) 知识蒸馏

文献[34]中首次提出了知识蒸馏的概念,它是一种将知识从复杂的AI模型转移到紧凑的AI模型的方法。一般来说,复杂的AI模型是强大的,而紧 凑的AI模型更灵活和高效。知识蒸馏可以利用一个复杂的AI模型来训练一个紧凑的AI模型,使其具有与复杂 AI模型相似的性能。这些方法可以应用于不同类型DNN或组合来优化复杂的边缘AI模型。

丨2.2.2 模型分割

以往,大多数智能应用程序只在云中执行,而边缘设备只扮演收集和上传数据的角色。如今,随着技术的进步,边缘设备有了更好的硬件配置,研究人员开始思考是否通过深度学习模型的分割将部分或全部计算任务推到边缘。这样可以将大量的计算任务分解成不同的部分,不同的设备可以协同解决问题。

在文献[35]中,对最先进的AI模型在云和边 缘设备上的延迟和功耗进行了评估,发现将数据上 传到云是当前AI服务方法的瓶颈(导致传输开销很大)。划分AI模型并进行分布式计算,可以获得更好的端到端延迟性能和能源效率。此外,通过将部分DL任务从云推送到边缘,可以提高云的吞吐量。

最常用的一种分割方法是将AI模型水平分割,即沿端-边-云进行分割。数据分析的过程通常分为两部分[36],一部分在边缘处理,另一部分在云中处理。由于上传数据减少了中间数据,这样既减少了边缘与云之间的网络流量,又避免了数据传输中安全隐私泄露的风险.

另一种模型分割方法是垂直分割,特别是CNN。相对于水平分区,垂直分区将层进行融合,以网格的方式进行垂直分区,将CNN各层划分为独立的可分布计算任务。Deep Things[37]利用了一种名为“融合TilesPartitioning(FTP)”的新方法,融合层以网格方式垂直划分。实验结果表明,在不降低精度的情况下,FTP至少可以将内存占用减少到32%。同样,J.Zhang的团队在文献[38]中为本地分布式移动计算设计了一个框架,提出了一种通用的神经网络层分割工具,测试了一些常见的神经网络,其中Google Net 的实验得到了最好的性能,该系统几乎 将总延迟减少了一半。

丨2.2.3 模型共享

AI的计算往往是复杂的,密集的计算是对设备资源的巨大考验。然而,AI计算具有高度的逻辑性,使得不同的DL操作过程具有一定的相关性。因此,如何利用DL操作的相关性成为优化AI模型的出发点。对于AI计算的共享,一种思路是对推理结果进行缓存和重用,以避免冗余操作,该思路在一些场景中取得了良好的实践效果。

边缘节点覆盖范围内附近用户的请求可能表现出时空局域性[39]。例如,同一区域内的用户可能会 请求对同一感兴趣的对象进行识别任务,这可能会引入DL推理的冗余计算。在这种情况下,Cachier [39]在对应用进行离线分析和在线估计网络条件的基础上,提出将识别应用的相关AI模型缓存到边缘节点,并通过动态调整其缓存大小来最小化预期的端到端延迟。因此,当缓存中的AI模型能够满足请求的要求时,可以直接从缓存中获取AI模型进行使用。通过这种方式,可以通过使用缓存和重用来避免冗余操作。

此外,为了继续进行有效的缓存和结果重用,必须解决可重用结果的精确查找问题,即缓存框架必须系统地容忍变化并评估关键的相似性。Foggy Cache[40]首先将异构原始输入数据嵌入到具有通用表示的特征向量中;然后,提出了自适应局部敏感哈希(Adaptive Locality Sensitive Hashing,A-LSH),即一种常用来索引高维数据的局部敏感哈希的变体, 对这些向量进行索引,以实现快速准确的查找;最后,基于K⁃紧邻(k-Nearest Neighbor,KNN) 实现均匀化,利用缓存的值去除离群值,确保初始选择的K条记录之间存在主导聚类,从而确定A-LSH查询记录的重用输出。因此,通过对可重用结果的精确查找和计算结果的缓存,可以减少AI模型的计算量,减轻对硬件资源的压力。

与共享推理结果不同的是,文献[41]通过不同AI模型之间的共享来减少计算量。通过考虑训练样本之间的相关性,作者提出了同一目标区域内的 迁移学习算法,即如果一个目标区域内存在多个相关的AI模型,那么一个AI模型的训练也可以使其他相关的AI模型受益。该方法通过共享训练良好的AI模型,减少了未训练的AI模型在同一目标区域的AI计算量。

2.3 目前面临的挑战

尽管AI on edge的工作研究很多,但也存在一些很明显的挑战。本文分别从数据可用性、模型训练、协调机制和性能指标四方面列举了AI on edge的重大挑战。

数据质量

数据的可用性是一切模型训练的基础。首先,对于提供原始数据的用户需要提供一定的激励才能获得更加有用的真实数据,所以对提供数据的用户设计合理的激励机制是十分重要的。否 则,原始数据可能无法用于模型训练和推断。此外,来自各个终端设备的原始数据可能会有明显的偏差,这将极大地影响学习性能。尽管联合学习可以 克服Non⁃IID所带来的问题,在一定程度上,训练过程在设计鲁棒通信协议方面仍面临很大困难。因此,在数据可用性方面存在着巨大的挑战。

模型训练

目前,从模型本身到训练框架和硬件,AI 模型的训练面临着以下两方面的严峻挑战。第一,基于AI模型时效的考量,如何确定合适的模 型学习精度阈值,以利于AI模型的快速交付和部署;第二,如何在有限的资源下选择探索性训练框架和加速器架构。模型选择、资源配置和管理耦合,问题复杂而富有挑战性。

协调机制

考虑到异构设备之间的计算能力和通信资源的差异,得到的AI模型无法在所有的设备适用,这可能会导致相同的方法在不同的移动设备 集群中获得不同的学习结果。因此,考虑异构边缘 器件之间的兼容性和协调具有重要的意义。所以,在端-边-云之间设计一种协调机制是十分必要的, 这种机制将为不同的边缘设备提供一个统一的API接口。

性能指标

由于EC网络的不确定性特征(无线信道质量变化、并发业务请求不可预测等),常用的标准性能指标(如Top⁃k精度或平均精度)不能反 映边缘环境中AI模型推理的运行性能。因此,这将导致无法准确量化和比较不同AI模型的性能。除了模型精度之外,推理延迟、资源消耗和服务收入也是关键指标。由于服务类型和应用场景的不同,一个边缘AI服务往往涉及多个指标,这时就会出现一个新的问题,即多个指标之间的权衡。由于EI服务的特点,不同的指标对服务的影响也不同。然而,如何准确地平衡多个指标,使综合绩效最大化,已成为定量EI服务性能的关键。因此需要识别EI的关键性能指标,并探索这些指标之间的权衡,以帮助提高EI部署的效率。

3.

AI for edge

在这一部分,将AI for edge的研究工作分为任务卸载和边缘缓存两部分。

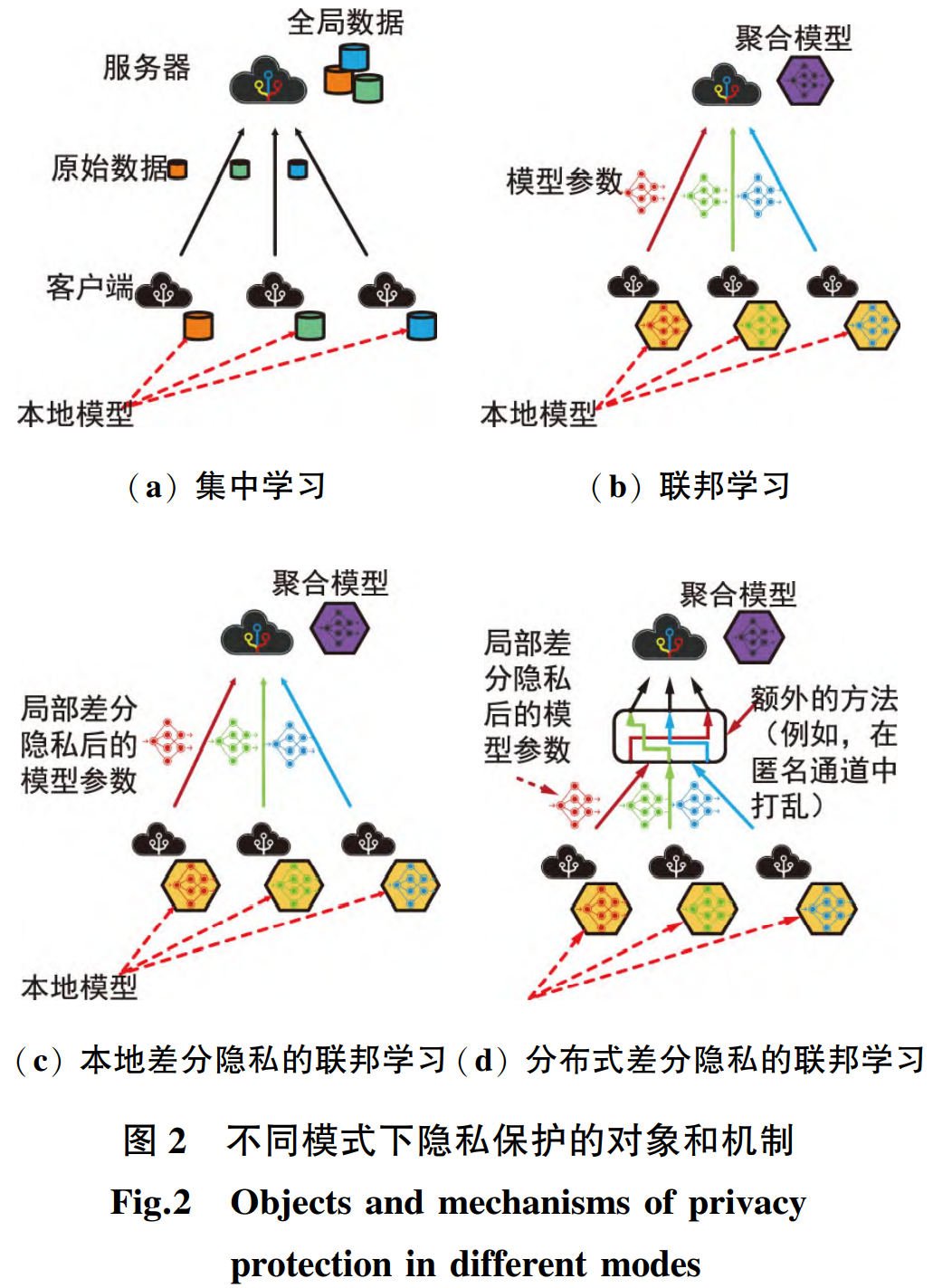

3.1 任务卸载

边缘计算允许边缘设备在能量、延迟、计算能力等约束下,将部分计算任务卸载给边缘节点[42]。但如图3所示,存在如下一些挑战:① 当一个边缘设备处于多个边缘节点的服务范围时,如何选择合适的节点进行任务卸载;②对于有一定计算资源的边缘设备,需要平衡在本地和在边缘节点执行任务时的资源消耗和延迟程度,以此达到一个最优的执行策略;③由于应用程序服务的多样性,边缘设备也需要处理各种各样的任务。但是,不同类型的任务对资源的需求不同。因此,对各种资源的分配也是一个挑战。

解决这类任务卸载问题是NP⁃hard[43],因为至少需要结合优化通信和计算资源以及边缘设备的竞争。特别是,优化需要考虑无线环境的时变(如信道质量的变化)和任务卸载的要求,因此需要使用学习方法。在所有与基于学习的优化方法相关的工作中,当有多个边缘节点和无线信道可进行计算卸载时,基于DL的方法比其他方法更具有优势。下面介绍两种基于DL的方法。

丨3.1.1 DNN用例

为了更高效地利用网络资源,在DNN的基础上研究者提出了许多高效卸载方案。例如,文献[44]提出了一种将DNN划分为多个分区的技术,这些分区可以在本地由终端设备处理,也可以卸载到一个或多个强大的节点上。文献[45]采用最短路径法 和惩罚因子法确定DNN分区,并在每个DNN分区到达时增量构建DNN模型,允许客户端在上传整个DNN 模型之前就开始部分上传,从而提高查询性能;基于上传开销罚因子法,文献[46]提出了一种增强分区法,该方法利用客户端与云/边缘服务器之 间的DNN执行图上的最短路径法对DNN层进行分区,生成更细粒度的上传计划;文献[47]将DNN最优计算调度问题转化为移动云计算环境下的最短路 径问题和整数线性规划(ICP),并通过层粒度优化 公式对DNN架构进行划分,从而实现移动设备和云之间的协同计算。文献[48]提出了一种端边云协同 环境下的DN推理加速高效卸载方案(Eos DNN),其中DNN推理加速主要体现在迁移延迟的优化和实时DNN查询的实现。

此外,文献[49]研究了关于区块链的一个特殊卸载场景。边缘设备上挖掘任务的计算和能量消耗 可能会限制区块链在EC网络中的实际应用。当然,这些挖掘任务可以从边缘设备卸载到边缘节点,但这可能导致边缘资源分配不公平。

丨3.1.2 DRL用例

虽然将计算任务卸载到边缘节点可以提高计算任务的处理效率,但由于无线环境的潜在质量较低,卸载的可靠性受到影响。在文献[50]中,为了使卸载效用最大化,作者首先量化了各种通信模式对任务卸载性能的影响,并据此提出了应用DQL(Deep Q⁃Learning)在线选择最优目标边缘节点和传输模式的方法。文献[51]不仅考虑了延迟违反概率,还 考虑了解码错误概率,指出了传输数据的编码速率是使卸载达到要求的可靠性水平的关键;考虑了编码块长度的影响,提出了计算资源分配的马尔可夫决策过程(MDP),以提高平均卸载可靠性。

此外,还有不少文献讨论了边缘设备细粒度计算资源的调度问题,主要涉及到任务卸载中的能量收集问题。例如,文献[52]使用DDQL提出了一种最佳的动态电压频率缩放算法,实验结果显示与 DQL相比,DDQL可以节省更多的能量,实现更高的卸载效率。与之前基于DQL 的离散功率控制策略不同,文献[53]提出了一种具有连续动作空间(而非离散动作空间)的DRL方法DDPG,对局部执行和任务卸载进行更细粒度的功率控制。该方法可以自适应地分配边缘设备的功率,以使其长期平均成本最小,数值仿真验证了该方法相对于基于DQL的离散功率控制策略的优越性。

3.2 边缘缓存

随着各类智能终端设备的兴起,多媒体应用、手机游戏、社交应用等服务也得到了快速发展。这一趋势在给网络架构带来越来越大流量压力的同时,也展示了一个有趣的特性,即相同的内容经常被同一区域的设备多次请求。这一特性促使研究人员考虑如何缓存内容,以实现对请求的快速响应,并减少网络上的流量负载。从内容交付网络到蜂窝网络的 内容缓存,网络中的内容缓存研究从未停歇,以此来应对不断增长的多媒体业务需求。边缘缓存[54] 符合向用户推送内容的理念,被认为是进一步减少冗余数据传输、缓解云数据中心压力、提高QoE(Quality of Experience ) 的一种很有前景的解决方案。

边缘缓存可以利用地理位置上离用户较近的边缘节点缓存热点内容,从而实现对服务范围内请求 的快速响应。因此,边缘缓存不仅可以实现更快的请求响应,还可以减少网络中相同内容的重复传输。然而,边缘缓存也面临许多挑战。通常,边缘缓存需要解决两个密切相关的问题:①边缘节点覆盖范围内热门内容的分布难以估计,可能会随时空变化而不同,并发生变化[55];② 针对EC环境中海量异构设备的特点,层级化的缓存体系结构和复杂的网络特性使内容缓存策略的设计更加困难[56]。具体来说,只有当内容流行度分布已知时,才能推导出最佳边缘缓存策略。然而,用户对内容的偏好实际上是未知的,因为他们的移动性、个人偏好和连通性可能 一直在变化。在本小节中,将讨论用于确定边缘缓存策略的DL学习算法。

丨3.2.1 DNN用例

传统的缓存方法通常计算复杂度较高,因为它们需要大量的在线优化迭代来确定用户和内容的特 征以及内容放置和传递策略。

① DL可以用来处理从用户的移动设备上收集到的原始数据,从而提取用户和内容的特征,作为基于特征的内容流行矩阵。这个流行度矩阵可以量化用户和内容的流行度,为缓存决策提供数字基础。例如,文献[57]提出在FL的框架下使用自动编码器实现用户信息和文件信息的特征提取,然后根据相似度矩阵给出推荐的缓存列表。

② 在使用DNN优化边缘缓存策略时,可以通过离线训练避免在线繁重的计算迭代。DNN由一个用于数据正则化的编码器和后面的隐藏层组成, 可以用最优或启发式算法生成的解进行训练并部署,以确定缓存策略[58],从而避免在线优化迭代。类似地,在文献[59]中,受部分缓存刷新优化问题 的输出具有某些模式的启发,训练 MLP接收当前内容流行度和最后一次内容放置概率作为输入,以生成缓存刷新策略。

虽然可以设计和实现基于DNN的缓存内容放置 和传递策略,但仍存在一些不足。如文献[58-59]所示,优化算法的复杂性可以转移到DNN 的训练中, 从而打破了使用优化算法的实际局限性。在这种情 况下,DL用于学习输入———解关系,而基于DNN的方法只有在原始缓存问题存在优化算法时才可用。因此,基于DNN方法的性能受固定的优化算法限 制,不具有自适应性。

此外,DL还可以用于定制边缘缓存。例如,为了最小化自动驾驶汽车的内容下载延迟,在云中部署一个 MLP来预测需要请求的内容的流行程度,然后将 MLP 的输出发送到边缘节点(即文献[60]中RSu的 MEC服务器),最后根据这些输出,每个边缘节点缓存最有可能被请求的内容。

但是,对于不同特征的用户,他们对内容的偏好是不同的。因此,可以将用户深度划分为不同的类别,然后探究每个类别中用户的偏好,这对提高内容缓存的命中率有积极的影响。在自动驾驶汽车方面,CNN被选中预测车主的年龄和性别。一旦识别出车主的这些特征,就使用K⁃means聚类和二值分类算法来确定哪些已经缓存在边缘节点的内容需要进一步从边缘节点下载并缓存到汽车上。此外,文献[61]在充分利用用户特性方面指出,在不同的环境中,用户访问内容的意愿是不同的。受此启发,RNN被用来预测用户的轨迹。然后根据这些预测,将所有用户感兴趣的内容预取并提前缓存到每个预测位置的边缘节点。

丨3.2.2 DRL用例

上节中描述的DNN功能可以看作是整个边缘 缓存解决方案的一部分,即 DNN本身并不处理整个优化问题。与这些基于DNN的边缘缓存不同,DRL可以利用用户和网络的上下文环境,以自适应策略最大化长期缓存性能作为优化方法的主体。

与传统的RL,如Q⁃learning[62]和Multi-ArmedBandit(MAB) Learning[55]相比,DRL的优势在DNN可以从原始观测数据中学习关键特征。结合RL和DL的集成DRL agent 可以直接从高维观测数据中优化EC网络的缓存管理策略。

文献[63]使用DDPG来训练DRL代理,以最大化长期缓存命中率,做出适当的缓存替换决策。该工作考虑单个BS场景,在该场景中,DRL代理决定是缓存请求的内容还是替换缓存的内容。在训练DRL代理时,奖励被设计为缓存命中率。此外,利用Wolpertinger架构[64]来应对大行动空间的挑战。具体来说,首先为DRL代理设置一个主要操作集,然后使用KNN将实际操作输入映射到该集合中的一个。通过这种方式,操作空间被有意地缩小,而不 会丢失最优的缓存策略。与基于DQL的算法搜索 整个动作空间相比,经过训练的DRL代理与DDPG和 Wolpertinger体系结构相比,能够在降低运行时 间的同时实现具有竞争力的缓存命中率。

另外,考虑到流行内容的时变性,文献[65]使用Wolpertinger 架构的深度强化学习框架研究无线网络边缘的内容缓存。特别地,提出了基于深度行为者-批评强化学习的集中和分散内容缓存策略。仿真结果验证了该策略相比最少使用策略(LFU)、最少最近使用策略(LRU)和先进先出策略(FIFO)具有很强的优越性。

3.3 目前面临的挑战

虽然AI for edge 的应用比较广泛,但也存在一些挑战。本节从系统建模、算法部署、优化与效率的平衡和资源编排四个方面列举了AI on edge 的重大挑战。

系统建模

使用AI方法进行系统建模时,公式化模型的数量必须是有限的。但模型数量的有限,使得一些以SGD和MBGD优化基础的AI算法可能无法很好地工作。同时针对MDP问题,状态集和动作集又不能是无限的,在进一步处理之前需要进行离散化,以避免维数灾难问题的出现。一般的解决方法是将约束转化为惩罚,并将其纳入全局优化目标。这种现状极大地制约了数学模型的建立,导致性能下降。这种情况可以被看作是利用AI方法的 一种妥协。因此,这对在EC中建立合适的系统模型构成了挑战。

算法部署

对于边缘的AI算法来说,当这些算法以在线方式部署在边缘时,会面临诸多挑战。此外,另一个被忽略的问题是,由哪个边缘设备来部署 和运行所提出的复杂算法。现有的研究工作通常集 中在具体问题上,而没有提供细节。

优化与效率的平衡

尽管AI技术确实能够提 供最优的解决方案,但在资源受限的边缘环境中,研 究者更多的是关心如何在有限的资源下实现更高的 算法效率。特别是在嵌入式的行业中,大多的设备都是资源受限的,但在嵌入式设备上部署的任务确实很 多,要完成这些任务,就需要把有限的资源最大化。因此,如何在嵌入AI技术的情况下,提高EC系统在不同应用场景下的可用性和效率是一个严峻的挑战。

资源编排

为了充分利用边缘计算的去中心化资源,需要建立与现有云计算基础设施的连接。由于EI的部署环境通常是高度动态的,边缘计算框架需要优秀的在线资源编排和参数配置,才能支持大量的AI服务。异构计算资源、通信资源和缓存资源的实时联合优化、高维系统参数配置是关键。然而,目前还没有相关的工作深入研究部署和使用这些DL技术在实际边缘计算网络或测试平台上,进行长期在线资源编排的性能分析。

4.

结论

EI的发展处于初始阶段,吸引了众多的学者参与研究,本文通过一个简单明了的分类对EI的研究现状提供一些参考。具体来说,本文首先分析了 AI和EC的关系,提出了在IoT时代二者结合的必要性,从而引出EI的概念;接着,本文将EI分为AI on edge和AI for edge 两部分,然后从模型训练、模型推理两方面阐述了AI on edge现状,并给出了存在的一些挑战;对于AI for edge,本文从任务卸载和边缘缓存两方面进行了阐述,并给出了可能存在的挑战。最后,希望本文能够激发相关学者对EI未来研究的兴趣。

参考文献如下:

参 考 文 献

[1] ASIF⁃UR⁃RAHMAN M,AFSANA F,MAHMUD M,et al. Toward a Heterogeneous Mist, Fog, and Cloud⁃based Framework for the Internet of Healthcare Things[ J].IEEE Internet of Things Journal,2019,6(3):4049-4062.

[2] ZWOLENSKI M, WEATHERILL L. The Digital Universe Rich Data and the Increasing Value of the Internet of Things[ J].Journal of Telecommunications and the Digital Economy,2014,2(3):1-9.

[3] CHIANG M, ZHANG T. Fog and IoT: An Overview of Research Opportunities[ J].IEEE Internet of Things Jour⁃ nal,2017,2(6):854-864.

[4] AHMED A,AHMED E.A Survey on Mobile Edge Compu⁃ ting[ C ] ∥ IEEE Conference on Intelligent Systems & Control.Coimbatore:IEEE,2016:1-10.

[5] SHI W,CAO J,ZHANG Q,et al. Edge Computing:Vision and Challenges[ J].IEEE Internet Things Journal,2016,3(5):637-646.

[6] PREMSANKAR G, FRANCESCO M D, TALEB T. Edge Computing for the Internet of Things:A Case Study[ J]. IEEE Internet Things Journal,2018,5(2):1275-1284.

[7] MAO Y, YOU C, ZHANG J, et al. A Survey on Mobile Edge Computing: The Communication Perspective [J]. IEEE Communications Surveys & Tutorials,2017,19(4): 2322-2358.

[8] CHEN J.The Evolution of Computing:AlphaGo[ J]. Com⁃ puting in Science & Engineering,2016,18(4):4-7.

[9] SHAHABI C. The Future of Driverless Cars [ M ]. New York:Springer,2016.

[10] ZENG S,WU M.Based on Public Health Service in Smart Medical Comprehensive Service Platform [ C ] ∥ IEEE Conference on Computation, Communication and Engi⁃ neering.Longyan:IEEE,2019:1-4.

[11] HAO X,ZHANG G,MA S.Deep Learning[J].International Journal of Semantic Computing,2016,10(3):417-439.

[12] ZHOU Z,CHEN X,LI E,et al. Edge Intelligence:Paving the Last Mile of Artificial Intelligence with Edge Computing[ J]. Proceedings of the IEEE,2019,107( 8): 1738-1762.

[13] ZHANG X, WANG Y, LU S, et al. Open EI: An Open Framework for Edge Intelligence[ C] ∥IEEE 39th Inter⁃ national Conference on Distributed Computing Systems( ICDCS).Dallas:IEEE,2019:1840-1851.

[14]李肯立,刘楚波. EI: 现状和展望[ J]. 大数据, 2019, 5(3):72-78.

[15] CHEN J, RAN X. Deep Learning with Edge Computing: A Review[ J]. Proceedings of the IEEE, 2019, 107( 8): 1655-1674.

[16] WANG X,HAN Y,LEUNG V,et al.Edge AI:Convergence of Edge Computing and Artificial Intelligence [ M]. New York:Springer Press,2020.

[17] MAO Q, HU F, HAO Q. Deep Learning for Intelligent Wireless Networks: A Comprehensive Survey [ J ]. IEEE Communications Surveys & Tutorials, 2018, 20 ( 4 ): 2595-2621.

[18] CHEN M,CHALLITA U,SAAD W,et al.Artificial Neural Networks⁃based Machine Learning for Wireless Networks: A Tutorial [ J ]. IEEE Communications Surveys & Tutorials,2019,21(4):3039-3071.

[19] MCMAHAN H,MOORE E,RAMAGE D,et al. Communi⁃ cation⁃efficient Learning of Deep Networks from Decen⁃ tralized Data[ C] ∥Proceedings of the 20th International Conference on Artificial Intelligence and Statistics. Fort Lauderdale:AISTATS,2017:1273-1282.

[20] ABAD M,OZFATURA E,GUNDUZ D,et al. Hierarchical Federated Learning Across Heterogeneous Cellular Networks[ C] ∥IEEE Conference on Acoustics, Speech, and Signal Processing.Brighton:IEEE,2019:8866-8870.

[21] SATTLER F,WIEDEMANN S,MULLER K,et al. Robust and Communication⁃Efficient Federated Learning from Non⁃i.i.d. Data[J].IEEE Transactions on Neural Networks and Learning Systems,2020,31(9):3400-3413.

[22] XU J, DU W, CHENG R, et al. Ternary Compression for Communication⁃Efficient Federated Learning [ J / OL ]. arXiv:2003. 03564v1, 2020. [ 2021 - 08 - 19]. https: ∥ arxiv.org / abs / 2003.03564.

[23] CHEN Y, SUN X, JIN Y. Communication⁃Efficient Federated Deep Learning with Asynchronous Model Update and Temporally Weighted Aggregation [ J]. IEEE Transactions on Neural Networks and Learning Systems, 2020,31(10):4229-4238.

[24] WANG S, TUOR T, SALONIDIS T, et al. When Edge Meets Learning: Adaptive Control for Resource Constrained Distributed Machine Learning [ C ] ∥ IEEE INFOCOM.Honolulu:IEEE,2018:63-71.

[25] XU Z,YU F,YANG Z,et al. Helios:Heterogeneity⁃Aware Federated Learning with Dynamically Balanced Collabora⁃ tion[ J / OL].arXiv:1912.01684v2,2021.[ 2021- 08- 17]. https:∥arxiv.org / abs / 1912.01684v2.

[26] DINH C,TRAN N,NGUYEN M,et al.Federated Learning over Wireless Networks: Convergence Analysis and Resource Allocation[ J].IEEE / ACM Transactions on Net⁃ working,2021,29(1):398-409.

[27] WANG H,KAPLAN Z,NIU D,et al.Optimizing Federated Learning on Non⁃IID Data with Reinforcement Learning[ C] ∥IEEE INFOCOM.Honolulu:IEEE,2020:1-10.

[28] XIE C,KOYEJO S,GUPTA I.Practical Distributed Learn⁃ ing:Secure Machine Learning with Communication⁃efficient Local Updates[J / OL]. arXiv:1903.06996v1,2019.[ 2021- 07-29].https:∥arxiv.org / abs / 1903.06996v1.

[29] ANG F,CHEN L,ZHAO N,et al.Robust Federated Learn⁃ ing with Noisy Communication[ J]. IEEE Transactions on Communications,2020,68(6):3452-3464.

[30] KIM H, PARK J, BENNIS M, et al. On⁃device Federated Learning via Blockchain and Its Latency Analysis[ J / OL]. arXiv:1808. 03949v2, 2019. [ 2021 - 07 - 28]. https: ∥ arxiv.org / pdf / 1808.03949.pdf.

[31] ALWANI M, CHEN H, FERDMAN M, et al. Fused⁃layer CNN Accelerators[ C] ∥49th Annual IEEE International Symposium on Microarchitecture. Taipei: IEEE, 2016: 1-12.

[32] RASTEGARI M,ORDONEZ V,REDMON J,et al. XNOR⁃ Net: ImageNet Classification Using Binary Convolutional Neural Networks[C]∥2018 European Conference on Com⁃ puter Vision.Munich:ECCV,2016:525-542.

[33] IANDOLA F,HAN S,MOSKEWICZ M,et al.SqueezeNet: AlexNet⁃level Accuracy with 50x Fewer Parameters and< 0.5 MB Model Size [ J / OL ]. arXiv: 1602. 07360v4, 2016. [ 2021 - 08 - 02 ]. https: ∥ arxiv. org / abs / 1602. 07360v4.

[34] HINTON G, VINYALS O, DEAN J. Distilling the Knowledge in a Neural Network [ J / OL ]. arXiv: 1503. 02531v1,2015. [ 2021 - 08 - 06]. https: ∥arxiv. org / abs / 1503.02531.

[35] KANG Y, HAUSWALD J, GAO C, et al. Neurosurgeon: Collaborative Intelligence between the Cloud and Mobile Edge[ C] ∥Proceeding of 22nd International Conference Architecture Support Programming Language Operator System.Xi’ an:ASPLOS,2017:615-629.

[36] LI G,LIU L,WANG X,et al. Auto⁃tuning Neural Network Quantization Framework for Collaborative Inference between the Cloud and Edge[ C] ∥Proceeding of Interna⁃ tional Conference on Artificial Neural Networks. Kuala Lumpur:ICANN,2018:402-411.

[37] ZHAO Z,BARIJOUGH K,GERSTLAUER A,et al. Deep⁃ Things:Distributed Adaptive Deep Learning Inference on Resource⁃constrained IoT Edge Clusters[ J]. IEEE Trans⁃ actions on Computer⁃Aided Design of Integrated Circuits and Systems,2018,37(11):2348-2359.

[38] ZHANG J, CHEN B, LIN Y, et al. A Locally Distributed Mobile Computing Framework for DNN Based Android Applications[ C] ∥Proceeding of the Tenth Asia⁃Pacific Symposium on Internetware.Beijing:CSERIS,2018:1-6.

[39] DROLIA U, GUO K, TAN J, et al. Cachier: Edge⁃caching for Recognition Applications[C]∥IEEE 37th International Conference on Distributed Computing Systems. Atlanta: ICDCS,2017:276-286.

[40] GUO P, HU B, LI R, et al. Foggy Cache: Cross⁃device Approximate Computation Reuse[ C] ∥Proceeding of the 24th Annual International Conference on Mobile Computing and Networking.New Delhi:MobiCom,2018:19-34.

[41] WANG L, LIU W, ZHANG D, et al. Cell Selection with Deep Reinforcement Learning in Sparse Mobile Crowdsensing[ C] ∥2018 IEEE 38th International Confer⁃ ence on Distributed Computing Systems. Vienna: IEEE, 2018:1543-1546.

[42] MACH P,BECVAR Z. Mobile Edge Computing:A Survey on Architecture and Computation Offloading [ J ]. IEEE Communications Surveys & Tutorials, 2017, 19 ( 3 ): 1628-1656.

[43] CHEN X,JIAO L,LI W,et al.Efficient Multi⁃user Compu⁃tation Offloading for Mobile⁃edge Cloud Computing [ J]. IEEE / ACM Transactions on Networking, 2016, 24 ( 5): 2795-2808.

[44] MOHAMMED T, JOE⁃WONG C, BABBAR R, et al. Dis⁃ tributed Inference Acceleration with Adaptive DNN Parti⁃ tioning and Offloading [ C] ∥ IEEE INFOCOM. Toronto: IEEE,2020:1-10.

[45] JEONG H,LEE H,SHIN C,et al. IONN:Incremental Off⁃ loading of Neural Network Computations from Mobile Devices to Edge Servers [ C] ∥ Proceedings of the ACM Symposium on Cloud Computing. Carlsbad: ACM, 2018: 401-411.

[46] SHIN K, JEONG H, MOON S. Enhanced Partitioning of DNN Layers for Uploading from Mobile Devices to Edge Servers[ C] ∥ the 3rd International Workshop on Deep Learning for Mobile Systems and Applications. Korea: ACM 2019:35-40.

[47] ESHRATIFAR A, ABRISHAMI M, PEDRAM M.

JointDNN:An Efficient Training and Inference Engine for Intelligent Mobile Cloud Computing Services [ J]. IEEE Transactions on Mobile Computing, 2021, 20 ( 2 ): 565-576.

[48] XUE M,WU H, LI R, et al. EosDNN: An Efficient Off⁃ loading Scheme for DNN Inference Acceleration in Local⁃ Edge⁃Cloud Collaborative Environments[ J]. IEEE Trans⁃ actions on Green Communications and Networking,2021: 1-17.

[49] LUONG N,XIONG Z,WANG P,et al.Optimal Auction for Edge Computing Resource Management in Mobile Block⁃ chain Networks:A Deep Learning Approach[ C] ∥IEEE Conference on Communications.Kansas City:IEEE,2018: 1-6.

[50] ZHANG K,ZHU Y,LENG S,et al.Deep Learning Empow⁃ ered Task Offloading for Mobile Edge Computing in Urban Informatics [ J ]. IEEE Internet Things Journal, 2019, 6(5):7635-7647.

[51] YANG T, HU Y, GURSOY M, et al. Deep Reinforcement Learning Based Resource Allocation in Low Latency Edge Computing Networks[ C] ∥15th International Symposium on Wireless Communication Systems.Lisbon:IEEE,2018: 1-5.

[52] ZHANG Q, LIN M, YANG L, et al. A Double Deep Q⁃learning Model for Energy⁃efficient Edge Scheduling[ J]. IEEE Transactions on Services Computing,2019,12(5):739-749.

[53] CHEN Z,WANG X.Decentralized Computation Offloading for Multi⁃user Mobile Edge Computing:A Deep Reinforce⁃ment Learning Approach [ J ]. EURASIP Journal -on Wireless Communcations and Networking,2020(1):1 6.

[54] ZEYDAN E,BASTUG E,BENNIS M,et al.Big Data Cac⁃ hing for Networking:Moving from Cloud to Edge[ J].IEEE Communications Magazine,2016,54(9):36-42.

[55] SONG J, SHENG M, QUEK T, et al. Learning⁃based Content Caching and Sharing for Wireless Networks[ J]. IEEE Transactions Communications, 2017, 65 ( 10 ): 4309-4324.

[56] LI X,WANG X,WAN P,et al.Hierarchical Edge Caching in Device⁃to⁃Device Aided Mobile Networks: Modeling, Optimization, and Design [ J]. IEEE Journal on Selected Areas in Communications,2018,36(8):1768-1785.

[57] YU Z,HU J,MIN G,et al.Federated Learning Based Pro⁃ active Content Caching in Edge Computing [ C] ∥ IEEE Global Communications Conference. Abu Dhabi : IEEE, 2018:1-6.

[58] CHANG Z, LEI L, ZHOU Z, et al. Learn to Cache: Machine Learning for Network Edge Caching in the Big Data Era [ J]. IEEE Wireless Communications, 2018, 25(3):28-35.

[59] YANG J, ZHANG J, MA C, et al. Deep Learning⁃based Edge Caching for Multi⁃cluster Heterogeneous Networks[ J]. Neural Computing & Applications, 2019, 32 ( 19): 1-12.

[60] NDIKUMANA A, TRAN N, HONG C. Deep Learning Based Caching for Self⁃driving Car in Multi⁃access Edge Computing[ J / OL]. arXiv: 1810. 01548v1, 2020. [ 2021 - 08-07].https:∥arxiv.org / abs / 1810.01548v1.

[61] TANG Y, GUO K, MA J, et al. A Smart Caching Mechanism for Mobile Multimedia in Information Centric Networking with Edge Computing [ J]. Future Generation Computer Systems,2019,91:590-600.

[62] GUO K, YANG C, LIU T. Caching in Base Station with Recommendation Via Q⁃learning [ C ] ∥ IEEE Wireless Communications and Networking Conference.San Francisco: IEEE,2017:1-6.

[63] ZHONG C,GURSOY M,VELIPASALAR S, et al.A Deep Reinforcement Learning⁃based Framework for Content Caching[ C] ∥ 52nd Annual Conference on Information Sciences and Systems.Princeton:CISS,2018:1-6.

[64] DULAC⁃ARNOLD G,EVANS R,HASSELT H,et al.Deep Reinforcement Learning in Large Discrete Action Spaces[ J / OL].(2016-4- 4). arXiv:1512.07679,2016. https:∥

arxiv.org / abs / 1512.07679v2

[65] CHEN Z,GURSOY M,VELIPASALAR S.Deep Reinforce⁃ ment Learning⁃based Edge Caching in Wireless Networks[J]. IEEE Transactions on Cognitive Communications and

Networking,2020,6(1):48-61.

作者介绍:

乔德文 博士研究生。主要研究方向:边缘计算、凸优化、机器学习等。

郭松涛 重庆大学计算机学院教授,博士生导师。主要研究方向:移动边缘计算、联邦学习、无线传感器网络和无线自组织网络等。

何静 博士研究生。主要研究方向:无线自组织网络、移动边缘计算和联邦学习等。

朱永东 之江实验室研究员。主要研究方向:边缘计算、群体智能、感知-计算-传输一体化网络等。

doi:10.3969/ j.issn.1003-3114.2022.01.003

引用格式: 乔德文,郭松涛,何静,等.边缘智能:研究进展及挑战

[J].无线电通信技术,2022,48(1):34-45.

[QIAO Dewen,GUO Songtao,HE Jing,et al.Edge Intelligence:Research Progress and Challenges [ J].Radio Communications Technol⁃ ogy,2022,48(1):34-45.]

首发《无线电通信技术》2022年第48卷第1期

全球边缘计算大会定档8月6日,疫散云开相聚鹏城,如果您对边缘计算感兴趣,不妨参加一下。优质的线下活动越来越少,不确定太多,所以希望在确定的会议里和你聊聊关于边缘的一切。

最后

以上就是结实冰棍最近收集整理的关于边缘智能:研究进展及挑战引言的全部内容,更多相关边缘智能内容请搜索靠谱客的其他文章。

发表评论 取消回复