目录

- 熵

- 举例:

- 条件熵

- 举例:

- 互信息(信息增益)

- 信息增益 定义

- 信息增益的 应用

- 互信息 概念

- 性质

- 交叉熵

- 定义

熵

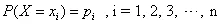

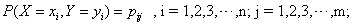

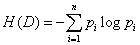

熵是表示随机变量不确定性的度量,X 是一个取有限值的离散随机变量,其概率分布为:

则随机变量X的熵定义为

举例:

假设有随机变量X,用来表达明天天气的情况。X可能出现三种状态 1) 晴天2) 雨天 3)阴天 每种状态的出现概率均为P(i) = 1/3,那么根据上述公式:

H(X) = - 1/3 * log(1/3) - 1/3 * log(1/3) + 1/3 * log(1/3) = log3 =0.47712

如果这三种状态出现的概率为(0.1, 0.1, 0.8), 那么

H(X) = -0.1 * log(0.1) *2 - 0.8 * log(0.8) = 0.277528

可以发现前面一种分布X的不确定程度很高,每种状态都很有可能。后面一种分布,X的不确定程度较低,第三种状态有很大概率会出现。 所以对应前面一种分布,熵值很高,后面一种分布,熵值较低。

条件熵

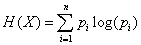

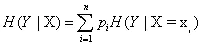

当随机变量为多维随机变量时,其联合概率分布为:

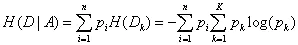

条件熵H(Y|X),表示已知随机变量X的条件下随机变量Y的不确定性,定义为X给定条件下Y的条件概率分布的熵对X的数学期望:

举例:

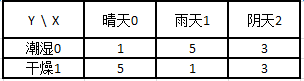

假设随机变量X表示明天的天气情况,随机变量Y表示今天的湿度,Y 有两种状态 1) 潮湿 2) 干燥。

假设基于以往的18个样本, X 的三种状态,概率均为 0.33, Y的两种状态,概率为0.5

条件概率可以通过朴素贝叶斯公式进行计算:

P(X=0|Y=0) =P(X=0,Y=0)/P(Y=0) = (1/18)/(9/18) = 1/9

P(X=1|Y=0)= P(X=1,Y=0)/P(Y=0) = (5/18)/(9/18) = 5/9

P(X=2|Y=0) =P(X=2,Y=0)/P(Y=0) = (3/18)/(9/18) = 3/9

P(X=0|Y=1) =P(X=0,Y=0)/P(Y=1) = (1/18)/(9/18) = 1/9

P(X=1|Y=1)= P(X=1,Y=0)/P(Y=1) = (5/18)/(9/18) = 5/9

P(X=2|Y=1) =P(X=2,Y=0)/P(Y=1) = (3/18)/(9/18) = 3/9

根据公式:

H(X|Y) = (1/18)*log(1/9) + (5/18)*log(5/9) + (3/18)*log(3/9) + (1/18)*log(1/9) + (5/18)*log(5/9) + (3/18)*log(3/9) = 0.406885

互信息(信息增益)

信息增益 定义

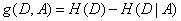

信息增益表示:特征X的信息使得Y的信息的不确定性减少的程度,定义为集合D的经验熵H(D)与特征A给定的条件下D的经验熵H(D|A)之差:

所以Y条件产生的信息增益为 0.47712 - 0.406885

信息增益的 应用

我们在利用进行分类的时候,常常选用信息增益更大的特征,信息增益大的特征对分类来说更加重要。决策树就是通过信息增益来构造的,信息增益大的特征往往被构造成底层的节点

熵与条件熵只差称为互信息。

H(D)的计算公式

H(D|A)的计算公式

参考原文链接

互信息 概念

互信息,Mutual Information,缩写为MI,表示两个变量X与Y是否有关系,以及关系的强弱。

I(X,Y)=∫X∫YP(X,Y)logP(X,Y)P(X)P(Y)I(X,Y)=∫X∫YP(X,Y)logP(X,Y)P(X)P(Y)

可以看出,如果X与Y独立,则P(X,Y)=P(X)P(Y),I(X,Y)就为0,即代表X与Y不相关

I(X,Y)=H(Y)−H(Y|X)I(X,Y)=H(Y)−H(Y|X)

理解:确定随机变量X的值后,另一个随机变量Y不确定性的削弱程度,因而互信息取值最小为0,意味着给定一个随机变量对确定一另一个随机变量没有关系,最大取值为随机变量的熵,意味着给定一个随机变量,能完全消除另一个随机变量的不确定性。这个概念和条件熵相对。

可以看出,I(X,Y)可以解释为由X引入而使Y的不确定度减小的量,这个减小的量为H(Y|X)

所以,如果X,Y关系越密切,I(X,Y)就越大

I(X,Y)最大的取值是H(Y)H(Y),此时H(Y|X)为0,意义为X和Y完全相关,在X确定的情况下Y是个定值,没有出现其他不确定情况的概率,所以为H(Y|X)为0

I(X,Y)取0时,代表X与Y独立,此时H(Y)=H(Y|X),意义为X的出现不影响Y。

性质

I(X;Y)I(X;Y)的性质:

1)I(X;Y)⩾0 ,I(X;Y)⩾0

2)H(X)−H(X|Y)=I(X;Y)=I(Y;X)=H(Y)−H(Y|X)H(X)−H(X|Y)=I(X;Y)=I(Y;X)=H(Y)−H(Y|X)

3)当X,Y独立时,I(X;Y)=0,I(X;Y)=0

4)当X,Y知道一个就能推断另一个时,I(X;Y)=H(X)=H(Y)

交叉熵

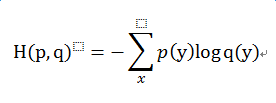

定义

信息论中的重要概念,主要用于度量两个概率分布间的差异性信息。

理解: 在进行优化的过程中,往往将交叉熵又命名为loss变量,优化的目标即是最小化loss。

假如X为一组已知的输入特征值,Y为一组已知的输出分类。优化的目标是为了找到一个映射模型F, 使得预测值Y_ = F(X), 与真值Y最相似。但现实世界的Y和Y_的分布肯定不是完全一致的。

所以:

Y 服从 p分布(即真实分布),Y_ 服从 q分布

交叉熵 cross_entropy 即为描述p,q两个分布差异性的指标:

最后

以上就是风中白开水最近收集整理的关于通信基础 1——熵、条件熵、互信息熵条件熵互信息(信息增益)交叉熵的全部内容,更多相关通信基础内容请搜索靠谱客的其他文章。

发表评论 取消回复