提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

- 前言

- 一、Python爬虫是什么?

- 二、使用步骤

- 1装入所需要的库

- 2.这里直接给出爬虫通用框架

- 3.requests库的7个主要方法

- 总结

- 文中资源来自中国大学Mooc

前言

兴趣是最好的导师,有很多人在学习编程的时候被前期枯燥的语法劝退

这篇博客就将带领大家从初学者的视角学习Python 爬虫 发现编程的魅力。

一、Python爬虫是什么?

一段自动抓取互联网信息的程序,从互联网上抓取对于我们有价值的信息

这里给出几个实用的案例:

(1)搜索引擎,例如百度、谷歌等搜索公司利用爬虫收揽网站,将目前信息时代数据变现成商业产品;

(2)舆情分析,例如百度、谷歌、搜狗、微博等排行旁,或者其他类的舆情分析产品;

(3)数据买卖,爬取数据提供给买数据的公司,例如天眼查、西瓜数据等;

(4)数据采集,政府、企业、科研工作者等用户根据需求爬取所需要的数据;

(5)爬取一些自己想要的资源,比如爬取美剧、电影等。

二、使用步骤

1装入所需要的库

这里使用requests库,requests是非常适合初学者及个人使用的库

这里直接用,pip指令装入pip install requests

可以用pip list 指令查看已装的库

如果看到requests则代表库已经装好

注:win+r输入cmd回车进入命令行输入以上代码

一般安装python的时候会自动装pip,如果出现pip不是内部或外部指令,应该就是路径问题

最有效简单的方法就是在pip官网下载放入python的Scripts目录下

2.这里直接给出爬虫通用框架

使用爬虫代码框架,可以使程序更稳定,安全

代码如下(示例):

#try except语句用来获取异常

import requests

def getHTMLText(url):#构造函数,url为网址

try:

r=request.get(url,timeout=30)

r.raise_for_status()#如果状态码不是200,则引发HTTPError异常

r.encoding = r.apparent.encoding#使返回的解码正确

return r.text#返回文本

except:

return "产生异常"

if__nema__=="__main__":

url = "http://www.baidu.com"

print(getHTMLText(url))

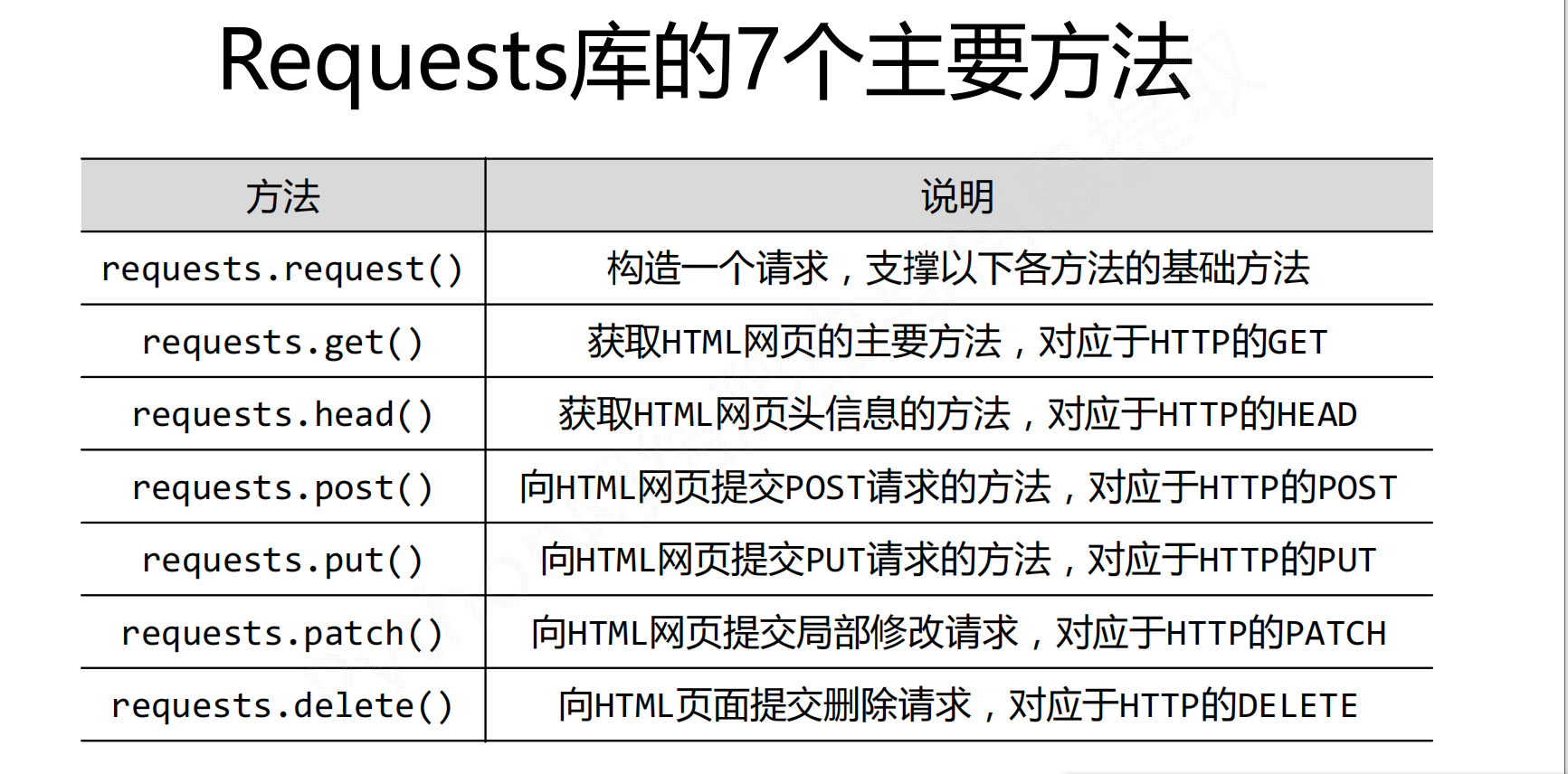

3.requests库的7个主要方法

对于爬虫来说,运用最多的就是get方法,在后面的文章中,我将给出get方法的详细解读及五个实例

总结

这篇文章只是给出了通用框架及前期的准备,在后面的文章中我会详细的,以最基础的东西开始,教会大家如何使用爬虫。

博主只是一位普通的大一学生,且初次写博客,排版及文笔比较差,如果内容出现错误,欢迎大家指出并改正

以及有对文章的意见,直言不讳。对我批评改正。

**

文中资源来自中国大学Mooc

最后

以上就是细心红牛最近收集整理的关于手把手从0开始学会Python爬虫,从大一初学者视角,带你实现爬虫攥写前言一、Python爬虫是什么?二、使用步骤总结的全部内容,更多相关手把手从0开始学会Python爬虫内容请搜索靠谱客的其他文章。

发表评论 取消回复