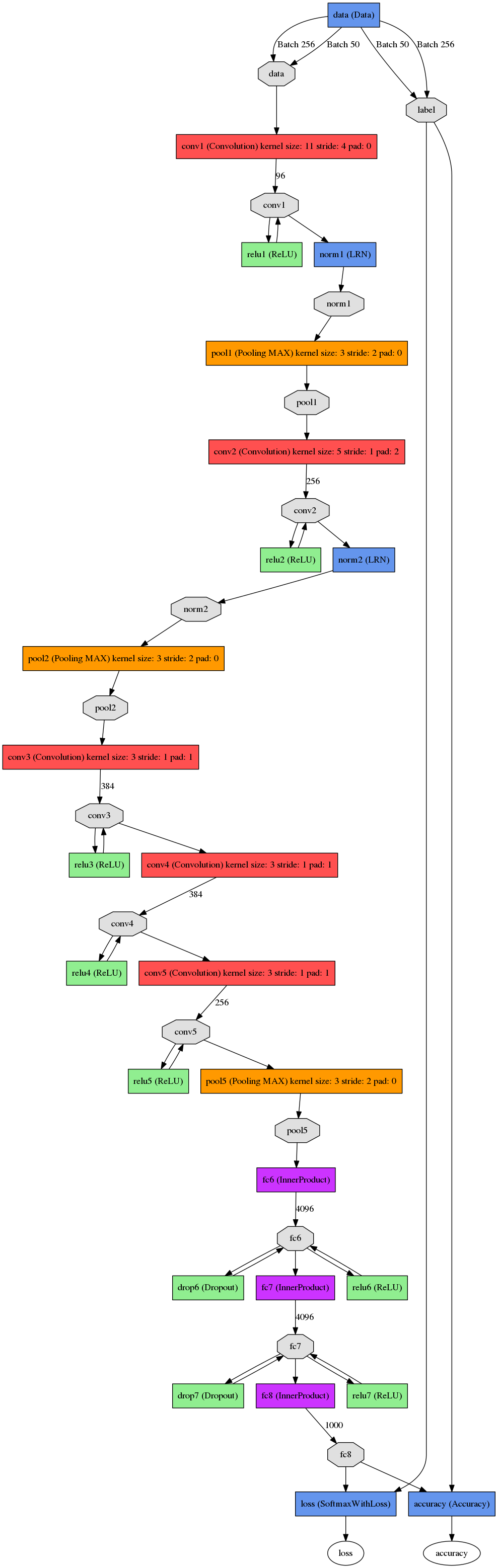

AlexNet:五层卷积,每层卷积层后面都有relu激活函数,第一二层后通过了LRN层和池化层,三层全连接网络,最终的输出层是1000通道的softmax。

文章中说该模型有5层卷积,去掉任意一层都会使结果不好。

在训练模型过程中,覆盖的池化层更不容易过拟合。

前两层全连接层使用了dropout。

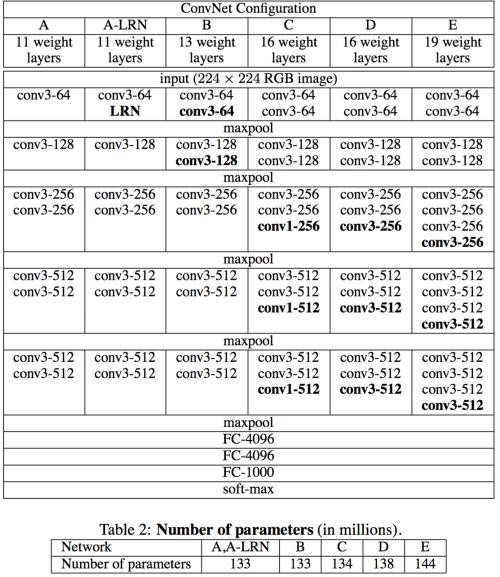

VGGNet:有VGG11,13,16,19,每个VGG网络都有3个FC层,5个池化层,1个softmax层,FC层中间有dropout(减小了神经元之间的相互依赖)。

使用了1*1的小卷积核(可以对输出通道数进行升维,降维,实现了跨通道的信息交互)。

使用小卷积核堆叠层大卷积核(2个3*3堆叠成一个5*5,3个3*3堆叠层7*7)。

如今用得最多的是VGG16(13层conv + 3层FC)和VGG19(16层conv + 3层FC),注意算层数时不算maxpool层和softmax

层,只算conv层和fc层。

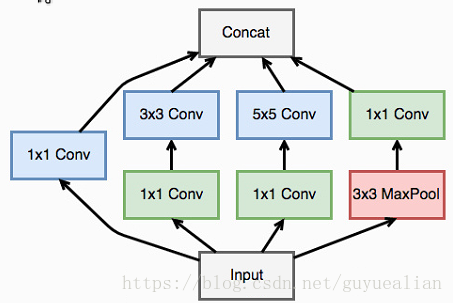

InceptionNet:Inception Module基本组成结构有四个成分。1*1卷积,3*3卷积,5*5卷积,3*3最大池化。最后对四个成分运算结果进行通道上组合。通过多个卷积核提取图像不同尺度的信息,最后进行融合,可以得到图像更好的表征。

Inception V2将所有的5*5变成2个3*3,而且提出来著名的Batch Normalization。

Inception V3把较大的二维卷积拆成了两个较小的一维卷积,加速运算、减少过拟合。

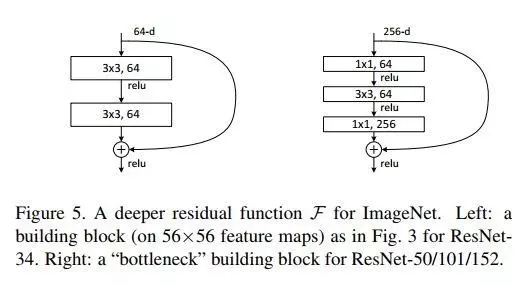

ResNet:残差学习单元在输入、输出之间建立了一条直接的关联通道,使得这一层神经网络学习的不是结果,而是输入与输出之间的残差。

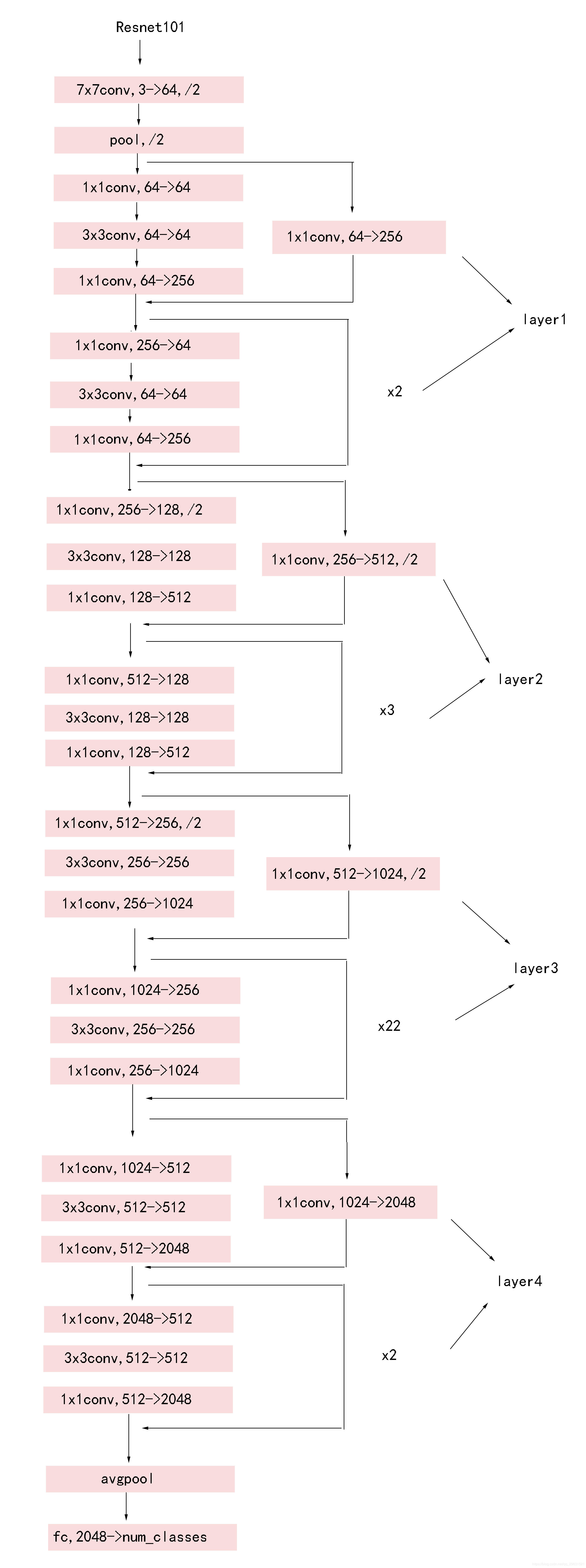

提出了一种bottleneck的结构块,通过使用1x1 conv来巧妙地缩减或扩张特征通道,从而使得我们的3x3 conv的filters数目不受外界即上一层输入的影响。

resnet101的网络结构:7x7conv,3->64,/2表示7x7大小的卷积核,3、64表示输入输出通道,/2表示输出为原来的1/2。 x2表示类似的结构还有两个。layer1-4对应代码里面的四层。

最后

以上就是幽默眼神最近收集整理的关于CNN经典网络模型概述的全部内容,更多相关CNN经典网络模型概述内容请搜索靠谱客的其他文章。

发表评论 取消回复