继今年1月份开源国内首个MoE(Mixture of Experts,专家混合)模型后,DeepSeek公司经过4个月的深入研究,于今日宣布开源其第二代MoE模型——DeepSeek-V2。这一模型在多个主流大模型评测榜单中表现卓越,尤其在中文综合能力(AlignBench)的开源模型中排名第一,与闭源模型如GPT-4-Turbo和文心4.0处于同一水平。(DeepSeek-V2体验入口见文末)

DeepSeek-V2的主要特点

- 性能卓越:DeepSeek-V2在主流模型评测榜单中表现突出,与闭源模型并驾齐驱。

- 创新模型结构:采用了MLA(Multi-head Latent Attention)架构,结合自研的Sparse结构DeepSeekMoE,显著减少了计算量和推理显存。

- 成本效益:每token成本大幅降低,输入吞吐量超过每秒10万tokens,输出超过每秒5万tokens。

- API定价:每百万tokens输入1元、输出2元,价格极具竞争力。

- 开源精神:DeepSeek-V2模型和相关论文完全开源,免费商用,无需申请。

- 模型权重获取:模型权重可在Hugging Face平台获取,技术报告发布在GitHub上。

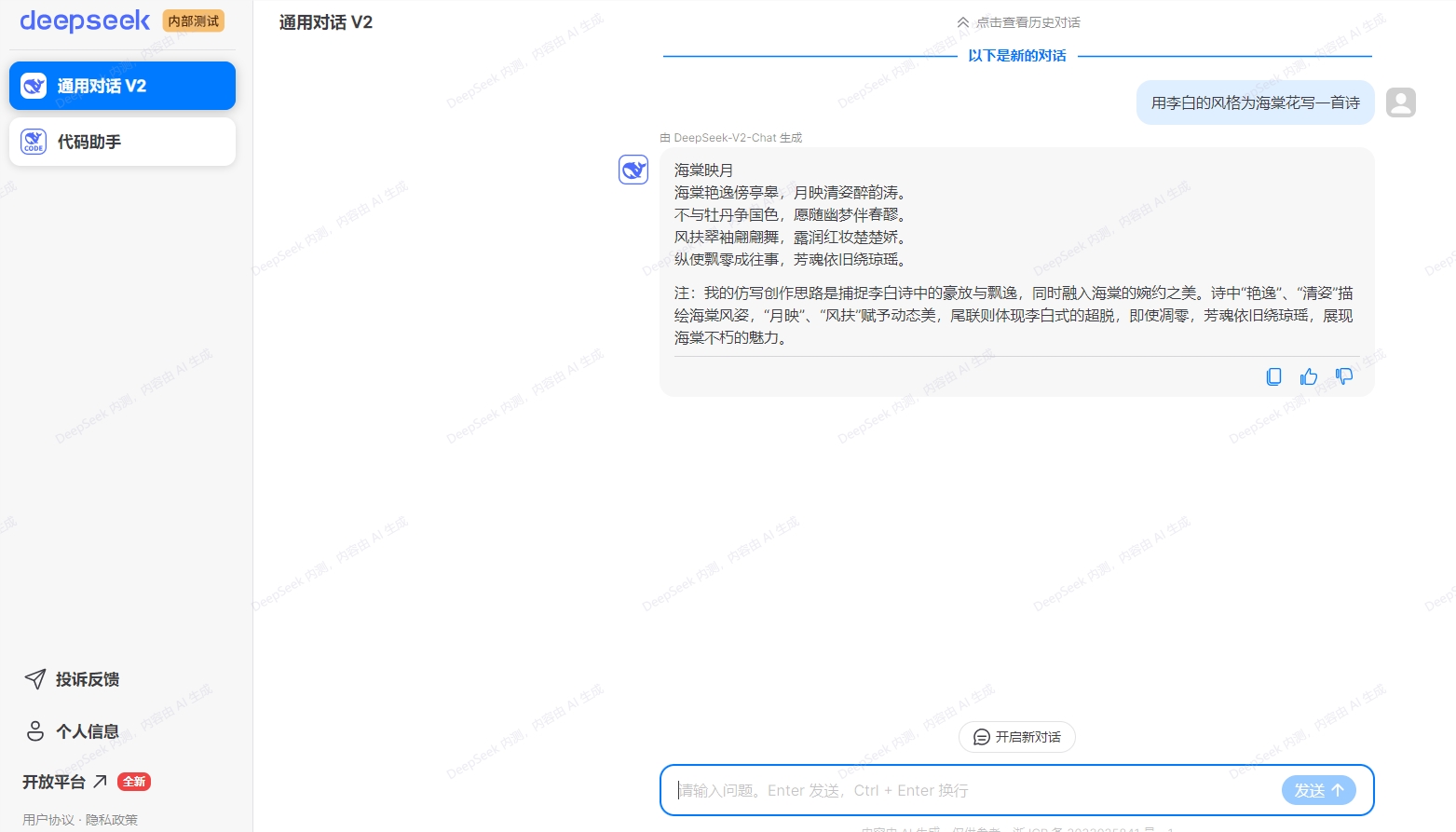

- 体验平台:DeepSeek提供了对话官网和开放平台,用户可以在deepseek免费开启对话。

DeepSeek-V2在英文综合能力(MT-Bench)方面也表现突出,与开源模型LLaMA3-70B并列第一梯队,超越了其他MoE开源模型。此外,在知识、数学、推理和编程等多个领域,DeepSeek-V2均取得了领先地位。该模型支持高达128K的上下文窗口,意味着能够处理更复杂的任务。

DeepSeek-V2采用了全新的模型结构,不同于主流的“类LLaMA的Dense结构”和“类Mistral的Sparse结构”。它引入了MLA(Multi-head Latent Attention)架构,该架构在减少计算量和推理显存方面有显著优势。结合自研的Sparse结构DeepSeekMoE,计算量被进一步降低,实现了模型性能的显著提升。

性能方面,DeepSeek-V2拥有236B的总参数和21B的激活量,其能力可与70B至110B的Dense模型相媲美,但显存消耗仅为同级别Dense模型的1/5至1/100,每token成本大幅降低。在8卡H800机器上的实际部署测试中,输入吞吐量超过每秒10万tokens,输出超过每秒5万tokens。

DeepSeek-V2的API定价极具竞争力,每百万tokens输入1元、输出2元(32K上下文),仅为GPT-4-Turbo价格的近百分之一。此外,DeepSeek-V2模型和相关论文已完全开源,免费商用,无需申请,模型权重可在Hugging Face平台获取,技术报告则发布在GitHub上。

微信扫码打赏作者

(举报)

发表评论取消回复