声明:本文来自于微信公众号 量子位(QbitAI),作者:金磊,授权靠谱客转载发布。

人类离电影《黑客帝国》的场景,似乎又近了一步。

因为就在刚刚,一个与电影同名的、首个AI基础世界模拟器——The Matrix问世。

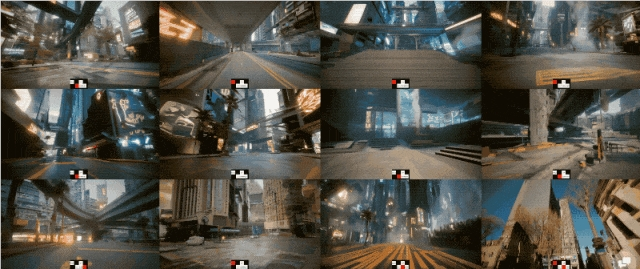

它已经可以实现生成无限长、高保真720p真实场景视频,而且还是可以实时交互的那种!

话不多说,直接来看一个长达14分钟的效果:

而这个时长还只是demo展示的长度,The Matrix可以做到在长达1个小时的时间里,穿梭沙漠、草原、水体和城市等景观。

在此期间,还可以通过按键W(前)、S(后)、A(左)和D(右)来实时控制——

每秒16帧,帧帧可控。

The Matrix项目是由全华人团队打造,作者分别来自阿里巴巴、香港大学、滑铁卢大学和加拿大AI研究机构Vector Insititute。

而之所以团队将研究取名为The Matrix,是因为其效果和内容与电影《黑客帝国》中的一句话类似:

这是你熟悉的世界;这是20世纪末的世界。它现在只存在于我们称之为Matrix的神经交互模拟系统中。

This is the world that you know; the world as it was at the end of the20th century. It exists now only as part of a neural-interactive simulation that we call the Matrix.

网友们看罢,评论区已经一片“crazy”、“amazing”的声音:

但除了无限生成、效果逼真和实时可控之外,The Matrix还解锁了一项能力。

零样本,就可以直接泛化

The Matrix的训练数据主要由两部分组成。

首先是通过像《极限竞速:地平线》和《赛博朋克2077》这样的3A游戏的监督数据来进行训练;其次再辅以大量的现实世界场景(如东京街头)的无监督视频。

而与以往研究不同的是,The Matrix可以在没有上述数据学习的情况下(零样本),可以理解和预测不同环境中物体的行为和交互。

例如下面这个“宝马X3在办公环境中行驶”的场景,这是在游戏数据和现实世界数据中都未出现过的环境:

再如“车在水里游泳”:

The Matrix还支持以第一视角的方式来看世界:

就连真实世界中的物体,甚至人物,都是可控的:

从实验结果上来看,与近期主流的游戏仿真生成模型比较,不论是时长还是效果等,The Matrix都已经达到了领先的效果:

怎么做到的?

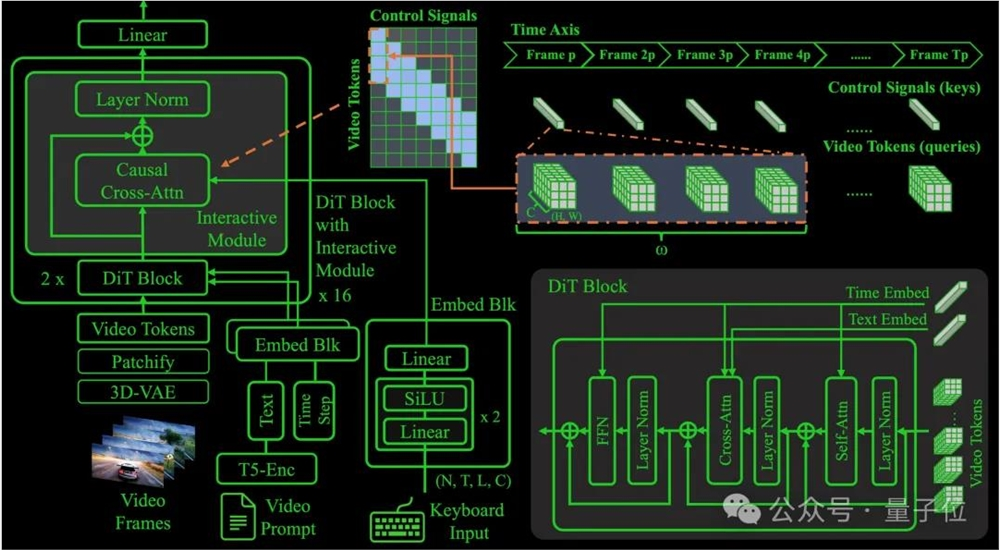

从技术角度来看,The Matrix的核心由三大模块组成。

首先是交互模块(Interactive Module)。

这个模块用于理解用户的输入(如键盘输入)并将其整合到视频生成中,实现帧级别的精确控制。

为了增强模型的交互性,研究人员对一个预训练的 Diffusion Transformer (DiT) 模型进行调优,使得交互模块不仅能够应对已知数据,还能泛化到无标签的数据。

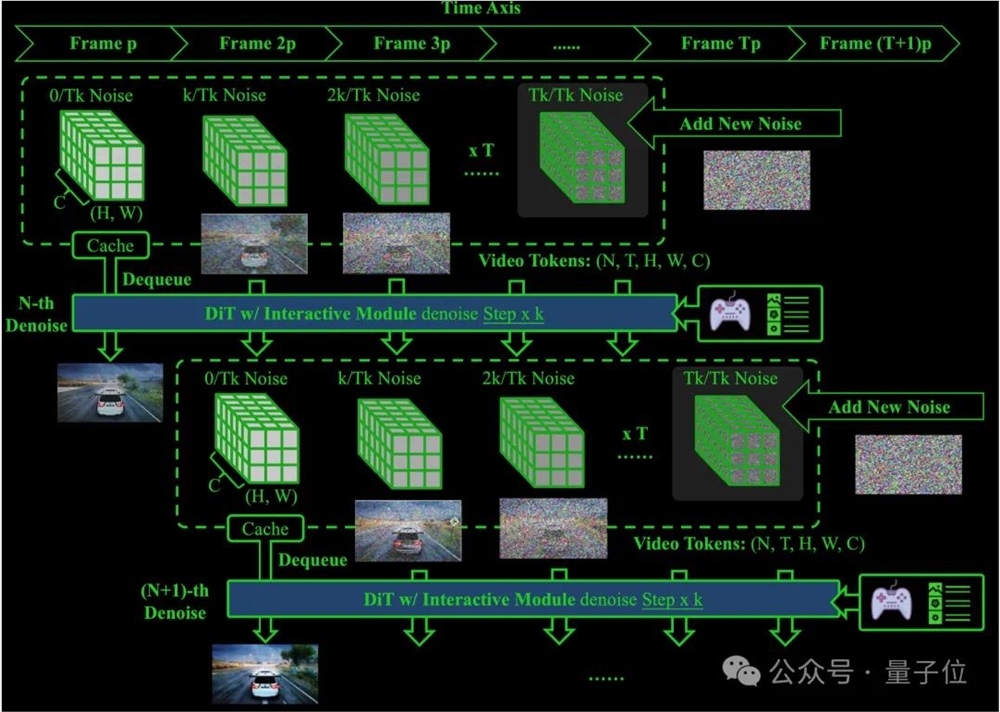

其次是移窗去噪过程模型(Shift-Window Denoising Process Model, Swin-DPM)。

这个新颖的扩散模型通过使用滑动的时间窗口来处理长时间依赖关系,从而实现无限长视频的生成。

该模型能够以连续、平滑的方式生成视频,解决了传统模型在长序列生成时遇到的记忆瓶颈。

最后是流一致性模型(Stream Consistency Model, SCM)。

为了实现实时生成,The Matrix 集成了一种名为流一致性模型的技术,使得推理速度加快10-20倍,最终实现8-16FPS 的实时生成速度。

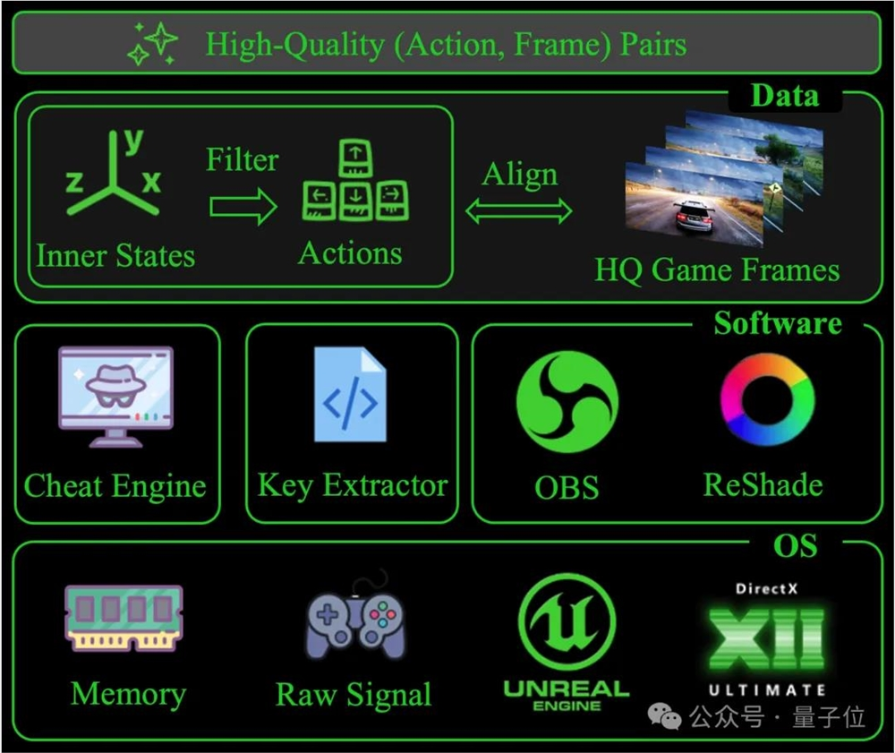

此外,研究人员还开发了一个名为GameData的平台,用于自动捕获游戏中的状态数据和视频帧,并生成标注的动作帧数据集。

这个数据集结合了真实世界的视频数据,既帮助模型学习具体动作控制,又增强了模型的视觉质量和域泛化能力。

团队介绍

正如我们刚才提到的,The Matrix的作者均为华人。

其中,项目负责人主要是两位,分别是Hongyang Zhang和Ruili Feng。

Hongyang Zhang目前是滑铁卢大学的助理教授,带领SafeAI Lab;其主要研究方向包括基础模型的研究。

另一位则是来自阿里巴巴的Ruili Feng。

若是大家对研究感兴趣,可戳下方链接查看详情。

参考链接:

[1]https://thematrix1999.github.io/

[2]https://thematrix1999.github.io/article/the_matrix.pdf

[3]https://x.com/hongyangzh/status/1859288829825515810

[4]https://x.com/SmokeAwayyy/status/1859369842647892325

—完—

(举报)

发表评论取消回复