声明:本文来自于微信公众号AIGC开放社区,授权靠谱客转载发布。

今天凌晨,OpenAI发布了全新扩散模型方法sCM,仅需2步就能生成高质量图片、3D模型等实现50倍时钟加速,尤其是在高分辨率任务上相当出色。

例如,通过sCM训练了一个15亿参数的模型,在单个A100GPU上无需任何推理优化0.11秒内就能生成内容。

目前,扩散模型生成图片最快的是Stability AI开源的SD快速版本,4步就能生成高质量图片。而Scm在保证质量的前提下又将推理效率提升了1倍,同时简化了连续时间一致性模型的理论公式,允许模型在更大数据集上进行稳定的训练和扩展。

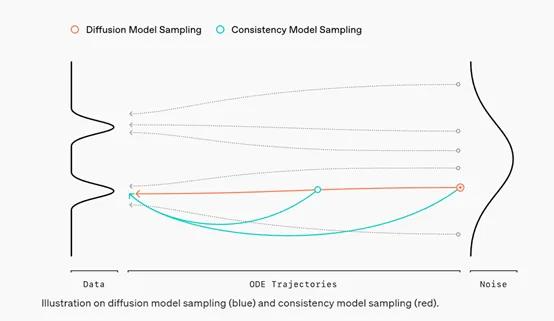

sCM的核心原理是基于一致性模型思路,通过直接将噪声转换为无噪声样本来生成数据。在传统扩散模型中,数据生成过程被视作一条从噪声到数据的渐进路径,每一步都通过去噪来逐渐恢复数据的清晰度。

一致性模型则恰恰相反,可找到一条更直接的路径,在单步或少数几步内直接从噪声状态跳跃到数据状态。

sCM采用了连续时间框架,使得模型在理论上可以在连续的时间轴上进行操作,从而避免了离散时间模型中的离散化误差。在连续时间于一致性模型中,模型的参数化、扩散过程和训练目标都被重新定义,以适应连续时间的设置。

例如,模型的参数化不再依赖于离散的时间步,而是直接依赖于时间本身。这种连续时间的参数化方式使得模型能够更精确地捕捉数据生成过程中的动态变化。

在网络架构方面,sCM引入了改进的时间条件、自适应组归一化、新的激活函数和自适应权重,以提高模型的训练稳定性和生成质量。改进的时间条件使得模型能够更准确地感知时间t的变化,从而在生成过程中做出更合理的决策。

自适应组归一化则有助于模型在训练过程中保持内部特征的稳定性,减少训练过程中的噪声干扰。新的激活函数被引入以增强模型的非线性表达能力,使得模型能够更好地学习复杂的数据分布。

而自适应权重的引入允许模型根据训练数据的分布动态调整损失函数中的权重,从而减少了不同时间步长之间的损失方差。

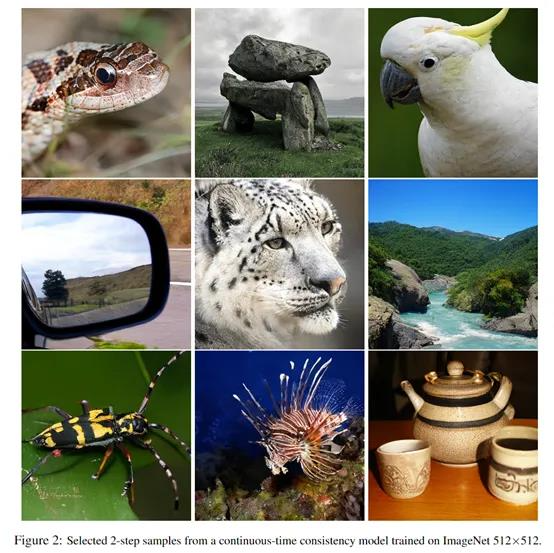

为了评估sCM的性能,研究人员在CIFAR-10、ImageNet64×64和ImageNet512×512多个数据集上进行了综合评测。结果显示,sCM成为目前最高效的扩散生成方法。

例如,在ImageNet512×512数据集上,sCM的模型达到了1.88FID,同时使用的算力更少、更高效。

有网友表示,如果把这个方法用在视频领域,那实时视频可能很快会到来。Sora的推理负担也会降低很多。

很高兴又看到OpenAI分享技术论文了。

如果把这个技术用在Sora,它应该快公测了吧?

这种简化的模型非常适合需要快速结果而不影响质量的应用!

这个模型相当有前途啊。

2步就能生成内容,这会再一次改变游戏规则啊。

把这个技术用在Sora,应该就快来了吧?

目前,OpenAI已经分享了该论文方法,是由两位华人提出来的。

论文地址:https://arxiv.org/abs/2410.11081

(举报)

发表评论取消回复