声明:本文来自于微信公众号 AIGC开放社区,作者:AIGC开放社区,授权靠谱客转载发布。

当Geoff Hinton听到获得诺贝尔物理奖时,自己都很惊讶一脸懵逼,你就知道这个争议有多大了。

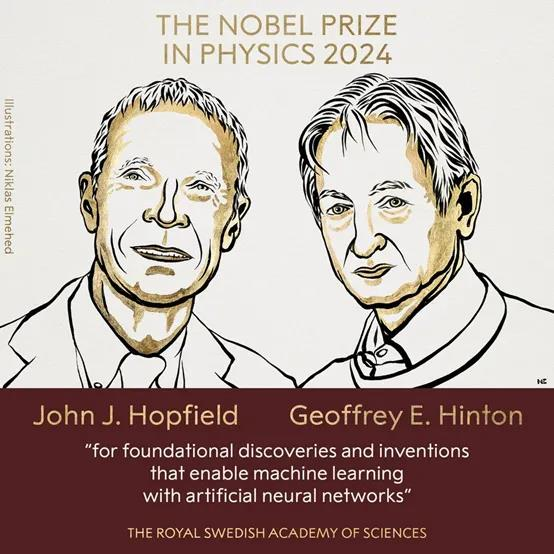

瑞典皇家科学院宣布2024年物理奖颁给了,两位AI先驱Geoff Hinton和John Hopfield。两位提出的Hopfield网络、玻尔兹曼机器、神经网络、深度学习、反向传播算法、模仿人类大脑等技术概念。

这为后来开发出ChatGPT、Midjourney、Sora、Runway等现象级生成式AI产品奠定了重要技术基础,但把这些成就与物理联系在一起难免有点牵强啊,那物理学家直接转行研究AI得了。

不过有一点可以确定,由生成式AI引发的第二次AI革命正在席卷全球各行业,加上这次的诺奖背书,其影响力将呈指数级爆炸增长。

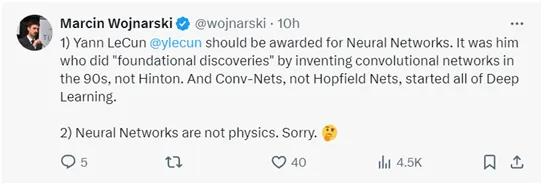

与往年的多数崇拜评论相比,今年的网友是格外不同。

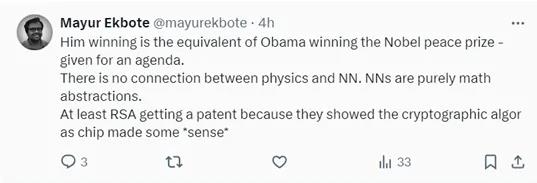

他俩的获奖相当于Obama获得了诺贝尔和平奖,是因为某种议程而颁发的。物理学和神经网络之间没有任何联系。神经网络纯粹是数学抽象。如果说还有点意义的话,至少 RSA 获得专利因为他们将加密算法展示为芯片。

是ChatGPT做出来的决定吗?

难道诺奖委员会被AI劫持了?

比较好奇,他们获奖的技术与物理有何关系呢?

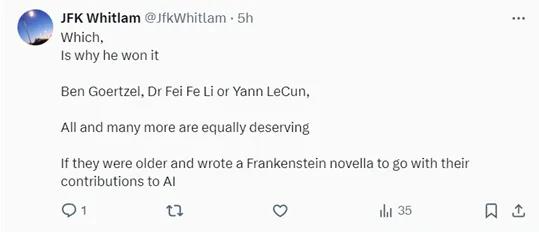

如果他们都能获奖,那Ben Goertzel、李飞飞、Yann LeCun也没问题啊。只要年纪大一点,然后写一部科幻AI小说配合一下绝对没问题的。

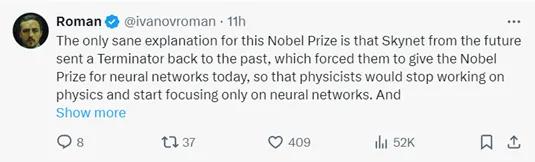

两位AI研究人员获得物理诺贝尔,唯一能解释清楚的理由是,来自未来的天网派了终结者回到过去,迫使瑞典皇家科学院将物理诺贝尔颁发给神经网络研究人员,这样物理学家就会停止研究物理,转而专注于神经网络。正是这些来自不久将来的研究导致了 AGI 的诞生。

神经网络的物理原理是什么呢?

不敢想物理学家现在有多么的痛苦。

根据目前AI发展现状,诺贝尔文学奖也能拿了吧。

诺贝尔文学奖也给他们发一下吧。

发明卷积神经网络的Yann LeCun贡献也非常大,他也能拿诺贝尔物理学奖啊。讲真,神经网络真的不是物理学啊。

实在不行,诺贝尔加一个计算机类别奖项吧。

Geoff作为AI教父,拿下图灵和诺贝尔物理两个重要大奖排面还是拉满。他最得意的学生之一,前OpenAI首席科学家Ilya Sutskever第一时间祝福了他的老师。

AI泰斗吴恩达也送上了祝福,非常开心看到Geoff Hinton和John Hopfield一起为AI获得了物理诺贝尔奖。

“AI之母”李飞飞也送上了祝福,如今AI的影响力真的太大了。

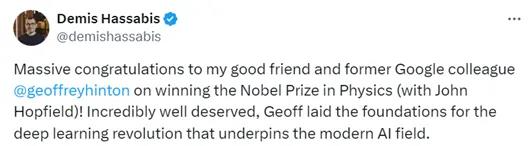

谷歌DeepMind联合创始人兼CEO,为Geoff Hinton送上了祝福,当之无愧的现代AI教父。

根据瑞典皇家科学院官网的信息,他们认为Geoff Hinton和John Hopfield获得物理学奖主要有以下理由:

相信,许多人都体验过计算机如何进行语言翻译、使用AI生成内容或进行多轮对话,其实这类技术经过15—20年的基础研究才有了如今的成果,它们基于的技术是——人工神经网络。

尽管计算机不能思考,但现在机器可以模仿记忆和学习等函数。今年的物理学奖得主Geoff Hinton和John Hopfield帮助实现了这一点。他们使用物理学的基本概念和方法,开发了利用网络结构处理信息的技术。

机器学习与传统软件不同,传统软件的工作原理类似于食谱。软件接收数据,根据清晰的描述进行处理并产生结果,就像有人收集食材并按照食谱加工,制作出蛋糕一样。

机器学习则不同,计算机通过示例学习,使其能够处理过于模糊和复杂而无法通过逐步指令管理的问题。一个例子是对图片进行解释以识别其中的物体。

人工神经网络使用整个网络结构处理信息。最初的灵感来自于想要了解大脑的工作原理。在20世纪40年代,研究人员开始推理大脑的神经元和突触网络背后的数学原理。心理学领域也提供了线索,这要归功于神经科学家唐纳德·赫布关于学习发生的假设,即当神经元一起工作时,它们之间的连接会得到加强。

后来,这些想法被用来尝试通过构建计算机模拟的人工神经网络来重现大脑网络的功能。在这些网络中,大脑的神经元被赋予不同值的节点所模仿,突触由节点之间的连接所代表,这些连接可以变得更强或更弱。唐纳德·赫布的假设仍然被用作通过称为训练的过程更新人工网络的基本规则之一。

在20世纪60年代末,一些令人沮丧的理论结果导致许多研究人员怀疑这些神经网络将永远不会有任何实际用途。但在1980年代,随着包括今年得主的工作在内的几个重要想法的出现,对人工神经网络的兴趣重新被唤醒。

1982年Hopfield发现的联想记忆,Hopfield网络可以存储模式,并有一种重建它们的方法。当网络被给出一个不完整或稍微失真的模式时,该方法可以找到最相似的存储模式,当神经元一起作用时,它们可以产生新的强大特性。

1985年,Hinton以Hopfield网络为基础,发明了一种使用不同方法的新网络——玻尔兹曼机器。

其结构由一组对称连接的神经元组成,可以分为可见层和隐藏层。每个神经元的状态通过一种称为“吉布斯采样”的技术进行更新,网络通过不断调整权重来最小化能量函数,以更好地表达输入数据的统计特性。

这种机器的核心目标是通过降低网络能量来逼近训练数据的分布,适用于联想记忆、模式识别和优化问题。

玻尔兹曼机器可以学习不是自指令,而是来自给出的例子。它通过更新网络连接中的值进行训练,以便在训练时输入到可见节点的示例模式在机器运行时发生的可能性尽可能高。如果同一个模式在训练过程中重复了几次,这个模式的概率就更高。训练也会影响输出与训练材料相似的新模式的概率。

例如,你遇到了一个朋友的兄弟姐妹,你可以立即看出他们一定是有关联的。类似地,玻尔兹曼机器可以识别一个全新的示例,如果它属于训练材料中找到的类别,并将其与不相似的材料区分开来(这与目前火爆AI圈的Transformer架构类似)。

由于Hinton和Hopfield发现的AI概念,为现在的AI发展、深度学习、机器学习奠定了重要技术基础。如今我们所看到的发展得益于能够获取大量可用于训练网络的数据,以及计算能力的巨大提升。目前的人工神经网络非常庞大由许多层构成,已经演变成深度神经网络,其训练方式被称为深度学习。

(举报)

发表评论取消回复