hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,可以将sql语句转换为MapReduce任务进行运行。 其优点是可以通过类SQL语句快速实现简单的MapReduce统计。

安装hive

1. 下载并解压hive源程序

Hive下载地址

$ sudo tar -zxvf ~/Downloads/apache-hive-1.2.2-bin.tar.gz -C /usr/local # 解压到/usr/local中

$ cd /usr/local/

$ sudo mv apache-hive-1.2.2-bin hive # 将文件夹名改为hive

$ sudo chown -R hadoop:hadoop hive # 修改文件权限

2. 配置环境变量

把hive命令加入到环境变量中:vim ~/.bashrc

export HIVE_HOME=/usr/local/hive

export PATH=$PATH:$HIVE_HOME/bin

使配置生效:source ~/.bashrc

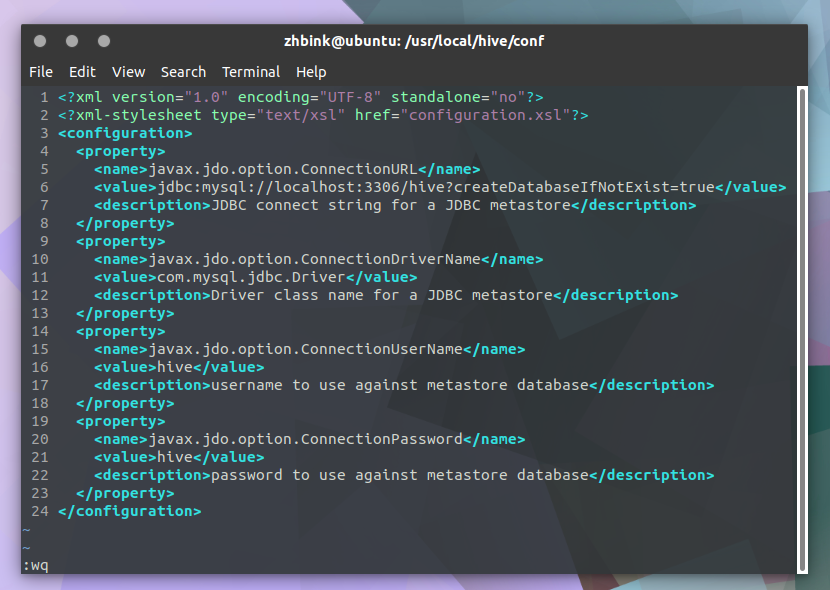

3. 修改/usr/local/hive/conf下的hive-site.xml

$ cd /usr/local/hive/conf

$ mv hive-default.xml.template hive-default.xml

$ vim hive-site.xml

hive-site.xml配置:

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>hive</value>

<description>password to use against metastore database</description>

</property>

</configuration>

安装并配置mysql

Hive使用mysql作为底层的数据库。默认已经为Ubuntu系统安装好了Mysql。

1.安装mysql-connetctor以连接hive。下载地址中找到previous GA versions中的tar包,下载mysql-connector-java-5.1.47.tar。

tar -zxvf mysql-connector-java-5.1.47.tar.gz #解压

cp mysql-connector-java-5.1.47/mysql-connector-java-5.1.47-bin.jar /usr/local/hive/lib #将mysql-connector-java-5.1.47-bin.jar拷贝到/usr/local/hive/lib目录下

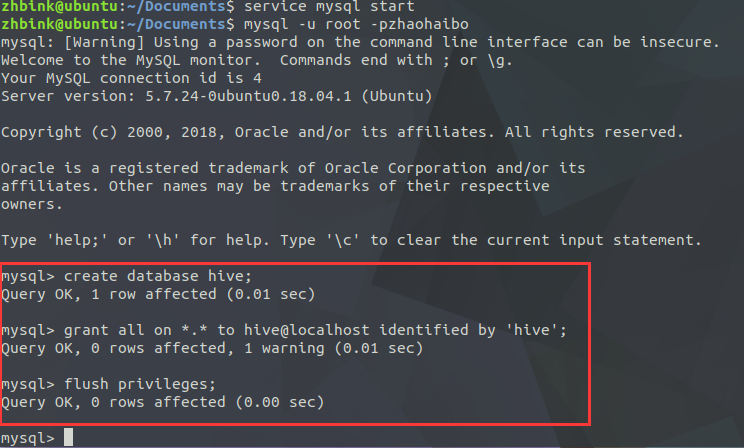

2.启动并登陆mysql shell

$ service mysql start #启动mysql服务

$ mysql -u root -p #登陆shell界面

3. 新建hive数据库。

mysql> create database hive; #这个hive数据库与hive-site.xml中localhost:3306/hive的hive对应,用来保存hive元数据

4. 配置mysql允许hive接入:

mysql> grant all on *.* to hive@localhost identified by 'hive'; #将所有数据库的所有表的所有权限赋给hive用户,后面的hive是配置hive-site.xml中配置的连接密码

mysql> flush privileges; #刷新mysql系统权限关系表

启动hive

启动hive之前,请先启动hadoop集群。

$ start-all.sh #启动hadoop

$ hive #启动hive

最后

以上就是故意花瓣最近收集整理的关于Ubutu18.04.1 LTS 安装Hive的全部内容,更多相关Ubutu18.04.1内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复