(前提须知:)

1 安装模式介绍

根据hive记录元数据的不同,分为:

1、内嵌模式(元数据保村在内嵌的derby种,允许一个会话链接,尝试多个会话链接时会报错)

2、本地模式(本地安装mysql 替代derby存储元数据)

3、远程模式(远程安装mysql 替代derby存储元数据)

2 安装环境说明,基于hadoop 已经按照完成后的环境进行安装。

我们进行第二类模式安装

模式23区别:URL路径区别

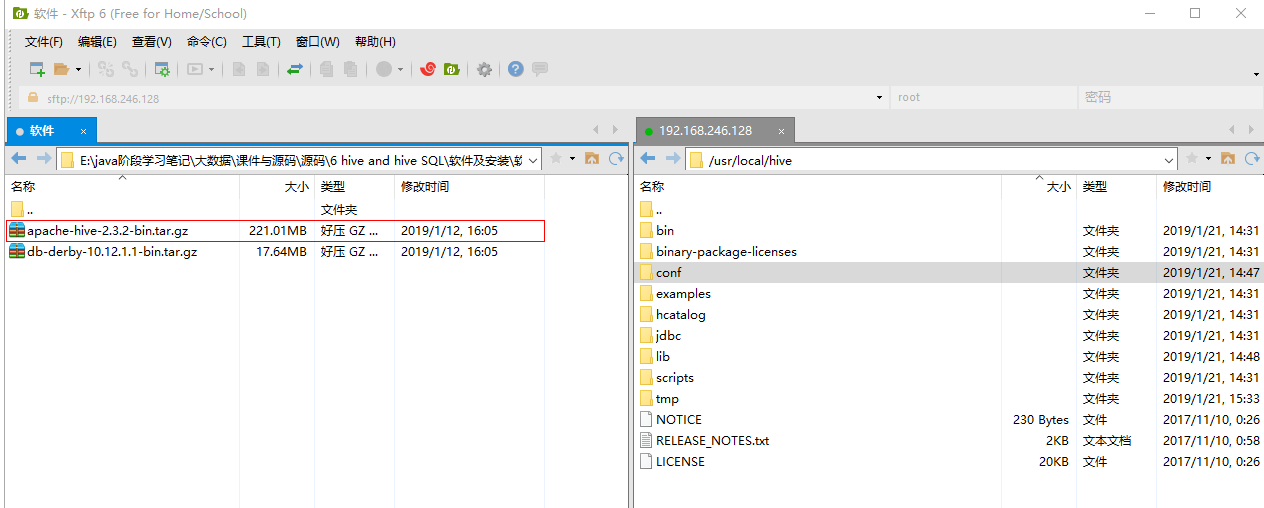

第一步:上传hive的可执行压缩包,并解压到/usr/local/hive下面

第二步:启动Hadoop服务

命令:Start-all-sh(懒人模式)

或者:

命令1:/usr/local/hadoop/sbin/start-dfs.sh

+

命令2:/usr/local/hadoop/sbin/start-yarn.sh

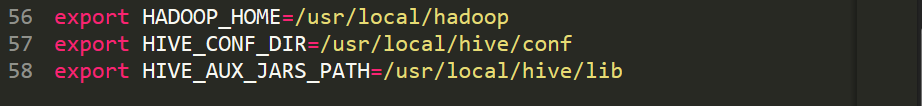

第三步:修改配置文件(一)

从/usr/local/hive/conf中下载所需的hive-env.sh.template并重命名为hive-env.sh文件;

*xftp 可以反向传输修改后再上传

结尾处添加:

export HADOOP_HOME=/usr/local/hadoop

export HIVE_CONF_DIR=/usr/local/hive/conf

export HIVE_AUX_JARS_PATH=/usr/local/hive/lib

重新上传

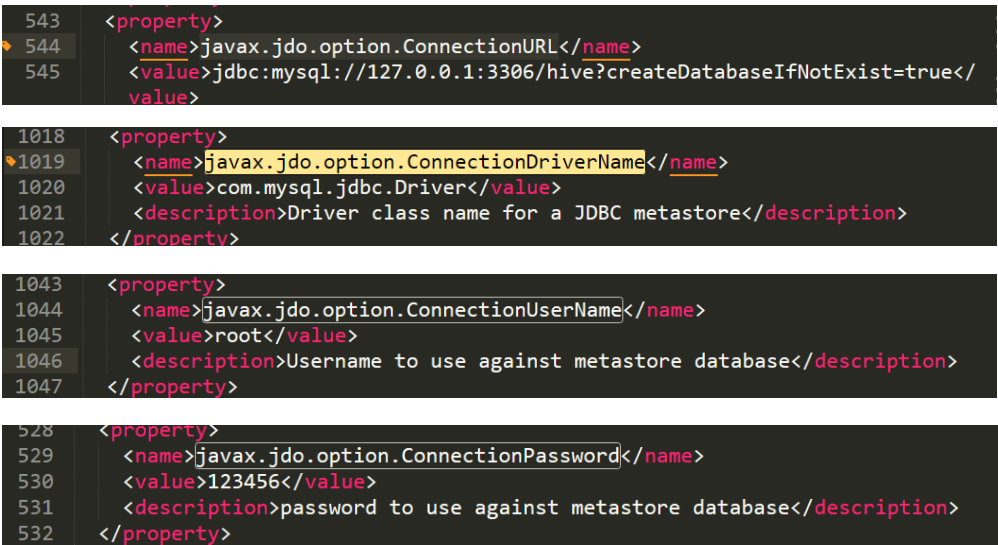

修改配置文件(二);

从/usr/local/hive/conf中下载所需的hive-default.xml.template并重命名为hive-site.xml文件;

例如:

注意IP

最终结果:IP=127.0.0.1

先不进行上传文件

第四步:进行相关文件夹配置

命令如下:

/usr/local/hadoop/bin/hadoop fs -mkdir -p /user/hive/warehouse

/usr/local/hadoop/bin/hadoop fs -mkdir -p /user/hive/tmp

/usr/local/hadoop/bin/hadoop fs -mkdir -p /user/hive/log

//新建文件夹

/usr/local/hadoop/bin/hadoop fs -chmod -R 777 /user/hive/warehouse

/usr/local/hadoop/bin/hadoop fs -chmod -R 777 /user/hive/tmp

/usr/local/hadoop/bin/hadoop fs -chmod -R 777 /user/hive/log

//修改权限

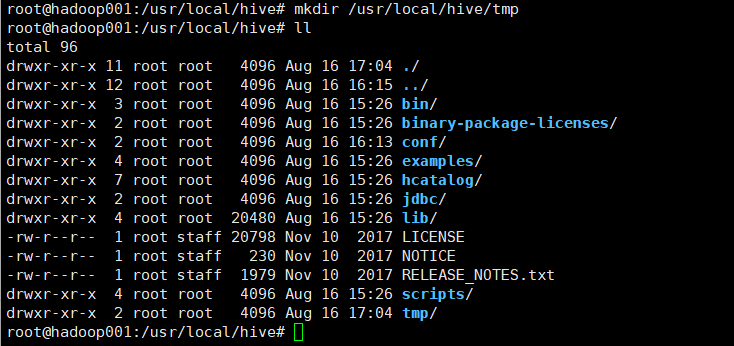

第五步:进行临时目录配置

创建临时IO文件夹:mkdir /usr/local/hive/tmp

转回第三步:修改配置文件(三);

然后替换 hive-site.xml 里面全部关于system:java.io.tmpdir,全部替换为,上述目录;

就是${system:java.io.tmpdir} 替换为 /usr/local/hive/tmp

上传文件

第六步:初始化

(一)需要上传mysql.jar包到 hive的lib目录下;

注意:此时,mysql 及hadoop需要在启动状态。

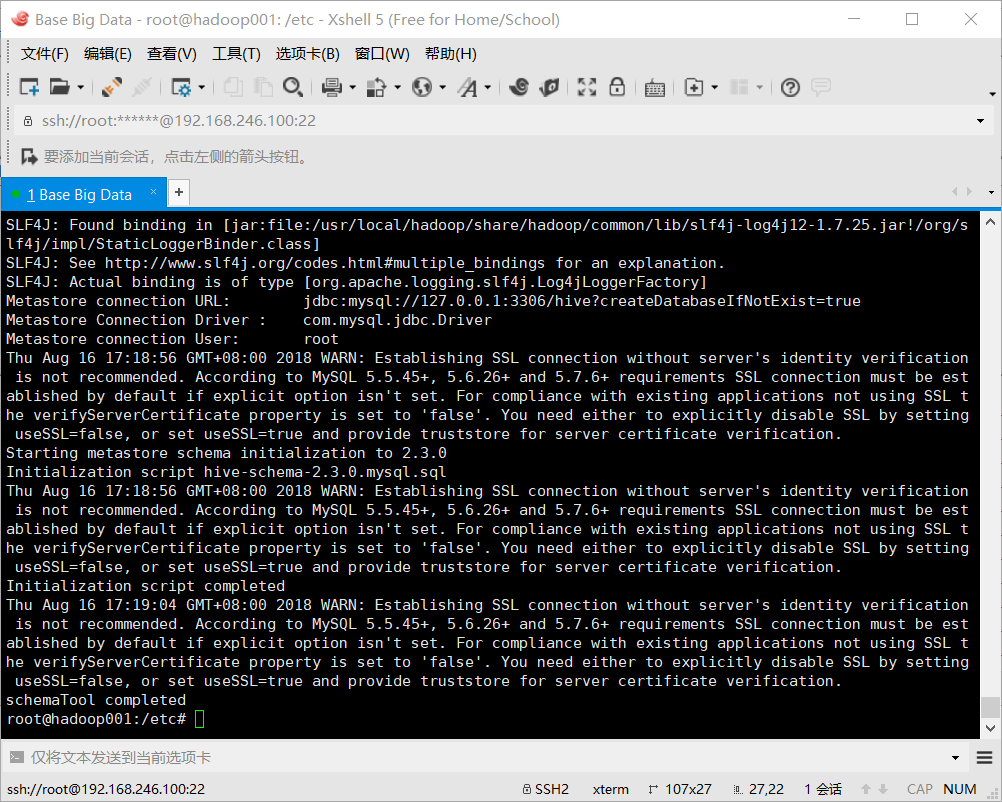

启动命令为:/usr/local/hive/bin/schematool -initSchema -dbType mysql

效果成功图:

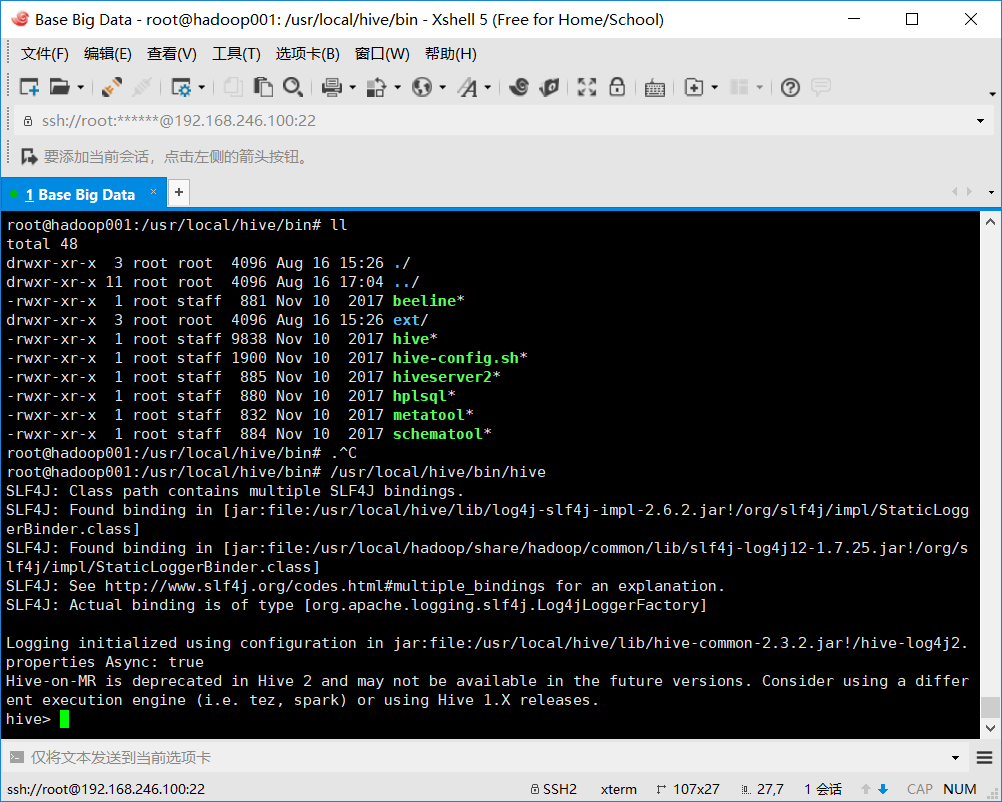

第七步:运行测试

命令:/usr/local/hive/bin/hive

运行效果:成功进入shell

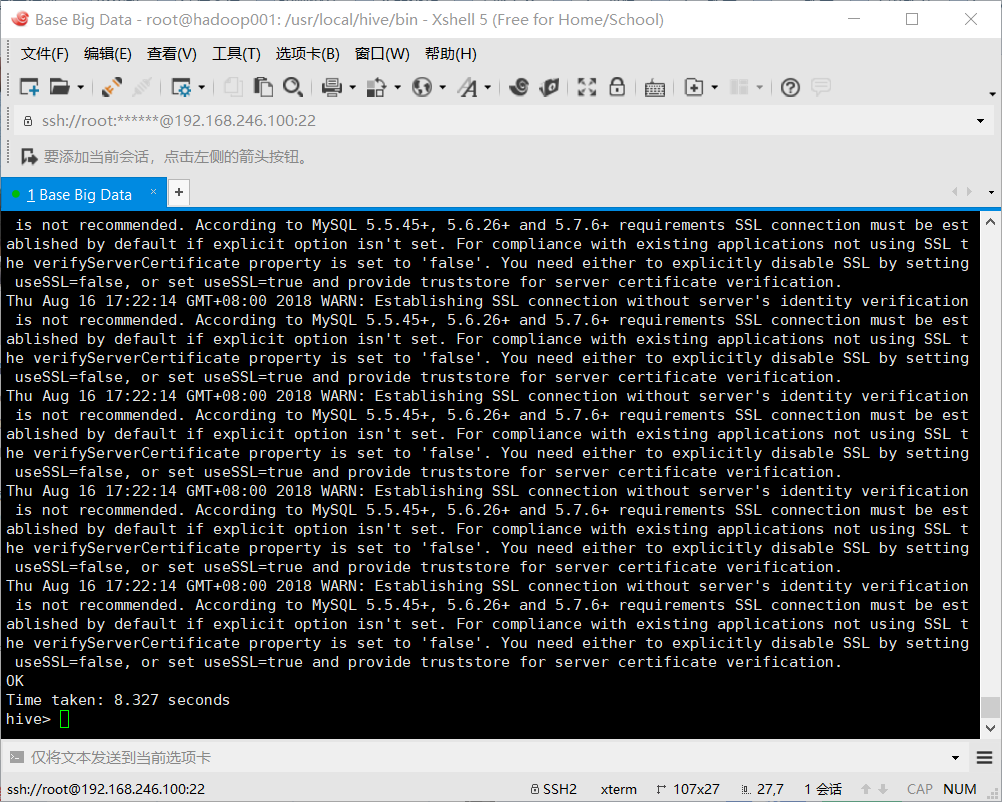

执行创建语句进行测试:如:CREATE TABLE t1(id int);

创建完成,配置完成;

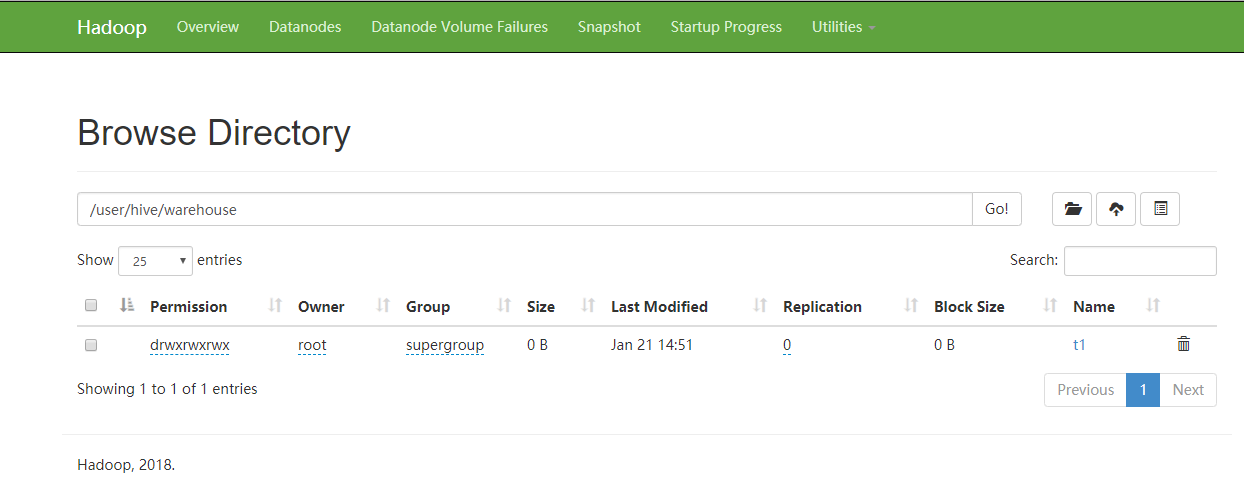

进入HDFS:检查创建的文件;

Congratulation!

最后

以上就是心灵美铅笔最近收集整理的关于(Ubuntu 16.04.2)基于Hadoop 中 hive 安装配置的全部内容,更多相关(Ubuntu内容请搜索靠谱客的其他文章。

发表评论 取消回复