似然函数:在已经抽到这一组样本X的条件下,估计参数θ的值,θ代表指定的分布参数。

最大似然估计可看作是一个反推,通常根据已知条件推算结果,而最大似然估计是已知结果,然后寻求使该结果出现的可能性最大的条件,以此作为估计值。

极大似然估计,概率论在统计学的应用,参数估计的方法之一。已知某个随机样本满足某种概率分布(即已知样本符合某种分布),但具体参数不清楚,参数估计就是通过若干次试验,观察其结果,利用结果推出参数的大概值。最大似然估计是建立在这样的思想上:已知某个参数能使这个样本出现的概率最大,把这个参数作为估计的真实值。

求最大似然函数估计值的一般步骤:

(1)写出似然函数;

(2)对似然函数取对数,并整理;

(3)求导数,令导数为0,得到似然方程;

(4)解似然方程,得到的参数即为所求;

EM算法:样本的分布未知,相比似然函数多了一个位置参数。

期望最大算法是一种从不完全数据或有数据丢失的数据集(存在隐含变量)中求解概率模型参数的最大似然估计方法。

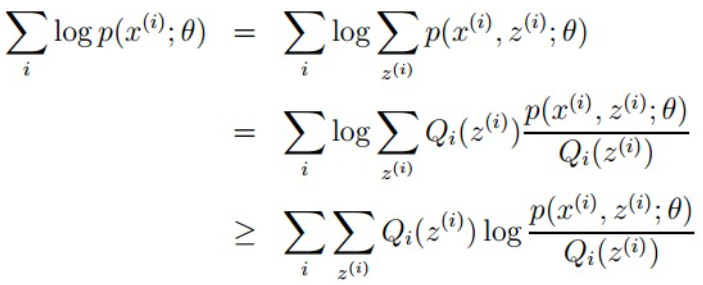

θ代表分布参数,z是可能的分布,Q为z的概率密度函数

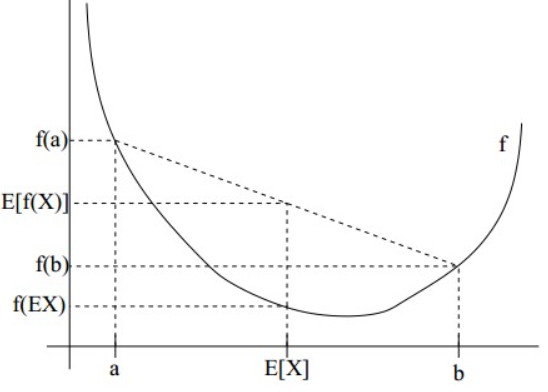

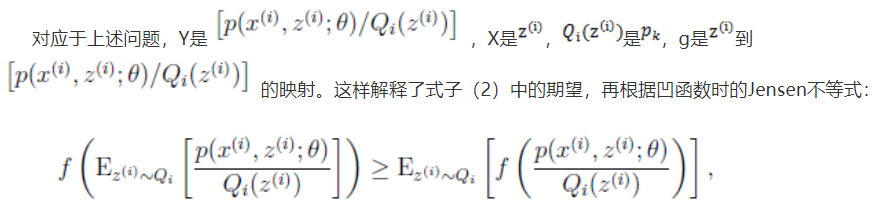

Jensen不等式:设f是定义域为实数的函数,如果对于所有的实数x,f(x)的二次导数大于等于0,那么f是凸函数。当x是向量时,如果其hessian矩阵H是半正定的,那么f是凸函数。如果只大于0,不等于0,那么称f是严格凸函数。

如果f是凸函数,X是随机变量,那么:E[f(X)]>=f(E[X])

如果f是严格凸函数,当且仅当X是常量时,上式取等号。

Jensen不等式应用于凹函数时,不等号方向反向。

log函数的二阶导小于0,为凹函数。

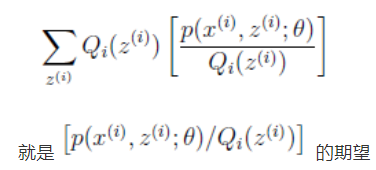

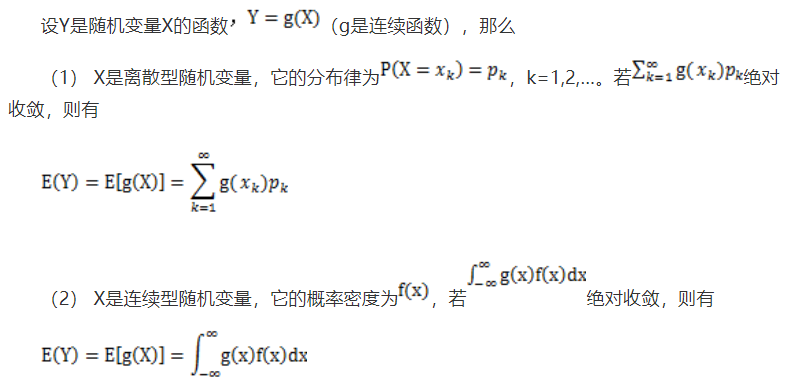

此处较难理解,根据如下

此处较难理解,根据如下

Lazy Statistician规则

K-Means中的EM思想:

目的是将样本分成k个类,就是求每个样例x的隐含类别y,利用隐含类别将x归类。由于事先不知道类别y,对每个样例假定一个y,使用样本的极大似然估计度量,这里就是x和y的联合分布P(x,y)。如果找到的y能够使P(x,y)最大,那么y就是样例x的最佳类别了,x顺手就聚类了。

E步就是估计隐含类别y的期望值,M步调整其他参数使得在给定类别y的情况下,极大似然估计P(x,y)能够达到极大值。在其他参数确定的情况下,重新估计y,直至收敛。

参考:

https://blog.csdn.net/zouxy09/article/details/8537620

https://www.cnblogs.com/jerrylead/archive/2011/04/06/2006924.html(EM推导)

https://www.cnblogs.com/jerrylead/archive/2011/04/06/2006910.html

最后

以上就是淡淡吐司最近收集整理的关于最大似然与EM算法理解的全部内容,更多相关最大似然与EM算法理解内容请搜索靠谱客的其他文章。

发表评论 取消回复