简介:近日,阿里云推出了弹性加速计算实例(EAIS)家族及产品弹性加速推理实例(简称EAIS.EI),首次实现了GPU与CPU/内存的解耦,可在提升AI推理效率的同时大幅降低成本。

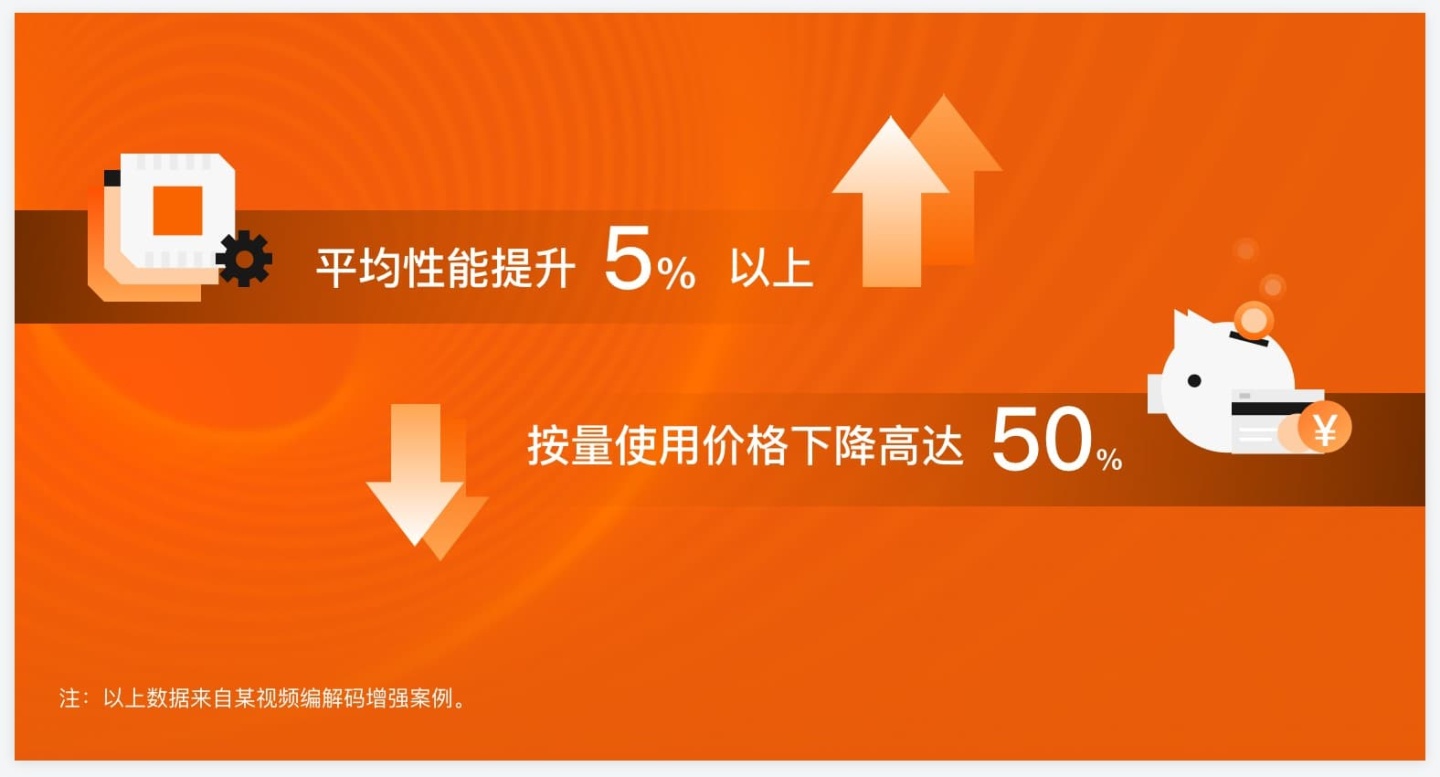

人工智能推理场景下,EAIS.EI让用户可以自定义GPU算力规模。据介绍,该产品可节省最高达50%的推理业务成本,目前EAIS.EI实例支持Tensorflow、Pytorch等主流深度学习框架,最高支持FP32 19.5 TFlops、FP16 混合精度312 TFlops的运算。

发布会传送门

产品详情

无论你是在逛淘宝还是刷抖音,人工智能都在背后疯狂计算,短视频推荐、拍照AI美颜,就连点外卖,人工智能都在帮外卖小哥优化路线。

人工智能崛起的燃料之一,就是跟通用处理器CPU有着不同专长的GPU异构加速器。在计算能力方面,如果说CPU是通才,GPU就是专才,非常擅长深度学习和图像处理,因此在人工智能、直播和短视频火热的今天大放异彩。

然而,不同的深度学习应用所需要的CPU、GPU和内存等计算资源的比例并非完全一样,云服务器受限于规格,往往只有特定数个比例。在某些情况下,就会造成资源闲置,尤其在推理场景中尤为明显。深度学习应用分为训练和推理两个过程,推理计算需求由于跟业务量紧密相关,往往是总运营成本的大头,最高占到90%成本。

EAIS为客户提供了一个异构算力池,用户可以将需要的GPU资源附加到任何一款阿里云ECS服务器中,根据不同应用需求灵活优化CPU/内存与GPU之间的比例,匹配适合的资源组合,有效提升资源利用率。

另外,AI推理计算业务通常伴随着业务的周期性的峰谷变化,EAIS.EI实例配合弹性伸缩ESS快速感知业务变化,实现高效的业务运维,提升业务弹性。资源的精准组合加上云服务的弹性,将大大降低成本。

阿里云异构计算产品负责人透露,除了推理场景之外,未来,弹性加速计算实例还将覆盖图形图像与多媒体计算编码场景,甚至实现含光800与CPU/内存的解耦。

弹性加速计算实例,将与神龙AI加速器和cGPU容器技术,一起组成阿里云异构计算的三大特色优势,为用户提供灵活高效、性能超群的异构计算基础设施。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

最后

以上就是魁梧花生最近收集整理的关于mobilenet cpu 加速_AI降成本利器!阿里云弹性加速计算实例来了,最高节省50%推理成本...的全部内容,更多相关mobilenet内容请搜索靠谱客的其他文章。

发表评论 取消回复