鱼羊 Pine 发自 凹非寺

量子位 | 公众号 QbitAI

ChatGPT爆火,Meta也坐不住了。

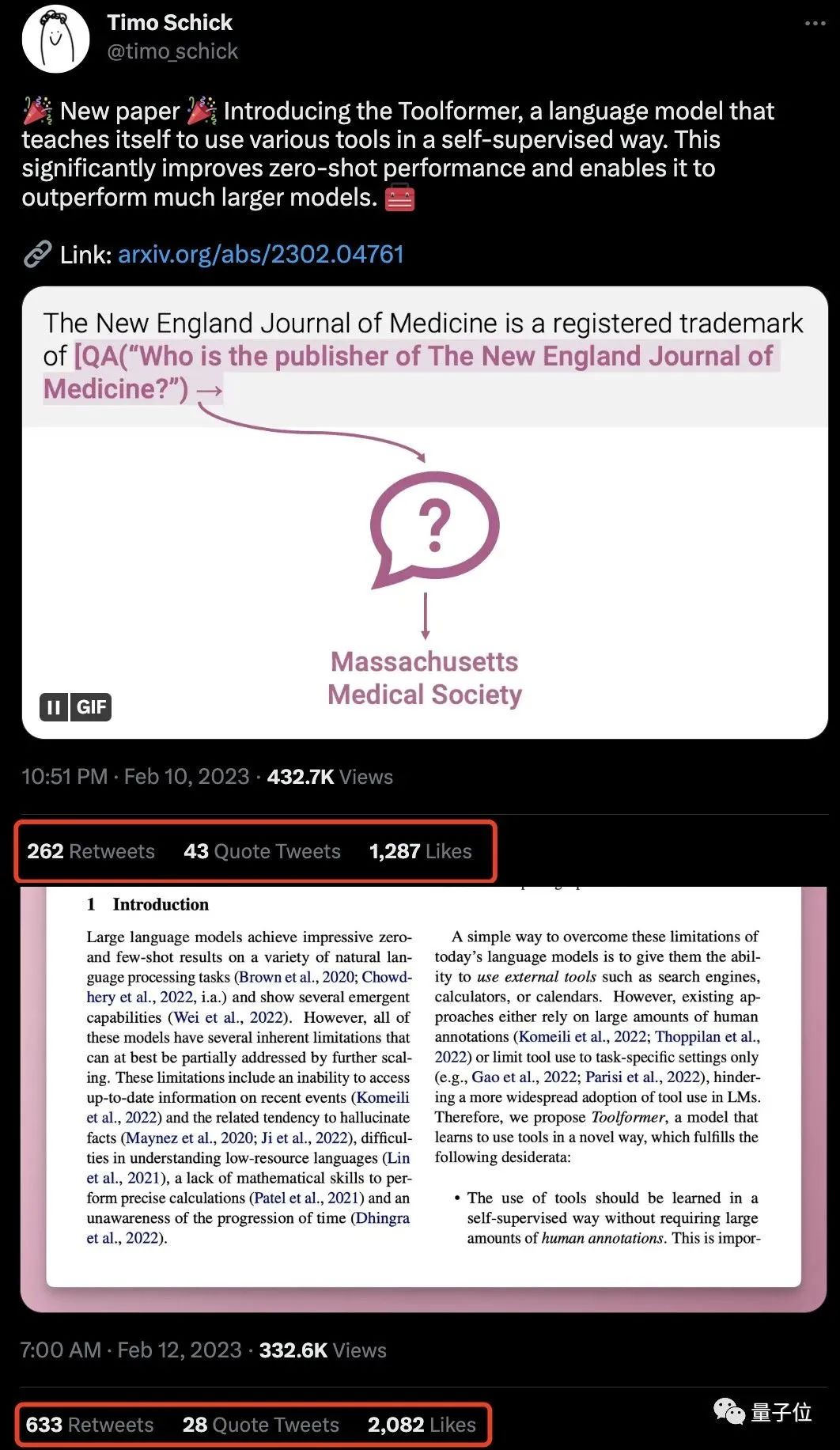

微软和谷歌正在搜索引擎那边刺刀拼刺刀呢,谁想Meta冷不防抛出一篇新论文,顿时吸引全场目光:

瞄准ChatGPT的“软肋”,让大语言模型自行学会了使用工具!

简单来说,基于Meta的这个思路,ChatGPT这些大语言模型可以缺啥补啥:

不会算数,就自己掏出计算器计算;需要最新信息,就自己连接搜索引擎搜索……

是不是有点AI自己操作自己内味儿了?

论文一出,不少AI研究者就将其视作“过去几周里最重要的论文”。

这篇论文给人们打开了思路,让大语言模型未来可以成为所有事情的起点。

还有网友表示:我老婆原本不太关心AI,听说Meta这论文都惊了。普通人真的得好好想想这事儿了。

自学工具用法的大语言模型

这一回,Meta给这个会使工具的语言模型起名Toolformer。

Toolformer的内核逻辑,总结下来很简单,就是:

专业的任务交给专业的工具来做。

在生成文本的过程中,遇到特定的任务,Toolformer会直接调用所需工具的API。

比如说,在执行这个任务:1400名参与者,有400人通过了测试,占多大比例?(为了让ChatGPT掌握数学运算,OpenAI可没少折腾,详见量子位:ChatGPT连夜迭代:你老婆不好使了)

Toolformer丝毫不慌,直接“掏出”计算器,现场计算得出结果:29%。

又或者说,想要备注个事情,只知道是周五,具体日期还不知道?

没关系,翻出日历查一下就好了。

甚至翻译任务也可以直接丢给它,各国语言都能够识别并翻译,直接省去了在软件切换语言的工夫。

除了这些工具之外,Toolformer还能够调用Q&A以及搜索引擎等工具。

这时,就已经有网友开始畅想未来了:

现在,ChatGPT版必应能帮你比较酒店价格,那未来有了Toolformer,预定性价比高的酒店岂不是也可以甩给AI去做了。

不过话说回来,Toolformer面对不同的任务都能行云流水般地调用对应的工具,它是怎么做到的呢?

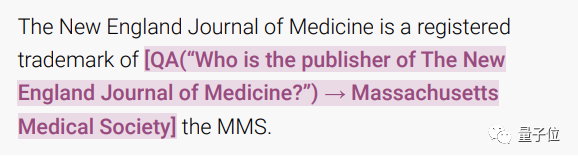

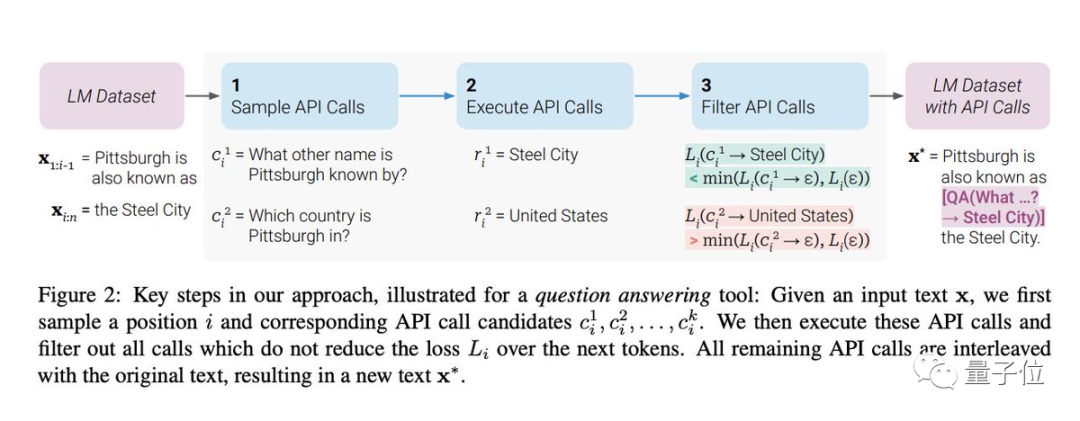

一言以蔽之,Toolformer经过训练,能够在生成文本中插入API调用,直接将任务外包出去。

在这其中,训练的过程是以自监督的方式完成的。这意味着无需大量人类标注好的数据,Toolformer只需要少量演示就能学会调用API。

具体来说,先给Toolformer提供少量已经手动标注好的例子,然后让语言模型在实践中生成一个更大的包含示例的数据集。

这个过程主要分成三步:

首先是取样,通俗点讲就是看输入的文本提示中,哪个地方需要调用哪种工具,然后直接将“调用的API”插入到对应的地方;

其次是执行,执行上一步的“调用API”任务,将生成的文本直接插入进去;

最后是过滤,上一步中工具生成的文本如果对输入文本来说用处不大的话,就可以直接pass掉,保留对文本有用的地方。

这样一来,基于这些有用的数据集,Toolformer便可以对预先训练好的大语言模型进行微调。

讲了这么多,Toolformer的真实效果到底如何,有没有一个横向的数据对比?

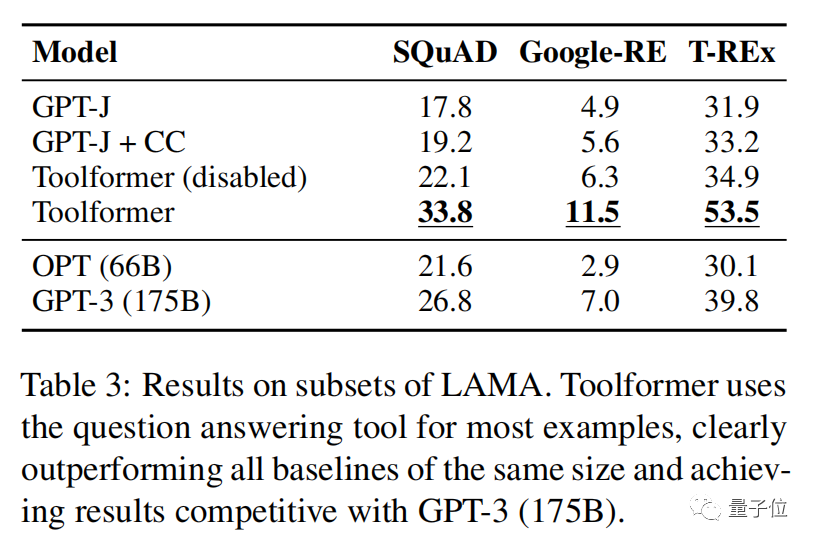

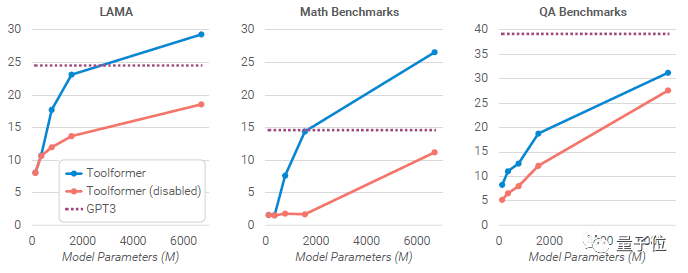

论文将Toolformer和多个其他大语言模型,包括GPT-J,OPT(66B)以及GPT-3(175B)进行了对比,比较了它们在数学、Q&A以及机器翻译等方面的能力。

结果显示,在学习使用工具后,GPT-J的零样本学习性能的到了显著的提高。

△Toolformer:是在GPT- J上微调,并加强了CCNet子集中的API调用/ Toolformer (disabled):同上,但解码期间禁用API调用

并且在大多数任务上性能都有明显提高,在一些下游任务中Toolformer甚至已经超过了GPT-3。

“未来大语言模型发展的重要分支”

说到这里,不知道你怎么看这件事儿。

有不少网友是已经按捺不住,想着去拔AI电源了。

而引发更多讨论的,是这样一种观点:Toolformer可能是未来LLM(大语言模型)发展的一个重要分支。

大语言模型进化出使用工具的能力,知道应该在何时、使用何种工具来实现需求,也就意味着许多在今天还需要人类和AI协作完成的工作,未来AI都能自己搞定了。

比如现在还多少有些“人工智障”的语音助手,如果背后有ChatGPT+Toolformer的技术能力支撑,那么从挑选符合需求的餐厅,到直接订座,这一系列动作都可以被丝滑地串联起来。

又比如微软的必应搜索接入ChatGPT。如果这些大语言模型能充分调用各种API、使用UI,那它不仅能帮人们完成搜索,还能完全改变人们操作网页的方式——一切输入都可以化简为自然语言。

甚至,ChatGPT这样的模型,借助各种API重写自己的代码,也将成为可能。

事实上,让AI掌握工具的使用方法这个研究方向,也并不只有Meta在做。

比如谷歌即将嵌入到搜索中的Bard,背后模型LaMDA就内置了一套工具箱,包括计算器、翻译器和访问搜索引擎获取外部信息的接口。

还有开源项目LangChain,也致力于将大语言模型与外部的计算、知识来源相结合,以开发真正可用的应用程序。

而现在,Meta又使大模型对工具的使用“熟练度”、“自主性”,更上一层楼。

不过,也有网友指出,Toolformer所展现出的“自学”能力,还是一个初级、“狭义”的版本。

这些模型本身仍然是纯粹的函数:给定相同的输入(包括采样时的随机值),它将总是产生相同的输出。

有点像是在说,一个大语言模型能学会将特定领域的语言作为其自然语言的一部分,以此纳入来自外部工具的知识。

One More Thing

Meta新论文炸场,还挑动了人类的“反思”神经。

这不,新鲜梗图已经出炉:

人类在沉迷,而机器在学习。

论文地址:

https://arxiv.org/abs/2302.04761

参考链接:

[1] https://twitter.com/timo_schick/status/1624058382142345216

[2] https://twitter.com/mathemagic1an/status/1624870248221663232

[3] https://twitter.com/Tisoga/status/1624543837745192960

— 完 —

《中国AIGC产业全景报告暨AIGC 50》调研启动

谁会是中国的“ChatGPT”?最有竞争力和潜力的AIGC力量位于何方?

量子位《中国AIGC产业全景报暨AIGC 50》正式启动对外征集,期待有更多优秀的机构、产品、案例与技术能够被大众看到。

点这里????关注我,记得标星哦~

最后

以上就是虚拟毛衣最近收集整理的关于让ChatGPT长“手”!Meta爆火新论文,让语言模型学会自主使用工具的全部内容,更多相关让ChatGPT长“手”!Meta爆火新论文内容请搜索靠谱客的其他文章。

发表评论 取消回复