Deep Sensor Fusion for Real-Time Odometry Estimation

本文提出一个激光和RGB用深度网络融合标定估计vo的方法,通融融合匹配算法不但能够避免标定误差同时提高了里程计估计得效果。

摘要

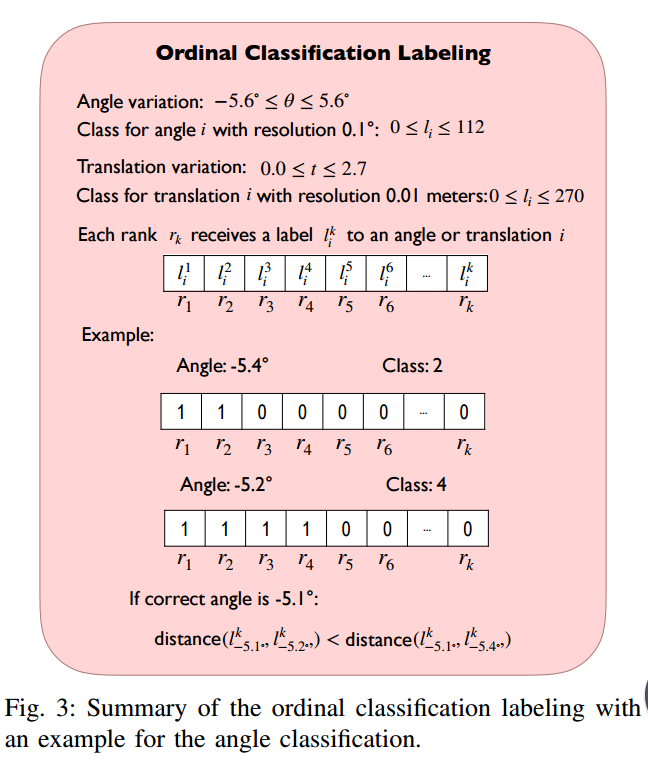

摄像机和二维激光扫描仪的结合,能够提供低成本、轻量化和精确的解决方案,这使得它们的融合非常适合许多机器人导航任务。然而,正确的数据融合依赖于传感器之间刚体变换的精确标定。本文提出了第一种利用卷积神经网络(CNNs)融合二维激光扫描仪和单摄像机进行里程估计的方法。CNNs的使用不仅提供了从两个传感器中提取特征的工具,而且还提供了无需在传感器之间进行校准即可进行融合和匹配的工具。为了在连续帧之间找到准确的旋转和平移值,我们将里程估计转化为一个有序分类问题。在实际道路数据集上的实验结果表明,融合网络能够实时运行,通过学习如何融合两种不同类型的数据信息,能够提高单传感器的里程估计性能。

方法

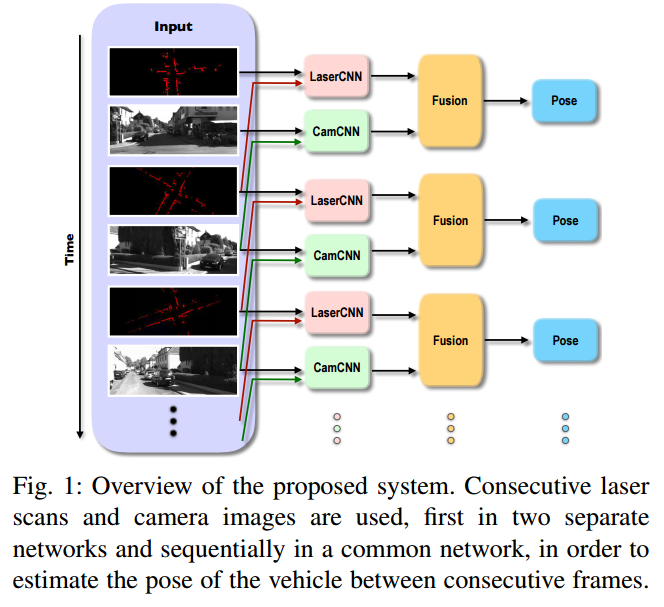

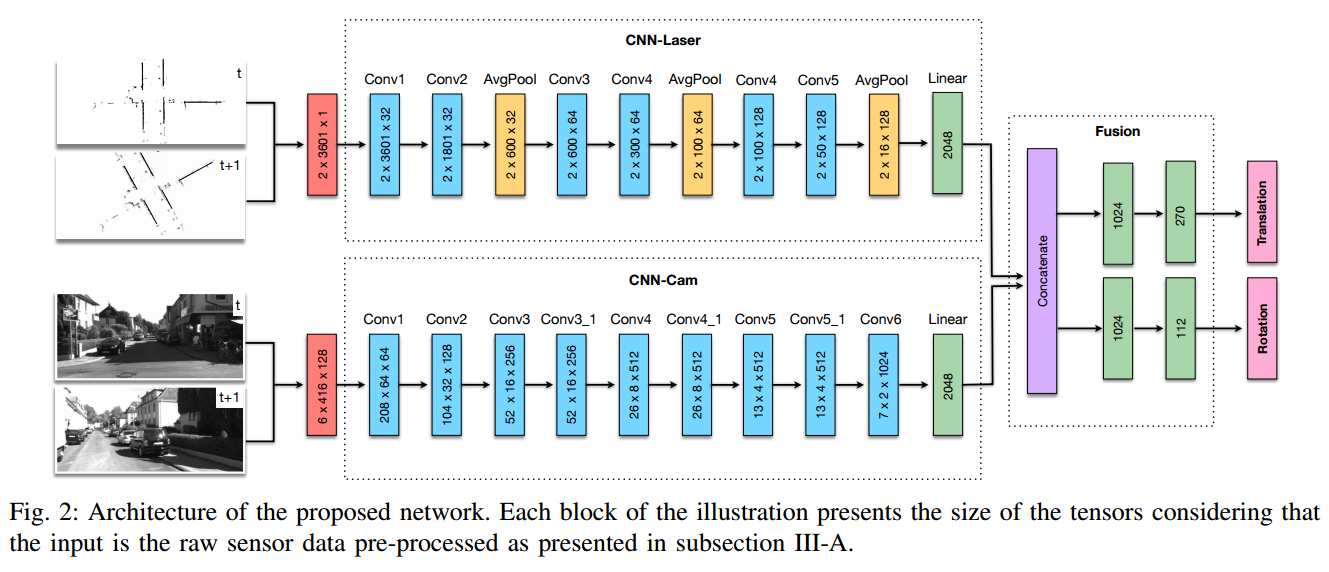

考虑到这一点,我们提出了一种完整的深度学习方法,利用CNNs提取两种不同传感器的特征,一种是二维激光扫描器,一种是单摄像机,然后进行融合以估计车辆的里程。拟议方法的示意图如图1所示。本文还提出了一种新的方法,将里程估计回归问题转化为便于网络训练的有序分类问题。与其他深度学习方法相比,该解决方案可以实时运行,并且在实际道路场景中的测试显示了具有竞争力的结果。

所提出的方法是通过估计一系列相机图像和激光扫描仪采集之间的转换来确定车辆的位移。

数据预处理

对于相机原始数据,我们只调整图像大小以减少计算时间。我们测试了不同的尺寸,这样方法的准确性不会降低,但我们仍然能够产生更快的结果。考虑到这一点,用图像大小(416128)实现了精度和时间的最佳匹配。调整它们的大小后,两个连续的图像以与扫描相同的方式堆叠在一起,形成表示两个相机采集的张量。这种格式允许我们将两幅图像输入到同一序列的cnn中提取特征。

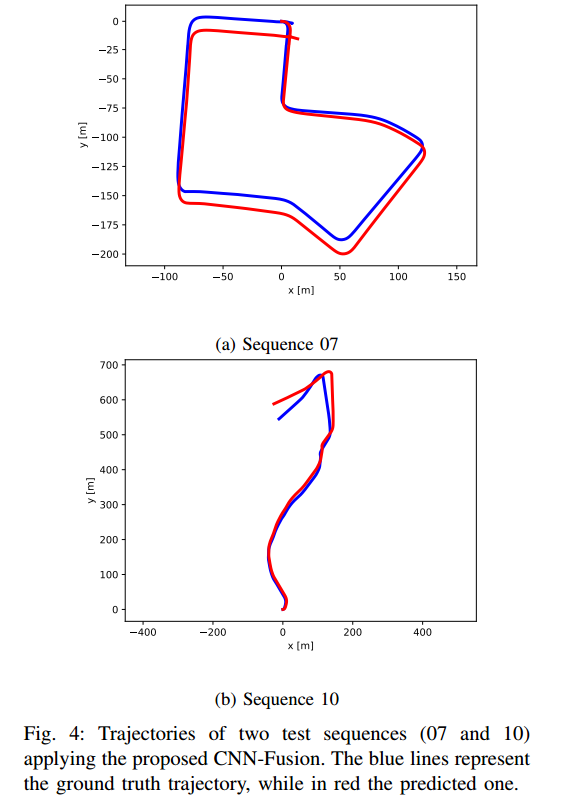

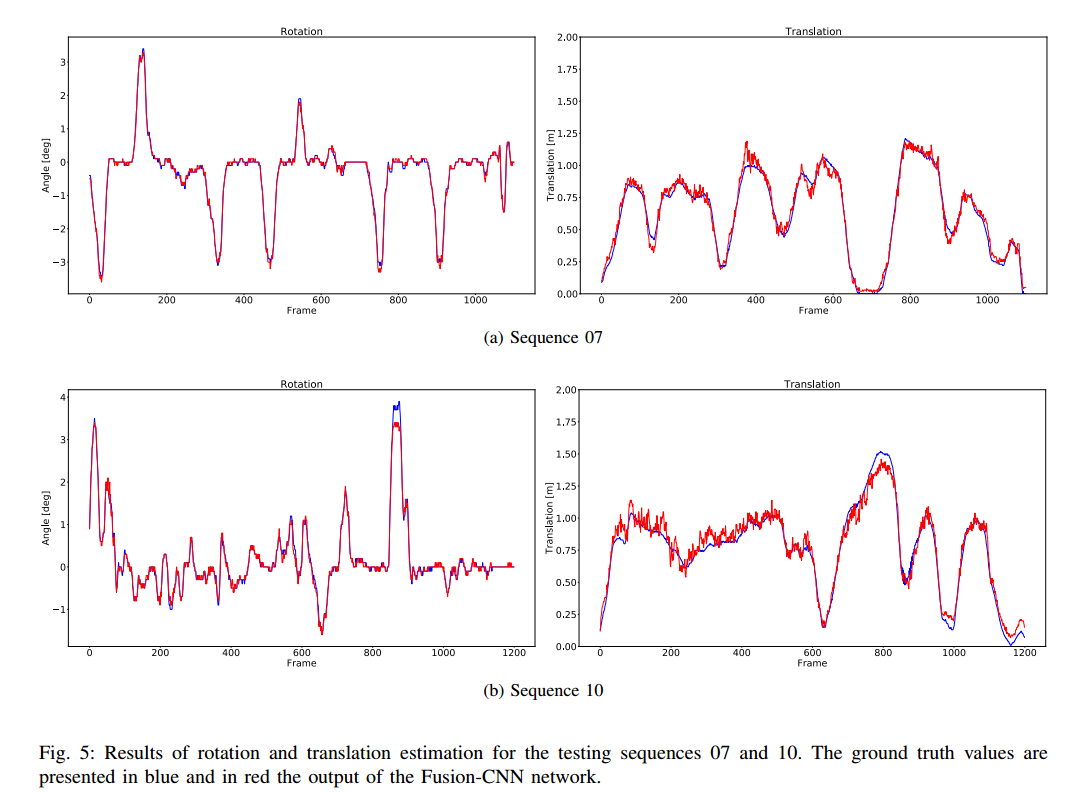

结果

最后

以上就是高兴耳机最近收集整理的关于每天一篇论文 290/300 Deep Sensor Fusion for Real-Time Odometry Estimation的全部内容,更多相关每天一篇论文内容请搜索靠谱客的其他文章。

发表评论 取消回复