1.APA简介

从半自动的APA到全自动的APA:https://zhuanlan.zhihu.com/p/69399889

全自动泊车辅助系统APA(Auto Parking Assist),通过控制车辆的加减速度和转向角度自动停放车辆。该系统通过AVM(环视)和USS(超声波雷达)感知泊车环境,使用IMU和车轮传感器估计车辆姿态(位置和行驶方向),并根据驾驶员的选择自动或手动设置目标泊车位。然后系统进行自动泊车轨迹计算,并通过精确的车辆定位与车辆控制系统使车辆沿定义的泊车轨迹进行全自动泊车,直至到达最终目标泊车位。

总结:APA是利用车载传感器(一般为超声波雷达或摄像头)识别有效的泊车空间,并通过控制单元控制车辆进行泊车。

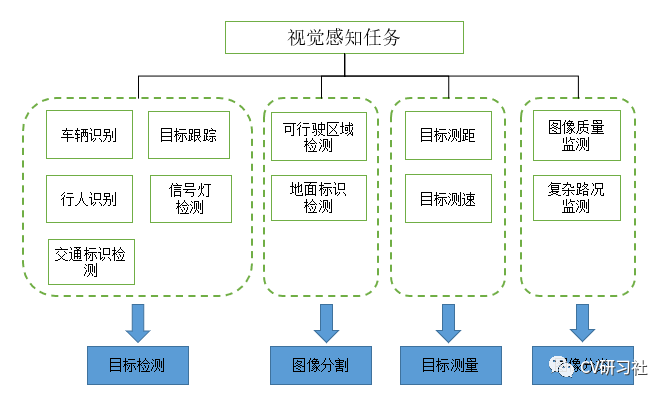

APA的视觉感知分为两个部分:基于IPM(Inverse Perspective Mapping)图的停车位视觉感知,以及基于原图的道路环境感知(车位的场景检测,比如车位的背景,行人,锥桶,地锁等)。

完成自动泊车功能,需要整车的档位、EPS(电动助力转向系统)、ESP/ibooster(车身电子稳定系统)、加速、EPB、APA开关及指示灯等控制器或传感器支持:

1. 泊车控制系统通过超声波雷达及360环视信息融合泊车车位。

2. 通过APA ECU算法规划泊车轨迹。

3. 获取轮速脉冲及IMU信号,推算车辆航迹。

4. 获取EPS转向角、车速、档位等信号,用于定位融合及速度控制。

5. 根据轨迹规划结果,对车辆的档位、速度、方向盘转向角进行控制,完成车辆泊入泊出。

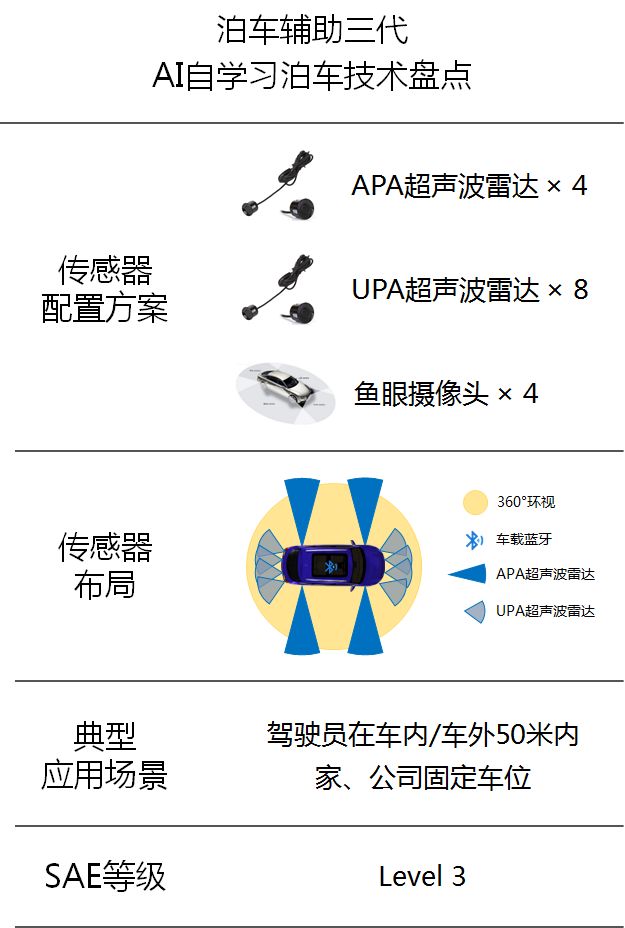

APA全自动泊车辅助系统采用12颗超声波雷达、4个环视摄像头和一个控制器构成,实现全自动泊车功能。

2.APA的视觉感知中的原图和IPM图的区别

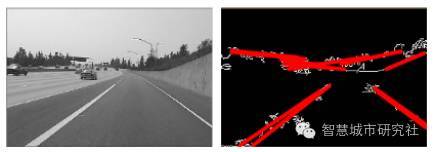

如果直接对原图进行边缘提取,则会将车道线目标外的大量非目标边缘也一同提取出来,如树木、交通标志、车辆、行人等,这些构成车道线检测的干扰源。典型的检测失败案例如图所示。这也正是传统的利用Hough变换进行车道线检测的难点。

三维道路场景在二维图像平面上的透视映射过程,对后续的边缘提取及车道线建模带来不利条件。逆透视映射(Inverse Perspective Mapping, IPM)是透视映射的逆过程,可利用摄像机的角度、高度等位置信息建立三维坐标系,消除透视作用,得到场景的俯视图。经过逆透视映射之后,原本有相交趋势的车道线转化为俯视图中的平行线,更便于检测。

3.ADAS中前视,环视,周视的区别:https://baijiahao.baidu.com/s?id=1692550336190864747&wfr=spider&for=pc (视觉感知的主要内容)

1. 前视线性相机:视角较小,一般采用52°左右的相机模组安装于车辆前挡风玻璃中间,主要用来感知车辆前方较远的场景,感知距离一般为120米以内。

2. 周视广角相机:视场角相对较大,一般采用6颗100°左右的相机模组安装在车辆周围一圈,主要用来感知360°的周身环境(安装方案与特斯拉大同小异)。广角相机存在一定的畸变现象。用于

3. 环视鱼眼相机:环视鱼眼相机视角较大,可以达到180°以上,对近距离的感知较好,通常用于APA,AVP等泊车场景,安装于车辆左右后视镜下方以及前后车牌下方等4个位置做图像的拼接、车位检测、可视化等功能。

前视+周视相机往往用于行车的路况和环境感知;鱼眼相机往往用于360环视和泊车感知;车内相机往往用于驾驶员监控。但是从传感器简化的角度,行泊一体化将是未来趋势,那么势必就要考虑鱼眼和周视相机是否能统一的问题。

泊车选用的摄像头,较为常规的做法是使用四颗鱼眼相机环视拼接然后在鸟瞰图(IPM)上做停车位检测,或者在原图上障碍物检测等多任务。大多数做泊车感知时偏向于拆分成两个网络分别处理不同的任务。这种类似于松耦合的方案,两个不同的任务放在不同的网络中独立运算,然后将输出的感知结果进行过滤合并。https://blog.csdn.net/Yong_Qi2015/article/details/117719409

最后

以上就是繁荣大白最近收集整理的关于APA学习记录的全部内容,更多相关APA学习记录内容请搜索靠谱客的其他文章。

发表评论 取消回复