FcaNet: 频率域通道注意力网络

Zequn Qin 1 , Pengyi Zhang 1 , Fei Wu 1 , 2 , Xi Li 1 , 2 * 1 College of Computer Science, Zhejiang University, 2 Shanghai Institute for Advanced Study, Zhejiang University zequnqin@gmail.com, pyzhang@zju.edu.cn, wufei@cs.zju.edu.cn, xilizju@zju.edu.cn

摘要

注意力机制,尤其是通道注意力,在计算机视觉领域取得了巨大的成功。许多研究集中于如何设计有效的通道注意力机制,而忽略了一个根本问题,即通道注意力机制使用标量来表示通道,这是由于大量信息丢失而带来的困难。在这项工作中,我们从不同的角度出发,利用频率分析将信道表示问题视为一个压缩过程。基于频率分析,我们从数学上证明了传统的全局平均池是频域特征分解的特例。通过证明,我们自然地在频域推广了信道注意力机制的压缩,并提出了多光谱信道注意力的方法,称为FcaNet。FcaNet简单但有效。我们可以在计算中更改几行代码,以便在现有的channel注意力方法中实现我们的方法。此外,与其他通道注意力方法相比,该方法在图像分类、目标检测和实例分割任务方面取得了最新的结果。在相同的参数数量和相同的计算成本下,我们的方法可以始终优于基线SENet。

我们的代码和模型在https://github.com/cfzd/FcaNet。

1、引言

作为特征建模中一个重要且具有挑战性的问题,卷积神经网络(CNN)的注意力机制最近吸引了大量的注意力,并广泛应用于计算机视觉[40]和自然语言处理[34]等许多领域。原则上,它们旨在有选择地集中于一些重要信息,并且有许多类型的变体(例如,空间注意、通道注意力和自我注意力)对应于不同的特征维度。由于特征建模的简单性和有效性,channel注意力通过不同的通道直接学习重视权重,成为深度学习社区的一种流行而强大的工具。

通常,由于计算开销有限,通道注意力方法的核心步骤是为每个通道使用一个标量来进行计算,而全局平均池(GAP)由于其简单高效而成为深度学习社区中事实上的标准选择。然而,每朵玫瑰都有刺。GAP的简单性使得很难很好地捕获各种输入的复杂信息。一些方法,如CBAM【39】和SRM【23】进一步使用全局最大池和全局标准差池来增强GAP的表现。与以往的工作不同,我们将信道的标量表示视为一个压缩问题。即,在尽可能保持整个信道的表示能力的同时,信道的信息应采用标量进行紧凑编码。

在这种情况下,由于计算开销有限,如何有效地压缩具有标量的信道是一个主要困难,并且对于信道注意力至关重要。

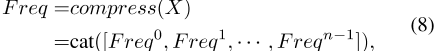

基于上述动机,我们建议在信道注意力机制中使用离散余弦变换(DCT)来压缩信道,原因如下:1)DCT是信号处理中广泛使用的数据压缩方法,尤其是在数字图像和视频中。

许多广泛使用的图像和视频格式,如JPEG、HEIF、MPEG和H.26x,都使用DCT来实现数据压缩。DCT具有很强的能量压缩特性[1,30],因此可以实现高质量的高数据压缩比[2,22]。此属性满足通道注意力的要求,即用标量表示通道。2) DCT可以用元素乘法实现,并且是可微的。通过这种方式,它可以很容易地集成到CNN中。3) 令人惊讶的是,DCT可以看作是GAP的推广。从数学上讲,GAP(在SENet[21]中显示了有效性)仅等效于DCT的最低频率分量,留下了许多其他潜在有用的频率分量未被探索。这强烈地促使我们为通道注意力机制定制DCT。

本文在上述讨论的基础上,进一步提出了一种简单、新颖、有效的多光谱通道注意力(MSCA)框架。为了更好地压缩信道并探索GAP遗漏的分量,我们建议定制DCT,并使用DCT的多个但有限的频率分量作为信道注意力机制。请注意,尽管我们使用多光谱通道注意力,但每个通道仍然只由一个标量表示。与MSCA框架一样,如何为每个信道选择DCT的频率分量也很重要。通过这种方式,我们提出了三种频率分量选择标准来实现和验证MSCA框架,即LF(低频选择)、TS(两步选择)和NAS(神经架构搜索选择)。有了这些选择标准,我们的方法与其他渠道的注意力方法相比,达到了最先进的表现。

总之,这项工作的主要贡献可以总结如下。

•我们将通道注意力视为压缩问题,并在通道注意力中引入DCT。然后我们证明了传统GAP是DCT的特例。基于这一证明,我们在频域中推广了信道注意力,并提出了基于多光谱信道注意力框架的方法,称为FcaNet。

•我们提出了三种频率分量选择标准以及建议的多光谱信道注意力框架,以实现FcaNet。

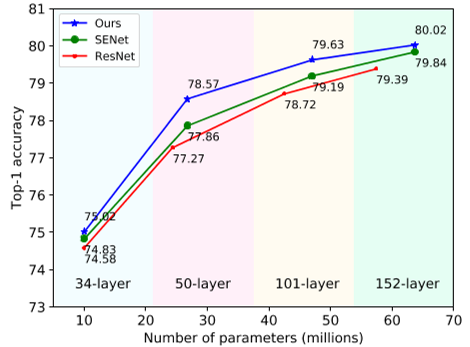

•大量实验表明,该方法在Ima-geNet和COCO数据集上都取得了最先进的结果,计算成本与SENet相同。ImageNet上的结果如图1所示。

图1:。ImageNet上的分类精度比较。在参数数目和计算量相同的情况下,我们的方法始终优于基线SENet。

2、相关工作

CNN中的注意力机制【40】中,首次提出了一种视觉注意力方法,以模型特征在图像字幕任务中的重要性。然后,许多方法开始关注注意力机制。提出了一种具有空间注意力机制的剩余注意力网络[35],该机制使用下采样和上采样。此外,SENet[21]提出了通道注意力机制。它在通道上执行间隙,然后使用完全连接的层计算每个通道的权重。此外,GE【20】使用空间注意力更好地利用特征上下文,2-Net【7】构建了图像或视频识别的关系函数。

受这些作品的启发,提出了一系列作品,如BAM【28】、DAN【9】、CBAM【39】、scSE【32】和CoordAttention【19】,以融合空间注意力【45】和通道注意力。其中,CBAM声称,由于信息丢失,GAP只能获得次优特征。为了解决这个问题,它使用了GAP和全局最大池,并获得了显著的表现改进。同样,SRM【23】还建议将GAP与全球标准偏差池结合使用。

在CBAM的推动下,GSoP【11】引入了一种二阶池法进行下采样。NonLocal[37]提出构建密集的空间特征地图。AANet[3]建议在特征中嵌入带有位置信息的注意力图。SkNet【24】引入了选择性通道聚合和注意力机制,ResNeSt【42】提出了类似的分割注意力方法。由于注意力操作的复杂性,这些方法相对较大。为了提高效率,GCNet[4]建议使用一个简单的空间注意力模块,并取代原来的空间下采样过程。ECANet【36】引入了一维卷积层,以减少完全连接的层的冗余,并获得更有效的结果。

除了这些工作,许多方法试图将注意力机制扩展到特定任务,如多标签分类[14]、显著性检测[44]、视觉解释[10]和超分辨率[43]。

频域学习频率分析一直是信号处理领域的有力工具。

近年来,在深度学习领域引入频率分析的一些应用出现了。在[8,13]中,通过JPEG编码在CNN中引入了频率分析。然后,在【41】中加入DCT以减少通信带宽。在模型压缩和修剪任务中也有一些应用程序,如[6、27、38]。

3、方法

在本节中,我们首先回顾DCT和通道注意力的公式。然后,基于这些工作,我们详细阐述了我们的多光谱通道注意力框架的推导。同时,结合多光谱信道注意力框架,提出了三种频率分量选择方法。

3.1. 重温DCT和频道注意力

我们首先阐述了离散余弦变换和通道注意力机制的定义。

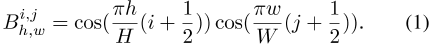

离散余弦变换(DCT)通常,二维(2D)DCT的基函数为:

那么2D DCT可以写成:

,其中f 2 d∈ R H×W是2D DCT频谱,x 2 d∈ R H×W是输入,his是x 2 d的高度,W是x 2 d的宽度。相应地,逆2D DCT可以写成:

请注意,在等式中。2和3中,为了简单起见,删除了一些常数归一化因子,这不会影响本工作的结果。

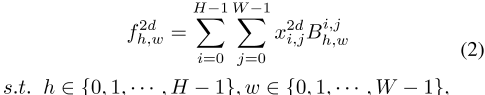

通道注意力通道注意力机制在CNN中得到广泛应用。它使用标量来表示和评估每个通道的重要性。假设X∈ R C×H×W是网络中的图像特征张量,C是通道数,his是特征的高度,W是特征的宽度。如第。1,我们将通道注意力中的标量表示视为压缩问题,因为它必须表示整个通道,而只能使用一个标量。这样,注意力机制可以写成:

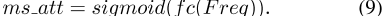

,其中att∈ R C是注意力向量,sigmoid是sigmoid函数,f C代表映射函数,如全连通层或一维卷积,压缩:R C×H×W 7→ R C是一种压缩方法。

在获得所有C通道的注意力向量后,输入X的每个通道按相应的注意力值进行缩放:

,其中X̃是注意力机制的输出,att i是注意力向量的第i个元素,X:,i,:,:是输入的第i个通道。

通常,全局平均池是事实上的压缩方法[21,36],因为它简单有效。还有一些压缩方法,如全局最大池法[39]和全局标准差池法[23]。

3.2. 多光谱通道注意力在这一部分中,我们首先从理论上讨论了现有通道注意力机制的问题。在理论分析的基础上,详细阐述了该方法的网络设计。

通道注意力的理论分析,如第。3.1,DCT可被视为输入的加权和。我们进一步证明了GAP实际上是2D-DCT的一个特例。

定理1。GAP是2D-DCT的特例,其结果与2D-DCT的最低频率分量成正比。

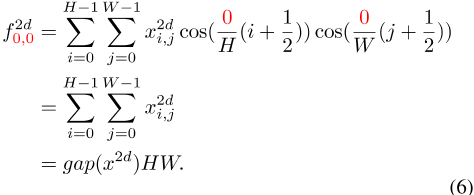

证据假设hand win公式2为0,我们得到: 中的

中的

表示2D DCT的最低频率分量,它与间隙成正比。这样就证明了-orem 1。

基于多光谱通道注意力模块的理论分析和定理1,我们可以看到,在通道注意力机制中使用GAP意味着只保留最低频率的信息。来自其他频率的所有分量都被丢弃,这也对表示信道的有用信息模式进行了编码,不应遗漏。

为了更好地压缩信道并引入更多信息,我们建议将GAP推广到2D DCT的更多频率分量,并使用2D DCT的多个频率分量压缩更多信息,包括最低频率分量,即GAP。

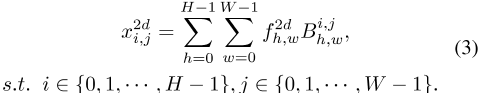

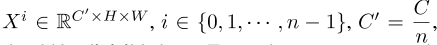

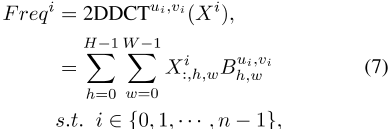

首先,输入X沿通道维度分成许多部分。表示[X 0,X 1,···,X n− 1]作为部分,其中

和C应可被n整除。对于每个部分,分配相应的2D-DCT频率分量,2D-DCT结果可以用作信道注意力的压缩结果。这样,我们得到:

,其中[u i,v i]是对应于X i和F req i的频率分量2D In-dice∈ R C′是压缩后的C′维向量。整个压缩向量可以通过级联获得:

,其中F req∈ R C是获得的多光谱向量。

整个多光谱通道注意力框架可以写成:Eqs中的

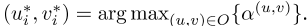

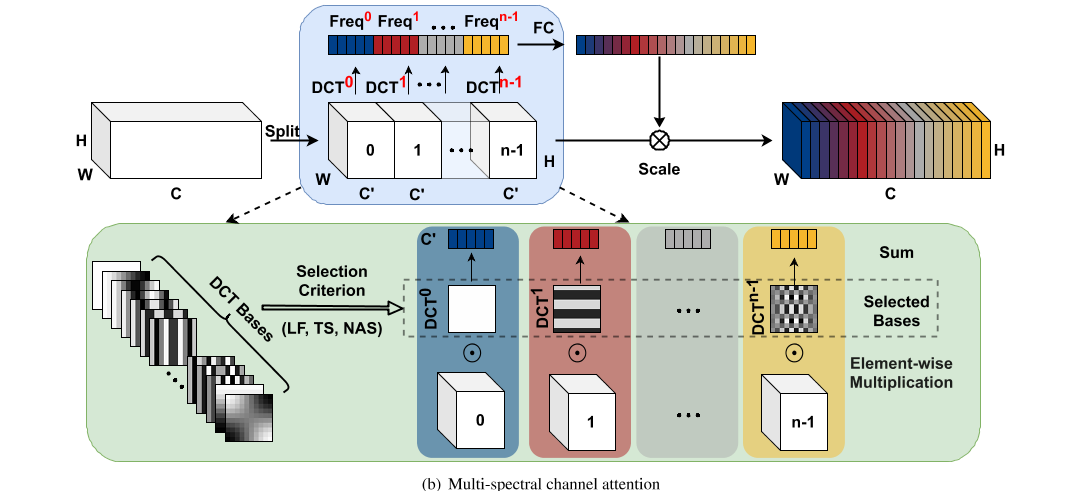

。8和9中,我们可以看到,我们的方法将原始GAP方法概括为具有多个频率分量的框架。通过这样做,压缩后的信道信息可以有效地丰富以便于表示。我们的方法的整体说明如图2所示。

选择频率分量的标准存在一个重要问题,即如何为每个部分X i选择频率分量指数[u i,v i]。为了充分填补多光谱信道的注意力,我们提出了三种准则,即FcaNet LF(低频)、FcaNet TS(两步选择)和FcaNet NAS(神经架构搜索)。

FcaNet LF指具有低频成分的FcaNet。众所周知,许多压缩方法利用DCT的低频信息来压缩信息。此外,一些方法[21,41]表明CNN更喜欢低频信息。这样,选择频率分量的第一个标准是只选择低频分量。

FcaNet TS表示FcaNet在两步选择方案中选择组件。其主要思想是首先确定每个频率分量的重要性,然后研究使用不同数量频率分量的效果。即,我们单独评估通道注意力中每个频率分量的结果。最后,根据评估结果选择Top-k最高表现频率分量。

FcaNet NAS指具有搜索组件的FcaNet。

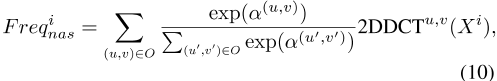

对于该准则,我们使用神经架构搜索来搜索信道的最佳频率分量。对于每个部分X i,一组连续变量α={α(u,v)}被分配给搜索组件。该部分的频率分量可以写为:

,其中O是包含所有2D DCT频率分量索引的集合。训练后,X i的频率分量由

得出。关于这些标准的消融研究见第。4.2 .

图2:。现有通道注意力和多光谱通道注意力的图示。为简单起见,2D DCT索引以一维格式表示。我们可以看到,我们的方法使用多个频率分量和选定的DCT基,而SENet只使用通道注意力中的间隙。以彩色显示效果最佳。

4、实验

在本节中,我们首先详细介绍了我们的实验细节。其次,我们展示了关于FcaNet的消融研究。第三,我们将讨论如何在我们的框架、复杂性和代码实现中压缩信息。最后,我们研究了该方法在图像分类、对象检测和实例分割方面的有效性。

4.1. 实施细节

为了评估拟议的FcaNet在Ima-geNet上的结果【33】,我们采用了四种广泛使用的CNN作为主干模型,包括ResNet-34、ResNet-50、ResNet-101和ResNet-152。我们遵循[16]和[17]中的数据扩充和超参数设置。具体地说,输入图像通过随机水平翻转被随机裁剪为224×224。我们使用的SGD优化器的动量为0.9,权重衰减为1e-4,训练时每个GPU的批量大小为128。对于像ResNet-101和ResNet-152这样的大型机型,批大小设置为64。使用线性缩放规则,将256个批次的学习率设置为0.1【12】。所有模型均在100个时期内进行训练的,具有余弦学习率衰减和标签平滑。值得注意的是,为了提高训练效率,我们使用了英伟达APEX混合精度训练工具包。

使用更快的R-CNN(31)和Mask R-CNN(15)评估我们在MS COCO(26)上的方法。我们使用MMDetection[5]工具箱中检测器的实现,并使用其默认设置。在训练期间,输入图像的较短一侧的大小调整为800。所有模型均使用SGD优化,重量衰减为1e-4,动量为0.9,12个时期内每个GPU的批量大小为2。

学习率初始化为0.01,在第8个和第11个时期分别降低了10倍。

所有型号均在PyTorch[29]框架中实现,并配有八个Nvidia RTX 2080Ti GPU。

4.2. 消融研究

如第。3.2,我们提出了三种标准,包括FcaNet LF(低频)、FcaNet TS(两步选择)和FcaNet NAS(神经架构搜索)。在本节中,我们首先展示关于这些变体的烧蚀。然后讨论了FcaNet与完全可学习通道注意力的关系。

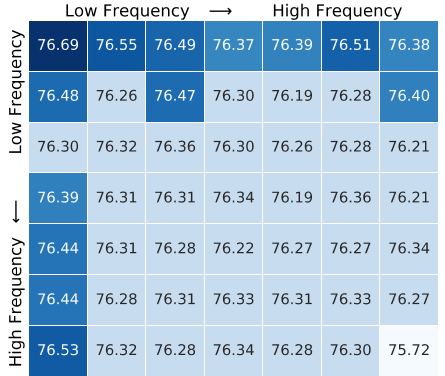

对于FcaNet TS,第一步是确定每个频率分量的重要性。为了研究信道触角中不同频率分量的影响,我们一次只使用一个频率分量。

由于Ima-geNet上的最小特征映射大小为7×7,我们将整个二维DCT频率空间划分为7×7部分。这样,总共有49个实验。为了加速实验,我们首先训练一个100个时代的标准ResNet-50网络作为基础模型。然后,我们将通道注意力添加到具有不同频率分量的基础模型中,以验证效果1。所有添加的模型都在20个时期内经过训练的,在Sec中具有类似的优化设置。4.1,而学习率设置为0.02。

如图3所示,我们可以看到,使用较低的频率可以有更好的表现,这是直观的,验证了SENet的成功。这也验证了深层网络更喜欢低频信息的结论。然而,有趣的是,我们可以看到,几乎所有频率分量(除最高分量外)在最低频率分量之间都有非常小的间隔(<=0。这表明其他频率分量也能很好地应对通道注意力机制,在频域中推广通道注意力是有效的。

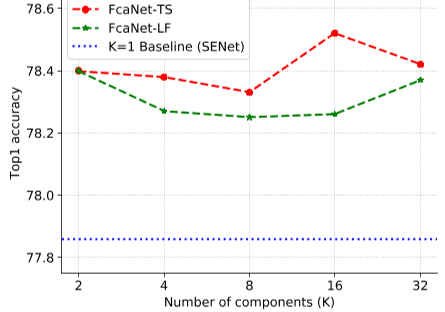

通过分析不同频率分量数目对FcaNet LF的影响,验证了使用K个最低频率分量的结果。对于FcaNet TS,我们选择图中的Top-K最高表现频率分量。

3.为简单起见,K可以是1、2、4、8、16或32。

如图4所示,我们可以看到两种现象。1) 与仅使用通道注意力间隙的实验相比,所有使用多光谱注意力的实验都有显著的表现增益。这验证了我们在通道注意力中使用多个频率分量的想法。2) 对于FcaNet LF和FcaNet TS,具有2个和16个频率分量的设置分别获得最佳的表现。

通过这种方式,我们在我们的方法和所有其他实验中使用这些设置。

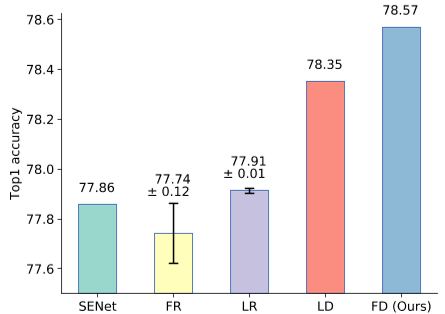

与等式7所示的完全可学习的信道注意力相比,我们使用2D DCT基函数来压缩信道。二维DCT基函数B u i,v i h,w可以简单地看作是包含DCT系数的张量。这样,一个自然的问题是,如何直接学习张量来压缩通道。我们将我们的方法与三种不同的张量进行了比较,它们是固定张量和随机初始化张量,学习张量和随机初始化张量,以及学习张量和DCT初始化张量。在这种情况下,我们的方法可以被视为具有DCT初始化(FD)的固定张量。

比较如图5所示。我们可以看到,所有带有DCT初始化(LD,FD)的设置都优于没有DCT(FR,LR)的设置。此外,具有固定DCT初始化的设置(我们的设置)甚至优于完全可学习的信道注意力方法(LR、LD),这表明了使用DCT压缩信道的有效性。

图3:。使用注意力频道中的不同频率分量,ImageNet上的最高精确度。

图4:。不同部件数量的Top1精度。由于FcaNet NAS会自动搜索和确定频率分量,因此本实验不包括它。

图5:。与完全可学习的通道注意力进行比较。FR表示具有随机初始化的固定张量,LR表示具有随机初始化的学习张量,LD表示具有DCT初始化的学习张量,FD表示具有DCT初始化的固定张量,这是我们的方法。对于随机初始化的设置,将显示错误栏。

4.3. 讨论

多光谱框架如何压缩和存储更多信息。3.2,我们表明,仅在通道注意力中使用GAP实际上是丢弃除最低频率分量(即GAP)之外的所有其他频率分量的信息。这样,在频域中推广通道注意力并使用多光谱框架可以自然地在通道注意力机制中嵌入更多信息。

除了上述推导之外,我们还进行了思维实验,以表明可以嵌入更多的信息。众所周知,深层网络是冗余的。

如果两个通道彼此冗余,我们只能使用GAP获得相同的信息。然而,在我们的多光谱框架中,由于不同的频率分量包含不同的信息,因此可以从冗余信道中提取更多的信息。这样,所提出的多光谱框架可以在通道注意力机制中嵌入更多的信息。

复杂性分析我们从两个方面分析了我们方法的复杂性:参数数量和计算成本。

对于参数数目,由于二维DCT的权值是预先计算的常数,因此与基线传感器相比,该方法没有额外的参数。

对于计算成本,我们的方法具有可忽略的额外成本,并且可以被视为具有与SENet相同的计算成本。对于ResNet-34、ResNet-50、ResNet-101和ResNet-152主干网,我们的方法的相对计算成本增加为0。04% , 0 . 13% , 0 . 11%和0。与SENet相比,分别为11%。更多结果见表1。

几行代码改变了所提出的多光谱框架的另一个重要特性,即它可以通过现有的信道注意实现轻松实现。我们的方法与SENet的唯一区别是信道压缩方法(GAP与多光谱2D DCT)。如第。3.1和等式7,2D DCT可被视为输入的加权和。它可以简单地通过元素乘法和求和来实现。这样,我们的方法可以很容易地集成到任意通道的注意力方法中。

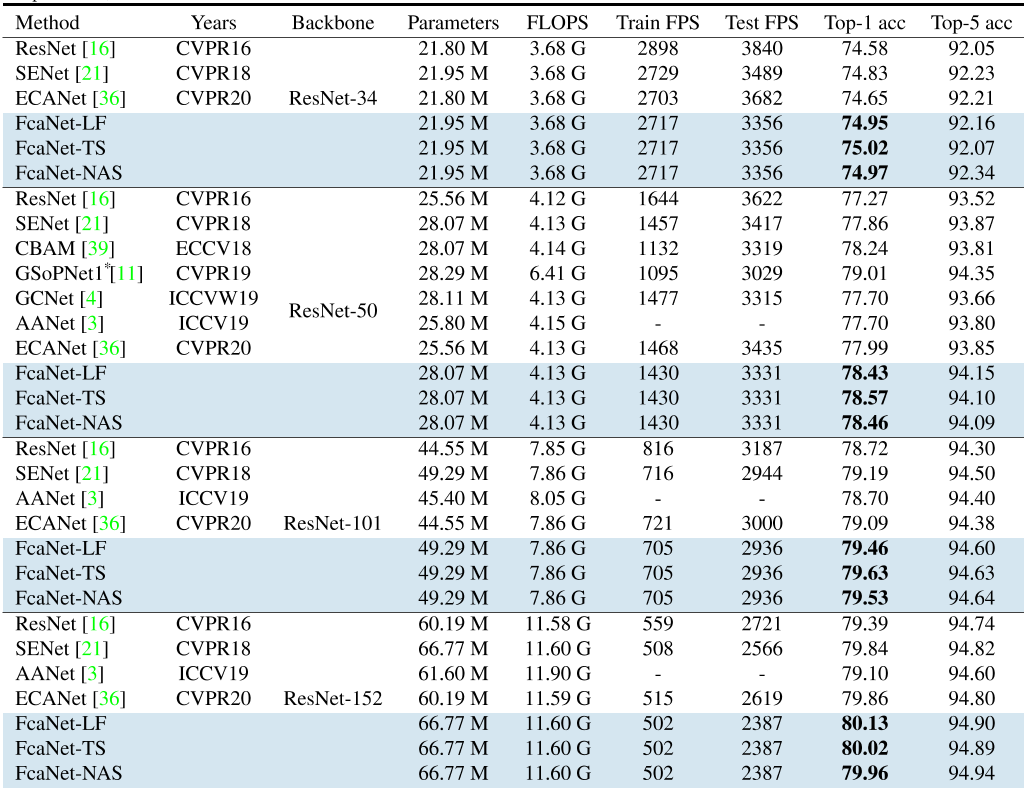

表1:。ImageNet上不同注意力方法的比较。除AANet没有官方代码外,所有结果都是在相同的训练设置下复制和训练的的。

*请注意,虽然GSoPNet1的性能更高,但计算成本是我们的1.5倍。与相同的计算成本相比,我们的方法仍然优于GSoPNet1。详细的比较可在补充文件中找到。

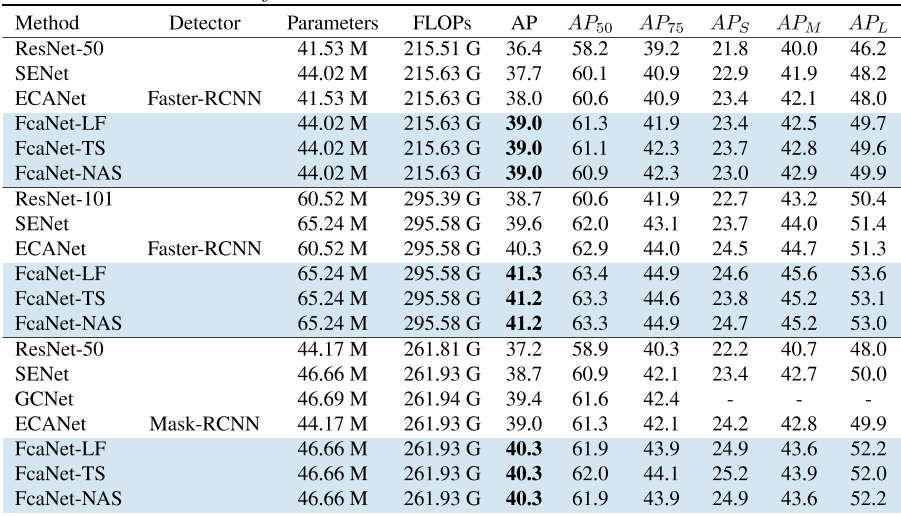

表2:。COCO val 2017上不同方法的物体检测结果。

4.4. ImageNet上的图像分类

我们将我们的FcaNet与使用ImageNet上的ResNet-34、ResNet-50、ResNet-101和ResNet-152主干的最先进方法进行了比较,包括SENet[21]、CBAM[39]、GSoP-Net1[11]、GCNet[4]、AANet[3]和ECANet[36]。评估指标包括效率(即网络参数、浮点运算/秒(FLOPs)和帧/秒(FPS))和有效性(即前1/前5精度)。如表1所示,我们的方法几乎在所有实验设置中都达到了最佳的表现。

4.5. 基于MS-COCO的目标检测

除了在ImageNet上的分类任务外,我们还对我们的目标检测任务进行了评估,以验证其有效性和泛化能力。我们使用带有FPN的FcaNet[25]作为更快的R-CNN和Mask R-CNN的主干(ResNet-50和ResNet-101),并在MS COCO数据集上测试其表现。SENet、CBAM、GC-Net和ECANet用于比较。

如表2所示,我们的方法也可以在更快的RCNN和Mask-RCNN框架下获得最佳的表现。与ImageNet上的分类任务相同,FcaNet也可以在相同的参数数量和计算成本下大大优于SENet。与SOTA方法ECANet相比,FcaNet在AP方面的表现优于它0.9-1.3%。

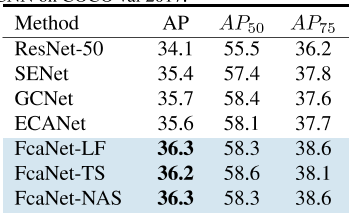

4.6. 基于MS-COCO的实例分割除了目标检测之外,我们还将我们的方法用于实例分割任务。如表3所示,我们的方法比其他方法有更大的优势。具体而言,FcaNet的表现优于GCNet 0.5%,而其他方法之间的差距约为0.1-0.2%。这些结果验证了我们方法的有效性。

表3:。COCO val 2017上使用Mask R-CNN的不同方法的实例分割结果。

5、结论

在本文中,我们研究了通道注意力的一个基本问题,即如何表示通道,并将此问题视为一个压缩过程。我们证明了GAP是DCT的一种特例,并提出了带有多谱注意力模块的FcaNet,它在频域上推广了现有的信道注意力机制。同时,我们探索了多光谱框架中频率分量的不同组合,并提出了三个频率分量选择标准。在参数数量和计算成本相同的情况下,我们的方法始终优于SENet。与其他通道注意力方法相比,我们在图像分类、目标检测和实例分割方面也取得了最先进的表现。

此外,FcaNet简单而有效。基于现有的通道注意力方法,我们的方法只需更改几行代码即可实现。

致谢

这项工作得到了2020AAA0107400国家重点研究开发项目、LR19F020004浙江省自然科学基金、教育部科技创新重点研究项目和U20A20222国家自然科学基金的部分支持。

参考文献

[1] Nasir Ahmed, T Natarajan, and Kamisetty R Rao. discrete cosine transform. IEEE Trans. Comput. , 100(1):90–93, 1974. 2 , 3

[2] Mario Barbero, H Hofmann, and ND Wells. Dct source cod- ing and current implementations for hdtv. EBU Technical Review , (251):22–33, 1992. 2

[3] Irwan Bello, Barret Zoph, Ashish Vaswani, Jonathon Shlens, and Quoc V Le. Attention augmented convolutional net- works. In Int. Conf. Comput. Vis. , pages 3286–3295, 2019. 2 , 7 , 8

[4] Yue Cao, Jiarui Xu, Stephen Lin, Fangyun Wei, and Han Hu. Gcnet: Non-local networks meet squeeze-excitation net- works and beyond. In IEEE Conf. Comput. Vis. Worksh. , pages 0–0, 2019. 2 , 7 , 8

[5] Kai Chen, Jiaqi Wang, Jiangmiao Pang, Yuhang Cao, Yu Xiong, Xiaoxiao Li, Shuyang Sun, Wansen Feng, Ziwei Liu, Jiarui Xu, Zheng Zhang, Dazhi Cheng, Chenchen Zhu, Tian- heng Cheng, Qijie Zhao, Buyu Li, Xin Lu, Rui Zhu, Yue Wu, Jifeng Dai, Jingdong Wang, Jianping Shi, Wanli Ouyang, Chen Change Loy, and Dahua Lin. MMDetection: Open mmlab detection toolbox and benchmark. arXiv preprint arXiv:1906.07155 , 2019. 5

[6] Wenlin Chen, James Wilson, Stephen Tyree, Kilian Q Wein- berger, and Yixin Chen. Compressing convolutional neural networks in the frequency domain. In SIGKDD , pages 1475– 1484, 2016. 2

[7] Yunpeng Chen, Yannis Kalantidis, Jianshu Li, Shuicheng Yan, and Jiashi Feng. A 2-nets: Double attention networks. In Adv. Neural Inform. Process. Syst. , pages 352–361, 2018. 2

[8] Max Ehrlich and Larry S Davis. Deep residual learning in the jpeg transform domain. In Int. Conf. Comput. Vis. , pages 3484–3493, 2019. 2

[9] Jun Fu, Jing Liu, Haijie Tian, Yong Li, Yongjun Bao, Zhiwei Fang, and Hanqing Lu. Dual attention network for scene

segmentation. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 3146–3154, 2019. 2

[10] Hiroshi Fukui, Tsubasa Hirakawa, Takayoshi Yamashita, and Hironobu Fujiyoshi. Attention branch network: Learning of attention mechanism for visual explanation. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 10705–10714, 2019. 2

[11] Zilin Gao, Jiangtao Xie, Qilong Wang, and Peihua Li. Global second-order pooling convolutional networks. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 3024–3033, 2019. 2 , 7 , 8

[12] Priya Goyal, Piotr Dollár, Ross Girshick, Pieter Noord- huis, Lukasz Wesolowski, Aapo Kyrola, Andrew Tulloch, Yangqing Jia, and Kaiming He. Accurate, large mini- batch sgd: Training imagenet in 1 hour. arXiv preprint arXiv:1706.02677 , 2017. 5

[13] Lionel Gueguen, Alex Sergeev, Ben Kadlec, Rosanne Liu, and Jason Yosinski. Faster neural networks straight from jpeg. In Adv. Neural Inform. Process. Syst. , pages 3933– 3944, 2018. 2

[14] Hao Guo, Kang Zheng, Xiaochuan Fan, Hongkai Yu, and Song Wang. Visual attention consistency under image trans- forms for multi-label image classification. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 729–739, 2019. 2

[15] Kaiming He, Georgia Gkioxari, Piotr Dollár, and Ross Gir- shick. Mask r-cnn. In Int. Conf. Comput. Vis. , pages 2961– 2969, 2017. 5

[16] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. Deep residual learning for image recognition. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 770–778, 2016. 5 , 7

[17] Tong He, Zhi Zhang, Hang Zhang, Zhongyue Zhang, Jun- yuan Xie, and Mu Li. Bag of tricks for image classification with convolutional neural networks. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 558–567, 2019. 5

[18] Yihui He, Xiangyu Zhang, and Jian Sun. Channel pruning for accelerating very deep neural networks. In Int. Conf. Comput. Vis. , pages 1389–1397, 2017. 6

[19] Qibin Hou, Daquan Zhou, and Jiashi Feng. Coordinate attention for efficient mobile network design. arXiv preprint arXiv:2103.02907 , 2021. 2

[20] Jie Hu, Li Shen, Samuel Albanie, Gang Sun, and Andrea Vedaldi. Gather-excite: Exploiting feature context in con- volutional neural networks. In Adv. Neural Inform. Process. Syst. , pages 9401–9411, 2018. 2

[21] Jie Hu, Li Shen, and Gang Sun. Squeeze-and-excitation net- works. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 7132–7141, 2018. 2 , 3 , 5 , 7 , 8

[22] William Lea. Video on demand . House of Commons Library, 1994. 2

[23] HyunJae Lee, Hyo-Eun Kim, and Hyeonseob Nam. Srm: A style-based recalibration module for convolutional neu- ral networks. In Int. Conf. Comput. Vis. , pages 1854–1862, 2019. 1 , 2 , 3

[24] Xiang Li, Wenhai Wang, Xiaolin Hu, and Jian Yang. selective kernel networks. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 510–519, 2019. 2

[25] Tsung-Yi Lin, Piotr Dollár, Ross Girshick, Kaiming He, Bharath Hariharan, and Serge Belongie. Feature pyramid

networks for object detection. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 2117–2125, 2017. 8

[26] Tsung-Yi Lin, Michael Maire, Serge Belongie, James Hays, Pietro Perona, Deva Ramanan, Piotr Dollár, and C Lawrence Zitnick. Microsoft coco: Common objects in context. In Eur. Conf. Comput. Vis. , pages 740–755, 2014. 5

[27] Zhenhua Liu, Jizheng Xu, Xiulian Peng, and Ruiqin Xiong. Frequency-domain dynamic pruning for convolutional neu- ral networks. In Adv. Neural Inform. Process. Syst. , pages 1043–1053, 2018. 2

[28] Jongchan Park, Sanghyun Woo, Joon-Young Lee, and In So Kweon. Bam: Bottleneck attention module. arXiv preprint arXiv:1807.06514 , 2018. 2

[29] Adam Paszke, Sam Gross, Francisco Massa, Adam Lerer, James Bradbury, Gregory Chanan, Trevor Killeen, Zeming Lin, Natalia Gimelshein, Luca Antiga, et al. Pytorch: An imperative style, high-performance deep learning library. In Adv. Neural Inform. Process. Syst. , pages 8026–8037, 2019. 5

[30] K Ramamohan Rao and Ping Yip. Discrete cosine trans- form: algorithms, advantages, applications . Academic press, 2014. 2

[31] Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. Faster r-cnn: Towards real-time object detection with region proposal networks. In Adv. Neural Inform. Process. Syst. , pages 91–99, 2015. 5

[32] Abhijit Guha Roy, Nassir Navab, and Christian Wachinger. Recalibrating fully convolutional networks with spatial and channel “squeeze and excitation” blocks. IEEE Medical Imaging , pages 540–549, 2018. 2

[33] Olga Russakovsky, Jia Deng, Hao Su, Jonathan Krause, San- jeev Satheesh, Sean Ma, Zhiheng Huang, Andrej Karpathy, Aditya Khosla, Michael Bernstein, Alexander C. Berg, and Li Fei-Fei. Imagenet large scale visual recognition challenge. Int. J. Comput. Vis. , pages 211–252, 2015. 5

[34] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszko- reit, Llion Jones, Aidan N Gomez, Łukasz Kaiser, and Illia Polosukhin. Attention is all you need. In Adv. Neural Inform. Process. Syst. , pages 5998–6008, 2017. 1

[35] Fei Wang, Mengqing Jiang, Chen Qian, Shuo Yang, Cheng Li, Honggang Zhang, Xiaogang Wang, and Xiaoou Tang. Residual attention network for image classification. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 3156–3164, 2017. 2

[36] Qilong Wang, Banggu Wu, Pengfei Zhu, Peihua Li, Wang- meng Zuo, and Qinghua Hu. Eca-net: Efficient channel attention for deep convolutional neural networks. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 11534–11542, 2020. 2 , 3 , 7 , 8

[37] Xiaolong Wang, Ross Girshick, Abhinav Gupta, and Kaim- ing He. Non-local neural networks. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 7794–7803, 2018. 2

[38] Yunhe Wang, Chang Xu, Shan You, Dacheng Tao, and Chao Xu. Cnnpack: Packing convolutional neural networks in the frequency domain. In Adv. Neural Inform. Process. Syst. , pages 253–261, 2016. 2

[39] Sanghyun Woo, Jongchan Park, Joon-Young Lee, and In So Kweon. Cbam: Convolutional block attention module. In Eur. Conf. Comput. Vis. , pages 3–19, 2018. 1 , 2 , 3 , 7 , 8

[40] Kelvin Xu, Jimmy Ba, Ryan Kiros, Kyunghyun Cho, Aaron Courville, Ruslan Salakhudinov, Rich Zemel, and Yoshua Bengio. Show, attend and tell: Neural image caption generation with visual attention. In Int. Conf. Mach. Learn. , pages 2048–2057, 2015. 1 , 2

[41] Kai Xu, Minghai Qin, Fei Sun, Yuhao Wang, Yen-Kuang Chen, and Fengbo Ren. Learning in the frequency domain. In IEEE Conf. Comput. Vis. Pattern Recog. , pages 1740– 1749, 2020. 2 , 5

[42] Hang Zhang, Chongruo Wu, Zhongyue Zhang, Yi Zhu, Zhi Zhang, Haibin Lin, Yue Sun, Tong He, Jonas Mueller, R Manmatha, et al. Resnest: Split-attention networks. arXiv preprint arXiv:2004.08955 , 2020. 2 [43] Yulun Zhang, Kunpeng Li, Kai Li, Lichen Wang, Bineng Zhong, and Yun Fu. Image super-resolution using very deep residual channel attention networks. In Eur. Conf. Comput. Vis. , pages 286–301, 2018. 2

[44] Ting Zhao and Xiangqian Wu. Pyramid feature attention network for saliency detection. In IEEE Conf. Comput. Vis. pattern Recog. , pages 3085–3094, 2019. 2

[45] Xizhou Zhu, Dazhi Cheng, Zheng Zhang, Stephen Lin, and Jifeng Dai. An empirical study of spatial attention mecha- nisms in deep networks. In Int. Conf. Comput. Vis. , pages 6688–6697, 2019. 2

[46] Zhuangwei Zhuang, Mingkui Tan, Bohan Zhuang, Jing Liu, Yong Guo, Qingyao Wu, Junzhou Huang, and Jinhui Zhu. Discrimination-aware channel pruning for deep neural net- works. In Adv. Neural Inform. Process. Syst. , pages 875–886, 2018. 6

最后

以上就是平淡羽毛最近收集整理的关于FcaNet: Frequency Channel Attention NetworksFcaNet: 频率域通道注意力网络的全部内容,更多相关FcaNet:内容请搜索靠谱客的其他文章。

发表评论 取消回复