原来不是说好的不做视频与图像改做NLP方向了吗,怎么这篇又是关于原来方面的。因为突然想起了原来的一个点子,是关于卷积神经网络学习算法的,希望通过这个算法使得CNN能够对视频数据进行学习。我是希望先琢磨下这个想法的可行性,然后把它交给师弟师妹们来做,也算是尽了当师兄的责任,以及对原来组员的一个交代吧。所以之后的几篇博客可能还是关于这个方向的。

本篇文章的主要工作是将时序性数据中的时间相干性引入到深度学习的模型结构中去,使其能够对无标签的视频数据进行学习。时间相干性指的是“two successive frames are likely to contain the same object or objects”。时间相干性可以用在无标签的数据中进行有监督的学习,同时其也能有效提高监督型学习任务的学习效果。

半监督学习方法以及transduction都可以通过为无标签数据赋予一个类标签的方法来处理无标签数据。但是如果无标签的数据来源于不同的数据源,那么就无法对其所属类别进行估计,之前传统的方法就无法被使用了。视频数据就是这样的一类数据。

虽然说本篇文章所提出的模型是为了识别视频中的物体,但是可以通过改变模型的目标函数,使得其同样能够适用于其他的任务中。这点上感觉与迁移学习的目的有些类似。记得前面也有一篇博客中也有提到迁移学习的问题。寻求一个较为统一的模型,一直也是我们所追求的。

如果从生物学的观点来看,生物的学习过程并不是以一种纯监督的形式进行的,所以监督型的学习算法并不是一种最优的方式。而本篇文章中利用视频数据中的时间相干性的方法“provide a natural, abundant source of data which seems a more biologically plausible signal than used in most current machine learning tasks”。

将视频中的时间相干性特点引入到模型中,其能带来的好处在于“enforce the representation of input images in the deep layers of the neural network to be similar if we know that the same scene is represented in the input images”。假设 和

和 表示两张图片,

表示两张图片, 和

和 表示两张图片在第l层上的表示。如果

表示两张图片在第l层上的表示。如果 ,

, 是一个视频中连续的两帧图片,则我们希望

是一个视频中连续的两帧图片,则我们希望 和

和 尽可能接近。可以使用如下公式来表示:

尽可能接近。可以使用如下公式来表示:

其中 表示两者之间间隔的大小,典型值可以取1。

表示两者之间间隔的大小,典型值可以取1。

在实际应用中,只是在模型的倒数第二层中使用了时间相干性的特征。实际上我们可以在模型的任何一层使用上这一特征。为什么作者做了这样一种选择,其原因在于“the  distance we use may not be appropriate for the log probability representation in the last layer”。在对模型进行训练时,所使用的是随机梯度下降法,以及“siamese network”的结构,是使用共享模型参数的两个网络来同时计算两张图片。具体结构如下:

distance we use may not be appropriate for the log probability representation in the last layer”。在对模型进行训练时,所使用的是随机梯度下降法,以及“siamese network”的结构,是使用共享模型参数的两个网络来同时计算两张图片。具体结构如下:

整个模型的目标函数如下:

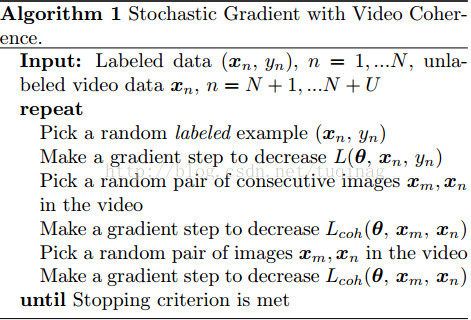

为了限制模型中参数的个数,令 。整个模型的学习算法如下:

。整个模型的学习算法如下:

最后

以上就是还单身小兔子最近收集整理的关于Deep Learning 读书笔记(十五):Deep Learning from Temporal Coherence in Video的全部内容,更多相关Deep内容请搜索靠谱客的其他文章。

![[2021] Spatio-Temporal Graph Contrastive Learning21-Spatio-Temporal Graph Contrastive Learning](https://file2.kaopuke.com:8081/files_image/reation/bcimg1.png)

![[文献阅读]——Prefix-Tuning: Optimizing Continuous Prompts for Generation前言任务介绍Prefix-Tuning实验其它](https://file2.kaopuke.com:8081/files_image/reation/bcimg4.png)

发表评论 取消回复