我是靠谱客的博主 任性大地,这篇文章主要介绍论文阅读 | LEARNING VIDEO REPRESENTATIONS USING CONTRASTIVE BIDIRECTIONAL TRANSFORMER,现在分享给大家,希望可以做个参考。

1. 论文链接:https://arxiv.org/abs/1906.05743

2. 论文分类:自监督,视频语言特征联合学习

3. 论文目的:利用BERT和对比学习算法学习视频特征

4. 论文算法:

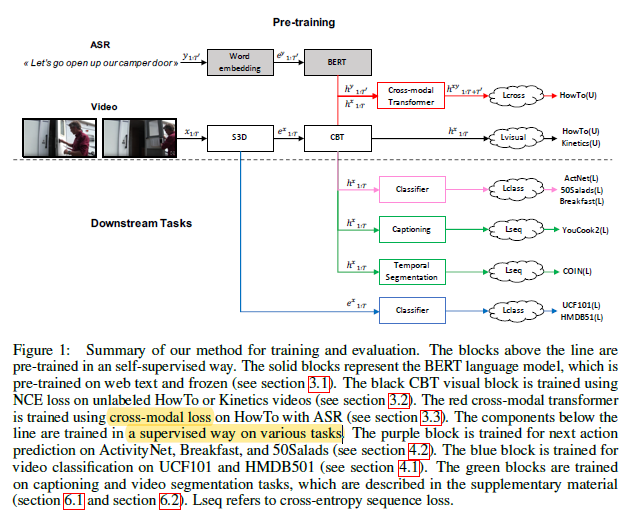

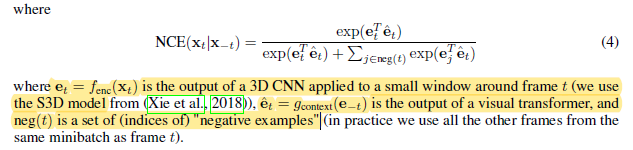

主要过程:先分别将视频和语音文本输入到CBT和BERT中,得到序列特征(因为先用了两个独立的stream来处理两个序列,所以不需要像VideoBERT那样额外对视频序列进行量化,而是通过两个stream都将序列变成连续特征),然后将两个序列特征拼接在一起经过一个cross-modal CBT。其中CBT模型使用NCE loss进行训练,也就是正样本和负样本以1比K的比例进行采样,然后计算两两的相关性,进行softmax:

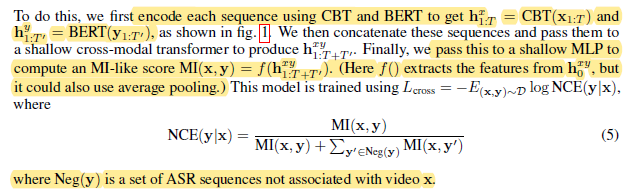

而cross-moal CBT的NCE loss类似:

5. 论文实验

数据集:预训练数据集为unlabeled RGB-only Kinetics和HowTo100M,用于训练S3D和CBT,在UCF101,HMDB51,Breakfast, 50Salads,ActivityNet,YouCook2,COIN数据集上进行下游任务评估。

预训练过程:

(1)自监督视觉特征学习:先预训练S3D模型,然后finetune S3D最后一个block以及CBT模型(2层Transformer layers,4 attention head,768 hidden units)。

(2)自监督时序特征学习:先用Kinetics预训练S3D模型,然后利用HowTo100M dataset预训练CBT和cross-modal CBT模型。

评估任务:

(1)action recognition

(2)action anticipation(预测未来的action标签)

(3)video captioning

(4)video segmentation

最后

以上就是任性大地最近收集整理的关于论文阅读 | LEARNING VIDEO REPRESENTATIONS USING CONTRASTIVE BIDIRECTIONAL TRANSFORMER的全部内容,更多相关论文阅读内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

![[2021] Spatio-Temporal Graph Contrastive Learning21-Spatio-Temporal Graph Contrastive Learning](https://www.shuijiaxian.com/files_image/reation/bcimg1.png)

发表评论 取消回复