ResNet 及其变体

自从

AlexNet

在

LSVRC2012

分类比赛中取得胜利之后,深度残差网络(deep Residual

Network

)可以说成为过去几年中,在计算机视觉、深度学习社区领域中最具突破性的成果了。

ResNet

可以实现高达数百,甚至数千个层的训练,且仍能获得超赞的性能。

得益于其强大的表征能力,许多计算机视觉应用在图像分类以外领域的性能得到了提升,如对象检测和人脸识别。

自从

2015

年

ResNet

进入人们的视线,并引发人们思考之后,许多研究界人员已经开始研究其成功的秘诀,并在架构中纳入了许多新的改进。本文分为两部分,第一部分我将为那些不熟ResNet

的人提供一些相关的背景知识,第二部分我将回顾一些我最近读过的关于

ResNet架构的不同变体及其论文的相关阐述。

重新审视 ResNet

根据泛逼近性原理(universal approximation theorem),我们知道,如果给定足够的容量,一个具有单层的前馈网络足以表示任何函数。然而,该层可能是巨大的,且网络可能容易过度拟合数据。因此,研究界有一个共同的趋势,即我们的网络架构需要更深。

自从

AlexNet

投入使用以来,最先进的卷积神经网络(

CNN

)架构越来越深。虽然

AlexNet只有 5

层卷积层,但

VGG

网络和

GoogleNet

(代号也为

Inception_v1

)分别有

19

层和

22

层。

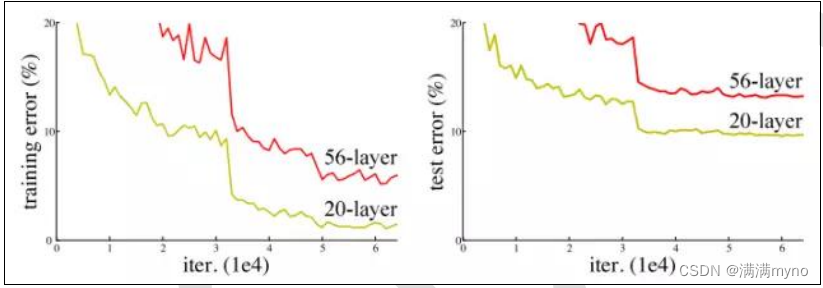

但是,如果只是通过简单地将层叠加在一起,增加网络深度并不会起到什么作用。由于有着臭名昭著的梯度消失问题,深层网络是难以进行训练的,因为梯度反向传播到前层,重复乘法可能使梯度无穷小,而造成的结果就是,随着网络的深层,其性能趋于饱和,或者甚至开始迅速退化。

增加网络深度导致性能下降

其实早在

ResNet

之前,已经有过好几种方法来处理梯度消失问题,例如,在中间层增加辅助损失作为额外的监督,但遗憾的是,似乎没有一个方法可以真正解决这个问题。ResNet 的核心思想是引入所谓的

“

身份近路连接(identity shortcut connection)

”

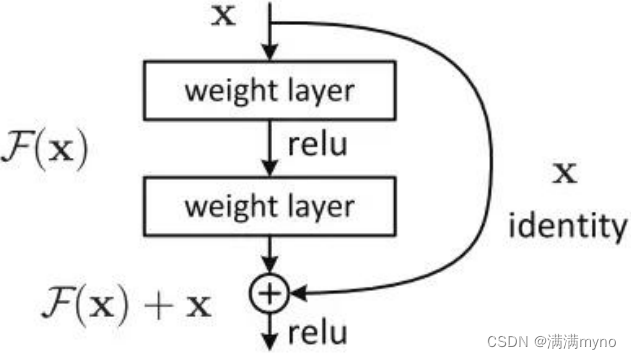

,可以跳过一层或多层,如下图所示:

ResNet 架构

事实上,ResNet 并不是第一个利用近路连接、Highway Networks 引入门控近路连接的。这些参数化门控制允许多少信息流过近路(shortcut)。类似的想法可以在长短期记忆网络 (LSTM)单元中找到,其中存在参数化的忘记门,其控制多少信息将流向下一个时间步。因此,ResNet 可以被认为是 Highway Networks 的一种特殊情况。 然而,实验表明,Highway Networks 的性能并不如 ResNet,因为 Highway Networks 的解决方案空间包含 ResNet,因此它应该至少表现得像 ResNet 一样好。这就表明,保持这些“梯 度公路”干净简洁比获取更大的解决方案空间更为重要。

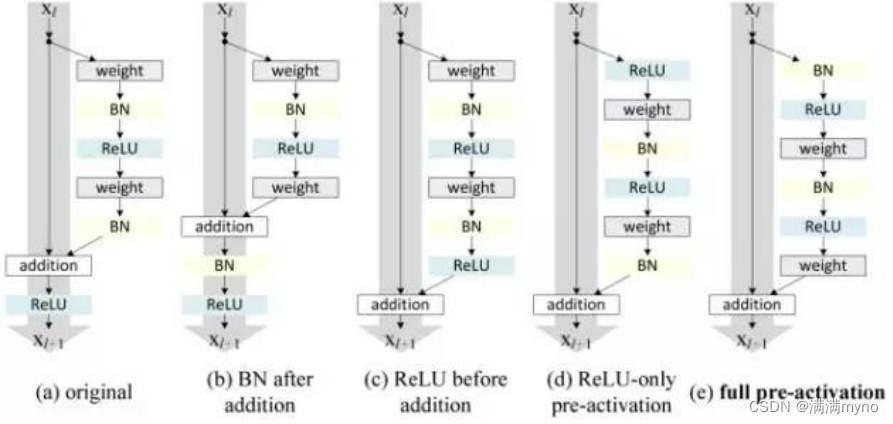

照着这种直觉,《用于图像识别的深度残差学习》的作者改进了残差块,并提出了一个残差块的预激活变体,其中梯度可以畅通无阻地通过快速连接到任何其他的前层。事实上,在《用于图像识别的深度残差学习》中表明,使用原始的残差块,训练 1202 层 ResNet 所展示的性能比其训练 110 层对等物要差得多。

残差块的变体

《深度残差网络中的身份映射》的作者通过实验证明,他们现在可以训练一种 1001 层的深度 ResNet,以超越其较浅层的对手。 由于其令人信服的结果,ResNet 迅速成为各种计算机视觉任务中最流行的架构之一。

ResNet 的最新变体和阐述.

随着 ResNet 在研究界越来越受欢迎,其架构获得大量研究。在本节中,我将首先介绍几种基于 ResNet 的新架构,然后介绍一篇论文,阐述一下将 ResNet 作为许多小型网络的集合的缘由。

最后

以上就是任性蜗牛最近收集整理的关于四、经典网络10(resNet)的全部内容,更多相关四、经典网络10(resNet)内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复