文章目录

- 爬虫基本原理

- 爬虫概述

- 能抓怎样地数据

- JavaScript渲染页面

- 会话和Cooikes

- 静态网页和动态网页

- 无状态HTTP

- 代理的基本原理

- 基本原理

- 代理的作用

- 爬虫代理

- 代理分类

- 常见的代理设置

爬虫基本原理

我们可以把互联网比作一张大网,而爬虫(即网络爬虫)就是在网上爬行的蜘蛛。信息。把节点间的连线比作网页与网页之间的连接关系,这样蜘蛛可以通过一个节点后,顺着节点连线爬行到达下一个节点,即通过一个网页可以继续获取网页的网页,这样整个网的节点便便可以被蜘蛛全部爬行,网站的数据就可以被抓取下来了。

爬虫概述

简单来说,爬虫就是获取网页并提取和保存信息的自动化程序。下面简要概括一下。

1.获取网页

爬虫给首先要做的工作就是获取网页,这里就是获取网页的源代码。 源代码里包含了网页的部分有用信息,所以只要把源代码获取下来,就可以从中提取想要的信息了。

Python提供了许多库来帮助我们实现这个操作,如urlib、requests等。我们可以用这些库来帮我们实现HTTP请求操作,请求和响应都可以用类库提供的数据结构来表示,得到相应之后只需要解析数据结构中的Body部分即可,即得到网页的源代码,这样我们可以用程序来实现获取网页的过程了。

2.提取信息

获取网页源代码后,接下来就是分析网页源代码,从中提取我们想要的数据。首先,最通用的方法便是采用正表达式提取,这是一个万能的方法,但是在构造正则表达式时比较复杂且容易出错。

提取信息是爬虫非常重要的部分,它可以使杂乱的数据变得条理清晰,以便我们后续处理和分析数据。

3.保存数据

提取信息后,我们一般会将提取到的数据保存到某处以便后续使用。这里保存形式有多种多样,如可以简单保存为TXT文本或JSON文本,也可以保存到数据库,如MySQl和MongoDB等,也可以保存至远程服务器,如借助SFTP进行操作等。

4.自动化程序

爬虫就是代替我们来完成这份爬取工作的自动化程序,它可以在抓取过程中进行各种异常处理、错误重试等操作,确保爬取持续高效地进行。

能抓怎样地数据

在网页中我们能看到各种各样地信息,最常见的便是网页,它们对应着HTML代码,而最常抓取的便是HTML源代码。另外,可能有些网页返回的不是HTML代码,而是一个JSON字符串(其中API接口大多使用这样的形式)。还有一些二进制数据,如图片、视频和音频等。利用爬虫,以及各种扩展名的文件,如CSS、JavaScript和配置文件等,这些都i可以进行抓取。

上述内容其实都对应各自的URL,是基于HTTP和HTTPS协议的,只要是这种数据,爬虫都可以抓取。

JavaScript渲染页面

有时候,我们在使用urllib或requests抓取网页时,得到的源代码实际和浏览器中看到的不一样。

这是一个非常常见的问题。现在网页越来越多地采取Ajax、前端模块化工具来构建,整个网页可能都是由JavaScript渲染出来的,也就是说原始的HTML代码就是一个空壳,例如:

<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<title>This is a Demo</title>

</head>

<body>

<div id="container">

</div>

</body>

<script src="app.js"></script>

</html>

body节点里面只有一个id为container的节点,但需要注意在body节点后引入了app.js,它便能完成网站的渲染。

在浏览器中打开这个页面的时候,首先会加载这个 HTML 内容,然后这个浏览器会发现引入了一个 app.js 文件,然后再去请求文件,获取到文件后,可能会出现其中的JavaScript代码,而JavaScript向修改HTML中的节点,其添加内容,最终得到完整的页面。

但是在用urllib或requests等库请求当前页面时,我们得到的只是这个HTML代码,它不会帮助我们继续加载这个JavaScript文件,这样就可以看不到浏览器中的内容了。

这也解释了为什么有时我们会得到源代码和浏览器中看到的不一样。

会话和Cooikes

在浏览网站的过程中,我们经常会遇到需要登录的情况,某些页面只有登录之后才可以访问,而且登录之后可以连续访问很多次网站,但是已经过生日就需要重新登录。网站,在打开器时就自动登录了,而且很长时间都不会失效,这种情况又是为什么?这里面涉及会话(Session)和Cookies的相关知识。

静态网页和动态网页

我们需要先了解一下静态网页和动态网页的概念。

<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<title>This is a Demo</title>

</head>

<body>

<div id="container">

<div class="wrapper">

<h2 class="title">Hello World</h2>

<p class="text">Hello, this is a paragraph.</p>

</div>

</div>

</body>

</html>

这是最基本的HTML代码,我们将其保存为一个.html文件,然后把它放在某个台拥有固定公网IP的主机上,主机上装上Apache或Nginx等服务器,这样这台主机就可以作为服务器了,其他人可以通过访问服务器查看页面,就搭建了一个最简单的网站。

这种网页的内容是HTML代码编写的,文字、土浦安等内容均是通过写好的HTML代码来指定,这种页面叫做静态页面。它加载速度快,编写简单,但是存在很大的缺陷, 如可维护性差,不能根据URL灵活多变地显示内容等。例如,我们想给这个网页地URL传参,就没法做到。

因此,动态网页应运而生,它可以动态解析URL中参数的变化,关联数据库并动态呈现不同的页面内容,非常灵活多变。我们现在遇到的大多数网站都是动态网站,它们不再是一个简单的HTML,而可能是由JSP、PHP、Python等语言编写的,其功能比静态网页强大和丰富多了。

再回到我们开始说的,很多页面需要登录后才能查看。按照一般逻辑,输入用户名和密码之后,肯定是拿到了一种类似凭证的东西,有了它,我们才能保持登录状态,才能访问登录之后才能看到的页面。这种凭证其实就是会话和Cooikes共同产生的结果。

无状态HTTP

在了解会话和Cooikes之前,我们还需要了解HTTP的一个特带你,叫做无状态。

HTTP的无状态是指HTTP协议对事务处理是没有记忆能力的,也就是说服务器不知道客户端是什么状态。 当我们向服务器请求请求后,服务器解析此,返回的响应响应,服务负责完成这个过程,而且这个过程是完全独立的,服务器不会记录后续状态的变化,也需要缺少状态记录。的重复请求,才能获取及时响应,只是这种状态不是我们想要的。

这时两个用于保持HTTP连接状态的技术就出现了,它们分别是会话和Cooikes。会话在服务端,也就是网站的服务器,用来保存用户的会话信息;Cooikes在客户端,也可以理解为浏览器端,有了Cooikes,浏览器在下次访问网页时会自动附带上它发送给服务器,服务器通过识别Cooikes并鉴定出是哪个用户,然后再判断用户是否为登陆状态,然后返回对它的响应。

我们可以理解为Cooikes里面保存了登录的凭证,有了它,只需要在下次请求携带Cooikes发送请求而不必重新输入用户名、密码等信息重新登陆了。

因此在爬虫中,有时候需要处理登录才能访问的页面时,我们一般会直接将登陆成功后获取的Cooikes放在请求头里面直接请求,而不必重新模拟登录。

下面,我来了解一下它们的原理。

1.会话

会话,其本来的意思是指有始有终的一系列动作/消息。例如,电话时,从电话电话拨号到挂断电话中间的一系列过程可以称为一个会话。

而在Web中,会话对象用来存储特定用户会话所需的属性及配置信息。

2.Cooikes

Cooikes指某些网站为了辨别用户身份、进行会话跟踪而存储在用户本地终端上的数据。

会话维持 :

那么,我们怎么利用Cooikes保持状态呢?当客户端第一此请求服务器时,服务器会返回一个请求头中带有Set-Cookie字段的响应给客户端,用来标记是哪一个用户,客户端浏览器会把Cooikes保存起来。当浏览器下次请求该网站的时候,浏览器会把此Cooikes放到请求头一起提交给服务器,Cooikes携带了会话ID信息,服务器检查该Cooikes即可找到对应的会话是什么,然后再判断会话来辨认用户状态。

在成功登录某个网站时,服务器会告知客户端设置哪些 Cookie 信息,在访问页面时客户端将 Cookie 发送给服务器,然后再找到对应的会话判断。变量是有效的,然后显示用户处于登录状态,此时返回登录后才可以查看网页内容,浏览器可以再进行解析便可以看到了。

反之,如果传给服务器的 Cookie 被输入了,或者会话已经过期了,就不能继续访问页面,此时可能会收到错误的响应跳转或者登录页面我们将重登录。

所以,Cookies 和会话需要配合,有一个客户端,一个服务端,二者共同协作,就实现了登录会话控制。

属性结构:

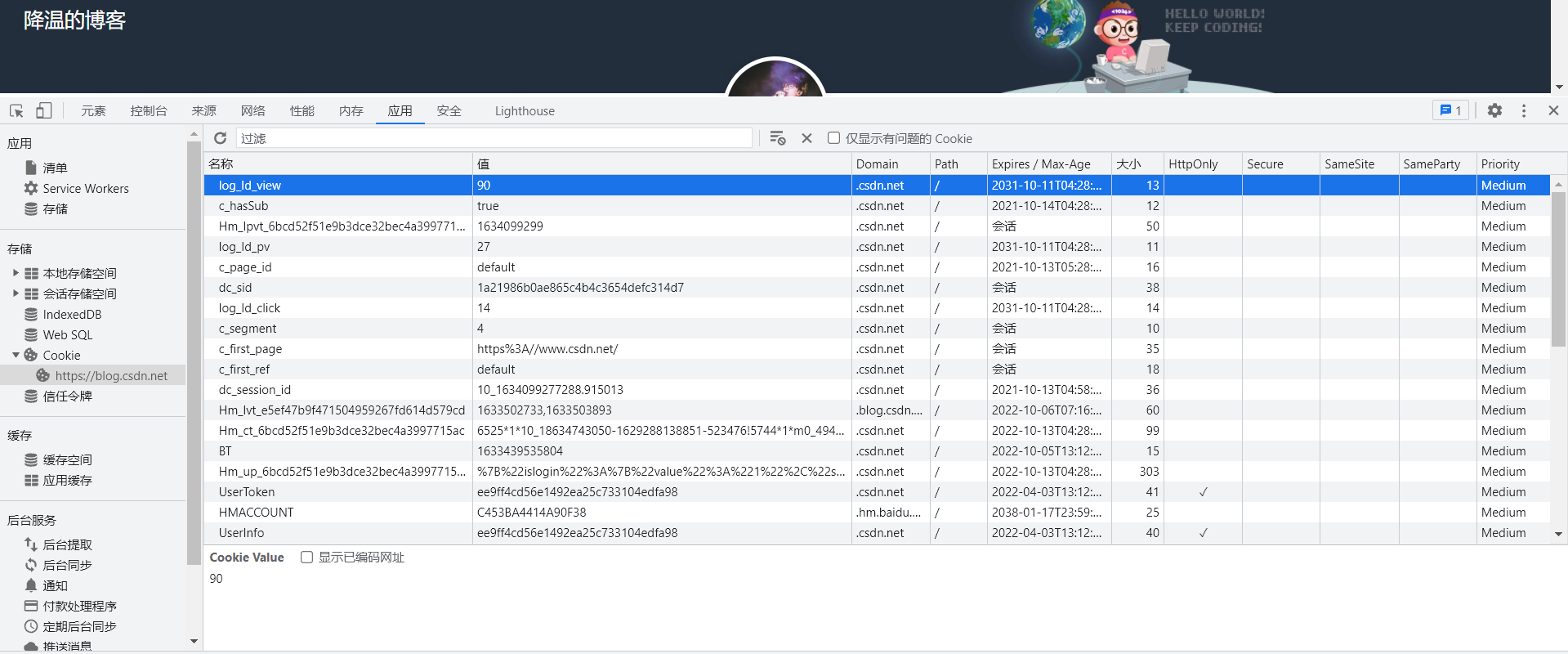

接下来,我们来看看Cooikes有哪些内容。以CSDN为例。

可以看到,这里有很多条目,其中每个条目可以称为Cooike。它有如下几个属性:

- Name:该Cooike的名称。一旦创建,该名称便不可更改。

- Value:该Cooike的值。如果值为Unicode字符,需要为字符编码。如果值为二进制数据,则需要BASE64编码。

- Domain:可以访问该Cooike的域名。例如,如果设置为csdn.net,则所有以csdn.net解为的域名都可以访问。

- Max Age:该Cooike失效的时间,单位为秒,也常和Expires一起使用,通过它可以计算出其有效时间。Max Age如果为正数,则该Cooike在Max Age秒后失效。如果为负数,则关闭浏览器后失效,浏览器也不会以任何形式保存该Cooike。

- Path:该Cooike的使用路径。如果设置为/path/,则只有路径为/path/的页面可以访问该Cooike。如果设置为/,则本域名下的页面都可以访问该Cooike。

- Size字段:此Cooike的大小。

- HTTP字段:Cooike的httponly属性。若此属性为true,则只有在HTTP头中会带有此Cooike的信息,而不能通过document.cooike来访问此Cooike。

- Secure:该Cooike是否仅被使用安全协议传输。安全协议有HTTPS和SSL等,在网络上传输数据之前先将数据加密。默认为false。

会话Cooike和持久Cooike

从表面意思说,会话Cooike就是把Cooike放在浏览器内存里,浏览器在关闭之后该Cooike即失效;持久Cooike则会保存到客户端的硬盘中,下次还可以继续使用,用于长久保持用户登录状态。

其实严格来说,并没有会话Cooike和持久Cooike之分,只是由Cooike的Max Age或Expires字段决定了过期的时间。

一些持久化登录的网站就是把Cooike的有效时间和会话有效期设置得比较长,比如上面的csdn。

代理的基本原理

我们在做爬虫的过程中经常会遇到这样的情况,最初爬虫正在正常运行,正常抓取数据,然会可能会出现403Forbidden,打开网页一看,“您的IP访问频率太高”。出现这样的原因是网站采取了一些反爬虫措施。比如,服务器会检测某个IP在单位时间内的请求次数,如果超过了这个阈值,就会直接拒绝服务,返回一些错误信息,这种情况被称为封IP。

既然服务器检测的是某个IP单位时间的请求次数,那么借助某种方式来伪装我们的IP,让服务器识别不出是由我们本机发起的请求,就可以防止IP被封。一种有效的方式就是代理。

基本原理

代理实际上指的就是代理服务器,英文proxy server,它的功能是代理网络用户去取得网络信息。

求给Web服务器,Web服务器把响应传回给我们。如果设置了代理服务器,实际上就是在本机和服务器之间搭建了一个桥,此时本机不是直接向Web服务器发起请求,模式向代理服务器发出请求,请求会发送给代理服务器,然后由代理服务器再发送给Web服务器,然后由代理服务器再把Web服务器返回的响应转发给本机。这样我们可以正常访问网页,过程中Web服务器识别出这真实IP不再是我们本机的IP了,就成功实现了IP伪装,就是代理的基本原理。

代理的作用

- 突破自身IP访问限制,访问一些平时不能访问的站点。

- 访问一些单位或团体内部资源:比如使用教育网内地址免费代理服务器,就可以用于对教育网开放的各类FTP下载上传,以及各类教育资源查询共享服务。

- 提高访问速度:通常代理服务器都设置一个较大的硬盘缓冲区,当有外界信息通过时,同时保存在缓冲区中,当其他用户再访问相同信息时,则由缓冲区中直接取出信息,提高访问速度。

- 隐藏真实IP:上网者也可以通过这种方法隐藏自己的IP,免受攻击。对于爬虫来说,我们用代理就是为了隐藏自身IP,防止自身的IP被封锁。

爬虫代理

对于爬虫来说,由于爬虫爬取速度过快,在爬取过程中可能遇到了一个IP访问过于频繁的问题,此时网站就会让我们让我们输入验证码或者直接封锁IP,这样一来给爬取带来极大的不便。

使用隐藏代理的真实IP,让服务器误以为是代理服务器在请求自己。这样在爬取过程中通过不断更换代理,就不会被成功,可以达到很好的爬取效果。

代理分类

1.根据协议区分

- FTP代理服务器:主要用于访问FTP服务器,一般有上传、下载以及缓存功能,端口号一般为21、2121等。

- HTTP代理服务器:主要用于访问网页,一般有内容过滤和缓存功能,端口一般为80、8080、3128等。

- SSL/TLS代理:主要用于访问加密的网站,一般有SSL或TLS加密功能(最高支持128位加密强度),端口一般为443.

- RTSP代理:主要用于访问Real流媒体服务器,一般有缓存功能,端口一般为554.

- Telnet代理:主要用于telnet远程控制(黑客入侵计算机时常用于隐藏身份),端口一般为23.

- POP3/SMTP:主要用于POP3/SMTP方式收发邮件,一般有缓存功能,端口一般为110/25.

- SOCKS代理:只是单纯传递数据包,不关心具体协议和用法,所以速度快很多,一般有缓存功能,端口为1080.SOCKS代理协议又分为SOCKS4和SOCKS5,前者只支持TCP,而后者支持TCP和UDP,还支持各种身份验证机制、服务器域名解析等。

2.根据匿名程度区分 - 高度匿名代理:会将数据包原封不动地转发,在服务端看来就好像真的是一个普通客户端在访问,而记录的IP是代理服务器的IP。

- 普通匿名代理:会在数据包上做一些改动,服务端上有可能发现这是个代理服务器,也有一定几率追查到客户端的真是IP。代理服务器通常会加入的HTTP头有HTTP_VIA和HTTP_X_FORWARDED_FOR。

- 透明代理:不但改了数据包,还会告诉服务器客户端真实的IP。除了能用缓存技术提高浏览速度,能用内容过滤提高安全性之外,并无其他显著作用。最常见的例子就是内网防火墙。

- 间谍代理:指组织或个人创建的用于记录用户传输的数据,然后进行研究、监控等目的的代理服务器。

常见的代理设置

- 使用网上的免费代理:最好使用高匿代理,另外可用的代理不多,需要在使用前筛选一下可用代理,也可以进一步维护一个代理池。

- 使用付费代理服务:互联网上存在许多代理商,可以付费使用,质量比免费代理好很多。

- ASDL拨号:拨一次号换一次IP,稳定性极高,也是一种比较有效的解决方案。

最后

以上就是陶醉酒窝最近收集整理的关于爬虫基础之爬虫基本原理爬虫基本原理会话和Cooikes代理的基本原理的全部内容,更多相关爬虫基础之爬虫基本原理爬虫基本原理会话和Cooikes代理内容请搜索靠谱客的其他文章。

发表评论 取消回复