这是东京工业大学关于人体动作预测的一篇论文,费劲千辛万苦终于下载下来,然后翻译一下与大家一起分享。

Abstract

在本文中,我们提出了一种新的混合现实武术训练系统,该系统采用基于深度学习的实时动作预测的方法。

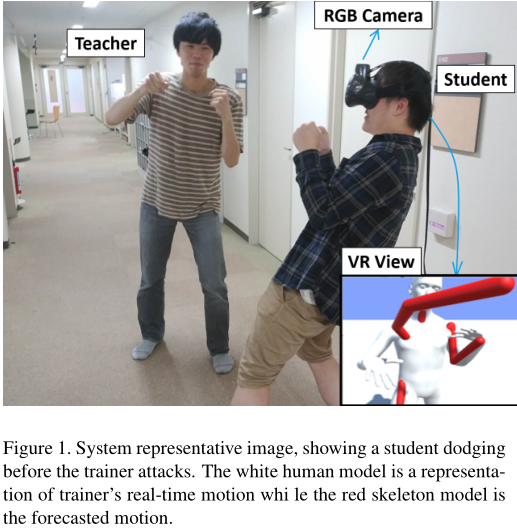

我们的训练系统是基于3D姿态估计,利用从RGB相机作为输入的残差神经网络来捕获教练的运动。头戴显示器的学生可以看到教练的虚拟模型和对他未来姿势的预测。姿态预测是基于循环网络的,为了提高运动时间特征的学习质量,我们采用一种特殊的点阵光流法进行关节运动估计。我们使用一个被生成的人体模型来显示实时的人体运动,而使用一个红色的骨骼模型来显示预测的姿态。在我们的实验中,我们评估了我们的系统的性能,可以在30fps的视频中预测提前15帧(0.5s的预测),它的精确度是可以接受的,因为它与某些使用深度红外相机或微芯片技术的方法相当,甚至更好。用户研究表明,我们的系统有助于初学者理解武术和可用性是可接受的,因为动作用RGB摄像机捕获。

Introduction

姿态估计在人机交互中起着重要的作用,特别是在体育运动中。在许多武术中,比如拳击或跆拳道,它可以分析玩家的习惯,确定他的力量,甚至根据他的动作数据预测他的下一个动作。一个专业的武术运动员可能会从长期的练习中学到这些,然而,这对初学者来说可能是困难的。自从虚拟现实开始流行起来,我们可以将实时姿态预测系统与头戴式显示器相结合提供一个混合现实武术训练系统。然而,最新的3D动作捕捉系统都是基于微芯片技术,这就需要用户穿戴特殊的装备或传感器。因此,用户可能会受到这些设备的干扰,无法发挥最佳水平。另一方面,基于摄像机的动作捕捉系统使用特殊的摄像机,如RGB-Depth或IR摄像机,这可能不适用于所有类型的运动。

理想情况下,我们希望使用普通相机拍摄的简单视频帧来估计或预测玩家的动作。为此,我们提出了一种基于常规RGB帧的实时三维人体姿态估计和预测系统。我们的系统使用自定义的残差网络[10]从输入图像中获取二维人体关节,并使用循环网络(LSTMs[8,11])学习人体运动的时间特征。为了获得精确的运动预测,我们使用光流来表示运动特征。然而,正常的稠密光流需要大量的计算,导致在LSTM中需要大量的推理时间。因此,我们使用一种lattice optical flow算法来计算关节运动,计算量较少。最后将预测的位姿传递到一个简单的线性三维恢复网络中,将预测的二维关节位置进行拟合成3D。

最后使用VR HMD对预测的三维节点进行了校核,使用逆运动学来移动模型,这在虚拟环境中观看真实的人体运动是可能的,被认为是一种混合的现实。要在武术训练中使用这个系统,学生可以穿一个VR HMD来查看教练的实时3D模型和未来3D姿态,如图1所示。由于可以在虚拟环境中调整学员与教练的距离,因此教练不需要站得离学员很近,也不需要真的打学员,从而实现了安全的训练。为了检测教练的三维模型在虚拟环境中是否与用户的三维模型发生冲突,根据RGB图像中的人体轮廓生成精确的人体模型。动态三维模型之间的协调是通过一种特殊的碰撞检测算法实现的,该算法将整个人体网格分割成小块,并将它们连接到一个关节上。

据我们所知,我们的系统是第一个基于正常视频帧实现实时3D人类姿态预测的系统,并应用于混合现实武术。与之前的工作相比,我们的系统不要求用户穿特殊的衣服,可以在户外或大型环境中使用,因为动作可以被一个RGB摄像头捕捉到,这使得系统具有更高的可用性和适应性。

Related Work

Martial Sports in AR/VR

Hamalainen等人的[9]是第一个将武术引入人工现实的人,他们引入了一个玩家与虚拟敌人战斗的游戏。玩家的动作被实时图像处理并显示在两个大的显示器上。然而,他们的系统仅限于一个人,不支持人对抗人,他们的虚拟环境是伪三维的,因为用户在三维场景中被视为一个二维平面。另一方面,最近大量的VR武术运动(7,26)被开发,然而,它们需要玩家穿VR HMD和拿着一对控制器, 将武术变成一种游戏,因此不适合进行武术训练。

Real-time 3D pose estimation

最近的工作表明,它能够从图像观测中恢复三维关节的位置[3,17,22,27,30]。

其中Dushyant等人的VNect[22]和Cao等人的OpenPose三维重建模型,[3,25,28]是目前实时三维人体姿态估计的技术现状。虽然VNect不能用于多人检测,但其计算量少,实时性好,为三维骨骼识别提供了更好的准确性。相反,OpenPose学习身体部位之间的关联,可以在一个图像中检测到多个个体,而其推理时间大于VNect。与上述方法不同,马丁等人[20]提出了一个有效的用于3D姿态恢复的网络,它简单而深入的神经网络只有两个线性层和两个残差块 (总共六层)。他们的评估表明,一个3D姿态可以从简单的2D关节位置创建,他们的方法在Human3.6M[4,13]数据集上获得了令人满意的准确性和实时性结果。

Pose forecasting

Chao等人[5]提出了3D姿态预测网络(3D- pfnet),这是首次从单RGB图像预测人体动态的研究。他们的方法,预测2D骨骼姿态和转换它们到3D空间显示,有定量和定性的结果,平均关节位置误差约为87.6毫米。然而,3D-PFNet是一个需要大量计算的离线网络,因此很难用于需要即时反馈的体育内容。

Horiuchi等人[12]预测人体运动0.5s(30 fps视频15帧)预先使用一个由微软Kinect V2相机作为输入的运动数据的五层神经网络[24, 31];预测结果的最大差异为7.9厘米,这对他们的研究是可以接受的。然而,Kinect是一款使用IR 传感器的深度相机,如前所述:因此,它不适合在户外环境或大面积使用。在他们的实验中,一个五层的神经网络可能足够简单的跳跃动作,但对于更复杂的运动,如拳击,时间特征是非常重要的。

最后

以上就是负责冰棍最近收集整理的关于Mixed Reality Martial Arts Training using Real-time 3D Human Pose Forecasting with a RGB Camera(翻译一)的全部内容,更多相关Mixed内容请搜索靠谱客的其他文章。

发表评论 取消回复