0 前言

来写一个softmax求导的推导过程,不仅可以给自己理清思路,还可以造福大众,岂不美哉~

softmax经常被添加在分类任务的神经网络中的输出层,神经网络的反向传播中关键的步骤就是求导,从这个过程也可以更深刻地理解反向传播的过程,还可以对梯度传播的问题有更多的思考。

1 softmax 函数

softmax(柔性最大值)函数,一般在神经网络中, softmax可以作为分类任务的输出层。其实可以认为softmax输出的是几个类别选择的概率,比如我有一个分类任务,要分为三个类,softmax函数可以根据它们相对的大小,输出三个类别选取的概率,并且概率和为1。

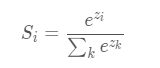

softmax函数的公式是这种形式:

S

i

S_i

Si代表的是第i个神经元的输出。

ok,其实就是在输出后面套一个这个函数,在推导之前,我们统一一下网络中的各个表示符号,避免后面突然出现一个什么符号懵逼推导不下去了。

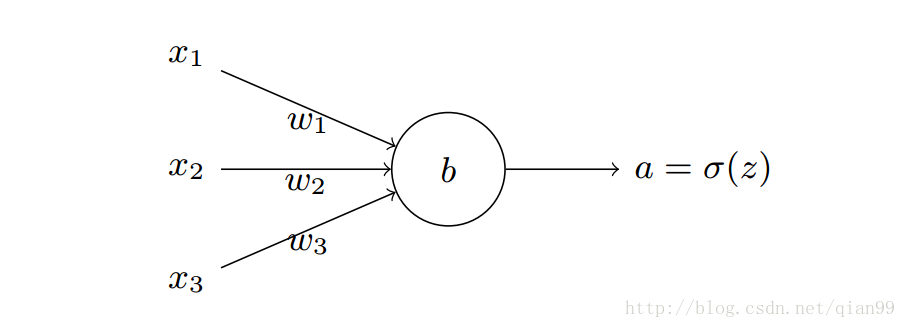

首先是神经元的输出,一个神经元如下图:

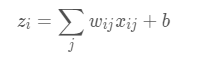

神经元的输出设为:

其中

w

i

j

w_{ij}

wij是第i 个神经元的第j 个权重,b是偏移值。

Z

i

Z_i

Zi表示该网络的第i 个输出。

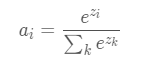

给这个输出加上一个softmax函数,那就变成了这样:

a

i

a_i

ai代表softmax的第i个输出值,右侧就是套用了softmax函数。

2 损失函数 loss function

在神经网络反向传播中,要求一个损失函数,这个损失函数其实表示的是真实值与网络的估计值的误差,知道误差了,才能知道怎样去修改网络中的权重。

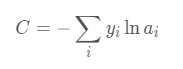

损失函数可以有很多形式,这里用的是交叉熵函数,主要是由于这个求导结果比较简单,易于计算,并且交叉熵解决某些损失函数学习缓慢的问题。交叉熵的函数是这样的:

其中

y

i

y_i

yi表示真实的分类结果。

到这里可能嵌套了好几层,不过不要担心,下面会一步步推导,强烈推荐在纸上写一写,有时候光看看着看着就迷糊了,自己边看边推导更有利于理解~

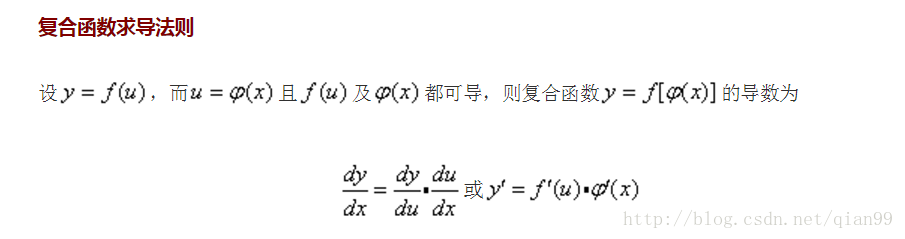

3 最后的准备

在我最开始看softmax推导的时候,有时候看到一半不知道是怎么推出来的,其实主要是因为一些求导法则忘记了,唉~

所以这里把基础的求导法则和公式贴出来~有些忘记的朋友可以先大概看一下:

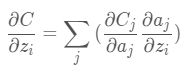

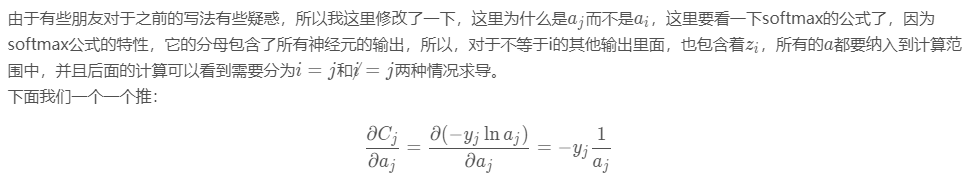

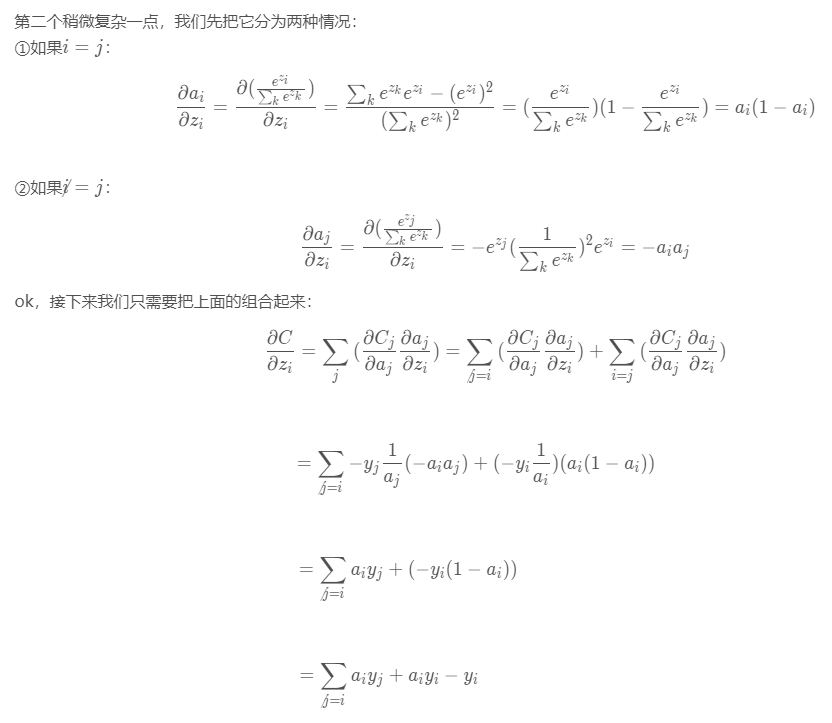

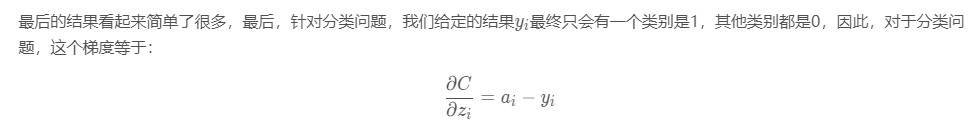

4 推导过程

好了,这下正式开始~

首先,我们要明确一下我们要求什么,我们要求的是我们的loss对于神经元输出

z

i

z_i

zi的梯度,即:

根据复合函数求导法则:

参考文章:简单易懂的softmax交叉熵损失函数求导

最后

以上就是傲娇哑铃最近收集整理的关于softmax交叉熵损失函数求导0 前言1 softmax 函数2 损失函数 loss function3 最后的准备4 推导过程的全部内容,更多相关softmax交叉熵损失函数求导0内容请搜索靠谱客的其他文章。

发表评论 取消回复