线性二分类

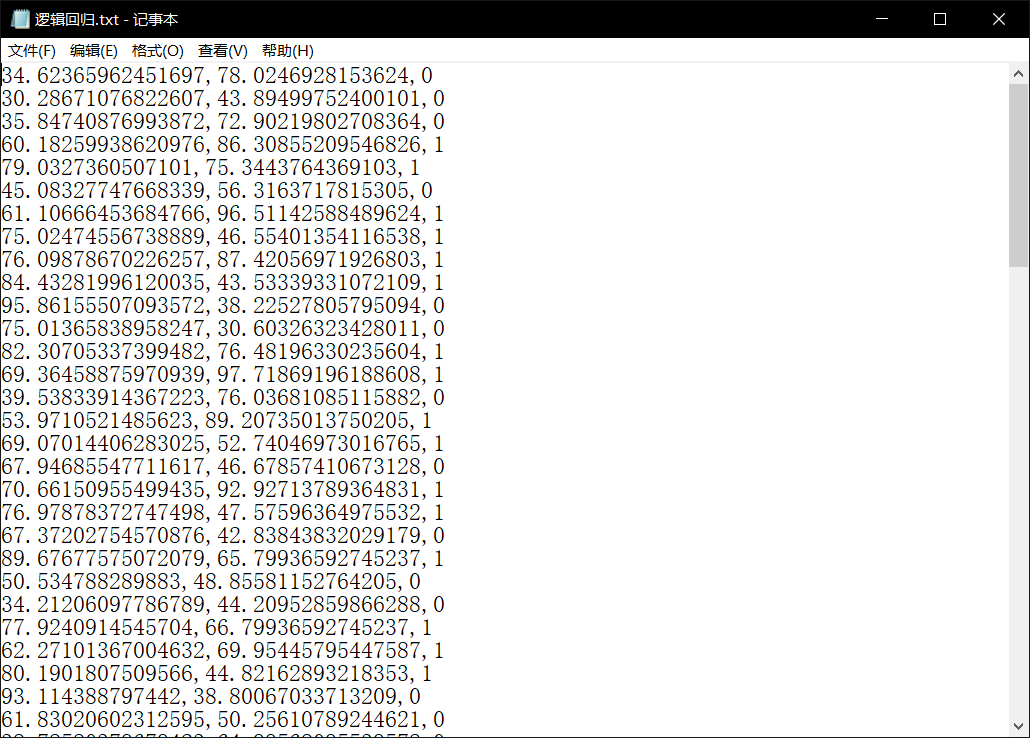

数据样式

使用的数据是上次用于逻辑回归的数据

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.metrics import classification_report

from sklearn import tree

import graphviz

# 导入数据

data = np.genfromtxt('D:/数据/逻辑回归.txt', delimiter=',', encoding='utf-8')

'''

# data = pd.read_table('D:/数据/逻辑回归.txt', sep=',')

# 将数据转化为矩阵形式

data_1 = data.values

# 将数据转化为array

data_2 = np.array(data_1)

'''

# 切分数据

x_data = data[:, :-1]

y_data = data[:, -1]

# 画出散点图,颜色根据标签来分类

plt.scatter(x_data[:, 0], x_data[:, 1], c=y_data)

plt.show()

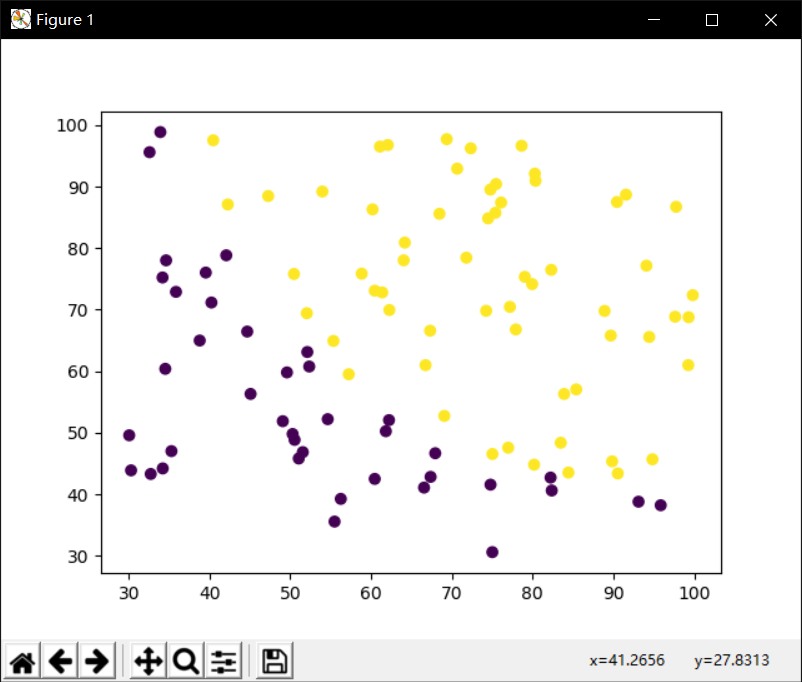

# 创建决策树模型

model = tree.DecisionTreeClassifier()

# 输入数据建立模型

model.fit(x_data, y_data)

# 测试

# x_text = x_data[0]

x_text = np.array([50, 30])

print("x_text:", str(x_text))

# 使用测试集做模型效果检验

predict = model.predict(x_text.reshape(1, -1)) # 转化成二维数据

print("predict:", predict)

# 导出决策树

dot_tree = tree.export_graphviz(

model,

feature_names=['x', 'y'],

class_names=['label0', 'label1'],

filled=True,

rounded=True,

special_characters=True

)

graph = graphviz.Source(dot_tree)

graph.render('computer3')

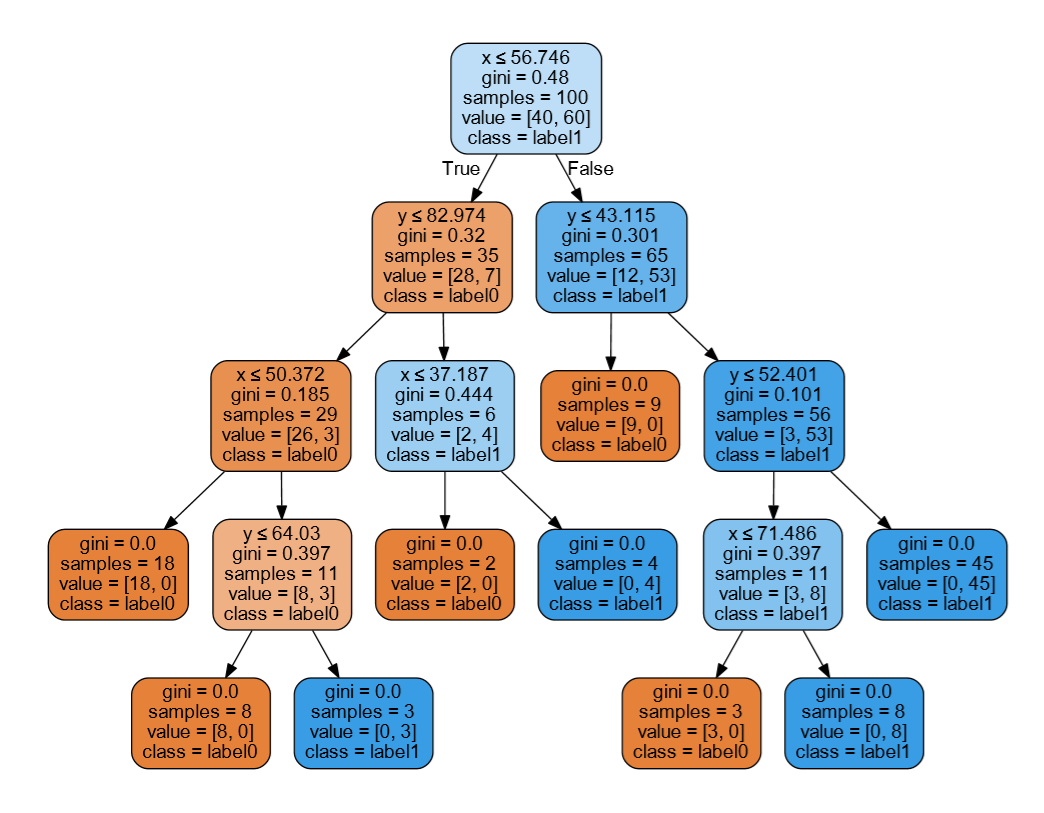

# 获取数据值所在的范围

x_min, x_max = x_data[:, 0].min()-1, x_data[:, 0].max()+1

y_min, y_max = x_data[:, 1].min()-1, x_data[:, 1].max()+1

# 生成网格矩阵

# numpy.meshgrid()——生成网格点坐标矩阵

x, y = np.meshgrid(

np.arange(x_min, x_max, 0.02),

np.arange(y_min, y_max, 0.02)

)

# np.flatten()和np.ravel()两者的功能是一致的,将多维数组降为一维,但是两者的区别是返回拷贝还是返回视图,

# np.flatten()返回一份拷贝,对拷贝所做修改不会影响原始矩阵,而np.ravel()返回的是视图,修改时会影响原始矩阵

# np.r_是按列连接两个矩阵,就是把两矩阵上下相加,要求列数相等,类似于pandas中的concat()。

# np.c_是按行连接两个矩阵,就是把两矩阵左右相加,要求行数相等,类似于pandas中的merge()。

z = model.predict(np.c_[x.ravel(), y.ravel()])

z = z.reshape(x.shape)

# 等高线

cs = plt.contourf(x, y, z) # 按照z分类显示出不同的颜色

# 样本散点图

plt.scatter(x_data[:, 0], x_data[:, 1], c=y_data)

plt.show()

'''

x_text: [50 30]

predict: [0.]

'''

关于numpy.genfromtxt的更多知识请阅读

Python科学计算——Numpy.genfromtxt

关于numpy.meshgrid()t的更多知识请阅读

numpy.meshgrid()理解

关于Numpy中扁平化函数ravel()和flatten()的区别

ravel()和flatten()的区别

关于np.c_的更多知识请阅读

np.c_的使用

关于contourf和contour的更多知识请阅读

等高线

最后

以上就是专注歌曲最近收集整理的关于决策树(三)线性二分类的全部内容,更多相关决策树(三)线性二分类内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

![[Graphviz]一些简单的例子(未完待续)1.设置点和线的形状和颜色2.设置点和线的位置(子图的概念)](https://file2.kaopuke.com:8081/files_image/reation/bcimg10.png)

![[skill][graphviz] 到底用什么画图: graphviz/inkscape/yed](https://file2.kaopuke.com:8081/files_image/reation/bcimg14.png)

发表评论 取消回复