Probing Linguistic Features of Sentence-Level Representations in Neural Relation Extraction

- 论文阅读

- 导读

- 实验设置

- 探测任务

- Surface information

- Syntactic information

- Argument information

- 编码器结构

- 实验观测与结论

- 编码器结构分析

- 探测任务分析

- 结语

论文阅读

论文地址:https://www.aclweb.org/anthology/2020.acl-main.140/

导读

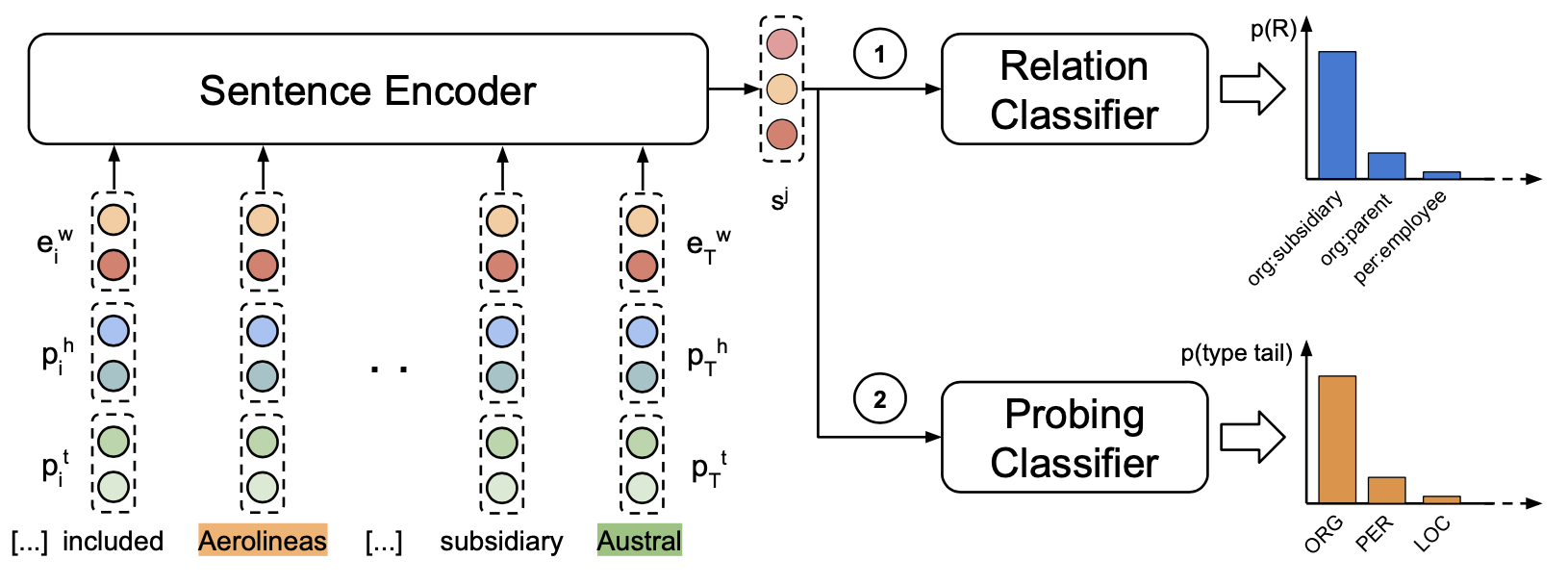

大部分关系抽取模型结构都是先使用编码器编码包括关系实体的句子,然后依据编码后的句子做分类操作。本文目的在于探究编码器的结构及其学习到的语言特征如何影响关系抽取的效果,旨在解释哪些特征是关系抽取模型所注重的。为此,本文采用了4种具有代表性的编码器结构和14个探测任务来探究那些特征有助于提高关系抽取模型的性能。

实验设置

如下图所示,作者先使用关系抽取任务训练一个编码器。之后保持编码器参数不变,其输出端训练若干探测任务,用探测任务的结果评价编码器捕捉不同特征的能力。

探测任务

作者使用了14个任务评估编码器学习到的句子级编码的效果。这些任务依据评估特征可分为三类:Surface information,Syntactic information,Argument information。分别对应句子特征的浅层信息,词法信息和两个关系实体本身的词汇信息。个人认为这些信息的学习难度和重要性逐步递增。

Surface information

探测浅层特征的任务有三个:

- SentLen:预测句话中token的数目;

- ArgDist:预测两个关系实体之间token的数目;

- EntExist:预测两个关系实体间是否存有别的实体。

Syntactic information

作者认为词法信息与关系抽取任务高度相关,推出来7个任务评估编码器抽取词法特征的能力。

- TreeDepth:多分类任务,探测编码器能否依靠词法树的深度将句子分组。一个5层词法树如下: 参考1

[1 [2 But right now, for the time be- ing, my past, my fears, and my thoughts [3 were [4 my [5business]]].]]

- SDPTreeDepth:按两个关系实体之间词法树的深度分类,

- ArgOrd:测试在句子中,第一个关系实体 是否出现在第二个的前面,

以下四个任务评估编码器是否对关系实体的上下文敏感

- PosHeadL:预测第一个关系实体左侧单词的词性,

- PosHeadR:预测第一个关系实体右侧单词的词性,

- PosTailL:预测第二个关系实体左侧单词的词性,

- PosTailR:预测第二个关系实体右侧单词的词性。

Argument information

评估编码器对关系实体本身指示内容的理解能力,重要性不言而喻。

- TypeHead:预测第一个关系实体的实体类型,

- TypeTail:预测第一个关系实体的实体类型,

- GRHead:预测第一个关系实体的语法角色,

- GRTail:预测第一个关系实体的语法角色。

编码器结构

编码器结构主要有4种,分别为:CNN,BIRNN,GCN和多头自注意机制。感兴趣的话可以阅读原文。

此外作者还在输入文本嵌入处做了文章,如使用实体类型或语法角色代替实体本身,使用预训练的ELMO或BERT生成词嵌入等。这些方式组合形成了约40种编码方式。每种方式均使用14个探测任务来检测其在捕捉对应特征的性能。

实验观测与结论

编码器结构分析

- 有局部依赖偏好的模型(CNN,BiLSTM)在聚焦在局部特征或距离相关特征的探测任务上表现较好,如PosHead{L,R},PosTail{L,R} 和ArgDist,ArgOrd.

- GCN在树相关的任务(SDPTreeDepth)表现较好。但在TreeDepth任务表现较差,这反映了GCN在捕捉长距离依赖的限制。

- 自注意编码器在关系抽取任务上表现较好,但在探测任务上均没有很好的表现,说明了自注意编码器编码了更深层的语义(探测任务没有覆盖)在句子表征中。

探测任务分析

因为编码器现在关系抽取任务上训练,然后再应用到下游探测任务中,在探测任务上表现较好的编码器在关系抽取任务中并没有良好表现,探测试验只是侧面反应关系抽取更注重哪方面的特征。

- 在所有编码结构中,任务7-14均表现较好。说明对关系抽取来说,这些信息还是非常重要的。而SentLen任务表现较差,说明了学习深层语义信息往往会使模型忽略掉简单的表皮信息。(没有免费午餐定理)

- 除了GCN,所有编码器在TreeDepth和SDPTreeDepth任务中均稍稍强过baseline,说明模型并没有学习到太多的句法信息。

- 有趣的是,使用实体类型或语法角色(主体/客体)代替实体本身,提高了关系抽取模型的效果,但在探测任务TypeHead和TypeTail上大幅度降低。在没有mask实体的时候会使得模型过度拟合于特定实体。且在mask实体之后,自注意编码器更加关注与实体本身及其周围环境。

- 本片论文再次给上下文单词向量发了金水,引入ELMO或BERT后,结果明显提升,且BERT优于ELMO。

结语

本篇论文揭示了关系抽取模型的训练偏好,验证了一些措施(如使用上下文单词向量,masking实体)的有效性。编者水平有限,仅做部分介绍,读者若感兴趣可以更进一步阅读原文。

最后

以上就是故意音响最近收集整理的关于关系抽取探测任务论文阅读结语的全部内容,更多相关关系抽取探测任务论文阅读结语内容请搜索靠谱客的其他文章。

发表评论 取消回复