本文主要介绍一篇年代久远但意义重大的论文A Neural Probabilistic Language Model(2003),其意义重大的一点在将神经网络引入语言模型的训练中,并得到了词向量这个副产物,即万物皆可Embedding的由来就在这里。

本文采用最通俗的例子来讲这个神经元模型的原理、代码和缺点。

一、原理

1、原型图

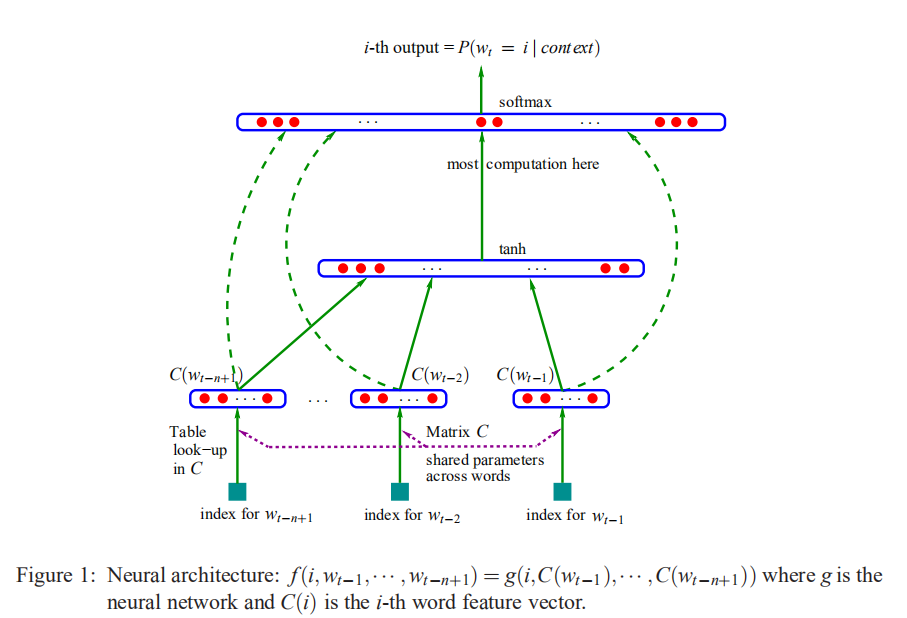

1、首先拿到一篇文章,需要把文章中的词全部提取出来并去重,得到 V V V ,初始化词向量 C C C(一个 ∣ V ∣ |V| ∣V∣x m m m大小的矩阵,m),

最后

以上就是想人陪毛衣最近收集整理的关于神经网路语言模型(NNLM)详细介绍一、原理的全部内容,更多相关神经网路语言模型(NNLM)详细介绍一、原理内容请搜索靠谱客的其他文章。

发表评论 取消回复