划重点:

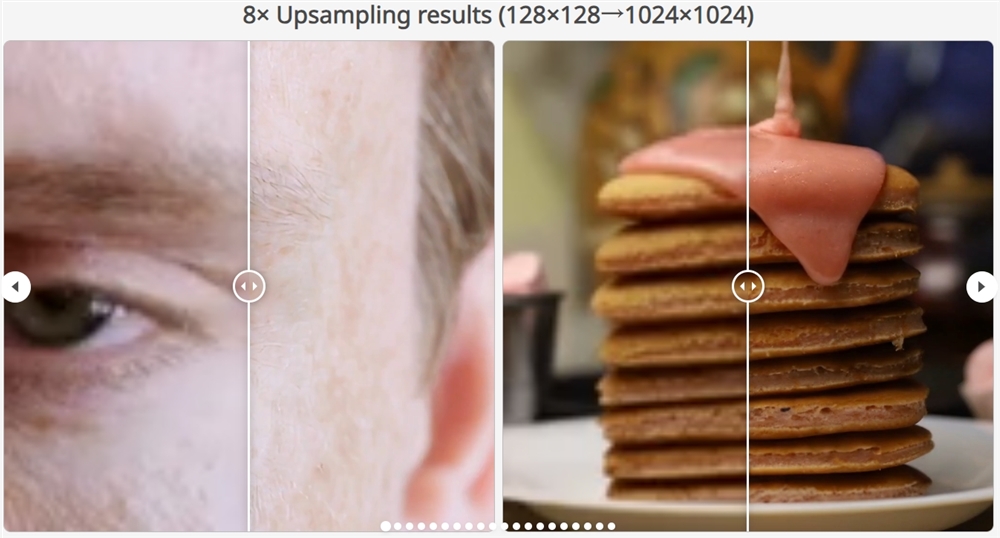

⭐ Adobe 和研究人员合作推出 VideoGigaGAN,兼顾帧率连贯性和细节丰富的超分辨率视频模型。

⭐ VideoGigaGAN 基于 GigaGAN 模型开发,通过添加时序卷积、自注意力层和光流引导模块,解决了超分辨率视频模型的时间连贯性和细节丰富性问题。

⭐ VideoGigaGAN 模型利用时序卷积捕捉视频帧之间的时间依赖性,自注意力层提取空间细节和纹理信息,光流引导模块保持特征的空间一致性,从而生成清晰的超分辨率视频。

靠谱客(kaopuke.com)6月23日消息:全球多媒体巨头 Adobe 与马里兰大学的研究人员合作推出了新的超分辨率视频模型 VideoGigaGAN。该模型兼顾帧率连贯性和丰富细节,解决了当前超分辨率视频模型的难题。

在过去的超分辨率视频转换中,存在两大难题:一是保持输出视频帧在时间上的连贯性,确保帧到帧之间平滑过渡,不出现闪烁或抖动的情况;二是在放大的视频帧中重建高频细节,提供清晰和逼真的纹理效果。然而,目前的超分辨率视频模型虽然在保持时间连贯性方面取得了进展,但以牺牲图像清晰度为代价,整体模糊缺乏更加生动的细节和纹理。

VideoGigaGAN 是基于 Adobe、卡内基梅隆大学和浦项科技大学之前推出的大规模图像超分辨率模型 GigaGAN 的基础之上开发而成。该模型通过添加时序卷积和自注意力层,将 GigaGAN 模型从2D 图像扩展为3D 视频模型,同时引入了光流引导模块,更好地对齐不同帧的特征,提高视频的时间一致性和细节丰富性。

时序卷积模块使模型能够捕捉视频帧之间的时间依赖性,从而提高超分辨率视频的时间一致性。自注意力层在解码器块中提取空间上的细节和纹理信息,同时在时间上增强一致性。光流引导模块利用光流来预测视频帧中的像素级运动,保持特征的空间一致性,生成清晰的超分辨率视频。

VideoGigaGAN 的技术原理:

基于 GigaGAN:VideoGigaGAN 基于大规模图像超分辨率模型 GigaGAN,通过将其扩展为视频模型来实现视频超分辨率处理。

时域注意力:在解码器块中添加时域注意力层,以确保在视频超分辨率处理过程中保持时域一致性。

特征传播模块:利用特征传播模块来增强一致性,将特征从视频的不同帧之间进行传播,以保持视频的连贯性。

抗锯齿处理:通过在编码器的下采样层中引入抗锯齿模块,有效抑制视频中的锯齿状伪影,改善视觉效果。

细节补偿:通过直接将高频特征通过跳跃连接传输到解码器层,以补偿在模糊处理过程中丢失的细节。

通过以上技术原理,VideoGigaGAN 能够在视频超分辨率处理中实现高质量的细节丰富的输出,并保持时域一致性。

VideoGigaGAN 具有以下功能特点:

视频超分辨率:能够将低分辨率的视频提升至高分辨率,增加视频细节和清晰度。

时域一致性:在进行视频超分辨率处理时,能够保持视频的时域一致性,避免出现时间上的不连续或跳跃。

丰富的细节处理:能够处理视频中的丰富细节,包括纹理、边缘和高频信息,提升视频质量。

抗锯齿处理:能够有效抑制视频中出现的锯齿状伪影,改善视频的视觉效果。

通用性:能够处理不同类型的视频内容,适用于多种视频处理场景。

高质量输出:生成的超分辨率视频具有更高的质量和清晰度,可用于多种应用领域。

VideoGigaGAN 可以在多种应用场景中发挥作用,包括但不限于:

1. 视频内容制作:提高视频内容的清晰度和细节,使得视频制作过程中可以处理低分辨率素材,并生成更高质量的视频作品。

2. 视频监控和安全领域:对于监控摄像头捕捉的低分辨率视频进行超分辨率处理,从而提高监控系统的效能和识别能力。

3. 视频通讯和会议:在视频通话和远程会议中,对低分辨率视频进行提升,改善视频质量,提升用户体验。

4. 医疗影像:对于医学图像和视频进行超分辨率处理,提高医疗影像的清晰度和诊断准确性。

5. 视频内容分发:对于在线视频平台或内容提供商,可以使用 VideoGigaGAN 提高视频质量,提供更清晰的视频内容给用户。

产品入口:https://top.aibase.com/tool/videogigagan

(举报)

发表评论取消回复