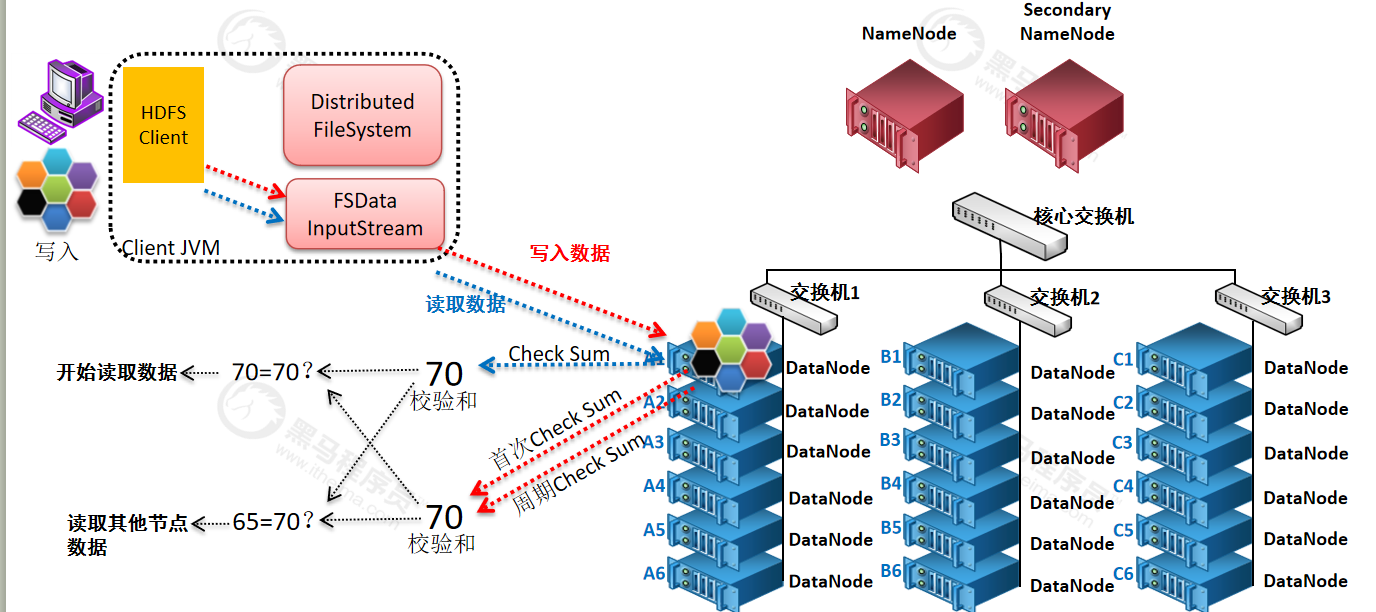

1)当DataNode读取block的时候,它会计算checksum

2)如果计算后的checksum,与block创建时(第一次上传是会计算checksum值)值不一样,说明block已经损坏。

3)client读取其他DataNode上的block.

4)datanode在其文件创建后周期验证checksum

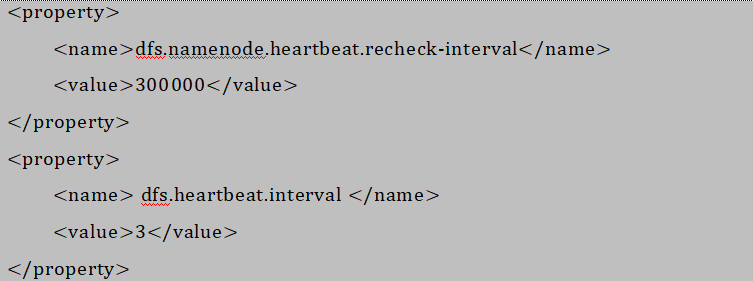

掉线时限参数设置

datanode进程死亡或者网络故障造成datanode无法与namenode通信,namenode不会立即把该节点判定为死亡,要经过一段时间,这段时间暂称作超时时长。HDFS默认的超时时长为10分钟+30秒。如果定义超时时间为timeout,则超时时长的计算公式为:

timeout = 2 * dfs.namenode.heartbeat.recheck-interval + 10 * dfs.heartbeat.interval。

而默认的dfs.namenode.heartbeat.recheck-interval 大小为5分钟,dfs.heartbeat.interval默认为3秒。

需要注意的是hdfs-site.xml 配置文件中的heartbeat.recheck.interval的单位为毫秒,dfs.heartbeat.interval的单位为秒。

一次写入,多次读出

HDFS 是设计成适应一次写入,多次读出的场景,且不支持文件的修改。

正因为如此,HDFS 适合用来做大数据分析的底层存储服务,并不适合用来做.网盘等应用,因为,修改不方便,延迟大,网络开销大,成本太高。

最后

以上就是暴躁百合最近收集整理的关于如何保证HDFS数据的完整性的全部内容,更多相关如何保证HDFS数据内容请搜索靠谱客的其他文章。

发表评论 取消回复