对于数据科学刚入门的新人来说,一个单节点的HADOOP平台的搭建是比较重要的.

他能帮助我们认识HADOOP的结构,更深入的理解这个平台的工作原理.

如果你也是windows操作系统,那么请跟我一起.

或可从此处先了解hadoop在做什么:

https://mp.weixin.qq.com/s?__biz=MzIzMTE1ODkyNQ==&mid=2649411054&idx=1&sn=f5fc02ccfb32cbe0421f13255027ae3f&chksm=f0b6080cc7c1811a7a333994bd77f2b57b6d6962e90d52ef173b06345f309ce6ecfa62519b7e&scene=21#wechat_redirect

欲安装一个单节点的hadoop,我们先要做好这几步:

- 安装虚拟机:

virtualbox下载地址:https://www.virtualbox.org/wiki/Downloads

- 给虚拟机安装一个linux系统:

ubuntu 下载地址:https://www.ubuntu.com/download/alternative-downloads

- 给linux安装jdk:

jdk下载和安装:

sudo apt-get update

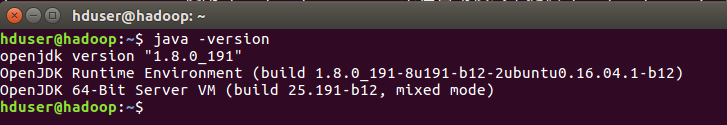

sudo apt-get install default-jdkjava -version 可以看到安装的Java 版本:

查看Java 安装位置:

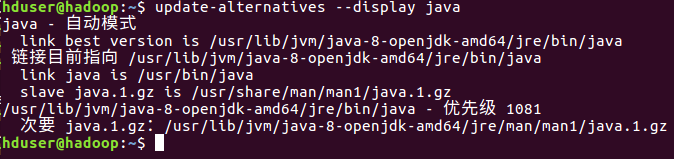

hduser@hadoop:~$ update-alternatives --display java

- 设置好SSH无密码登陆

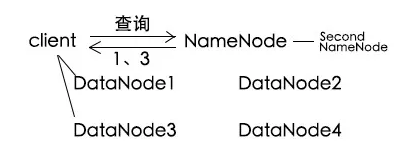

我们知道,Hadoop是很多服务器组成的,NameNode 与DataNode相连接,并管理DataNode。

为了让连接时不总是需要输入密码,设置好SSH无密码登陆很重要。

这一部分可以参考:https://blog.csdn.net/qq_38262266/article/details/79154494

先确保已安装ssh

hduser@hadoop:~$ sudo apt-get install ssh

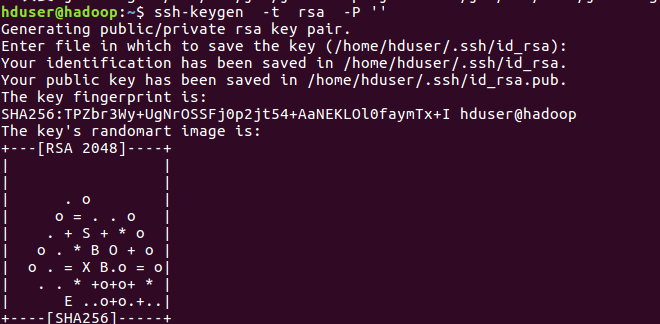

hduser@hadoop:~$ sudo apt-get install rsync产生秘钥:

hduser@hadoop:~$ ssh-keygen -t rsa -P ''将产生的秘钥放入许可证文件中。

cat .ssh/id_rsa.pub >> .ssh/authorized_keys

下载hadoop,解压,并配置文件。

hadoop下载地址:http://archive.apache.org/dist/hadoop/common//hadoop-2.7.0/

wget 下载 :

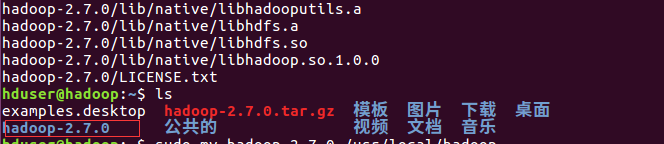

wget http://archive.apache.org/dist/hadoop/common//hadoop-2.7.0/hadoop-2.7.0.tar.gz解压:tar -zxvf hadoop-2.7.0.tar.gz 得到解压后文件

将文件移动一下:

hduser@hadoop:~$ sudo mv hadoop-2.7.0 /usr/local/hadoop

- 配置HADOOP

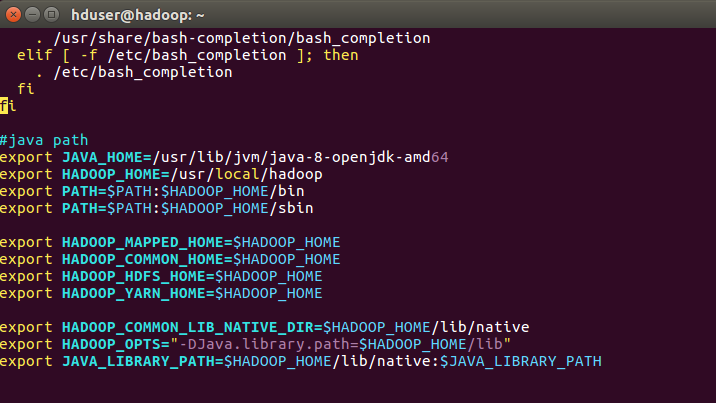

运行HADOOP需要设置一些环境变量,因此我们需要修改~/.bashrc 文件:

#java path

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

export HADOOP_MAPPED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export HADOOP_YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-DJava.library.path=$HADOOP_HOME/lib"

export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native:$JAVA_LIBRARY_PATH

配置文件修改:

1、hadoop-env.sh:

sudo vim /usr/local/hadoop/etc/hadoop/hadoop-env.sh

修改JAVA_HOME

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

2、core-site.xml

hduser@hadoop:~$ sudo vim /usr/local/hadoop/etc/hadoop/core-site.xml

必须设置默认的HDFS名称

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

3、yarn-site.xml

hduser@hadoop:~$ sudo vim /usr/local/hadoop/etc/hadoop/yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

4、mapred-site.xml

该文件用于设置监控map reduce程序的 jobTracker 任务的分配情况,以及taskTracker的运行情况。

Hadoop提供了模板,mapred-site.xml.template,可以拷贝修改。

hduser@hadoop:~$ sudo cp /usr/local/hadoop/etc/hadoop/mapred-site.xml.template /usr/local/hadoop/etc/hadoop/mapred-site.xml

hduser@hadoop:~$ sudo vim /usr/local/hadoop/etc/hadoop/mapred-site.xml

<configuration>

<!-- 设置mapreduce 的框架为 yarn-->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

5、hdfs-site.xml

hduser@hadoop:~$ sudo vim /usr/local/hadoop/etc/hadoop/hdfs-site.xml

<configuration>

<!-- blocks的备份数量默认为3-->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!-- namenode 的数据存储位置-->

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hadoop_data/hdfs/namenode</value>

</property>

<!-- datanode的数据存储位置-->

<property>

<name>dfs.namenode.data.dir</name>

<value>file:/usr/local/hadoop/hadoop_data/hdfs/datanode</value>

</property>

</configuration>

hduser@hadoop:~$ sudo mkdir -p /usr/local/hadoop/hadoop_data/hdfs/namenode

hduser@hadoop:~$ sudo mkdir -p /usr/local/hadoop/hadoop_data/hdfs/datanode

#修改文件所有者

hduser@hadoop:~$ sudo chown hduser:hduser -R /usr/local/hadoop- HADOOP 启动

hadoop namenode -format

启动hadoop的方式有两种:

1、分别启动HDFS、YARN

终端输入如下命令:

start-dfs.sh

start-yarn.sh

2、同时启动 HDFS、YARN

start-all.sh

- 观察启动情况

jps查看进程的启动情况:

hduser@hadoop:~$ jps

4500 Jps

3413 SecondaryNameNode

4392 NodeManager

4092 ResourceManager

3805 DataNode

3662 NameNode

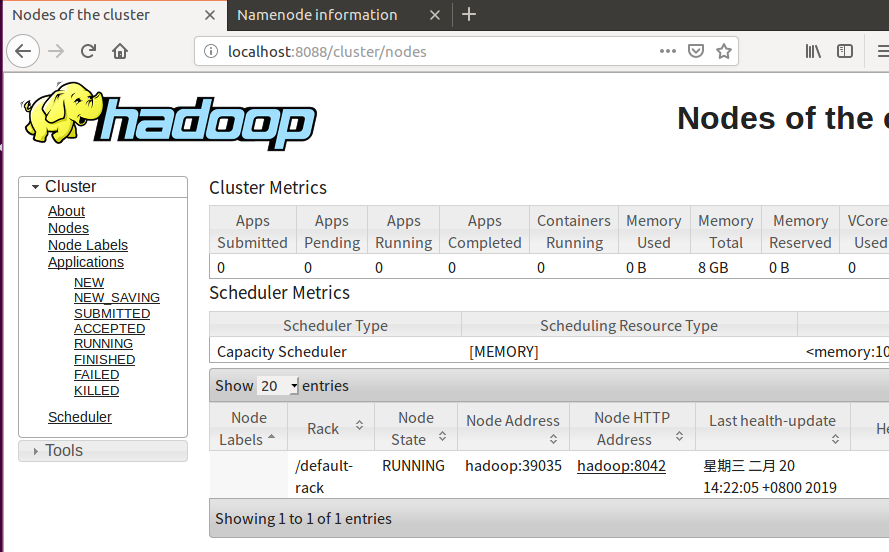

Hadoop ResourceManage Web 网址 http://localhost:8088/cluster/nodes

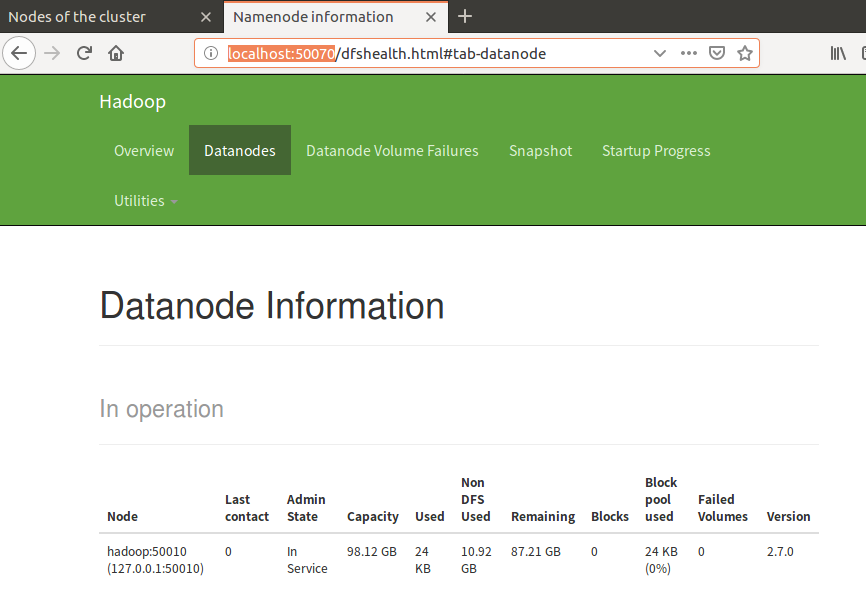

HDFS WEB网址 http://localhost:50070

______________________________________________________

单节点hadoop部署完成

最后

以上就是含糊煎饼最近收集整理的关于安装一个单节点的HADOOP的全部内容,更多相关安装一个单节点内容请搜索靠谱客的其他文章。

发表评论 取消回复