官方中文文档【3.0之前的版本】

1、系统环境

OS:Ubuntu 16.04.6 LTS

Java:java version "1.8.0_241"

Hadoop:Hadoop 3.2.1

如果没有安装Java环境的,可以借鉴Java环境

2、安装配置ssh【已安装的请忽略】

2-1、输入命令:

sudo apt-get install openssh-server # 安装ssh

ssh localhost # 登录本机

exit # 退出登录登录本机,首次登录会有提示,输入yes,接着输入当前用户登录电脑的密码即可。

2-2、配置ssh无密码登录

cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

ssh-keygen -t rsa # 会有提示,都按回车就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授权配置完成之后再登录就不需要密码了。

3、Hadoop安装

去Hadoop官网下载hadoop-3.2.1.tar.gz,或者下载其他镜像文件。

sudo tar -xzf hadoop-3.2.1.tar.gz -C /usr/local # 解压hadoop到/usr/local下

mv /usr/local/hadoop-3.2.1 /usr/local/hadoop # 重命名

vi /etc/profile # 配置环境变量添加以下代码:

export HADOOP_HOME=/usr/local/hadoop

export PATH=$HADOOP_HOME/bin:$PATH

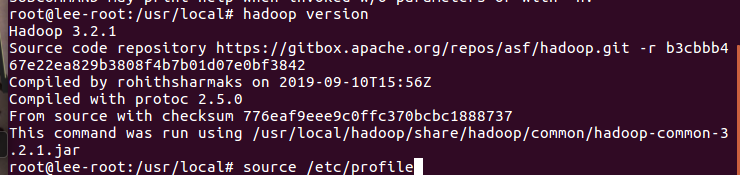

然后使用命令

source /etc/profile # 使配置生效

hadoop version # 检查环境变量是否配置成功

4、伪分布式

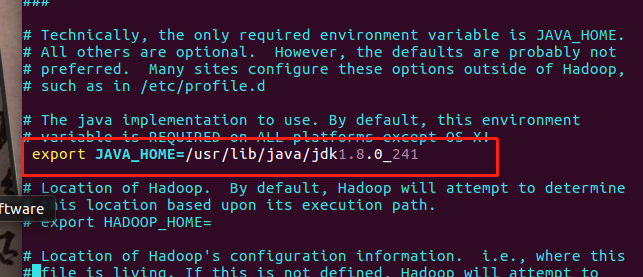

1、添加jdk路径到hadoop-env.sh文件

vi etc/hadoop/hadoop-env.sh添加:export JAVA_HOME=/usr/lib/java/jdk1.8.0_241 # jdk的安装目录

![]()

2、修改core-site.xml文件

文件位置: /usr/local/hadoop/etc/hadoop/【/usr/local/hadoop是安装目录】

将<configuration></configuration>改为:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>localhost:9000</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmpdir</value> #自定义临时文件夹的配置

<description>A base for other temporary directories.</description>

</property>

</configuration>

# 伪分布式模式下,Hadoop每次start-all完之后,用jps发现namenode没有正常启动,原因是将hadoop默认的临时目录在/tmp目录下,这个目录在机器重启后就会删除。所以在conf目录下的core-site.xml文件里加入对临时文件夹的配置。

3、修改同目录下的hdfs-site.xml文件

hdfs-site.xml内存储的是HDFS的配置。修改<configuration></configuration>内的内容为:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

4、格式化文件系统

bin/hdfs namenode -format # 在安装目录下执行,楼主的安装目录为:/usr/local/hadoop5、 修改sbin/start-dfs.sh和sbin/stop-dfs.sh,在文件头加入以下内容

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=root

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

【PS:我的是在root用户下安装的,其他安装教程大都是在新用户下安装】

6、启动hadoop服务

sbin/start-dfs.sh # 在安装目录下输入7、浏览器访问namenode结点

http://localhost:9870【特别注意:HaDoop3.0之前web访问端口是50070 hadoop3.0之后web访问端口为9870】

8、关闭伪分布式

sbin/stop-dfs.shOK

最后

以上就是贤惠长颈鹿最近收集整理的关于Ubuntu16.04 安装 Hadoop3.2.1的全部内容,更多相关Ubuntu16.04内容请搜索靠谱客的其他文章。

发表评论 取消回复