我是靠谱客的博主 执着西牛,这篇文章主要介绍Ubuntu16.04下Hadoop3.1的安装与配置1. 下载压缩包2. 配置环境变量3. 配置Hadoop4.运行并测试,现在分享给大家,希望可以做个参考。

参考链接:Hadoop: Setting up a Single Node Cluster.

1. 下载压缩包

Hadoop环境需要安装java,若未安装见:java下载与安装

然后到官网下载对应的安装包,然后解压到本地目录下.

2. 配置环境变量

sudo gedit ~/.bashrc然后设置环境变量(路径根据自己的设置)

export HADOOP_HOME=/usr/hadoop-3.1.0/

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH设置完成好使其生效:

source ~/.bashrc3. 配置Hadoop

编辑以下文件:

文件在Hadoop文件夹“/etc/hadoop/”目录下

core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

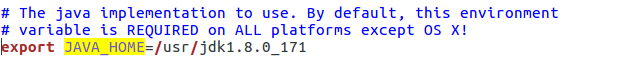

</configuration>hadoop-env.sh (设置java的路径)

找到JAVA_HOME行,如下图所示,根据自己的路径进行设置:

4.运行并测试

依次输入如下命令:

bin/hdfs namenode -format

sbin/start-dfs.sh

bin/hdfs dfs -mkdir /user

bin/hdfs dfs -mkdir /user/xxx

bin/hdfs dfs -mkdir input

bin/hdfs dfs -put etc/hadoop/*.xml input //将要处理的数据输入

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.0.jar grep input output 'dfs[a-z.]+'

bin/hdfs dfs -get output output//将输出提取到本地的output文件夹内

cat output/*

bin/hdfs dfs -cat output/*

sbin/stop-dfs.sh //结束最后

以上就是执着西牛最近收集整理的关于Ubuntu16.04下Hadoop3.1的安装与配置1. 下载压缩包2. 配置环境变量3. 配置Hadoop4.运行并测试的全部内容,更多相关Ubuntu16.04下Hadoop3.1的安装与配置1.内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复