LSTM 是为了解决 RNN 的 Gradient Vanish 的问题所提出的。

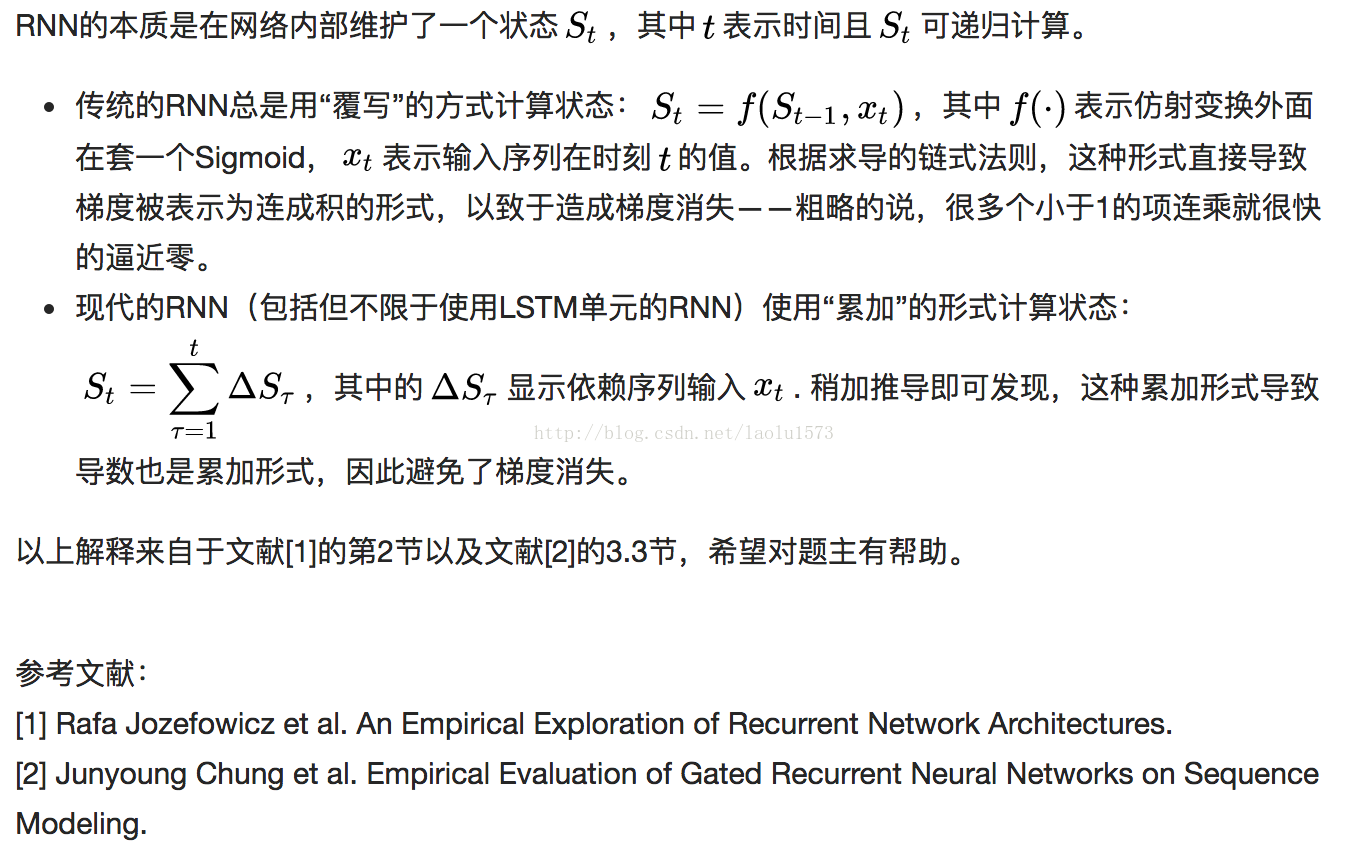

LSTM如何避免梯度消失?

LSTM只能避免RNN的梯度消失(gradient vanishing),但是不能对抗梯度爆炸问题(Exploding Gradient)。

梯度膨胀(gradient explosion)不是个严重的问题,一般靠裁剪后的优化算法即可解决,比如gradient clipping(如果梯度的范数大于某个给定值,将梯度同比收缩)。

梯度剪裁的方法一般有两种:

1.一种是当梯度的某个维度绝对值大于某个上限的时候,就剪裁为上限。

2.另一种是梯度的L2范数大于上限后,让梯度除以范数,避免过大。

最后

以上就是着急大炮最近收集整理的关于LSTM相比一般RNN的优势的全部内容,更多相关LSTM相比一般RNN内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复