【1】转自http://www.jianshu.com/p/9dc9f41f0b29

【1.5】前馈神经网路——信息是一级一级向前传的

【2】人类并不是每时每刻从空白思考问题,是基于对先前所见词的理解来推断当前词的含义。

【3】但是传统的神经网络不能做到这点,传统的神经网络输入之间是独立的,代表着新物质的构成。?????对么

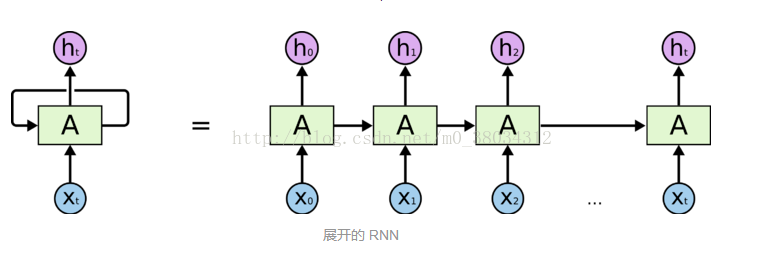

【4】RNN解决了这个问题,RNN时循环的网络允许信息的持久化,即基于原始的信息去处理新的信息。

【5】

链式的特征揭示了RNN本质与序列和列表相关的。他们是对这类数据最自然的神经网络构架。

【6】RNN不能处理长期依赖的问题(长期依赖指输出的根据离输出时刻太远,可能会造成梯度消失或梯度爆炸)

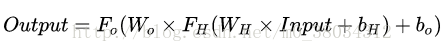

【7】LSTM可以很好解决这个问题,LSTM是在标准的RNN的基础上加入了其他的神经网络(gates),而这些gates只是控制数级,控制信息的流动量

【8】gate的理解:把信息想象成水流,而gate就是控制水流可以通过。

最后

以上就是生动小土豆最近收集整理的关于机器学习_RNN/长期依赖/LSTM的全部内容,更多相关机器学习_RNN/长期依赖/LSTM内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复