BN、LN这两个归一化的计算流程几乎是一样的,可以分为四步:

1.计算出均值

2.计算出方差

3.归一化处理到均值为0,方差为1

4.变化重构,恢复出这一层网络所要学到的分布

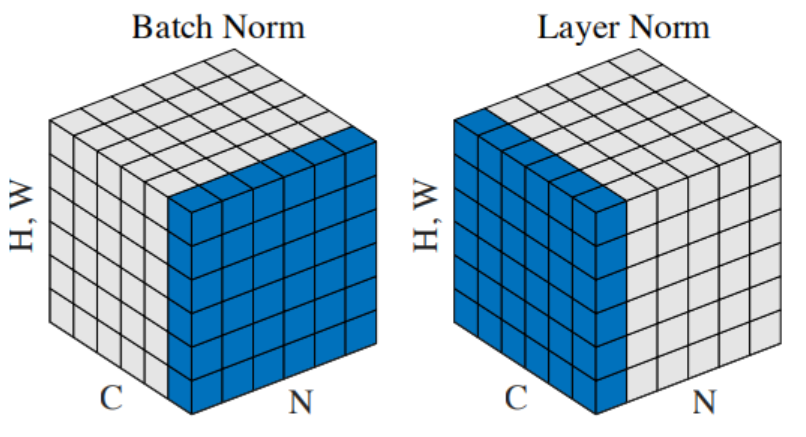

Batch Normalization(对不同batch的同一维做归一化):

1.BN的计算就是把每个通道的NHW单独拿出来归一化处理

2.针对每个channel我们都有一组γ,β,所以可学习的参数为2*C

3.当batch size越小,BN的表现效果也越不好,因为计算过程中所得到的均值和方差不能代表全局

优点:

1、可以解决内部协变量偏移。

2、缓解了梯度饱和问题(如果使用sigmoid激活函数的话),加快收敛。

Layer Normalizaiton(对同一batch的所有维做归一化):

1.LN的计算就是把每个CHW单独拿出来归一化处理,不受batchsize 的影响

2.输入的特征区别很大时,归一化处理效果较差

最后

以上就是虚幻御姐最近收集整理的关于Batch Normalization(BN)的全部内容,更多相关Batch内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复