测试HDFS写性能

在集群节点上执行如下命令:

[hadoop@hadoop01 mapreduce]$ hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.1.3-tests.jar TestDFSIO -write -nrFiles 10 -fileSize 128MB

参数说明:

- jar包名称和集群的版本有关,注意版本。

- TestDFSIO:jar包中的类名。

- -write:写数据测试。

- -nrFiles 10 -fileSize 128MB:写10个文件,每个文件大小128M。

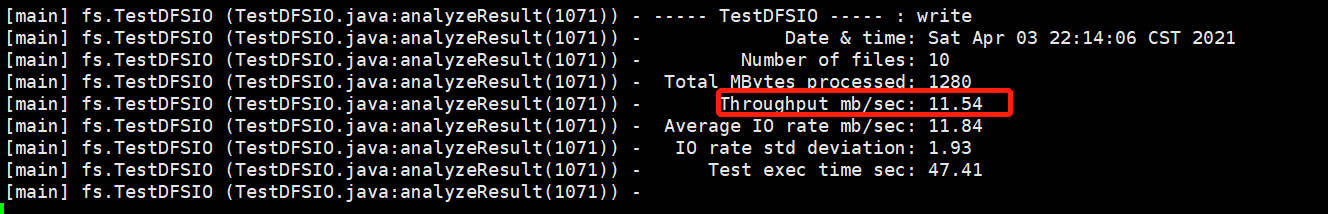

运行结果及说明

- Throughput mb/sec 11.54:吞吐量11.54M/s。

测试HDFS读性能

在集群节点上执行如下命令:

[hadoop@hadoop01 mapreduce]$ hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.1.3-tests.jar TestDFSIO -read -nrFiles 10 -fileSize 128MB

参数说明

- 同上,不同的是将write改为read。

删除测试读写性能产生的数据

[hadoop@hadoop01 mapreduce]$ hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.1.3-tests.jar TestDFSIO -clean

使用Sort程序评测MapReduce

1)使用RandomWriter来产生随机数,每个节点运行10个Map任务,每个Map产生大约1G大小的二进制随机数。

[hadoop@hadoop01 mapreduce]$ hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar randomwriter random-data

2)执行Sort程序

[hadoop@hadoop01 mapreduce]$ hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar sort random-data sorted-data

3)验证数据是否真正排好序了

[hadoop@hadoop01 mapreduce]$ hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.1.3-tests.jar testmapredsort -sortInput random-data -sortOutput sorted-data

最后

以上就是舒适飞机最近收集整理的关于Hadoop集群读写性能测试以及MR测试的全部内容,更多相关Hadoop集群读写性能测试以及MR测试内容请搜索靠谱客的其他文章。

发表评论 取消回复