2.3 10臂测试台

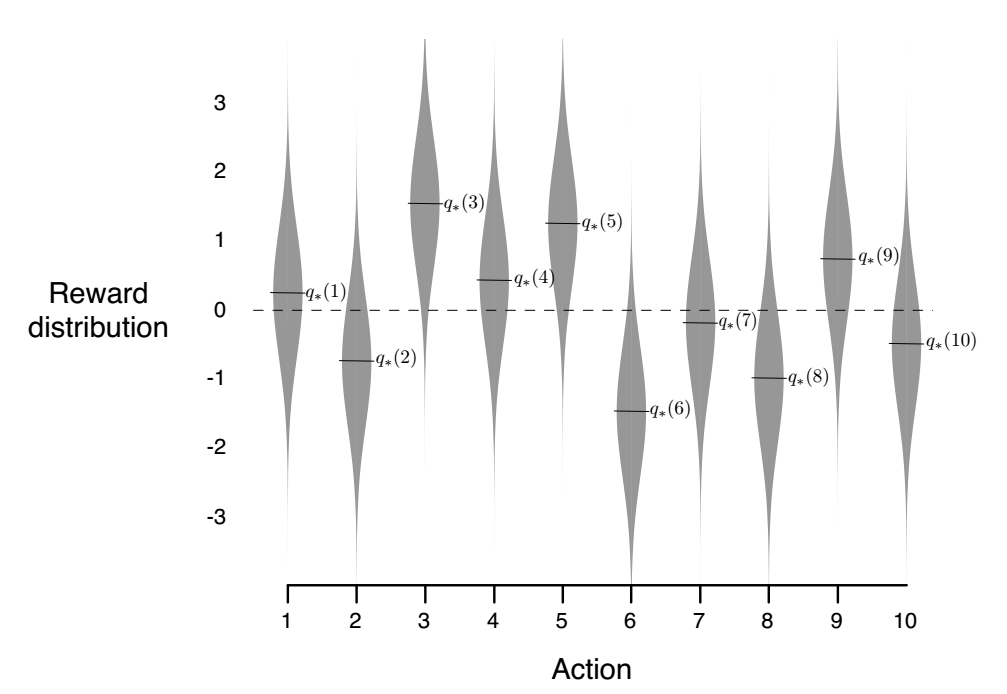

为了粗略的评估贪婪算法和ε-greedy 方法的相对有效性,我们通过一系列测试问题进行数值上的比较。这是一个2000次的随机产生的10个臂的赌博问题。对于每个赌博机问题,就像图2.1所示:

图2.1

对于动作值函数![]() ,来自于一个均值为0方差为1的高斯分布函数。然后,当一种学习方法应用于该问题时,选择在时间步长t处的动作

,来自于一个均值为0方差为1的高斯分布函数。然后,当一种学习方法应用于该问题时,选择在时间步长t处的动作![]() ,从均值为

,从均值为![]() 方差为1的正态分布中获得实际奖励值

方差为1的正态分布中获得实际奖励值![]() , 我们可以画出随着1000局经验积累后不同方法的表现,这些分布在图2.1中用灰色表示。我们称这一套测试任务为10-臂测试平台。对于任何一种学习方法,将它应用于一个强盗问题,当其经验超过1000个时间步的时候,我们都可以测量它的性能和行为。这构成了一次运行。在2000次独立的测试中,每一次测试都有不同的强盗问题,我们通过学习算法的平均表现获得策略。

, 我们可以画出随着1000局经验积累后不同方法的表现,这些分布在图2.1中用灰色表示。我们称这一套测试任务为10-臂测试平台。对于任何一种学习方法,将它应用于一个强盗问题,当其经验超过1000个时间步的时候,我们都可以测量它的性能和行为。这构成了一次运行。在2000次独立的测试中,每一次测试都有不同的强盗问题,我们通过学习算法的平均表现获得策略。

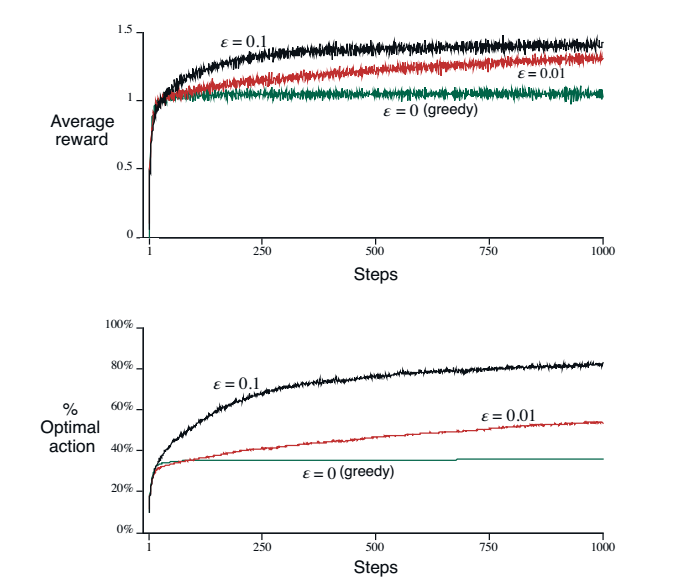

图2.2比较了一种贪婪算法和2种ε-greedy 算法,如下所示:

图2.2

2种方法都采用均值采样技术实现行为值估计。上图展示了期望回报随着经验增加。刚开始的时候贪婪算法的提升效果略微好于其他方法,但是之后稳定在一个低水平。它每一步的收益仅仅是1,相比于最好的1.55。贪婪算法的长期表现很糟糕,因为他会陷入次优解。下面那张图展示了贪婪算法在大概三分之一的任务中找到了最优行为。其他三分之二任务里,在刚开始最优行为的选择上是令人失望的,最终也没能逆转。ε-greedy 算法最终表现更好因为它持续探索,提供了识别最优行为的可能。ε=0.1 的方法探索的概率大,因此通常会更早的找到最优值,但是仍有9%的概率没有找到最优动作。ε=0.01 方法改善的速度慢,但是最终表现效果比前面好。随着时间的推移,还可以逐渐减少ε ,以尽量同时获得高值和低值。

ε-greedy 算法相较于贪婪算法的优势取决于任务,例如,假设奖励差异较大,比如说10而不是1。对于有噪声的奖励值,为了找到最佳动作需要更多的探索,并且ε-greedy 方法应该是有效的,并且相对于贪婪的方法甚至更好。另一方面,如果奖励的方差为0,那么贪心方法在尝试一次后会知道每个动作的真实值。在这种情况下,贪心方法实际上可能执行得最好,因为它会很快找到最优的行动,然后永远不需要探索。但即使在确定性的情况下如果我们弱化其他一些假设,那么探索就有很大的优势。例如,假设强盗任务是非平稳的,即

行为会随着时间而改变。在这种情况下,甚至在确定性情况中也需要探索,确保其中一个非贪心行为没有改变,相比较贪心算法变得更好。正如我们将在接下来的几章中看到的,非平稳性是在强化学习中经常遇到的问题中是最常见的情况。即使基础任务是固定的和确定的,学习者也会面临一组强盗式的决策任务随着学习的进行和智能体决策策略的变化而变化。强化学习需要探索和开发之间的平衡。

练习2.2:土匪示例,考虑一个k-armed土匪问题,k = 4个动作,表示1、2、3、4。考虑将强盗算法应用于此问题ε-greedy 行为选择,样本-平均行为价值估计,和初始估计![]() ,对于所有a。假设行为和奖励的初始序列为

,对于所有a。假设行为和奖励的初始序列为![]() ,

, ![]() ,

, ![]() ,

, ![]() ,

,![]() 。在这些时间步骤中,ε可能已经发生,导致选择在随机的。这是在什么时候发生的?什么时候才能做到使这一点可能发生呢?

。在这些时间步骤中,ε可能已经发生,导致选择在随机的。这是在什么时候发生的?什么时候才能做到使这一点可能发生呢?

练习2.3:在图2.2所示的比较中,从长期来看,在累积回报和选择最佳行动的概率方面哪种方法表现最好?这样会好多少?定量地表达你的答案。

最后

以上就是舒适板凳最近收集整理的关于Reinforcement Learning An Introduction~The 10-armed Testbed2.3 10臂测试台的全部内容,更多相关Reinforcement内容请搜索靠谱客的其他文章。

发表评论 取消回复