作者丨黄浴@知乎

来源丨https://zhuanlan.zhihu.com/p/371258127

编辑丨3D视觉工坊

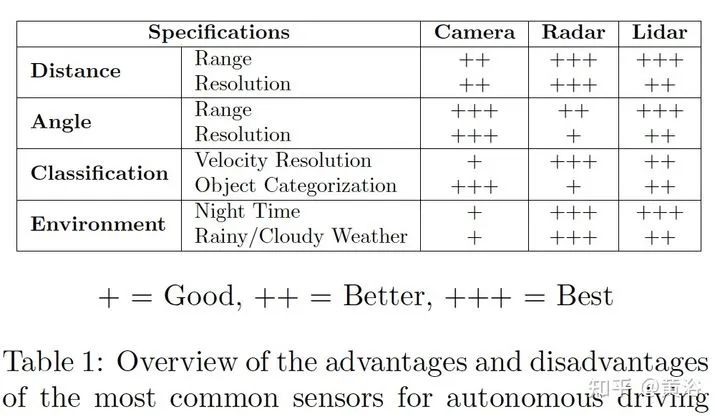

关于传感器融合,特别是摄像头、激光雷达和雷达的前融合和和特征融合,是一个引人注意的方向。

今年也介绍过一些工作,比如摄像头和激光雷达的融合:

https://zhuanlan.zhihu.com/p/344408038

https://zhuanlan.zhihu.com/p/344405996

https://zhuanlan.zhihu.com/p/344131092

也有雷达和摄像头的融合:

https://zhuanlan.zhihu.com/p/345845006

更早的分析讨论见:

https://zhuanlan.zhihu.com/p/86543002

https://zhuanlan.zhihu.com/p/103155774

这里介绍最近的几篇论文,主要是摄像头和雷达。

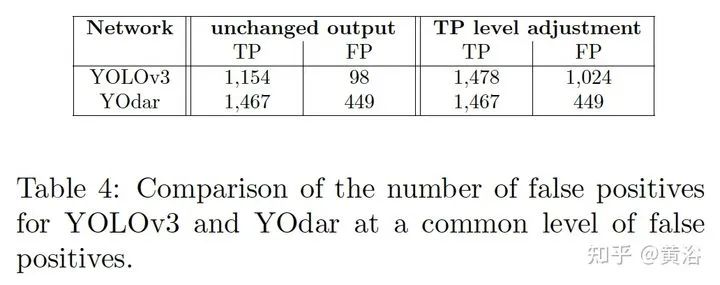

1 “YOdar: Uncertainty-based Sensor Fusion for Vehicle Detection with Camera and Radar Sensors“, 11,2020

基于不确定性的融合方法。后处理采用gradient boosting,视觉来自YOLOv3,雷达来自1D segmentation network。

FCN-8 inspired radar network

Image of a radar detection example with four predicted slice bundles

YOdar

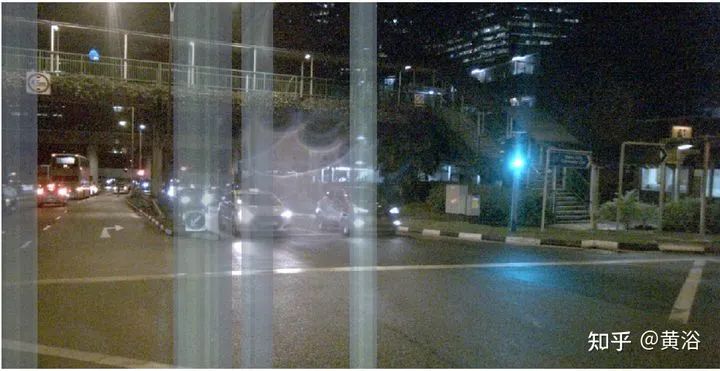

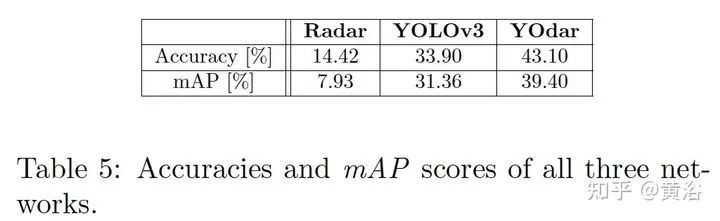

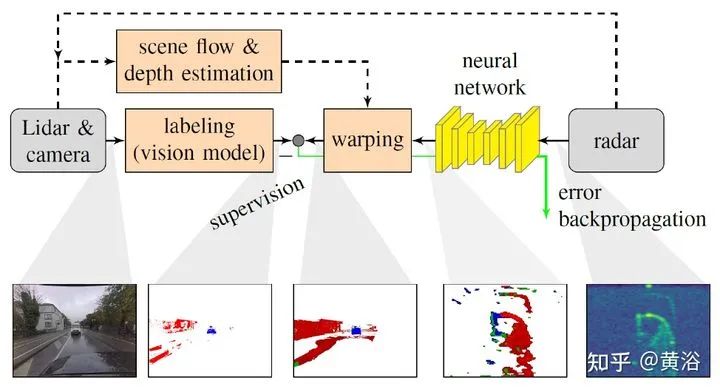

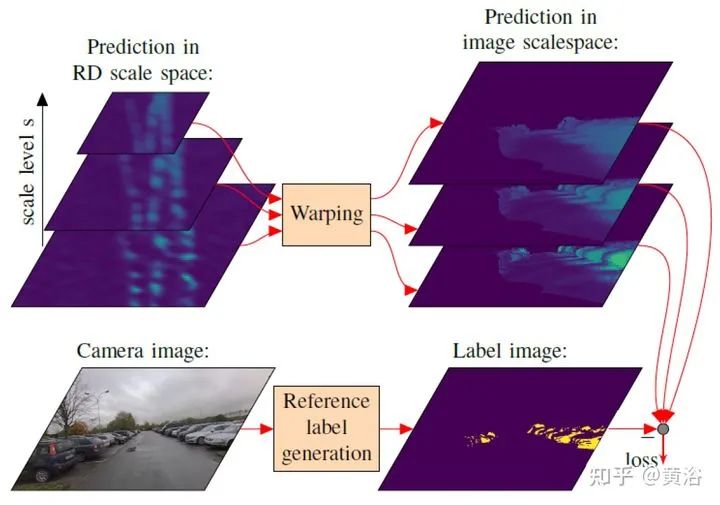

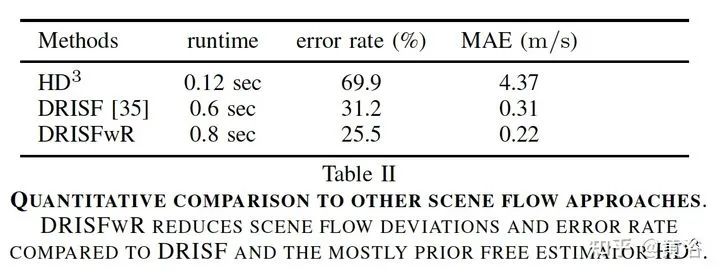

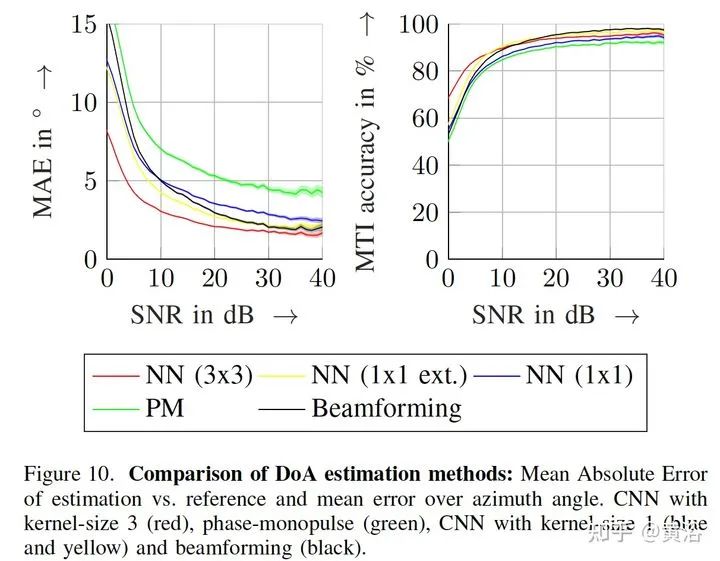

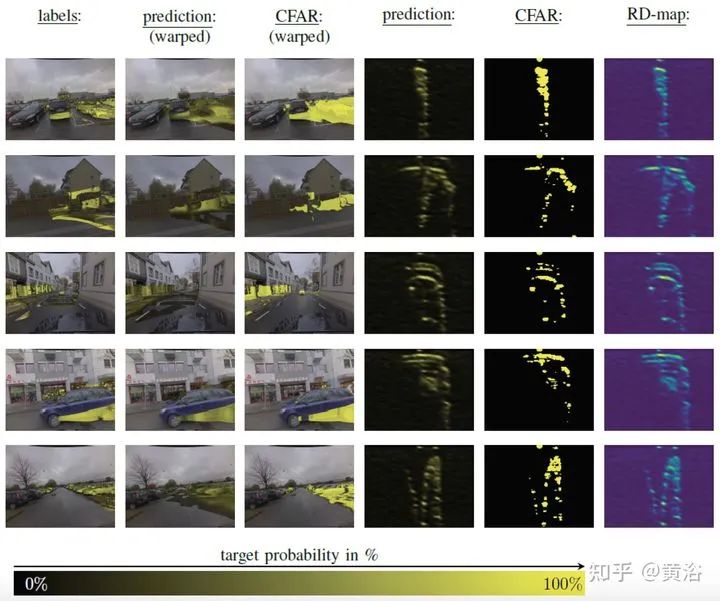

2 “Warping of Radar Data into Camera Image for Cross-Modal Supervision in Automotive Applications”,12,2020

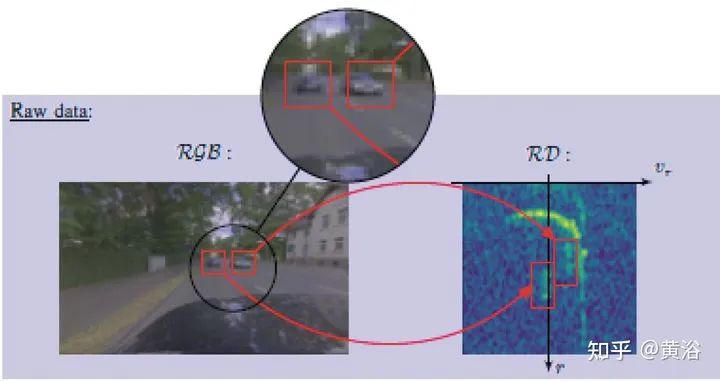

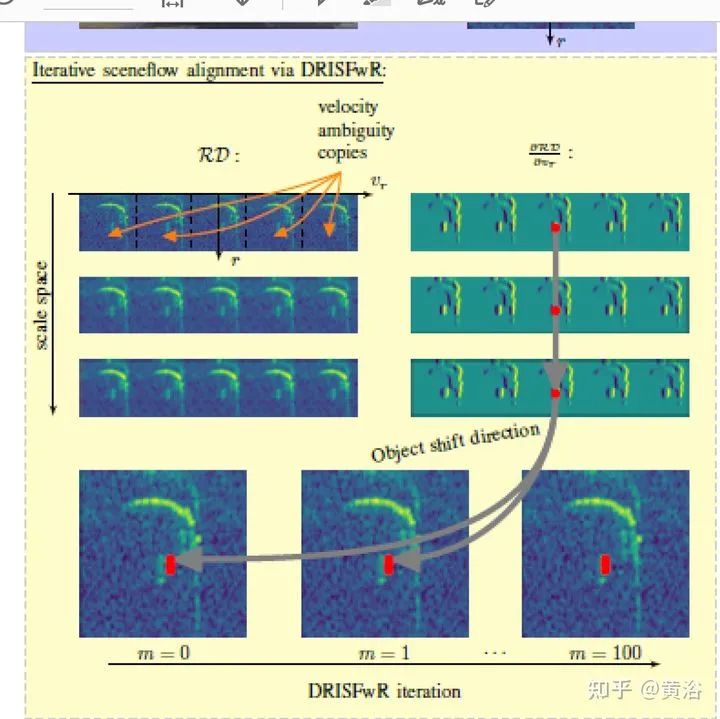

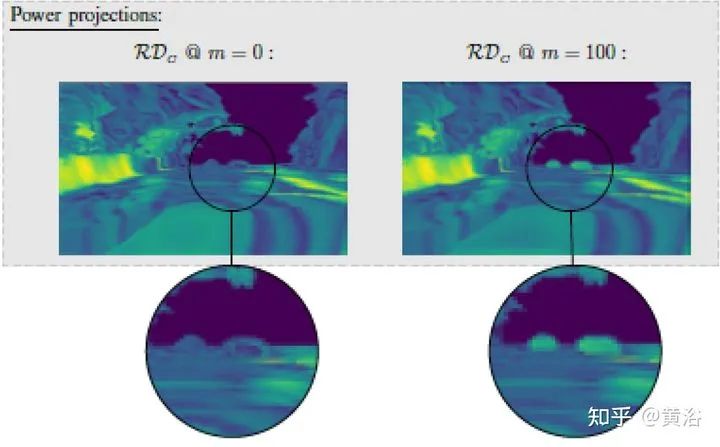

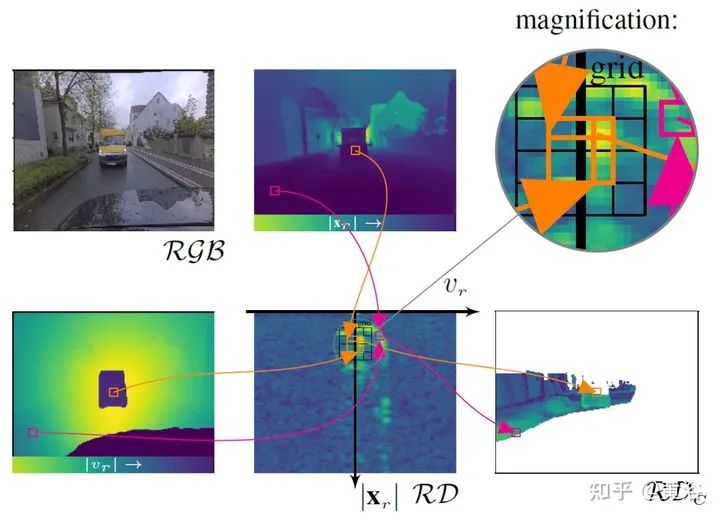

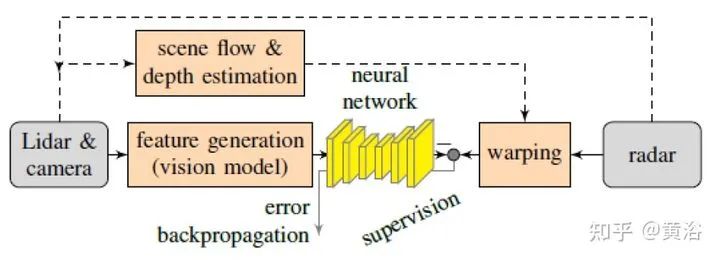

将雷达的range-Doppler (RD) spectrum投射到摄像头平面。由于设计的warping函数可微分,所以在训练框架下做BP。该warping操作依赖于环境精确的scene flow,故提出一个来自激光雷达、摄像头和雷达的scene flow估计方法,以提高warping操作精度。实验应用涉及了direction-of-arrival (DoA) estimation, target detection, semantic segmentation 和 estimation of radar power from camera data等。

model pipeline

DRISFwR overview (deep rigid instance scene flow with radar)

Automatic scene flow alignment to Radar data via DRISFwR:

RGB image and RD-map with two vehicles

Scale-space of radar data used in DRISFwR with energy & partial derivative

Power projections

RD-map warping into camera image:

Loss in scale-space:

最后实验结果比较:

Qualitative results of target detection on test data examples

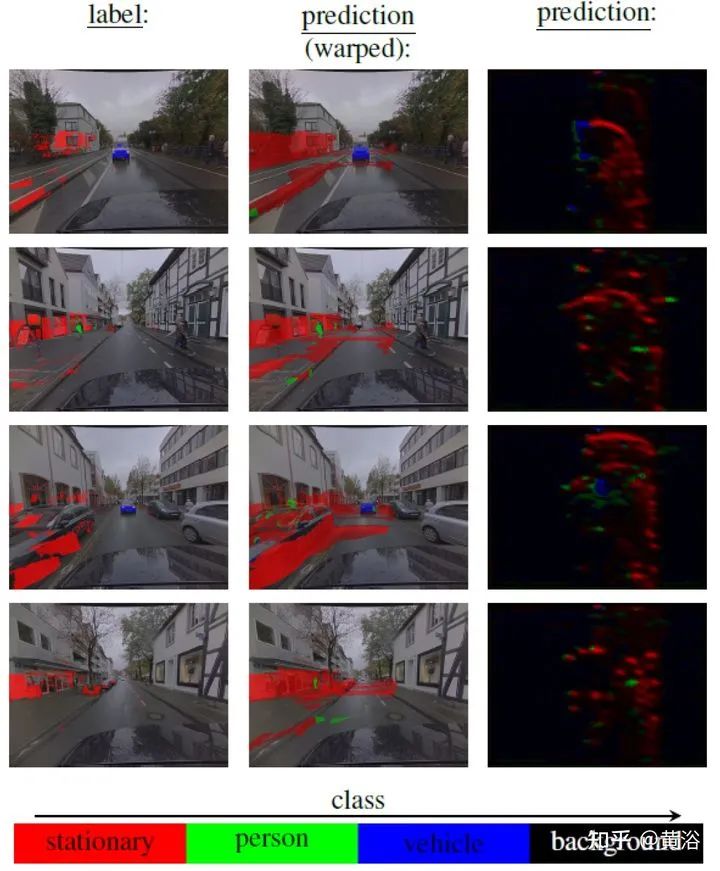

Qualitative results of semantic segmentation on test data examples

Overview of the model pipeline for camera based estimators for NN training:

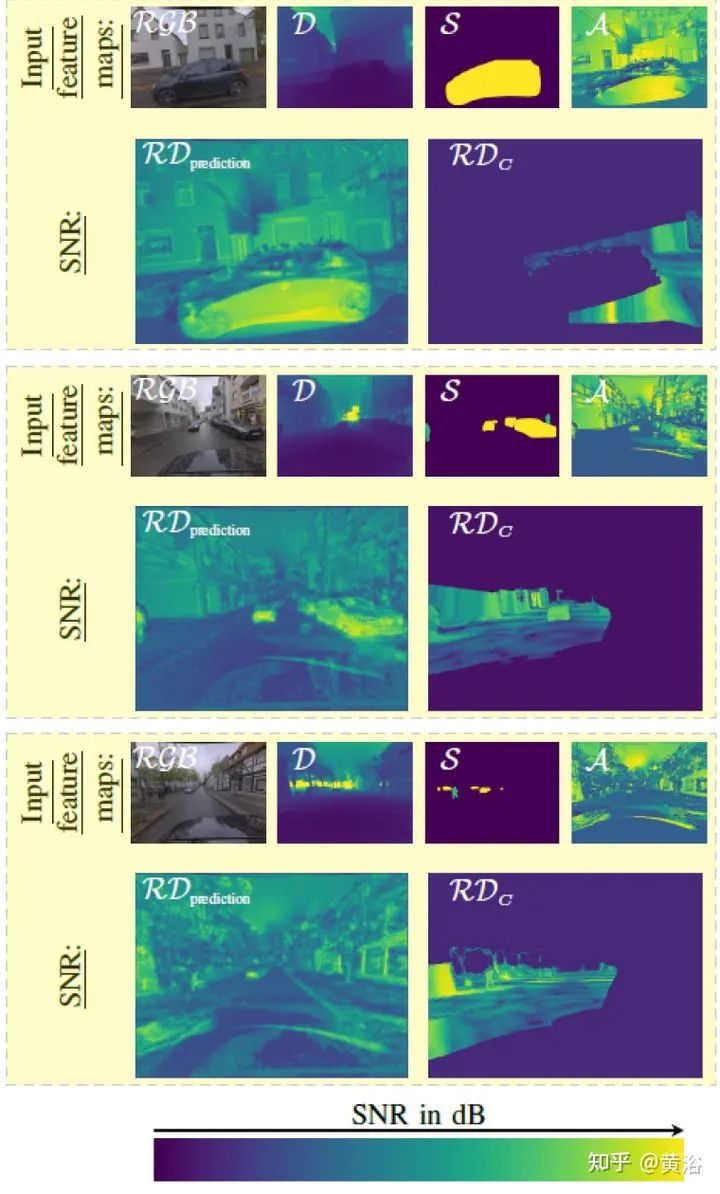

Qualitative results of SNR prediction on test data:

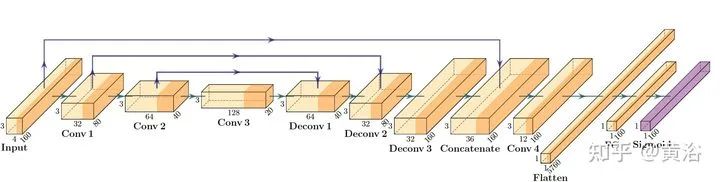

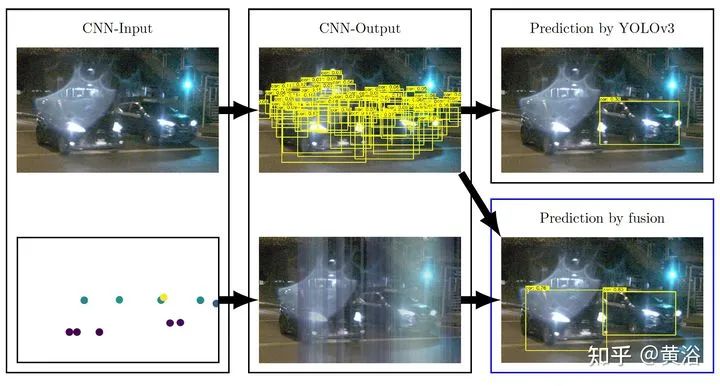

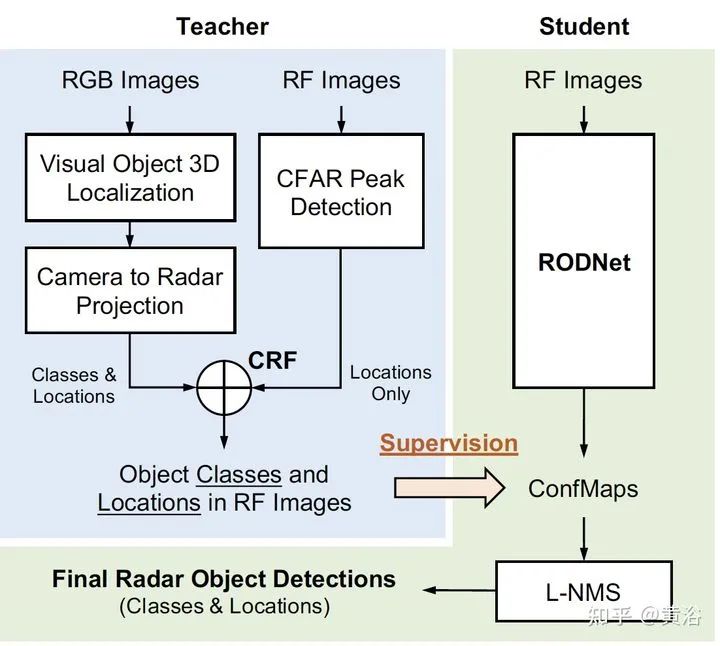

3 "RODNet: A Real-Time Radar Object Detection Network Cross-Supervised by Camera-Radar Fused Object 3D Localization", 2 2021

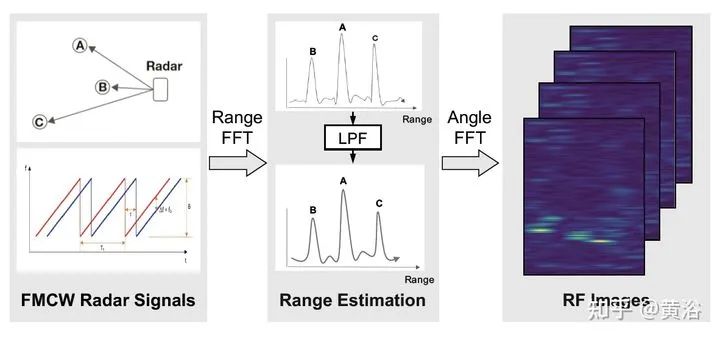

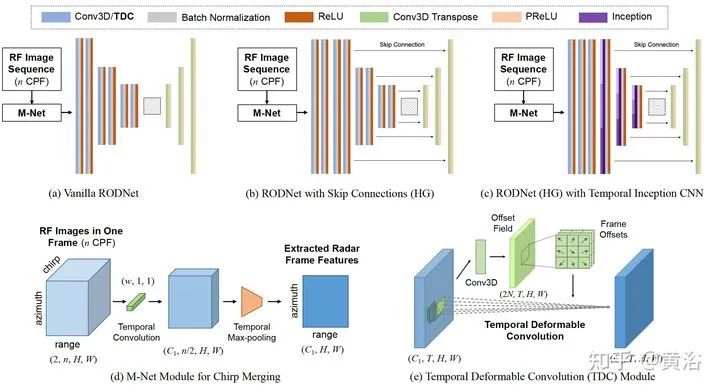

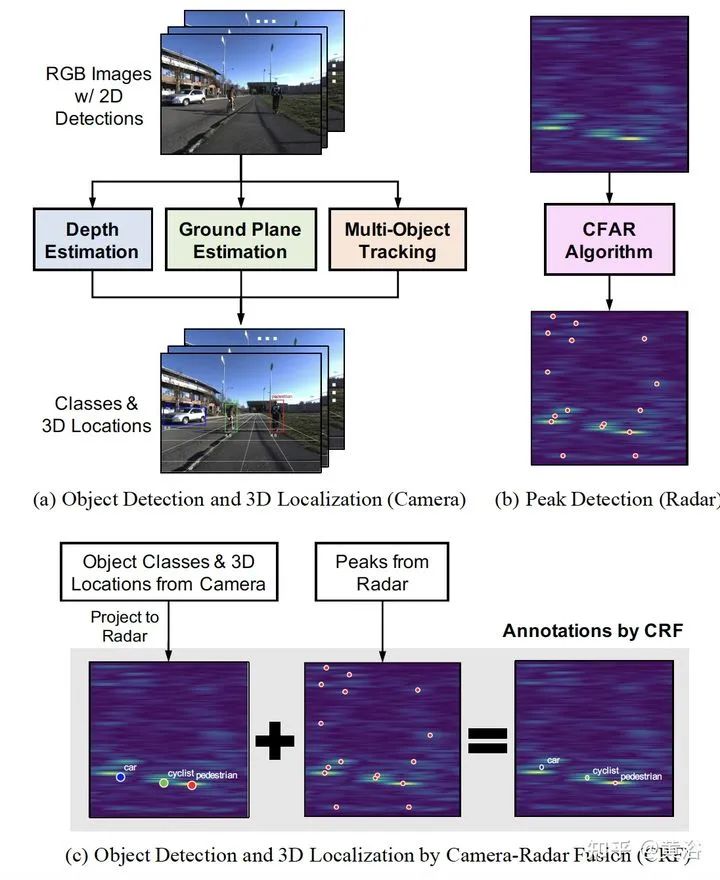

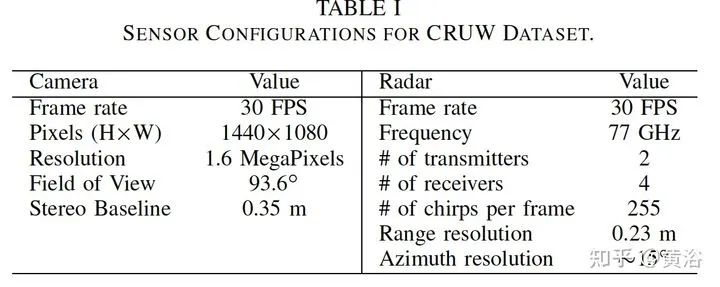

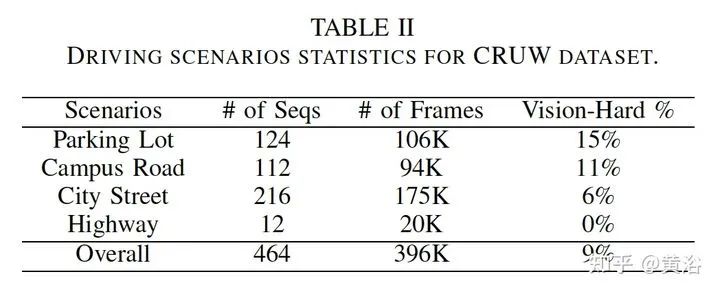

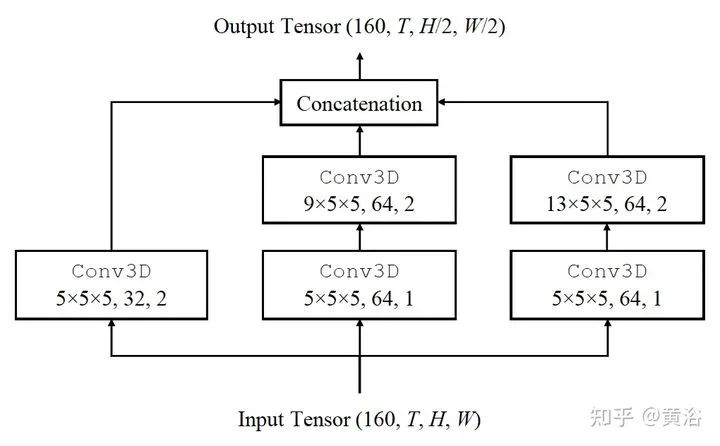

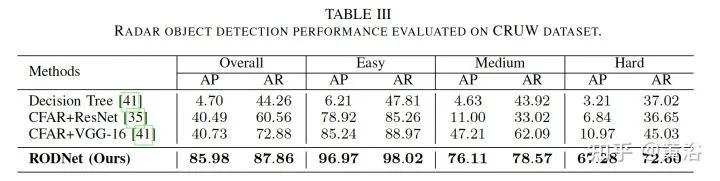

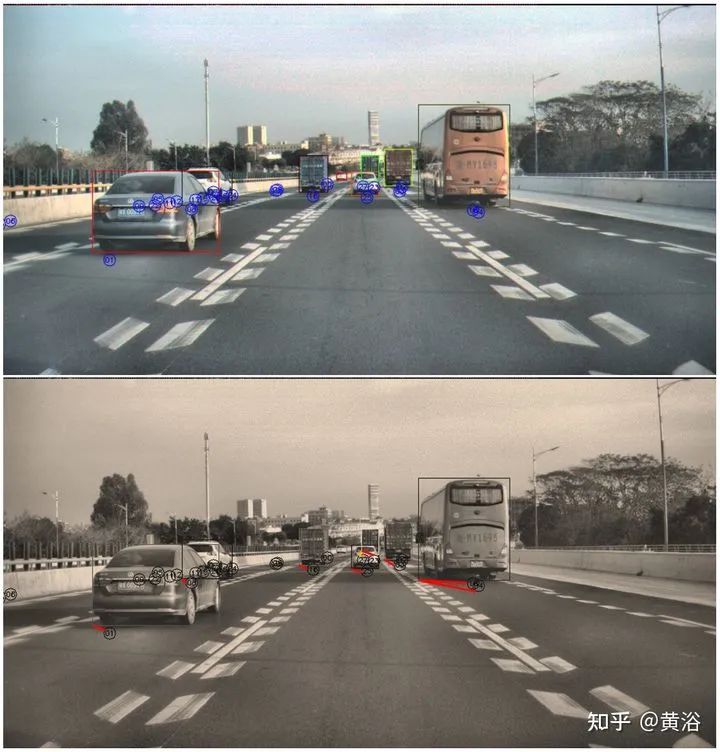

雷达目标检测网络RODNet,但训练是通过一个摄像头-雷达监督算法,无需标注,可实现射频(RF)图像的实时目标检测。原始毫米波雷达信号转换为range-azimuth坐标的RF图像;RODNet预测雷达FoV的目标似然性。两个定制的模块M-Net和temporal deformable convolution分别处理multi-chirp merging信息以及目标相对运动。训练中采用camera-radar fusion (CRF) 策略,另外还建立一个新数据集CRUW1。

cross-modal supervision pipeline for radar object detection in a teacher-student platform

workflow of the RF image generation from the raw radar signals

The architecture and modules of RODNet

Three teacher’s pipelines for cross-model supervision

temporal inception convolution layer

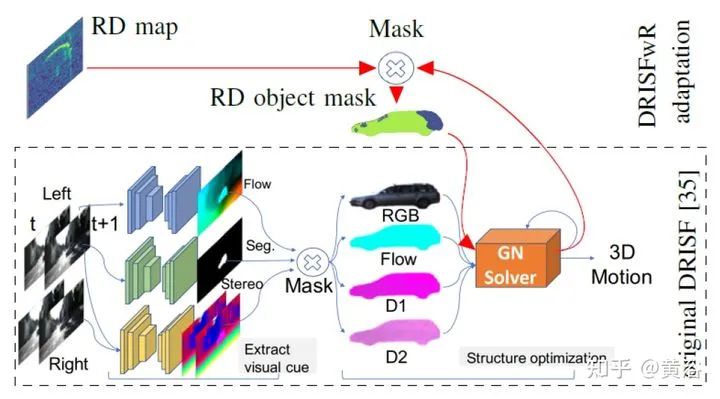

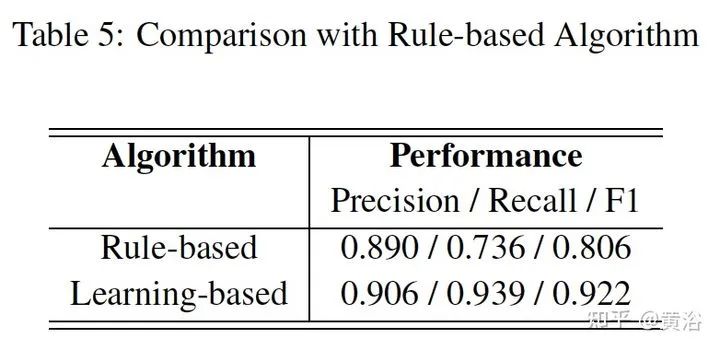

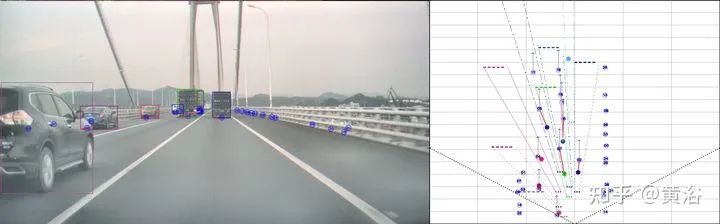

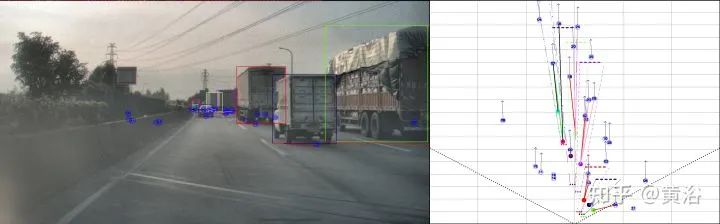

4 “Radar Camera Fusion via Representation Learning in Autonomous Driving”,4,2021

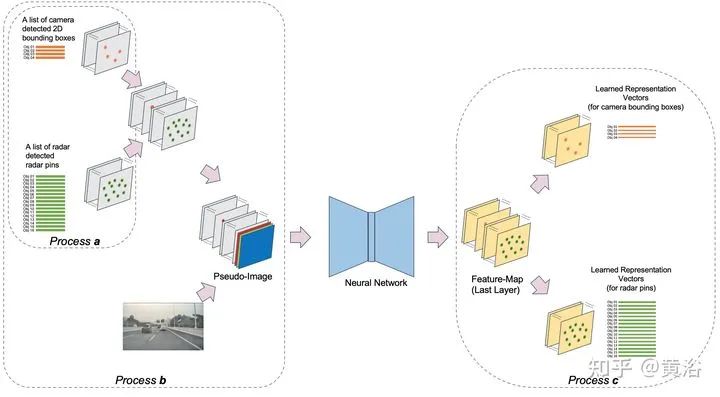

重点讨论data association问题。而rule-based association methods问题较多,故此讨论radar-camera association via deep representation learning 以开发特征级的交互和全局推理。将检测结果转换成图像通道,和原图像一起送入一个深度CNN模型,即AssociationNet。另外,设计了一个loss sampling mechanism 和 ordinal loss 来克服不完美的标注困难,确保一个类似人工的推理逻辑。

associations between radardetections (radar pins) and camera detections (2D bounding boxes).

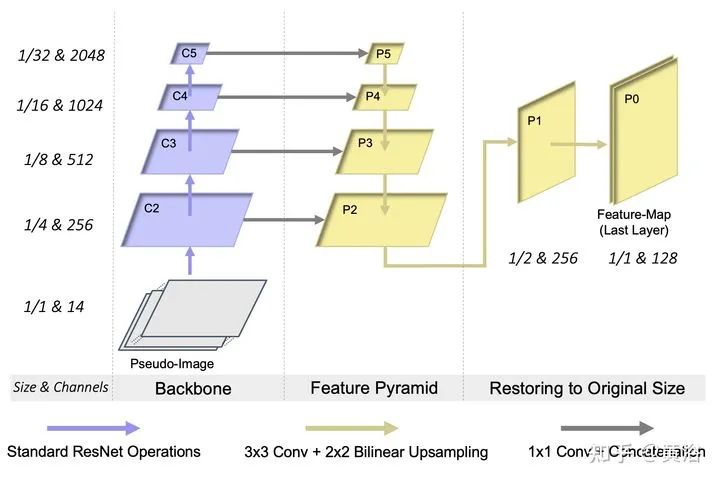

AssociationNet

architecture of the neural network

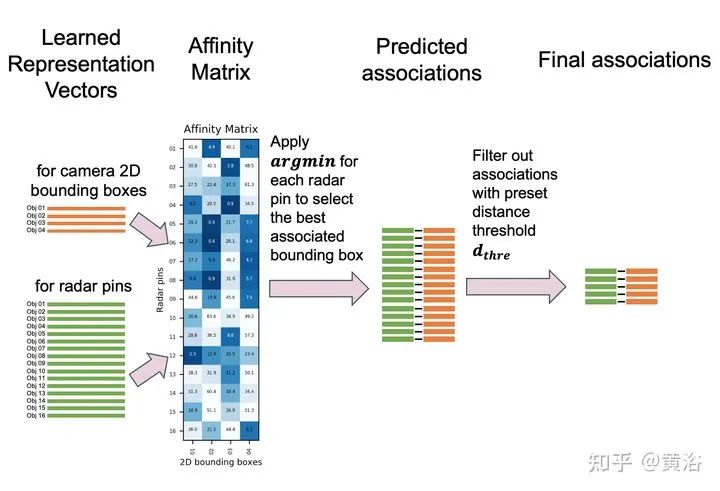

process of obtaining final associationsfrom the learned representation vectors

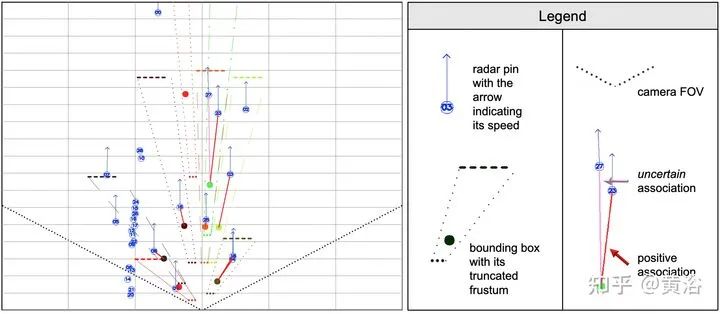

illustration of radar pins, bounding boxes, and association relationships under BEV perspective

the red solid lines represent the true-positive associations; and the pink solid lines represent predicted positive associations but labeled as uncertain in the ground-truth

The added green lines represent the false-positive predictions; and the added black lines represent the false-negative predictions

本文仅做学术分享,如有侵权,请联系删文。

下载1

在「3D视觉工坊」公众号后台回复:3D视觉,即可下载 3D视觉相关资料干货,涉及相机标定、三维重建、立体视觉、SLAM、深度学习、点云后处理、多视图几何等方向。

下载2

在「3D视觉工坊」公众号后台回复:3D视觉github资源汇总,即可下载包括结构光、标定源码、缺陷检测源码、深度估计与深度补全源码、点云处理相关源码、立体匹配源码、单目、双目3D检测、基于点云的3D检测、6D姿态估计源码汇总等。

下载3

在「3D视觉工坊」公众号后台回复:相机标定,即可下载独家相机标定学习课件与视频网址;后台回复:立体匹配,即可下载独家立体匹配学习课件与视频网址。

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、orb-slam3等视频课程)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近2000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~

最后

以上就是现实小馒头最近收集整理的关于摄像头和雷达融合的目标检测方法(最新)的全部内容,更多相关摄像头和雷达融合内容请搜索靠谱客的其他文章。

发表评论 取消回复